ByteDanceがSa2VAをリリース:初の統合型画像・動画理解モデル

2025/10/17

通義 Wan2.1 ComfyUI ワークフロー

アリババは2025年2月にWan2.1をオープンソース化しました。これは現在のビデオ生成分野の基準となるモデルで、オープンソースライセンスはApache 2.0です。14B(140億パラメータ)と1.3B(13億パラメータ)の2つのバージョンが提供され、テキストからビデオ(T2V)、画像からビデオ(I2V)などの多くのタスクをカバーしています。

また、現在コミュニティの著者によってGGUFおよび量子化バージョンが作成されています。

- GGUF: https://huggingface.co/city96/Wan2.1-T2V-14B-gguf/tree/main

- 量子化バージョン: https://huggingface.co/Kijai/WanVideo_comfy/tree/main

この記事では、Wan2.1に関連するワークフローを以下の内容で案内します:

- ComfyUIがネイティブにサポートするWan2.1ワークフロー

- Kijaiからのバージョン

- City96のGGUFバージョン

本チュートリアルで使用するすべてのワークフローファイルには、対応するワークフロー情報が含まれており、直接ComfyUIにドラッグして対応するワークフローとモデル情報を読み込むことができます。ポップアップが表示されたら、対応するモデルをダウンロードしてください。モデルのダウンロードが完了しない場合は、手動インストールのセクションを参照してモデルをインストールしてください。すべての出力ビデオは ComfyUI/output ディレクトリに出力されます。

Wan2.1は480Pと720Pのモデルを分けていますが、対応するワークフローはモデルとキャンバスのサイズを除いて他に違いはありません。720Pまたは480Pのワークフローに基づいて、別のバージョンのワークフローを調整できます。

Wan2.1 ComfyUI ネイティブ(native)ワークフローの例

以下のワークフローはComfyUI公式ブログからのもので、現在 ComfyUIはWan2.1をネイティブにサポートしています。公式のネイティブサポートバージョンを使用するには、ComfyUIを最新バージョンにアップグレードしてください。 ComfyUIのアップグレード方法 セクションのガイドを参照してアップグレードを完了してください。 ComfyUI Wiki は元のワークフローを整理しています。

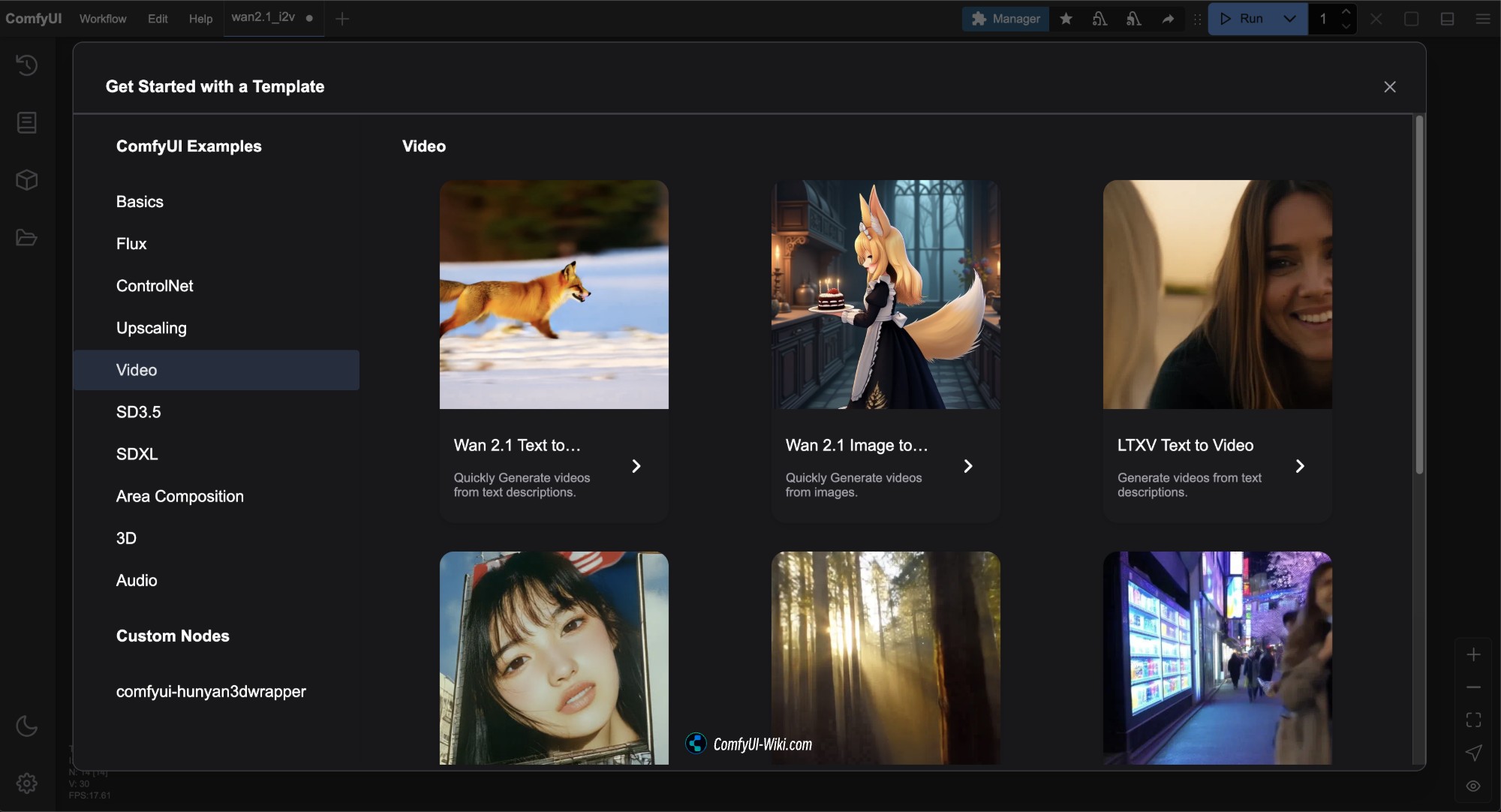

ComfyUIを最新バージョンに更新した後、メニューバーの Workflows -> Workflow Templates でWan2.1のワークフローテンプレートを確認できます。

このバージョンの対応ワークフローファイルはすべて Comfy-Org/Wan_2.1_ComfyUI_repackaged からのものです。

Diffusion models Comfy-orgは複数のバージョンを提供しています。この記事で使用される公式ネイティブバージョンのモデルバージョンがハードウェア要件が高い場合は、必要なバージョンを選択して使用できます。

- i2v は image to video(画像からビデオ)モデル、 t2v は text to video(テキストからビデオ)モデルです。

- 14B、1.3Bは対応するパラメータ数で、数値が大きいほどハードウェア性能の要求が高くなります。

- bf16、fp16、fp8は異なる精度を表し、精度が高いほどハードウェア性能の要求が高くなります。

- bf16はAmpereアーキテクチャ以上のGPUサポートが必要な場合があります。

- fp16はより広くサポートされています。

- fp8は最低精度で、ハードウェア性能の要求が最低ですが、効果も相対的に低下します。

- 通常、ファイルサイズが大きいほどデバイスのハードウェア要件も高くなります。

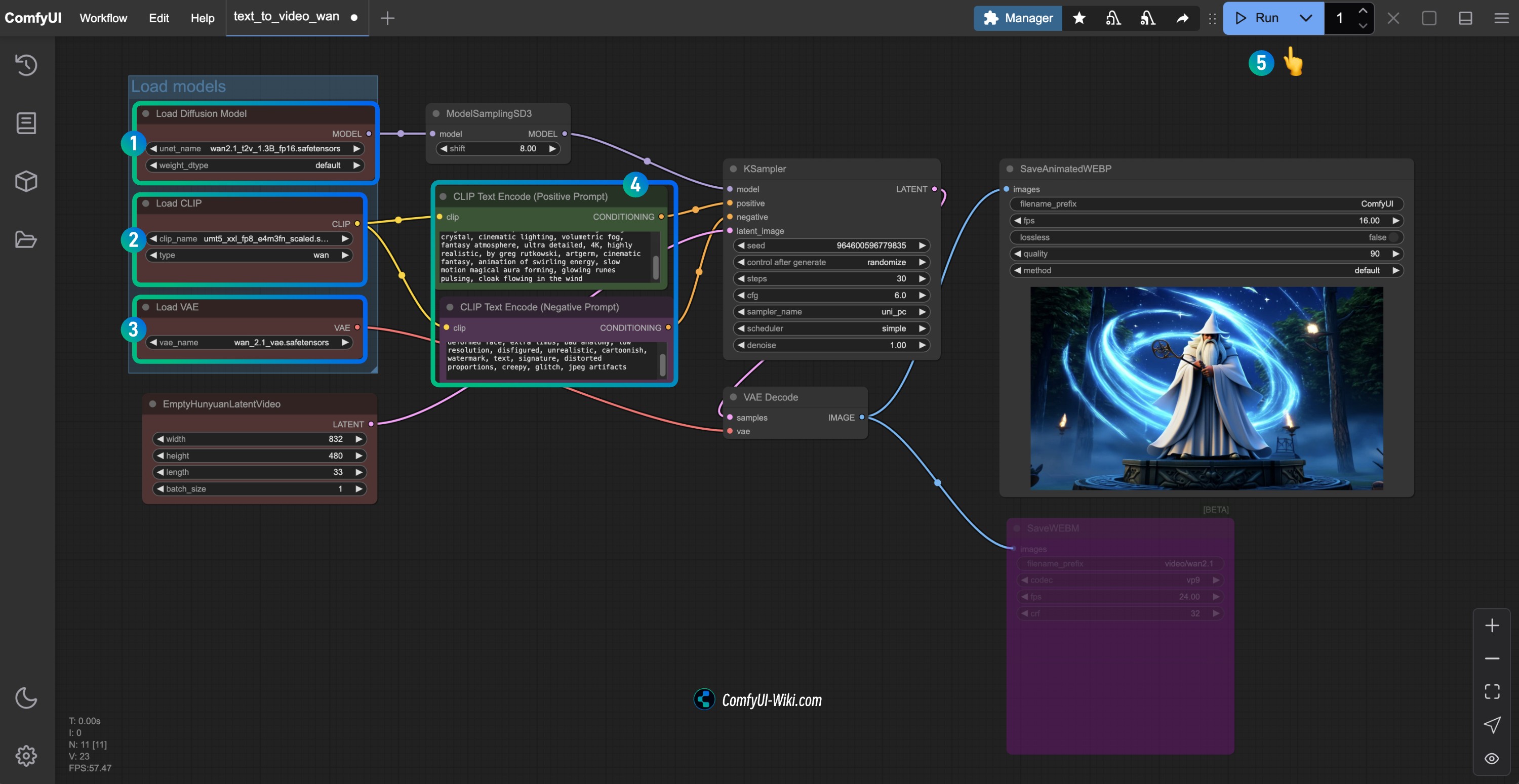

1. Wan2.1 テキストからビデオワークフロー

1.1 Wan2.1 テキストからビデオワークフローファイルのダウンロード

以下の画像をダウンロードし、ComfyUIにドラッグするか、メニューバーの Workflows -> Open(Ctrl+O) を使用してワークフローを読み込みます。

Json形式のファイルをダウンロード

1.2 手動モデルインストール

上記のワークフローファイルでモデルのダウンロードが完了しない場合は、以下のモデルファイルをダウンロードし、対応する場所に保存してください。

異なるタイプのモデルには複数のファイルがありますので、1つだけダウンロードしてください。ComfyUI WikiはGPU性能要件の順に高から低に並べています。すべてのモデルファイルを確認するにはこちらを訪問してください。

以下から1つのDiffusion modelsモデルファイルを選択してダウンロードしてください。

- wan2.1_t2v_14B_bf16.safetensors

- wan2.1_t2v_14B_fp16.safetensors

- wan2.1_t2v_14B_fp8_e4m3fn.safetensors

- wan2.1_t2v_14B_fp8_scaled.safetensors

- wan2.1_t2v_1.3B_bf16.safetensors

- wan2.1_t2v_1.3B_fp16.safetensors

Text encodersから1つのバージョンを選択してダウンロードしてください。

VAE

ファイル保存場所

ComfyUI/

├── models/

│ ├── diffusion_models/

│ │ └── wan2.1_t2v_14B_fp16.safetensors # または選択したバージョン

│ ├── text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # または選択したバージョン

│ └── vae/

│ └── wan_2.1_vae.safetensors1.3 プロセスに従ってワークフローを実行

Load Diffusion Modelノードがwan2.1_t2v_1.3B_fp16.safetensorsモデルを読み込んでいることを確認します。Load CLIPノードがumt5_xxl_fp8_e4m3fn_scaled.safetensorsモデルを読み込んでいることを確認します。Load VAEノードがwan_2.1_vae.safetensorsモデルを読み込んでいることを確認します。CLIP Text Encoderノードに生成したいビデオの説明内容を入力します。Runボタンをクリックするか、ショートカットキーCtrl(cmd) + Enter(リターン)を使用してビデオ生成を実行します。

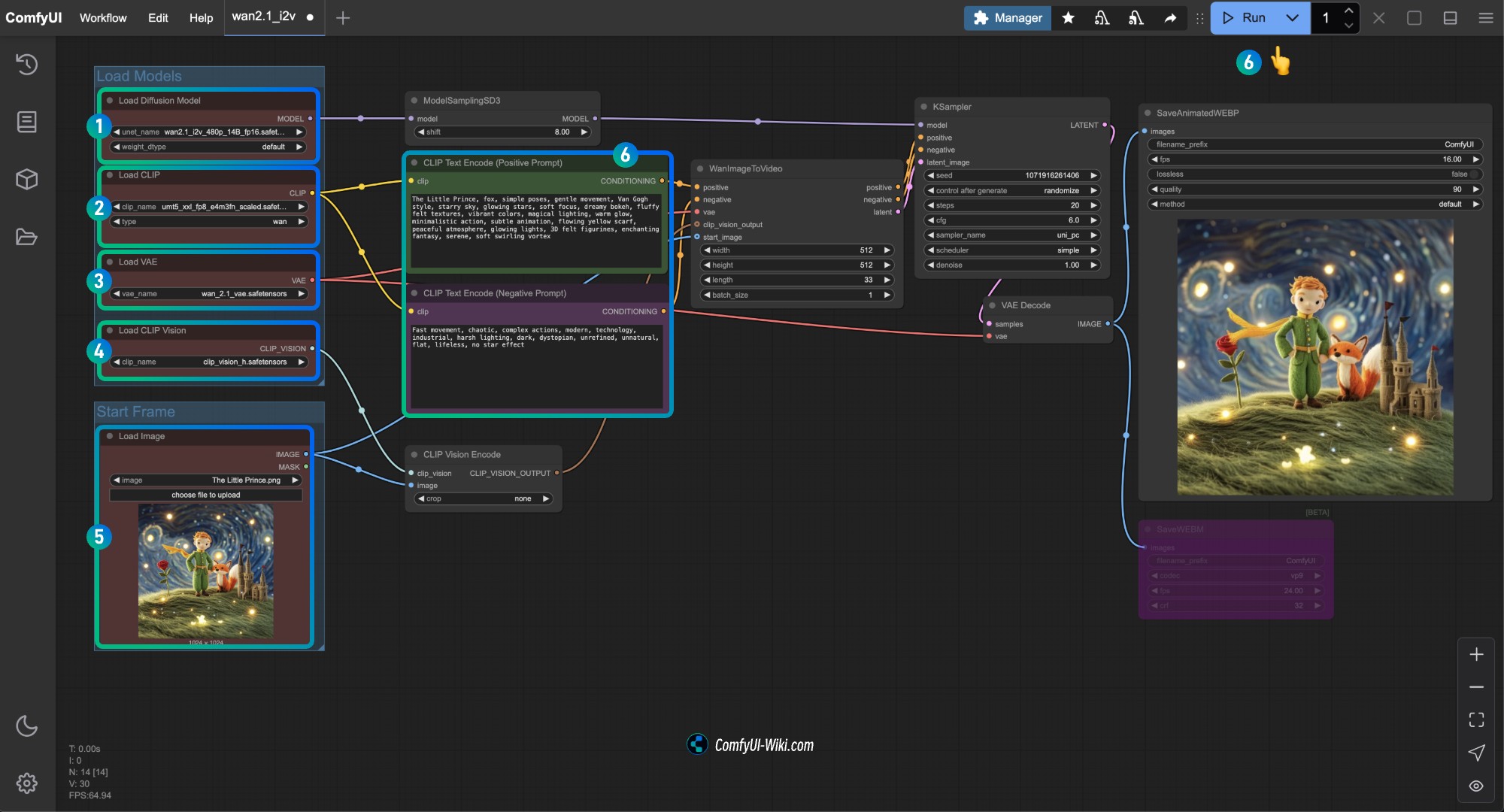

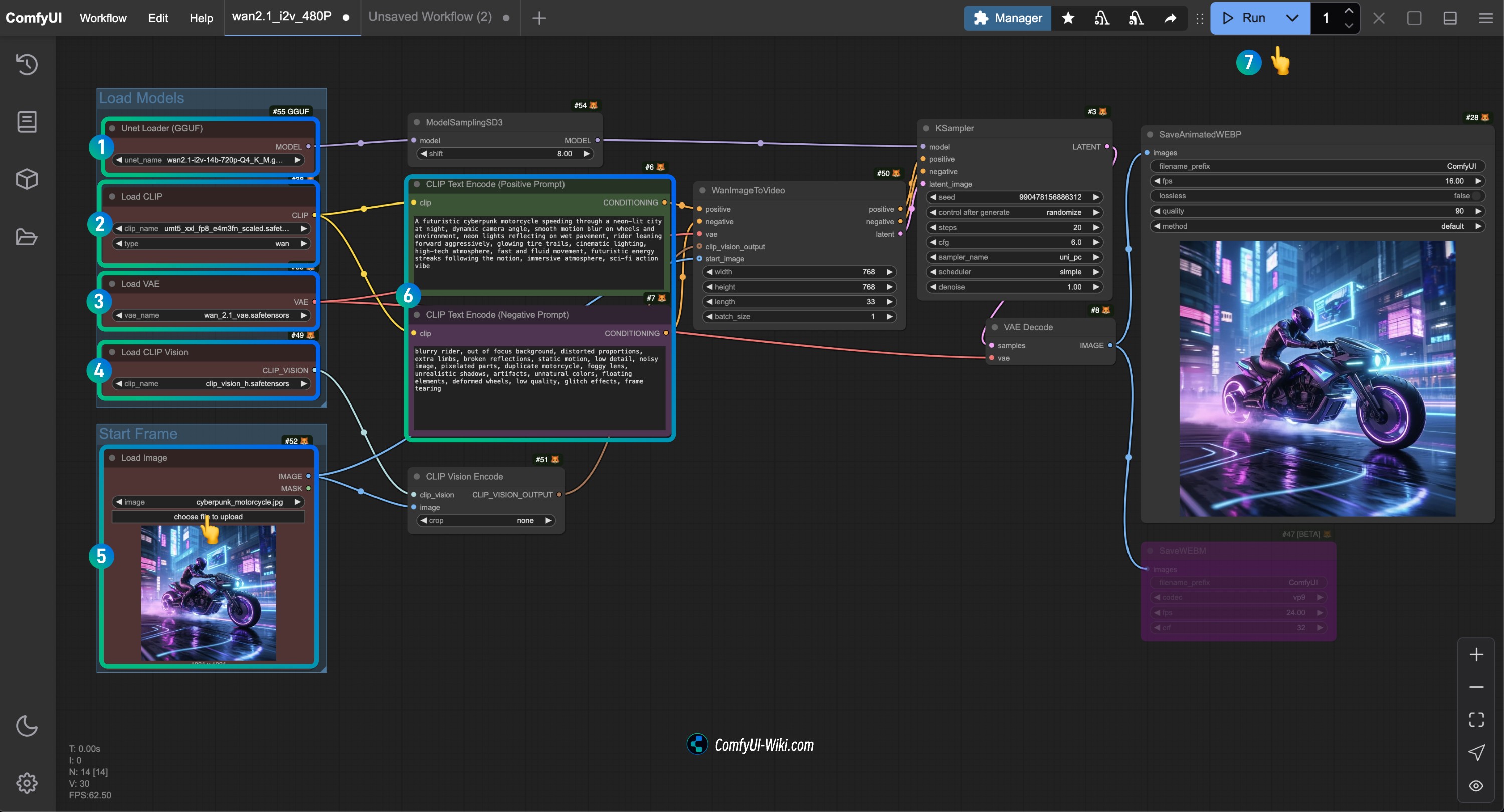

2. Wan2.1 画像からビデオワークフロー

2.1 Wan2.1 画像からビデオワークフロー 14B Workflow

ワークフローファイルのダウンロード

以下のボタンをクリックして対応するワークフローをダウンロードし、ComfyUIインターフェースにドラッグするか、メニューバーの Workflows -> Open(Ctrl+O) を使用して読み込みます。

Json形式のファイルをダウンロード

このバージョンのワークフローは480Pバージョンとほぼ同じですが、使用するdiffusion modelが異なり、WanImageToVideoノードのサイズも異なります。

以下の画像を入力画像としてダウンロードしてください。

2.2 手動モデルのダウンロード

上記のワークフローファイルでモデルのダウンロードが完了しない場合は、以下のモデルファイルをダウンロードし、対応する場所に保存してください。

Diffusion models

720Pバージョン

- wan2.1_i2v_720p_14B_bf16.safetensors

- wan2.1_i2v_720p_14B_fp16.safetensors

- wan2.1_i2v_720p_14B_fp8_e4m3fn.safetensors

- wan2.1_i2v_720p_14B_fp8_scaled.safetensors

480Pバージョン

- wan2.1_i2v_480p_14B_bf16.safetensors

- wan2.1_i2v_480p_14B_fp16.safetensors

- wan2.1_i2v_480p_14B_fp8_e4m3fn.safetensors

- wan2.1_i2v_480p_14B_fp8_scaled.safetensors

Text encoders

VAE

CLIP Vision

ファイル保存場所

ComfyUI/

├── models/

│ ├── diffusion_models/

│ │ └── wan2.1_i2v_480p_14B_fp16.safetensors # または選択したバージョン

│ ├── text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # または選択したバージョン

│ └── vae/

│ │ └── wan_2.1_vae.safetensors

│ └── clip_vision/

│ └── clip_vision_h.safetensors 2.3 プロセスに従ってWan2.1 480P 画像からビデオワークフローを実行

Load Diffusion Modelノードがwan2.1_i2v_480p_14B_fp16.safetensorsモデルを読み込んでいることを確認します。Load CLIPノードがumt5_xxl_fp8_e4m3fn_scaled.safetensorsモデルを読み込んでいることを確認します。Load VAEノードがwan_2.1_vae.safetensorsモデルを読み込んでいることを確認します。Load CLIP Visionノードがclip_vision_h.safetensorsモデルを読み込んでいることを確認します。Load Imageノードに前述の入力画像を読み込みます。CLIP Text Encoderノードに生成したいビデオの説明内容を入力するか、ワークフロー内の例を使用します。Runボタンをクリックするか、ショートカットキーCtrl(cmd) + Enter(リターン)を使用してビデオ生成を実行します。

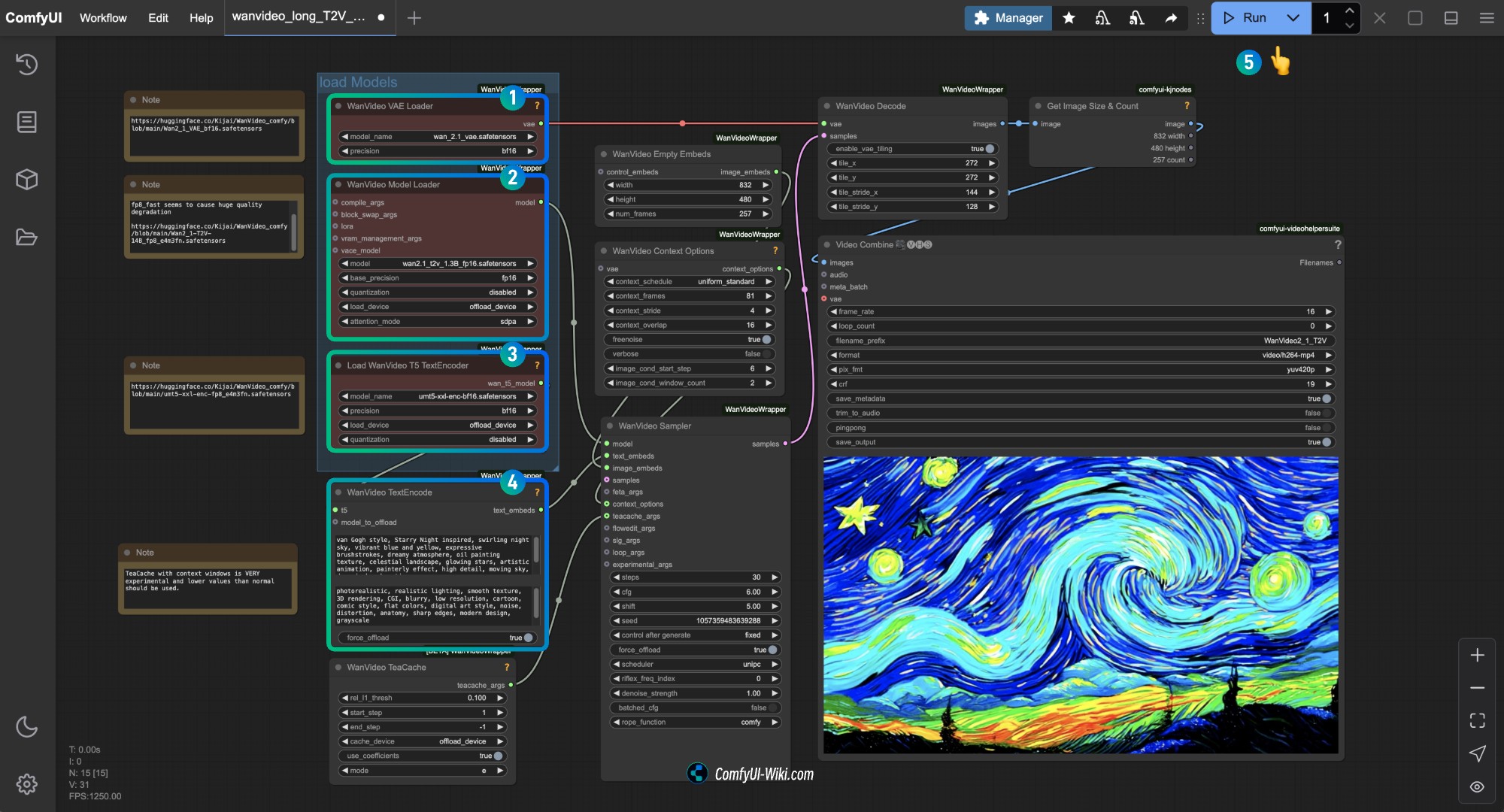

Kijai Wan2.1 量子化バージョンワークフロー

このバージョンは Kijai によって提供され、以下のカスタムノードと一緒に使用する必要があります。

以下の3つのノードをインストールする必要があります:

開始前にComfyUI-Managerを使用するか、ComfyUIカスタムノードインストールチュートリアルを参照して、これら3つのカスタムノードのインストールを完了してください。

モデルリポジトリ:Kijai/WanVideo_comfy

このリポジトリは、デバイス性能に応じたさまざまなモデルバージョンを提供しています。通常、ファイルサイズが大きいほど効果が良くなりますが、同時にデバイス性能の要求も高くなります。

もしComfyUIネイティブワークフローがあなたのデバイスで正常に動作する場合、Comfy Orgが提供するモデルを使用することもできます。例ではKijaiが提供するモデルを使用して示します。

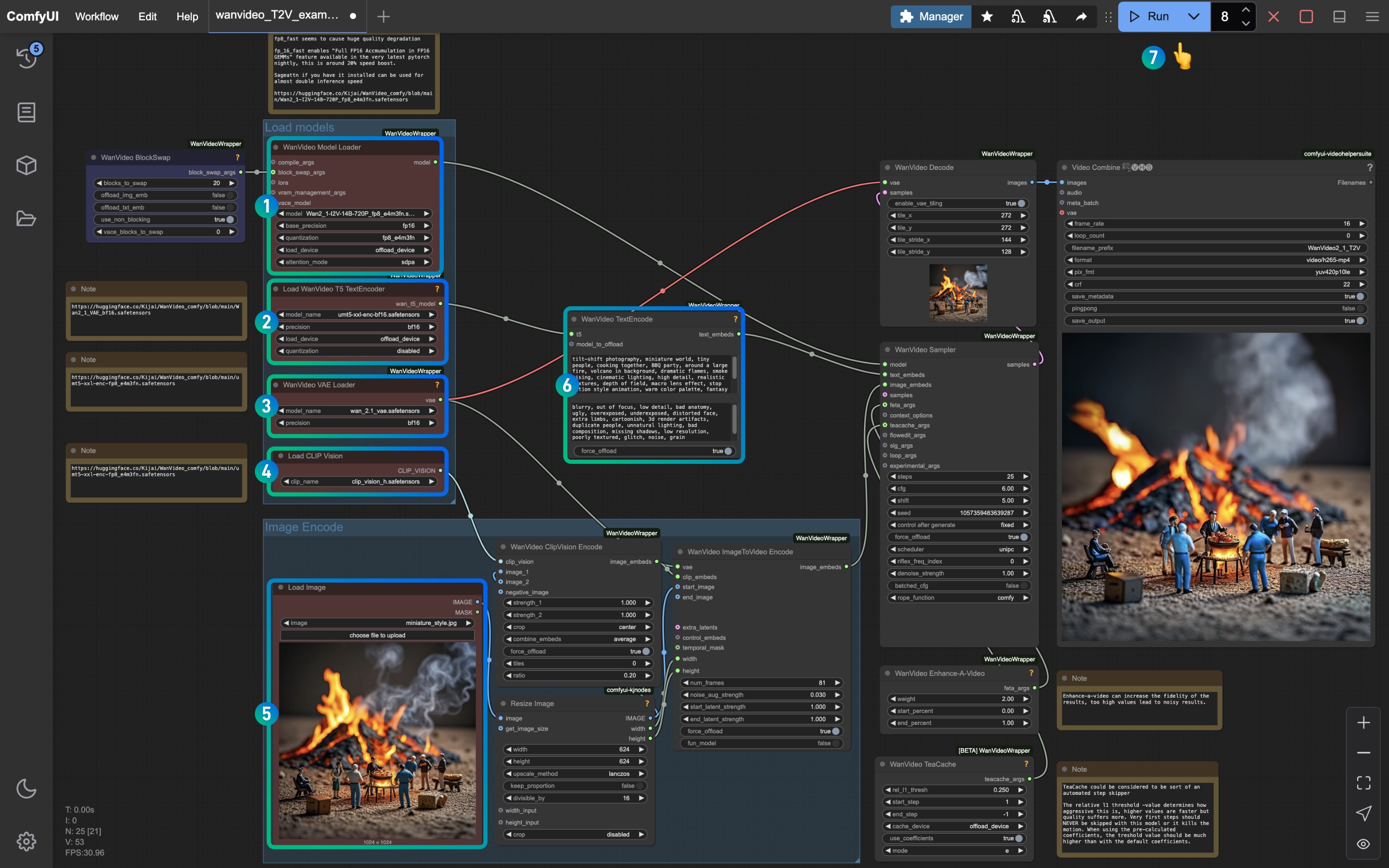

1. Kijai テキストから画像ワークフロー

1.1 Kijai Wan2.1 テキストから画像ワークフローのダウンロード

以下のボタンをクリックして対応するワークフローをダウンロードし、ComfyUIインターフェースにドラッグするか、メニューバーの Workflows -> Open(Ctrl+O) を使用して読み込みます。

上記の2つのワークフローファイルは基本的に同じですが、2号ファイルにはオプションの注釈情報が追加されています。

1.2 手動モデルインストール

訪問: https://huggingface.co/Kijai/WanVideo_comfy/tree/main でファイルサイズを確認してください。通常、ファイルサイズが大きいほど効果が良くなりますが、同時にデバイス性能の要求も高くなります。

Diffusion models

- Wan2_1-T2V-14B_fp8_e4m3fn.safetensors

- Wan2_1-T2V-14B_fp8_e5m2.safetensors

- Wan2_1-T2V-1_3B_fp32.safetensors

- Wan2_1-T2V-1_3B_bf16.safetensors

- Wan2_1-T2V-1_3B_fp8_e4m3fn.safetensors

Text encodersモデル

VAEモデル

ファイル保存場所

ComfyUI/

├── models/

│ ├── diffusion_models/

│ │ └── Wan2_1-T2V-14B_fp8_e4m3fn.safetensors # または選択したバージョン

│ ├── text_encoders/

│ │ └─── umt5-xxl-enc-bf16.safetensors # または選択したバージョン

│ └─── vae/

│ └── Wan2_1_VAE_bf16.safetensors # または選択したバージョン1.3 プロセスに従ってワークフローを実行

対応するノードが対応するモデルを読み込んでいることを確認し、ダウンロードしたバージョンを使用してください。

WanVideo Vae LoaderノードがWan2_1_VAE_bf16.safetensorsモデルを読み込んでいることを確認します。WanVideo Model LoaderノードがWan2_1-T2V-14B_fp8_e4m3fn.safetensorsモデルを読み込んでいることを確認します。Load WanVideo T5 TextEncoderノードがumt5-xxl-enc-bf16.safetensorsモデルを読み込んでいることを確認します。WanVideo TextEncodeで生成したいビデオのプロンプトを入力します。Runボタンをクリックするか、ショートカットキーCtrl(cmd) + Enter(リターン)を使用してビデオ生成を実行します。

WanVideo Empty Embeds内のサイズを変更して画面サイズを調整できます。

2. Kijai Wan2.1 画像からビデオワークフロー

2.1 ワークフローファイルのダウンロード

以下の画像を入力画像としてダウンロードしてください。

2.2 手動モデルのダウンロード

ComfyUIネイティブ部分の例で使用されるモデルも使用できますが、text_encoderのみ使用できないようです。

Diffusion models 720Pバージョン

480Pバージョン

Text encodersモデル

VAEモデル

CLIP Vision

ファイル保存場所

ComfyUI/

├── models/

│ ├── diffusion_models/

│ │ └── Wan2_1-I2V-14B-720P_fp8_e4m3fn.safetensors # または選択したバージョン

│ ├── text_encoders/

│ │ └─── umt5-xxl-enc-bf16.safetensors # または選択したバージョン

│ ├── vae/

│ │ └── Wan2_1_VAE_fp32.safetensors # または選択したバージョン

│ └── clip_vision/

│ └── clip_vision_h.safetensors 2.3 プロセスに従ってワークフローを実行

画像番号を参照して、対応するノードとモデルがすべて読み込まれていることを確認し、モデルが正常に動作するようにします。

WanVideo Model LoaderノードがWan2_1-I2V-14B-720P_fp8_e4m3fn.safetensorsモデルを読み込んでいることを確認します。Load WanVideo T5 TextEncoderノードがumt5-xxl-enc-bf16.safetensorsモデルを読み込んでいることを確認します。WanVideo Vae LoaderノードがWan2_1_VAE_fp32.safetensorsモデルを読み込んでいることを確認します。Load CLIP Visionノードがclip_vision_h.safetensorsモデルを読み込んでいることを確認します。Load Imageノードに前述の入力画像を読み込みます。- デフォルトを保存するか、

WanVideo TextEncodeプロンプトを変更して画面効果を調整します。 Runボタンをクリックするか、ショートカットキーCtrl(cmd) + Enter(リターン)を使用してビデオ生成を実行します。

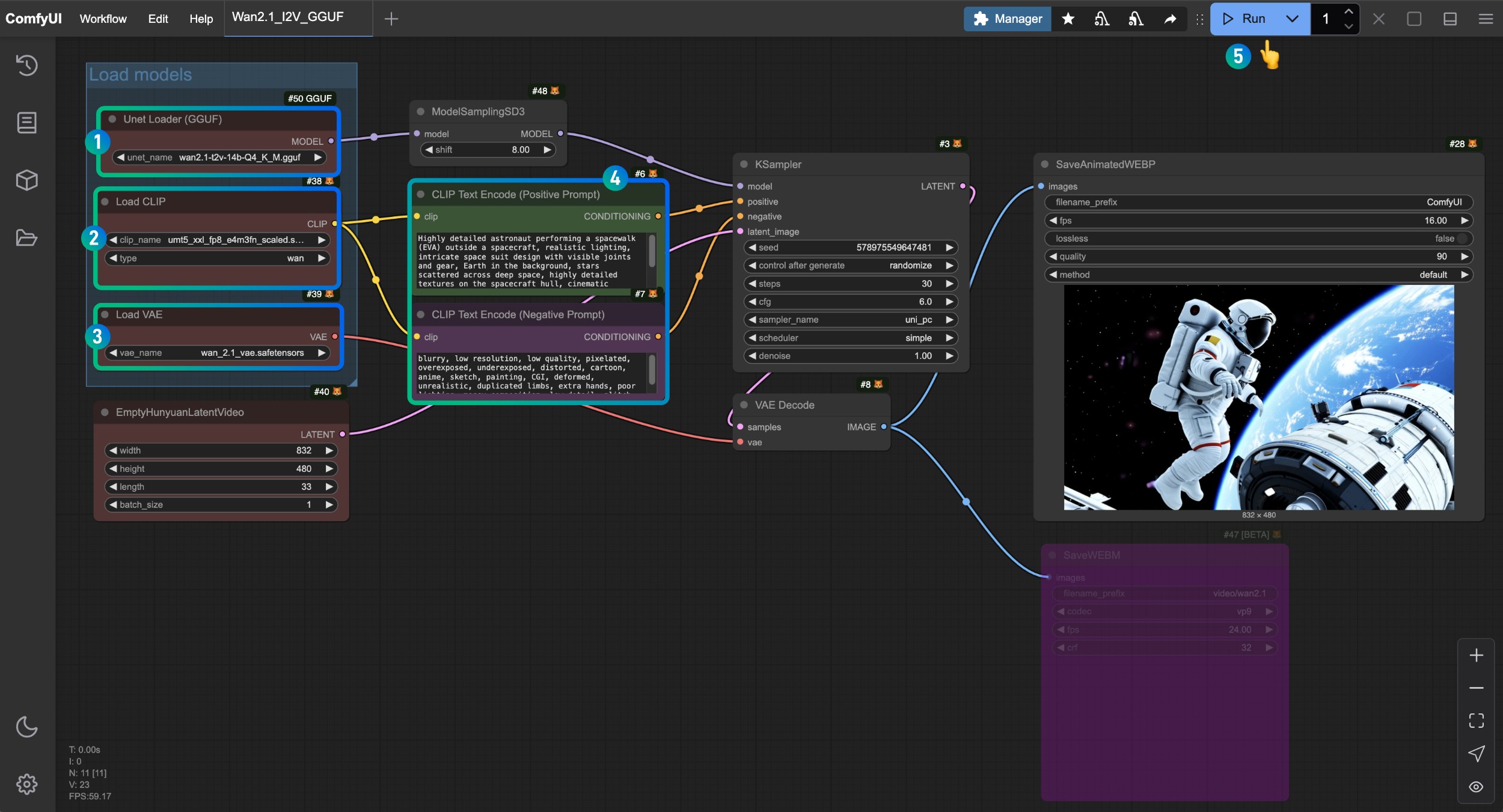

Wan2.1 GGUF バージョンワークフロー

この部分ではGGUFバージョンモデルを使用してビデオ生成を行います。 モデルリポジトリ:https://huggingface.co/city96/Wan2.1-T2V-14B-gguf/tree/main

ComfyUI-GGUFを使用して対応するモデルを読み込む必要があります。開始前にComfyUI-Managerを使用するか、ComfyUIカスタムノードインストールチュートリアルを参照して、対応するカスタムノードのインストールを完了してください。

このバージョンのワークフローは基本的にComfyUIネイティブバージョンのワークフローと同じですが、GGUFバージョンと対応するGGUFモデルの読み込みを使用してビデオ生成を行います。この部分では完全なモデルリストを提供しますので、一部のユーザーがこの部分の例を直接確認するのを防ぎます。

1. Wan2.1 GGUF バージョンテキストからビデオワークフロー

1.1 ワークフローファイルのダウンロード

1.2 手動モデルのダウンロード

以下から1つのDiffusion modelsモデルファイルを選択してダウンロードしてください。 city96はさまざまなモデルバージョンを提供しています。 https://huggingface.co/city96/Wan2.1-T2V-14B-gguf/tree/main で適切なバージョンをダウンロードしてください。通常、ファイルサイズが大きいほど効果が良くなりますが、同時にデバイス性能の要求も高くなります。

Text encodersから1つのバージョンを選択してダウンロードしてください。

VAE

ファイル保存場所

ComfyUI/

├── models/

│ ├── diffusion_models/

│ │ └── wan2.1-t2v-14b-Q4_K_M.gguf # または選択したバージョン

│ ├── text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # または選択したバージョン

│ └── vae/

│ └── wan_2.1_vae.safetensors1.3 プロセスに従ってワークフローを実行

Unet Loader(GGUF)ノードがwan2.1-t2v-14b-Q4_K_M.ggufモデルを読み込んでいることを確認します。Load CLIPノードがumt5_xxl_fp8_e4m3fn_scaled.safetensorsモデルを読み込んでいることを確認します。Load VAEノードがwan_2.1_vae.safetensorsモデルを読み込んでいることを確認します。CLIP Text Encoderノードに生成したいビデオの説明内容を入力します。Runボタンをクリックするか、ショートカットキーCtrl(cmd) + Enter(リターン)を使用してビデオ生成を実行します。

2. Wan2.1 GGUF バージョン画像からビデオワークフロー

2.1 ワークフローファイルのダウンロード

2.2 手動モデルのダウンロード

以下から1つのDiffusion modelsモデルファイルを選択してダウンロードしてください。 city96はさまざまなモデルバージョンを提供しています。対応するリポジトリから適切なバージョンをダウンロードしてください。通常、ファイルサイズが大きいほど効果が良くなりますが、同時にデバイス性能の要求も高くなります。

ここでは wan2.1-i2v-14b-Q4_K_M.ggufモデルを使用して例を示します。

Text encodersから1つのバージョンを選択してダウンロードしてください。

VAE

ファイル保存場所

ComfyUI/

├── models/

│ ├── diffusion_models/

│ │ └── wan2.1-i2v-14b-Q4_K_M.gguf # または選択したバージョン

│ ├── text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # または選択したバージョン

│ └── vae/

│ └── wan_2.1_vae.safetensors2.3 プロセスに従ってワークフローを実行

Unet Loader(GGUF)ノードがwan2.1-i2v-14b-Q4_K_M.ggufモデルを読み込んでいることを確認します。Load CLIPノードがumt5_xxl_fp8_e4m3fn_scaled.safetensorsモデルを読み込んでいることを確認します。Load VAEノードがwan_2.1_vae.safetensorsモデルを読み込んでいることを確認します。Load CLIP Visionノードがclip_vision_h.safetensorsモデルを読み込んでいることを確認します。Load Imageノードに前述の入力画像を読み込みます。CLIP Text Encoderノードに生成したいビデオの説明内容を入力するか、ワークフロー内の例を使用します。Runボタンをクリックするか、ショートカットキーCtrl(cmd) + Enter(リターン)を使用してビデオ生成を実行します。

よくある質問

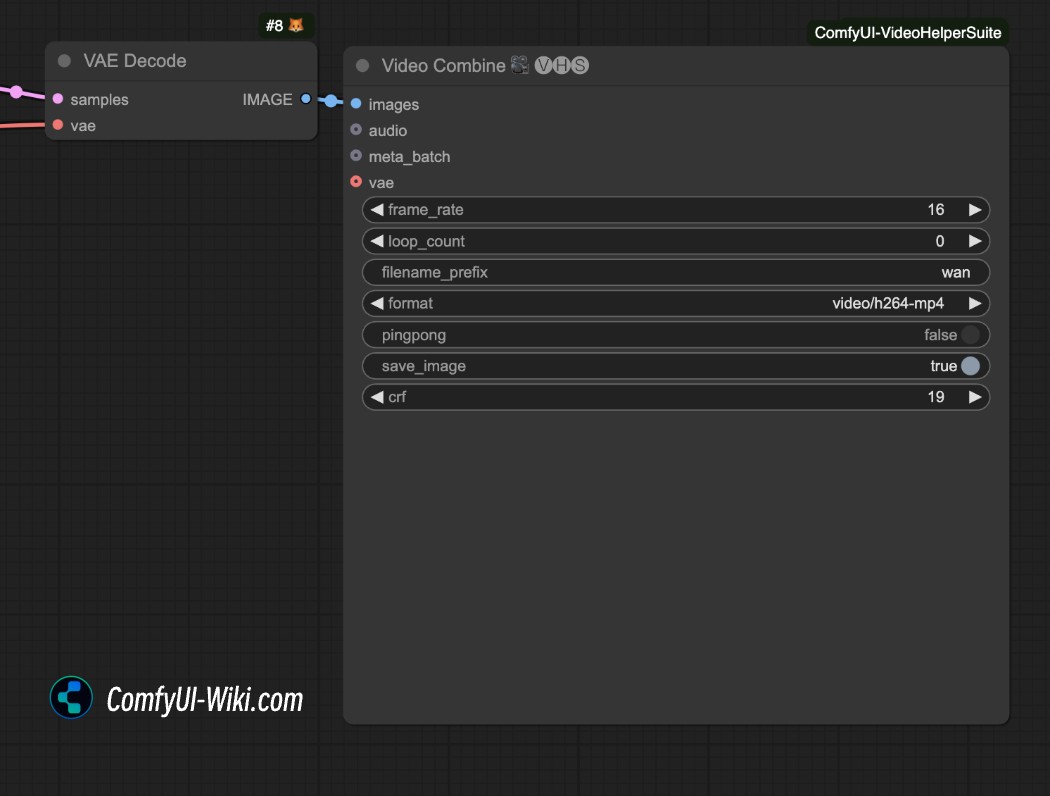

mp4形式の動画を保存するにはどうすればよいですか

上記の動画生成ワークフローはデフォルトで.webp形式の動画を生成します。他の形式の動画を保存したい場合は、ComfyUI-VideoHelperSuiteプラグインのvideo Combineノードを使用してmp4形式で保存することを試みてください。

関連リソース

現在、すべてのモデルはHugging FaceおよびModelScopeプラットフォームでダウンロード可能です:

-

T2V-14B:Hugging Face | ModelScope

-

I2V-14B-720P:Hugging Face | ModelScope

-

T2V-1.3B:Hugging Face | ModelScope