ByteDanceがSa2VAをリリース:初の統合型画像・動画理解モデル

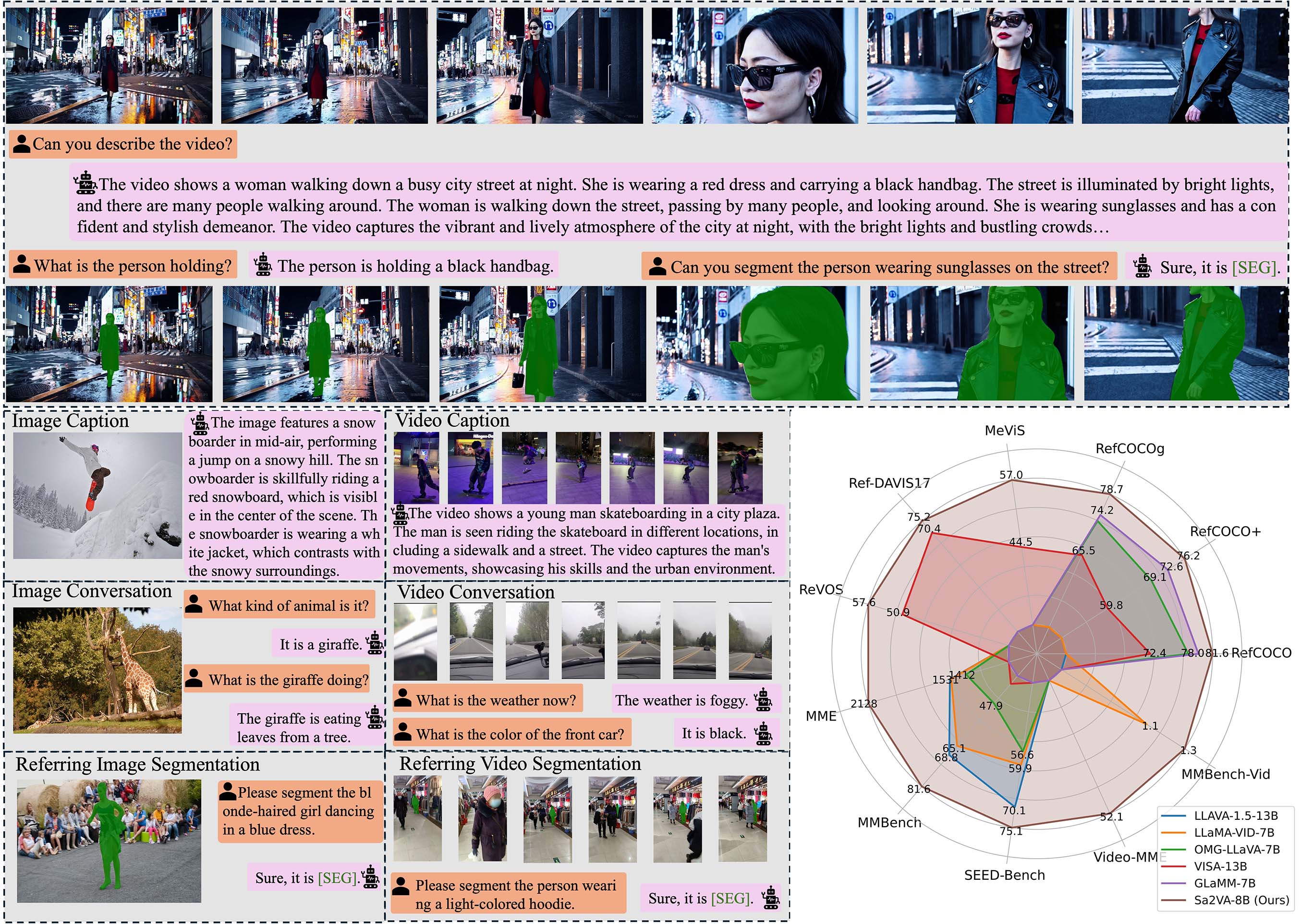

本日、ByteDanceはHugging FaceプラットフォームでSa2VA(SAM2 + LLaVA)マルチモーダルモデルをリリースしました。これは画像と動画を同時に処理できる初の密なセグメンテーション理解モデルです。Sa2VAはMetaのSAM2セグメンテーション技術とLLaVAの視覚的質問応答機能を組み合わせ、最先端のマルチモーダルモデルと同等の質問応答性能を維持しながら、視覚的プロンプト理解および密なオブジェクトセグメンテーション機能を新たに追加しています。

技術的特徴:マルチモーダル理解における新ブレークスルー

Sa2VAの核となる革新は、2つの先進技術を有機的に融合することにあります:

1. 視覚セグメンテーション能力

- 密なオブジェクトセグメンテーション:画像および動画内の複数オブジェクトを正確に識別・セグメント化可能

- 視覚的プロンプト理解:マスクなどの視覚的ヒントを通じたインタラクティブなセグメンテーションをサポート

- クロスフレーム一貫性:動画処理においてオブジェクトセグメンテーションの時間的連続性を維持

2. マルチモーダル質問応答

- 画像理解:詳細な画像の説明と分析を提供

- 動画分析:動画コンテンツの時間的動的変化を理解

- インタラクティブ対話:視覚コンテンツに基づく複数回の対話をサポート

モデルシリーズ:多様なニーズに対応する複数仕様

ByteDanceはQwen2.5-VLおよびInternVLシリーズに基づいて、完全なSa2VAモデルファミリーを構築しました:

| モデル名 | ベースモデル | 言語モデル | パラメータ規模 |

|---|---|---|---|

| Sa2VA-InternVL3-2B | InternVL3-2B | Qwen2.5-1.5B | 20億 |

| Sa2VA-InternVL3-8B | InternVL3-8B | Qwen2.5-7B | 80億 |

| Sa2VA-InternVL3-14B | InternVL3-14B | Qwen2.5-14B | 140億 |

| Sa2VA-Qwen2_5-VL-3B | Qwen2.5-VL-3B | Qwen2.5-3B | 30億 |

| Sa2VA-Qwen2_5-VL-7B | Qwen2.5-VL-7B | Qwen2.5-7B | 70億 |

性能:複数ベンチマークでリーディング結果

Sa2VAは複数の標準テストで優れた性能を発揮しています:

視覚的質問応答能力

- MMEテスト:Sa2VA-InternVL3-14Bは1746/724点を達成

- MMBench:84.3点で、プロフェッショナルな視覚理解モデルレベルに近い

セグメンテーションタスク性能

- RefCOCOシリーズ:指名表現セグメンテーションタスクで優れた結果

- 動画セグメンテーション:MeVISおよびDAVISベンチマークテストで最高峰性能を達成

応用シナリオ:広範な実用的価値

Sa2VAの統合アーキテクチャは、複数の分野に新たな可能性をもたらします:

1. コンテンツ制作

- 動画編集:動画内のオブジェクトを自動的に識別・セグメンテーションし、ポストプロダクション工程を簡略化

- 画像アノテーション:大規模画像データセットに正確なオブジェクトセグメンテーションと説明を提供

2. 教育・研修

- インタラクティブ教育:視覚的プロンプトと質問応答を通じて学生が複雑な概念を理解するのを支援

- コンテンツ分析:教育用動画の重要な情報点を自動分析

3. セキュリティ・監視

- インテリジェント分析:監視動画内の人物および物体の動作をリアルタイムで分析

- 異常検知:視覚的認識とセグメンテーション機能を組み合わせて異常状況を識別

4. 医療画像診断

- 補助診断:医療画像を分析し、詳細な領域説明を提供

- 病変の局在化:関心領域を正確にセグメント化および注釈付け

オープンソースリソースおよび取得方法

Sa2VAはオープンソースリリース戦略を採用し、研究者および開発者にとっての利便性を確保しています:

公式リソースリンク:

- プロジェクトホームページ:GitHub Sa2VA

- 論文:arXiv:2501.04001

- モデルダウンロード:Hugging Face Sa2VAシリーズ

Sa2VAのリリースは、マルチモーダルAIがより統合的で実用的な方向への進化を示しており、視覚セグメンテーションと言語理解を深く統合する設計思想は、今後のAIアプリケーションに新しい可能性を開きます。