AIGC 最新ニュース

最新のAIGCニュースと更新情報をお届けします。

OpenMOSS、MOVA をリリース - オープンソース音声・動画同期生成モデル

OpenMOSS チームが MOVA (MOSS Video and Audio) をリリース。単一推論パスで動画と音声を生成するエンドツーエンドの音声・動画同期生成基盤モデルで、正確なリップシンクと環境認識音響効果を実現し、モデルウェイト、トレーニングおよび推論コードを完全オープンソース化

アリババ通義ラボがZ-Image-Baseをリリース - 非蒸留版高品質画像生成モデル

アリババ通義ラボがZ-Image-Baseをリリース。これはZ-Imageシリーズの非蒸留基盤モデルで、完全な生成能力を保持し、コミュニティのファインチューニングとカスタム開発に理想的な基盤を提供します

DeepSeek、DeepSeek-OCR-2をリリース - ビジュアル因果フローを搭載した文書理解モデル

DeepSeekがDeepSeek-OCR-2をオープンソース化。新しいDeepEncoder V2ビジョンエンコーダを導入し、ビジュアル因果フローメカニズムを通じて人間の読解ロジックを模倣し、OmniDocBench v1.5で91.09%の精度を達成

Moonshot AI、Kimi K2.5をリリース - 1Tパラメータのネイティブマルチモーダルエージェントモデル

Moonshot AIが正式にKimi K2.5をリリース。15兆の混合ビジュアル・テキストトークンで継続的に事前学習された1Tパラメータのネイティブマルチモーダルエージェントモデルで、画像・動画理解をサポートし、Agent Swarm自律協調メカニズムを搭載

アリババQwen、Qwen3-TTSをリリース - 97ms超低レイテンシ音声合成モデル

アリババQwenがQwen3-TTS音声生成モデルシリーズをオープンソース化。Dual-Trackモデリングにより97ms超低レイテンシを実現し、3秒音声クローニングと自然言語音声デザインをサポート、10の主要言語をカバー

Microsoft、VibeVoice-ASRをリリース - 60分長音声シングルパス処理対応音声認識モデル

Microsoftが9Bパラメータの統合音声認識モデルVibeVoice-ASRをオープンソース化。最大60分の音声を一度に処理可能で、単一推論プロセスで認識、話者分離、タイムスタンプ生成を共同完了

NVIDIA、PersonaPlex-7B-v1をリリース - 全二重音声対話モデル

NVIDIAがMoshiアーキテクチャベースの70億パラメータ全二重音声対話モデルPersonaPlex-7B-v1をオープンソース化。同時聴取・発話、自然な中断、役割カスタマイズをサポートし、中断応答レイテンシは240ミリ秒まで低減

SVI 2.0 Pro リリース - Wan 2.2 サポートによる無限長動画生成

Stable Video Infinity 2.0 Pro が正式リリースされ、Wan 2.2 ベースモデルのサポートを追加。ComfyUI で無限長の動画コンテンツを生成するための HIGH および LOW バージョンの LoRA モデルを提供

Qwen-Image-Layered リリース - レイヤーベース編集をサポートする画像生成モデル

Qwen-Image-Layered は画像を複数の RGBA レイヤーに分解でき、各レイヤーは他のコンテンツに影響を与えることなく独立して編集可能。色変更、置換、削除、サイズ変更、位置移動などの操作をサポート

Microsoft、TRELLIS.2を発表 - 40億パラメータの画像から3D生成モデル

Microsoftが40億パラメータの大規模3D生成モデルTRELLIS.2を発表。数秒で画像を高品質な3Dアセットに変換し、完全なPBRマテリアルと複雑なトポロジーをサポート

Alibaba Cloud PAI が Z-Image-Turbo-Fun-Controlnet-Union を発表 - 複数制御条件対応 ControlNet モデル

Alibaba Cloud PAI チームが Z-Image-Turbo-Fun-Controlnet-Union を発表。Canny、HED、Depth、Pose、MLSD を含む複数の制御条件に対応する ControlNet モデルで、1328 解像度でトレーニング済み

Alibaba AIDC-AI が Ovis-Image を発表 - テキスト描画に最適化された7Bパラメータの画像生成モデル

Alibaba AIDC-AI チームが高品質なテキスト描画に特化した7Bパラメータのテキスト画像生成モデル Ovis-Image を発表。複数のテキスト描画ベンチマークで優れた結果を達成し、単一のハイエンドGPUで効率的に動作

アリババ通義ラボがZ-Image-Turboを発表 - 6Bパラメータの効率的な画像生成モデル

アリババ通義ラボがZ-Image-Turboを発表。6Bパラメータの効率的な画像生成モデルで、わずか8ステップのサンプリングで高品質な画像を生成し、16GB VRAMのコンシューマー向けGPUでスムーズに動作

ByteDanceがSa2VAをリリース:初の統合型画像・動画理解モデル

ByteDanceはSa2VAマルチモーダルモデルを発表し、SAM2とLLaVA技術を組み合わせて画像・動画の密なセグメンテーションと視覚的質問応答を実現し、複数のベンチマークテストで最高峰の性能を達成

テンセントが混元画像3.0をオープンソースで公開 - 世界最大のオープンソーステキスト生成画像モデル

テンセントは、総パラメータ数800億個の商用レベルネイティブマルチモーダル画像生成モデル混元画像3.0をリリースしました。世界知識推論機能を備え、数千文字の複雑な意味理解をサポートしています

Nunchakuが4-Bit Lightning Qwen-Image-Edit-2509モデルをリリース

Nunchakuチームは、4-Bit Lightning Qwen-Image-Edit-2509モデルの最適化バージョンをリリースしました。4/8ステップの高速推論をサポートし、8GB VRAM環境でもスムーズに実行できます

アリババ、Wan-Animateモデルを発表 - 統合キャラクターアニメーションおよび置換技術

アリババ通義実験室がWan-Animateを発表、Wan2.2ベースの統合キャラクターアニメーションフレームワークで、キャラクターアニメーション生成およびビデオキャラクター置換をサポート、モデル重みと推論コードをオープンソース化

Comfy Cloud - クラウドで手軽にComfyUIを利用

Comfy Cloudは、強力なGPU、人気モデル、カスタムノードを備えたComfyUIへの簡単なアクセスを提供します。無料のクラウド版ComfyUIを体験できるプライベートベータにご参加ください。

テンセント・フンユアンワールド・ボイジャー:1枚の画像から3Dワールド探索ビデオを生成

テンセント・フンユアンチームがボイジャー技術をリリース、単一画像とユーザー定義のカメラパスからワールド一貫性のある3Dポイントクラウドシーケンスビデオを生成可能に、無限ワールド探索と直接3D再構成をサポート

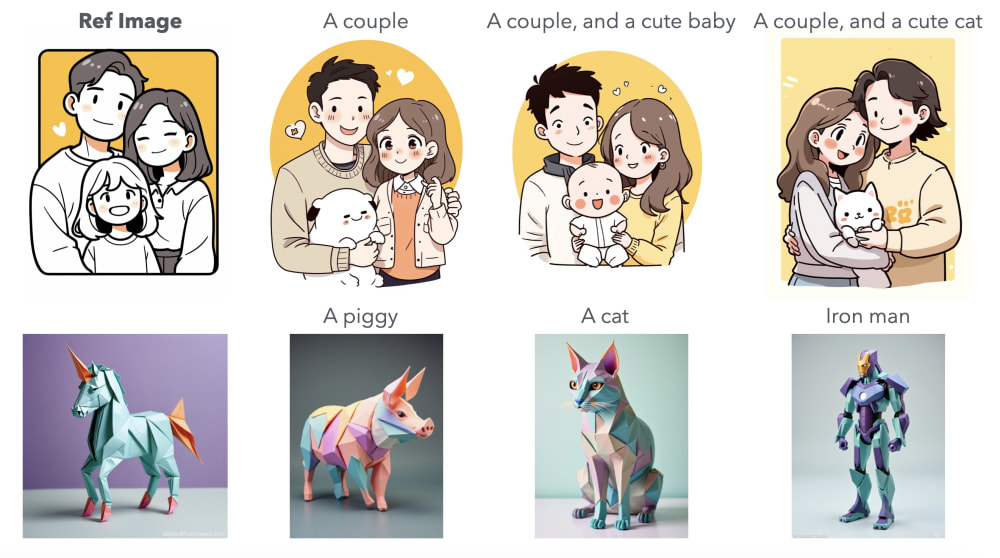

ByteDance、USOをリリース:統一されたスタイルと主体駆動型の画像生成モデル

ByteDanceがUSOモデルを発表。任意の主体と任意のスタイルを自由に組み合わせ、主体の一貫性を維持しながら高品質なスタイル転送効果を実現

Wan2.2-S2V:音声駆動型動画生成モデルがリリース

Wan2.2-S2Vは、静止画と音声を動画に変換できるAI動画生成モデルで、対話、歌唱、演技などのコンテンツ制作ニーズをサポートします。

ComfyUIチャレンジ #1: 参加して100ドルを獲得

最初のComfyUIウィークリーチャレンジに参加して100ドルを獲得しましょう!提供された深度マップを使って、猫男のキャラクターをひっくり返す動画を作成してください。

InfiniteTalk オープンソースリリース - 無制限長対応の音声駆動型ビデオ生成技術

MeiGen-AIチームがInfiniteTalkモデルをオープンソース化し、精密なリップシンクと無制限長ビデオ生成を実現。画像からビデオ、ビデオからビデオへの変換をサポートし、デジタルヒューマン技術に新たな突破口をもたらしました。

ComfyUIがサブグラフ機能を正式リリース

ComfyUIがサブグラフ機能を正式リリースし、ユーザーが複雑なノードの組み合わせを再利用可能な個別のサブグラフノードにパッケージ化できるようになり、ワークフローのモジュール性と管理が大幅に向上します。

ComfyUIでQwen-Imageがネイティブ対応

Qwen-Imageは200億パラメータのMMDiT画像生成モデルで、複雑な文字レンダリングと精密な編集を得意とします。ComfyUIでネイティブに利用可能になりました。本記事は主な機能、ライセンス、リソースを簡潔にまとめます。

Tencent Hunyuanチーム、人間の嗜好アライメント訓練効率を向上させるMixGRPOフレームワークをオープンソース化

Tencent Hunyuanチームが、GRPOにスライディングウィンドウ混合ODE-SDEサンプリングを統合した初のフレームワークMixGRPOをオープンソース公開。拡散モデルとフローモデルの人間嗜好アライメントで最大71%の訓練高速化を実現。

Black Forest Labs、FLUX.1 Krea [dev] オープンソース版リリース、ComfyUIネイティブサポート

Black Forest LabsとKreaの協力によりFLUX.1 Krea [dev]モデルが正式リリースされました。これはテキスト-画像生成に特化した最高のオープンソースFLUXモデルです。ComfyUIがネイティブサポートを実装し、ユーザーが最新のテキスト-画像生成技術を直接体験できるようになりました。

WAN2.2 オープンソース版リリースとComfyUIによるDay 0ネイティブサポート

WANチームがWan2.2のオープンソース版を正式リリース。革新的なMoEアーキテクチャを採用し、ビデオ生成の品質が大幅に向上。ComfyUIはネイティブサポートを実現し、ユーザーは最新のビデオ生成技術を直接体験可能。

ByteDanceがSeed-X 7Bをオープンソース化:28言語対応のコンパクトな翻訳モデル

ByteDanceは翻訳タスク向けに設計されたSeed-X 7Bモデルをオープンソース化しました。28言語間の翻訳をサポートし、AI画像生成など様々なシーンへの統合に適しています。

PUSA V1.0: 低コストで高性能な動画生成モデルがリリース

PUSA V1.0は革新的なVTA技術を活用し、最小限のデータとコストで高品質なマルチタスク動画生成を実現。画像から動画、キーフレーム生成、動画拡張、テキストから動画など、多様な機能をサポート。

AMAPがFLUX-Textシーンテキスト編集新手法を発表

AMAPチームがFLUX-Textを発表。拡散モデルに基づく新しいシーンテキスト編集手法で、多言語・スタイル一貫性・高忠実度テキスト編集をサポート。

OmniAvatar: 音声制御による効率的な仮想人物動画生成モデルのリリース

OmniAvatarモデルがオープンソース化され、自然な動きと豊かな表情を持つ音声制御のフルボディ仮想人物動画の生成が可能に。ポッドキャスト、インタラクション、ダイナミックなシーンなど、様々な用途に対応

通義研究所がThinkSoundをリリース:マルチモーダル音声生成・編集の新パラダイム

通義研究所が、チェーン推論をサポートする初のAny2Audio統合音声生成・編集フレームワークThinkSoundをオープンソースで公開。動画、テキスト、音声などのマルチモーダル入力に対応し、高い忠実度、強力な同期、インタラクティブな編集機能を実現。

XVerse公開: 複数の被写体のアイデンティティと意味的属性を制御できる高一貫性画像生成モデル

ByteDanceがXVerseモデルをオープンソース化。複数の被写体のアイデンティティと意味的属性(ポーズ、スタイル、照明など)を正確に独立制御することを可能にし、AI画像生成のパーソナライゼーションと複雑なシーン生成能力を向上

Flux.1 Kontext Dev オープンソース版がリリース、ComfyUI がネイティブサポートを提供

Black Forest Labs が 120 億パラメータの拡散トランスフォーマーモデル Flux.1 Kontext Dev オープンソース版をリリース、ComfyUI が即時にネイティブサポートを提供

OmniGen2リリース:自然言語指示による統合画像理解・生成モデル

VectorSpaceLabがOmniGen2をリリース。自然言語指示による精密な局所画像編集をサポートする強力なマルチモーダル生成モデルで、オブジェクトの削除・置換、スタイル転換、背景処理などの編集タスクに対応

NVIDIA、拡散モデルベースの汎用リライティング技術 UniRelight を発表

NVIDIAの研究チームが、単一の画像や動画から高品質なリライティング効果を実現する拡散モデルベースの汎用リライティング技術 UniRelight を発表

シンガポール国立大学がOmniConsistencyを発表 - 低コストで画像スタイル化の一貫性を実現

NUSチームがOmniConsistencyプロジェクトを発表、2,600組の画像と500時間のGPU訓練のみでGPT-4oレベルの画像スタイル化一貫性を実現、ComfyUIノードにも対応

Black Forest Labs が FLUX.1 Kontext をリリース:コンテキスト認識画像編集モデルスイート

Black Forest Labs は FLUX.1 Kontext シリーズモデルを発表し、テキストと画像入力に基づくコンテキスト認識編集を初めて実現、キャラクター一貫性保持とローカライズ編集機能をサポート

ID-Patch:複数人物の個性を活かした集合写真生成の新手法

ByteDanceとミシガン州立大学が共同でID-Patch手法を提案。複数人物の個性を活かした画像生成を実現し、アイデンティティの保持と生成効率を向上。集合写真や広告など、複数キャラクターのシーンに適しています。

テンセントが音声デジタルヒューマンモデル HunyuanVideo-Avatar をオープンソース化:1枚の画像と音声で自然なデジタルヒューマン動画を生成

テンセントは HunyuanVideo-Avatar を発表し、画像と音声から高精度かつ感情制御可能なデジタルヒューマン動画を生成。短編動画やEC広告など多様なシーンに対応。

IndexTTS 1.5リリース:高品質中国語・英語音声合成モデル

IndexTTSがバージョン1.5をリリース、モデルの安定性と英語性能を大幅に向上、ピンイン発音訂正と句読点による一時停止制御をサポート、複数のテストで主流TTSシステムを上回る性能を実現

StepFunがStep1X-3Dをオープンソース化 - 高精度3Dアセット生成フレームワーク

StepFunが単一画像から高品質な3Dジオメトリとテクスチャを生成するオープンソースフレームワークStep1X-3Dをリリース。200万件の高品質データセット、完全な訓練コード、モデル重みを含む

更新通知: ComfyUIフロントエンドに影響を与えるカスタムノード

最近のComfyUIアップデート後、一部のカスタムノードがフロントエンドの問題を引き起こす可能性があります。この記事では、影響を受けるプラグインと解決策をまとめ、適時のアップデートまたは関連プラグインのアンインストールを推奨しています。

Step1X-3Dが高品質な3Dアセット生成とオープンソース計画を発表

Step1X-3Dチームは高精度な3Dアセット生成ソリューションを公開し、モデル・データセット・コードをオープンソース化。多様な3Dアセット生成やテクスチャ合成に対応。

テンセントがマルチモーダル動画生成システムHunyuanCustomを発表

テンセントが、テキスト、画像、音声、動画の条件をサポートするマルチモーダル動画カスタマイズフレームワークHunyuanCustomを発表し、複数のシナリオで高い一貫性のある動画生成を実現

Insert Anything: シームレスな画像挿入のためのオープンソースフレームワーク

Insert Anythingは、参照画像から人物、オブジェクト、衣服などの要素をターゲットシーンにシームレスに挿入できるオープンソースの統合フレームワークで、さまざまなアプリケーションシナリオをサポートしています

Step1X-Edit: オープンソースAI画像編集フレームワーク

Step1X-Editは自然言語指示による画像編集をサポートする強力なオープンソース画像編集フレームワークで、GPT-4oやGemini2 Flashに匹敵する画像編集能力を提供します

Flex.2-preview:オープンソースAI画像生成モデルのリリース

Flex.2-previewは、汎用的なコントロールと組み込みのインペイント機能を備えたオープンソーステキストから画像への拡散モデルで、クリエイターにより強力な画像生成ツールを提供します

Sand AI、MAGI-1をリリース:大規模自己回帰型動画生成モデル

Sand AIは、チャンク単位で動画を生成する自己回帰型モデルMAGI-1をオープンソース化し、24Bおよび4.5Bパラメータバージョンを提供、複数の動画生成モードをサポート

SkyReels-V2発表:無限長の動画生成に対応するオープンソースモデル

SkyworkAIが新しいオープンソース動画生成モデルSkyReels-V2をリリース。無限長の動画生成に対応し、テキストから動画および画像から動画の両機能を兼ね備える

Nari LabsがDia 1.6Bテキスト対話音声合成モデルをリリース

Nari Labsがオープンソースのテキスト音声変換モデルDia 1.6Bを発表。テキストから直接複数キャラクターの対話を生成し、感情表現や非言語コミュニケーションをサポート

崑崙万維がSkyReels-V2無限長映画生成モデルをリリース

崑崙万維のSkyReelsチームが、拡散強制フレームワークを使用した世界初の無限長映画生成モデルSkyReels-V2をリリースしオープンソース化。高品質で長時間の動画コンテンツを生成可能

Shakker Labs、FLUX.1-dev-ControlNet-Union-Pro-2.0をリリース

Shakker Labsが制御効果を最適化し、複数の制御モードをサポートし、モデルサイズが小さくなった新しいFLUX.1-dev-ControlNet-Union-Pro-2.0モデルを発表

テンセント混元とInstantXチームがInstantCharacterオープンソースプロジェクトをリリース

InstantCharacterは、1枚の画像からキャラクターの一貫性を保った生成を実現する革新的なチューニング不要の手法で、さまざまな下流タスクをサポートします

FramePack: 動画生成のための効率的な次フレーム予測モデル

Lvmin Zhangが開発したFramePackテクノロジーは入力フレームコンテキストを圧縮し、動画生成の作業負荷を動画の長さに関係なく一定に保ち、ノートパソコンのGPUでも多数のフレームを処理可能にします

ByteDanceがSeaweed-7Bを発表:コスト効率の高い動画生成基盤モデル

Seaweed-7Bは、わずか70億パラメータで140億パラメータモデルを上回る性能を実現し、業界標準の3分の1のトレーニングコストで動画生成分野に新たな可能性をもたらします

FloED: 光学フローガイド拡散モデルを活用した効率的なオープンソース動画修復技術

新しい動画修復フレームワークFloEDがコードと重みを公開し、光学フローガイダンス技術によって高い動画一貫性と計算効率を実現

PixelFlow: ピクセル空間で直接動作する生成モデル

PixelFlowは生の画素空間で革新的に動作し、事前訓練された変分オートエンコーダを必要とせずに画像生成プロセスを簡素化し、エンドツーエンドで訓練可能なモデルを実現します

VAST-AIがHoloPart発表:生成的3Dパーツアモーダル分割技術

HoloPartは3Dモデルを完全で意味のあるパーツに分解し、3Dコンテンツ制作における編集課題を解決します

VAST-AIと清華大学がUniRigをオープンソース化:あらゆる3Dモデルの自動スケルトンリギングフレームワーク

UniRigは自己回帰モデルを活用して多様な3Dモデル向けの高品質スケルトン構造とスキニングウェイトを生成し、アニメーション制作ワークフローを大幅に簡素化

OmniSVG:復旦大学とStepFunが統合ベクターグラフィックス生成モデルを発表

OmniSVGは、テキスト、画像、キャラクターリファレンスなど様々な入力から高度に複雑で編集可能なベクターグラフィックスを生成できる新しい統合マルチモーダルSVG生成モデルです

TTT-Video: 長時間ビデオ生成のための技術

研究者らがCogVideoX 5Bをベースにしたテスト時学習技術を用いたTTT-Videoモデルを開発し、最大63秒の一貫性のあるビデオ生成を実現

ByteDanceがUNOを発表:少ないものから多いものへの生成能力の拡張

ByteDanceのクリエイティブインテリジェンスチームが、コンテキスト生成によってより高い制御性を実現するUNOモデルを発表し、単一から複数の被写体への高品質な画像生成を可能に

EasyControl: 拡散トランスフォーマーに効率的で柔軟な制御をもたらす新フレームワーク

Tiamat AIチームがEasyControlフレームワークをリリース、DiTモデルに条件付き制御機能を追加、ComfyUI-easycontrolプラグインを通じてComfyUIでのサポートが可能に

HiDream-I1オープンソースリリース - 次世代画像生成モデル

HiDream.aiが17B パラメータを持つ新しいオープンソーステキスト生成画像モデルHiDream-I1をリリース。複数のベンチマークで既存のオープンソースモデルを上回り、様々なスタイルの高品質画像生成をサポート

Hi3DGen: 法線橋渡しによる高忠実度3D形状生成の新フレームワーク

Stable-Xチームが、法線橋渡し技術により既存手法の幾何学的詳細の欠如を解決する、画像から高忠実度3Dモデルを生成する革新的フレームワークHi3DGenを発表

VAST AI ResearchがTripoSFをオープンソース化:3D生成技術の新たな高みを再定義

革新的なSparseFlex表現法に基づくTripoSFは、1024³解像度までの3Dモデル生成をサポートし、開放面や複雑な内部構造の処理が可能で、3Dアセットの品質を大幅に向上させます

崑崙万維がSkyReels-A2をオープンソース化:商用グレードの動画生成フレームワーク

崑崙万維が世界初の商用グレードの制御可能な動画生成フレームワークSkyReels-A2をリリース。デュアルブランチアーキテクチャにより複数要素の動画生成を実現し、Eコマース、映画制作などの分野に新たな可能性をもたらす

アリババの通義研究所がVACEをリリース:動画制作と編集が統合時代へ

アリババグループの通義研究所が、テキストから動画生成、動画編集、複雑なタスク組み合わせまでをカバーする世界初の統合フレームワークVACEを発表

StarVector: SVGコード生成のためのマルチモーダルモデル

StarVectorプロジェクトは、画像やテキストからSVGベクターグラフィックスコードを自動生成する機能を実装し、デザイナーや開発者に新しいクリエイティブツールを提供します。

バイトダンス、InfiniteYouをリリース:ユーザーのアイデンティティを保持しながら柔軟な写真再構築が可能に

バイトダンスが拡散トランスフォーマーに基づく革新的なフレームワークInfiniteYou(InfU)を発表。このフレームワークは、アイデンティティの類似性、テキスト画像の整合性、生成品質に関する既存手法の限界に対処しながら、ユーザーのアイデンティティを保持する柔軟な写真再構築を可能にします

Stability AIがStable Virtual Cameraをリリース:2D写真を3Dビデオに変換する技術

Stability AIが新しいAIモデルStable Virtual Cameraを発表。通常の写真をリアルな奥行きと遠近感を持つ3Dビデオに変換し、クリエイターに直感的なカメラコントロールを提供

StdGEN: 単一画像からの意味分解3Dキャラクター生成

清華大学とテンセントAI研究所が共同でStdGENを発表、単一画像から体、衣服、髪などのコンポーネントが分離された高品質な意味分解3Dキャラクターを生成する革新的パイプライン

テンセント、Hunyuan3D 2.0をリリース - 高品質な3D資産生成システム

テンセントは、テキストと画像から高解像度の3D資産を生成するための二段階プロセスを備えたHunyuan3D 2.0システムを発表しました。複数のオープンソースモデルシリーズを特徴としています

快手がReCamMaster単眼ビデオ再撮影技術を発表

快手科技がReCamMasterを発表しました。この技術は、ユーザーが単一のビデオから新しいカメラ視点と動きの軌跡を生成できる生成型ビデオ技術です。

Open-Sora 2.0のリリース:低コストで商業レベルのビデオ生成能力を実現

hpcaitechがOpen-Sora 2.0オープンソースビデオ生成モデルを発表。20万ドルのトレーニングコストで、トップクラスの商業モデルに近い性能を実現

アリ通義研究所がVACEを発表:統合ビデオ生成および編集モデル

アリ通義研究所が多機能ビデオ生成および編集モデルVACEを発表し、さまざまなビデオ処理タスクを単一のフレームワークに統合し、ビデオ制作のハードルを下げました。

マイクロソフト、ART多層透明画像生成技術を発表

マイクロソフトリサーチがグローバルテキストプロンプトに基づくインテリジェントレイヤー生成ソリューションを開発。50以上の独立レイヤーを含む透明画像の作成を可能に

Tencentが画像から動画を生成するオープンソースモデルHunyuanVideo-I2Vを公開

TencentのHunyuanチームが単一画像から5秒動画を生成可能なオープンソースモデルをリリース。スマートモーション生成とカスタムエフェクト機能を提供

Alibaba、文書解析ツールViDoRAGをオープンソース化

テキストと画像を同時に理解するAIシステム、複雑文書処理効率10%以上向上

智譜AIチーム(THUDM)CogView4をオープンソース化 - 中国語ネイティブ対応のDiTテキスト画像生成モデル

智譜AIチーム(THUDM)が日中バイリンガル入力と漢字生成可能なオープンソース画像生成モデルCogView4を公開、複数ベンチマークで首位を獲得

Sesame、CSM音声モデルで自然な対話を実現

SesameがデュアルTransformerアーキテクチャの会話型音声モデルCSMを公開、リアルタイム音声インタラクションとオープンソースコアを提供

アリババの万相 Wan2.1 ビデオ生成モデルが正式にオープンソースに

アリババが最新のビデオ生成モデルである Wan2.1 を正式にオープンソースにした。このモデルはわずか 8GB のビデオメモリで動作し、高画質ビデオ生成、動的字幕、多言語吹き替えをサポートし、VBench ランキングで Sora などを超える 86.22% の総スコアを記録した

アリババが ComfyUI Copilot をオープンソース:AI によって駆動されるスマートワークフローアシスタント

アリババ国際デジタル商業グループ(AIDC-AI)は ComfyUI Copilot プラグインをリリースしました。これは、自然言語インタラクションと AI によって駆動される機能を通じて ComfyUI の使用体験を簡素化し、中国語インタラクションをサポートし、スマートノードの推奨機能などを提供します。

アリババの万相2.1ビデオ生成モデルがオープンソースになる

アリババは、最新のビデオ生成モデルである万相2.1が2025年第二四半期にオープンソースになることを発表した。このモデルは、HDビデオ生成、動的字幕、多言語音声などをサポートし、VBenchランキングで84.7%の総スコアで首位に立っている

GoogleがPaliGemma 2 mixをリリース:多タスクをサポートするオープンソースの視覚言語モデル

Googleが新しいPaliGemma 2 mixモデルをリリースし、画像の説明、OCR、オブジェクト検出など多くの視覚タスクをサポートし、3B、10B、28Bの3つのスケールバージョンを提供

SkyworkがSkyReels-V1をオープンソース:AI短編映画創作に特化したビデオ生成モデル

Skyworkがオープンソースビデオ生成モデルSkyReels-V1をリリースし、文生ビデオと図生ビデオをサポートし、映画級の光影効果と自然な動作表現を実現し、商用も可能にした

Light-A-Video - トレーニング不要のビデオ再照明技術

研究者たちは新しいビデオ再照明手法Light-A-Videoを提案しました。この手法は、一貫した光注意(CLA)と段階的光融合(PLF)を通じて、時間的に滑らかなビデオ再照明効果を実現します。

StepFunがオープンソースのStep-Video-T2Vを発表:300億パラメータのテキストから動画生成モデル

StepFunはオープンソースのテキストから動画生成モデルStep-Video-T2Vを発表しました。300億パラメータを持ち、最大204フレームの高品質動画を生成でき、オンライン体験プラットフォームも提供しています。

Kuaishou(快手)がCineMasterを発表:3D認識による画期的な動画生成フレームワーク

Kuaishouが3D認識技術による高品質な動画コンテンツ制作を実現するCineMasterテキスト→動画生成フレームワークを正式リリース

アリババがInspireMusicをオープンソース化:革新的な音楽、歌声、オーディオ生成フレームワーク

アリババの最新オープンソースプロジェクトInspireMusic、FunAudioLLMをベースとした統合オーディオ生成フレームワークで、音楽制作、歌声生成など様々なオーディオ合成タスクをサポート。

Alibaba がACE++をオープンソース化:トレーニング不要のキャラクター一貫性画像生成

アリババ研究所が画像生成ツールACE++をオープンソース化。コンテキスト認識コンテンツ充填技術により、単一入力からキャラクター一貫性のある新しい画像を生成し、オンライン体験と3種類の専用モデルを提供。

ByteDanceがOmniHumanを発表:次世代人体アニメーション生成フレームワーク

ByteDanceの研究チームが人体アニメーション生成フレームワークOmniHuman-1を発表。1枚の画像とモーション信号から高品質な人体ビデオアニメーションを生成可能に。

DeepSeek、Janus-Pro-7Bをオープンソース化:マルチモーダルAIモデル

TurboDiffusion、動画生成加速フレームワークをリリース

清華大学チームがTurboDiffusionをオープンソース化。RTX 5090単体で100-205倍のエンドツーエンド拡散生成加速を実現し、動画品質を維持する動画生成加速フレームワーク

テンセントがHunyuan3D 2.0をリリース:オープンソースの高品質3D生成モデルと統合制作エンジン

テンセントがHunyuan3D 2.0をリリース。完全なDiTモデルをオープンソース化し、スケルタルアニメーションやスケッチから3Dへの変換など、革新的な機能を備えたワンストップ3D制作エンジンを提供。メタバースとゲームコンテンツ制作に革命をもたらす

ComfyUIプロジェクト2周年

ComfyUIは2周年を迎え、個人プロジェクトから世界で最も人気のある生成AIビジュアルツールへと進化しました。ComfyUI、お誕生日おめでとうございます!

NVIDIAオープンソースSana - 効率的な4K画像生成のAIモデル

NVIDIAは新しいSanaモデルを発表しました。このモデルは、一般的なノートパソコンのGPUで最大4K解像度の画像を迅速に生成でき、ComfyUIの統合をサポートしています。

ByteDanceがLatentSyncをオープンソース化 - 拡散モデルベースの高精度リップシンク技術

ByteDanceが音声条件付き潜在空間拡散モデルに基づくリップシンクツールLatentSyncをオープンソースで公開。実写と アニメーションキャラクターの両方で精密なリップシンクを実現し、従来手法のフレームジッター問題を解決

VMix:ByteDanceが革新的な文章から画像生成モデルの美的向上技術を発表

ByteDanceと中国科学技術大学が共同でVMixアダプターを発表。クロスアテンション混合制御技術によりAI生成画像の美的品質を向上させ、再学習なしで既存モデルと完璧に統合

テンセントがStereoCrafterをオープンソース化:通常の動画を3D動画に一発変換

テンセントAI LabとARC Labが共同開発したStereoCrafterモデルがオープンソース化。2D動画を高品質な立体3D動画に変換可能で、Apple Vision Proを含む様々な3Dディスプレイに対応

LuminaBrush: ControlNetの開発者がAIライティング編集ツールをリリース

ControlNetとIC-Lightの開発者lllyasvielが新作LuminaBrushを発表。2段階フレームワークで正確な照明効果の制御を実現し、直感的なブラシ操作体験を提供

Genesis:革新的汎用物理エンジンと生成AIプラットフォームをリリース

Genesisプロジェクトが新しい汎用物理エンジンと生成AIプラットフォームをリリース。物理シミュレーション、ロボット制御、生成AI機能を統合し、ロボットと物理AIアプリケーションの包括的なソリューションを提供

Odysseyが革新的な生成型ワールドモデルExplorerをリリース

Odysseyが初の生成型ワールドモデルExplorerを発表。2D画像を完全な3D世界に変換し、ダイナミックな効果とメインストリームのクリエイティブツールによる編集をサポートし、映画、ゲームなどの分野に革新的な変化をもたらします

ComfyUI Impact-Packプラグインでマイニングウイルスが発見 - 緊急対応が必要

ComfyUIコミュニティの人気プラグインImpact-PackがUltralyticsパッケージを通じてマイニングマルウェアを含んでいることが判明し、多数のユーザーに影響。本記事ではウイルスの状況と解決策を詳しく説明します。

Lumaが新しいAI画像生成モデルPhotonを発表 - 高コストパフォーマンスのクリエイティブ生成エンジン

LumaがPhotonとPhoton Flashという革新的な画像生成モデルを発表し、優れたコストパフォーマンスと卓越した画質でAIクリエイション分野を再定義

テンセント、HunyuanVideo - 動画生成の新時代を切り開く大規模モデルをオープンソース化

テンセントが業界最大規模の動画生成モデルHunyuanVideoを正式にオープンソース化。130億のパラメータを持ち、動画品質や動きの安定性などで最高水準を達成

Stability AI が Stable Diffusion 3.5 Large ControlNet モデルをリリース

Stability AI が Stable Diffusion 3.5 Large 用の新しい ControlNet モデル3種(Blur、Canny、Depth)をリリースし、画像生成のより精密な制御を実現

NVIDIA、Edify 3Dを発表 - 革新的な3Dアセット生成技術

NVIDIAは、新しいEdify 3D技術を発表しました。この技術は、詳細なジオメトリ、明確なトポロジー、高解像度のテクスチャ、PBRマテリアルを含む高品質の3Dアセットをわずか2分で生成することができます。

Lightricks、リアルタイムビデオ生成モデルLTX-Videoを発表

Lightricksは、DiTに基づくリアルタイムビデオ生成モデルLTX-Videoを発表しました。高品質なビデオをリアルタイムで生成でき、GitHubとHugging Faceでオープンソース化されています。

InstantX、FLUX.1-dev IP-Adapterモデルをリリース

InstantXチームは、FLUX.1-devに基づくIP-Adapterモデルをリリースし、FLUXモデルにより強力な画像参照機能をもたらしました

FLUX公式ツールスイートのリリース

Black Forest Labsがローカルリドロー、ControlNet、画像スタイル変換を含む多様なFLUX公式ツールをリリース

IC-Light V2リリース: 画像編集機能の強化

IC-Light V2は、油絵やアニメスタイルを含む様々なスタイライズ画像処理をサポートするFluxベースの画像編集モデルです。この記事では、IC-Light V2の新機能と応用について詳しく説明します。

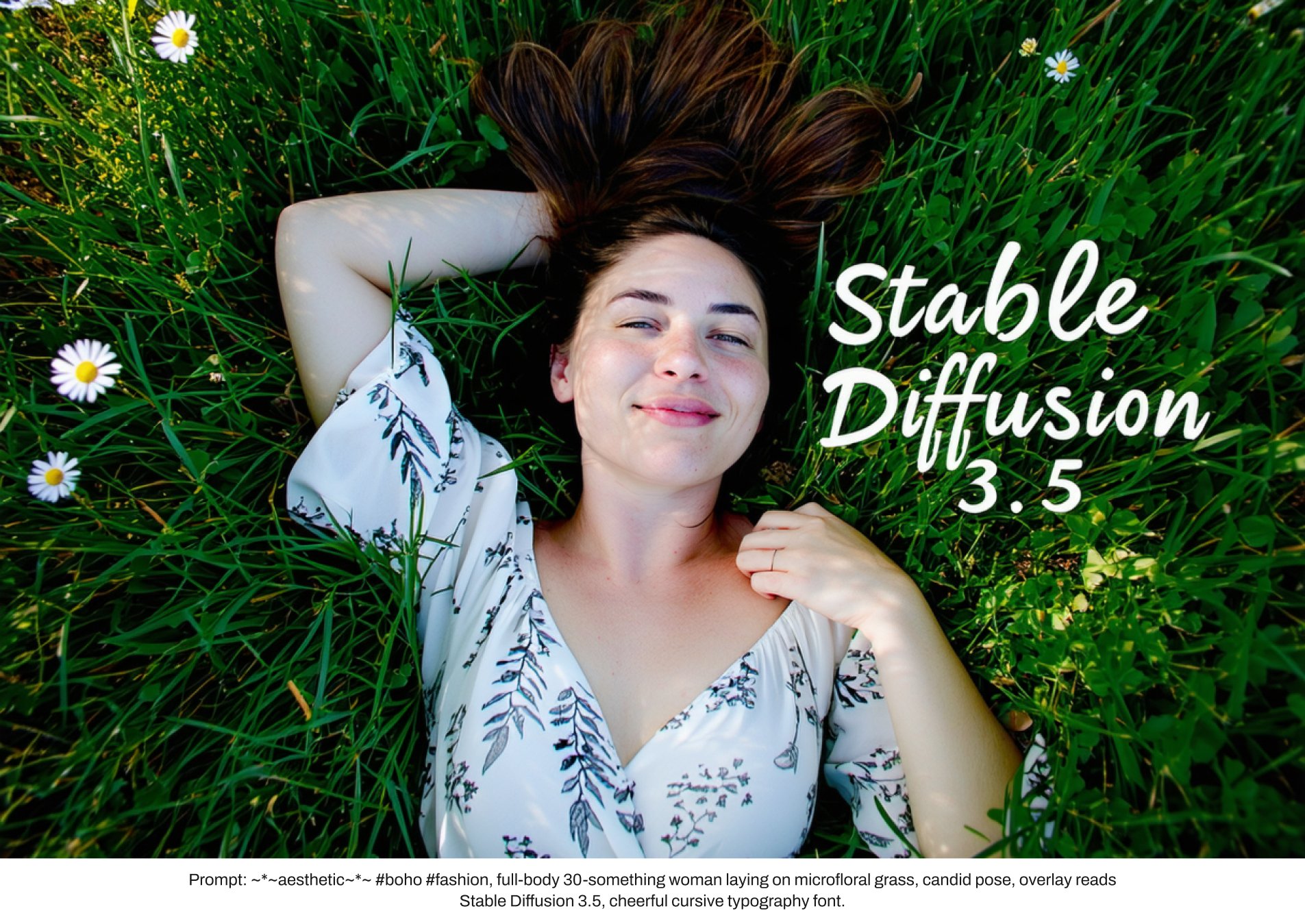

Stable Diffusion 3.5の登場: AI画像生成の新時代

Stability AIはStable Diffusion 3.5をリリースし、複数の強力なモデルバリアントを提供し、商用利用をサポートし、画像品質とプロンプトの適合性で市場をリードしています。

ComfyUI V1リリース: ワンクリックインストール可能なクロスプラットフォームデスクトップアプリ

ComfyUIはバージョン1をリリースし、ワンクリックインストールが可能なクロスプラットフォームデスクトップアプリケーション、新しいユーザーインターフェース、多数の機能改善を提供し、ユーザー体験を大幅に向上させます。

KuaishouとPKU、ピラミッドフローマッチングビデオ生成モデルを共同リリース

Kuaishou Technologyと北京大学が共同で開発したピラミッドフローマッチングモデルは、フローマッチングに基づく自己回帰型ビデオ生成技術であり、高品質で長時間のビデオコンテンツを生成することが可能です。

Jasperai、Flux.1-dev ControlNetモデルシリーズをリリース

Jasperaiは、Flux.1-dev用のControlNetモデルシリーズを発表しました。これには、サーフェスノーマル、デプスマップ、超解像モデルが含まれ、AI画像生成の精度を向上させます。

ComfyUI-PuLID-Flux: ComfyUIでのPuLID-Fluxの実装

ComfyUI-PuLID-Fluxは、ComfyUIにPuLID-Fluxを統合するオープンソースプロジェクトであり、強力な画像生成と編集機能を提供します。

Meta、Movie Genを発表:ビデオおよびオーディオ生成のためのAIモデル

Metaは、ビデオ生成、オーディオ生成、パーソナライズされたビデオ編集機能を含むMovie Genシリーズのモデルを紹介し、AIコンテンツ生成の新たなフロンティアを開きます。

ostris、商用可能なFLUX.1-schnellのデディスティル版OpenFLUX.1をリリース

ostrisは、FLUX.1-schnellモデルのデディスティル版であるOpenFLUX.1をリリースしました。このモデルはファインチューニングが可能で、通常のCFG値を使用し、商用ライセンスを保持しています。

Black Forest Lab、FLUX 1.1 [Pro]を発表

Black Forest Labsは、超高速生成、優れた画像品質、2K超高解像度生成を特徴とする生成AIモデルFLUX1.1 [pro]を紹介し、クリエイター、開発者、企業に前例のない機会を提供します。

THUDM、新しい画像生成モデルCogView3とCogView-3Plusをオープンソース化

THUDMは最新の画像生成モデルCogView3とCogView-3Plus-3Bをオープンソース化し、優れた性能と効率性を示しています。CogView3はカスケード拡散技術を利用し、CogView-3Plus-3BはDiTアーキテクチャに基づく軽量モデルで、テキストから画像生成の分野に大きなブレークスルーをもたらします。