ByteDanceがUNOを発表:少ないものから多いものへの生成能力の拡張

ByteDanceのクリエイティブインテリジェンスチームが最近、「Less-to-More Generalization(少ないものから多いものへの汎化)」を核心概念とする汎用画像生成フレームワーク「UNO」を発表しました。このフレームワークはコンテキスト生成によってより高い制御性を実現し、単一の被写体から複数の被写体への高品質な画像生成を可能にします。

UNOフレームワークはコンテンツクリエイターにより柔軟で強力なツールを提供し、複雑なシーンにおいて複数のオブジェクトの特性を維持しながら精密な制御を可能にし、AIが生成する画像をクリエイターの意図により適合させます。

解決される主要な課題

従来のAI画像生成モデルは、複数の特定オブジェクトを扱うシーンにおいて二つの大きな課題に直面しています:

- データの拡張性の問題:単一被写体のデータセットから複数被写体のデータセットへの拡張は特に困難であり、高品質で多角度かつ被写体一貫性のあるペアデータを大規模に取得することが難しい

- 被写体の拡張性の問題:既存の手法は主に単一被写体の生成に焦点を当てており、複数被写体シナリオの複雑な要件に適応することが困難

UNOはユニークなアプローチでこれらの問題を解決し、より一貫性があり制御可能な画像生成結果を実現しています。

技術原理の解説

UNOフレームワークは二つの重要な技術革新を導入しています:

-

段階的クロスモーダルアライメント:二段階の訓練戦略

- 第一段階:コンテキスト生成された単一被写体データを使用して事前訓練されたT2Iモデルを微調整し、S2I(Subject-to-Image)モデルに変換

- 第二段階:生成された複数被写体データペアを使用してさらに訓練し、複雑なシーンを処理するモデルの能力を向上

-

ユニバーサル回転位置エンベディング(UnoPE):視覚的な被写体制御を拡張する際に発生する属性混同の問題を効果的に解決する特殊な位置エンコーディング技術で、モデルが複数の被写体の特性を正確に区別し維持することを可能に

高一貫性データ合成パイプライン

UNOの大きな革新の一つは、高一貫性データ合成パイプラインです:

- 拡散トランスフォーマーの内在的コンテキスト生成能力の活用:現在の拡散モデルのポテンシャルを最大限に活用

- 高一貫性の複数被写体ペアデータの生成:特定のデータ生成戦略を通じて、訓練データの品質と一貫性を確保

- 反復訓練プロセス:テキストから画像へのモデルから、複数の画像条件を処理する複雑なモデルへと段階的に進化

このアプローチはデータ取得の課題を解決するだけでなく、生成結果の品質と一貫性も向上させます。

実際の応用シナリオ

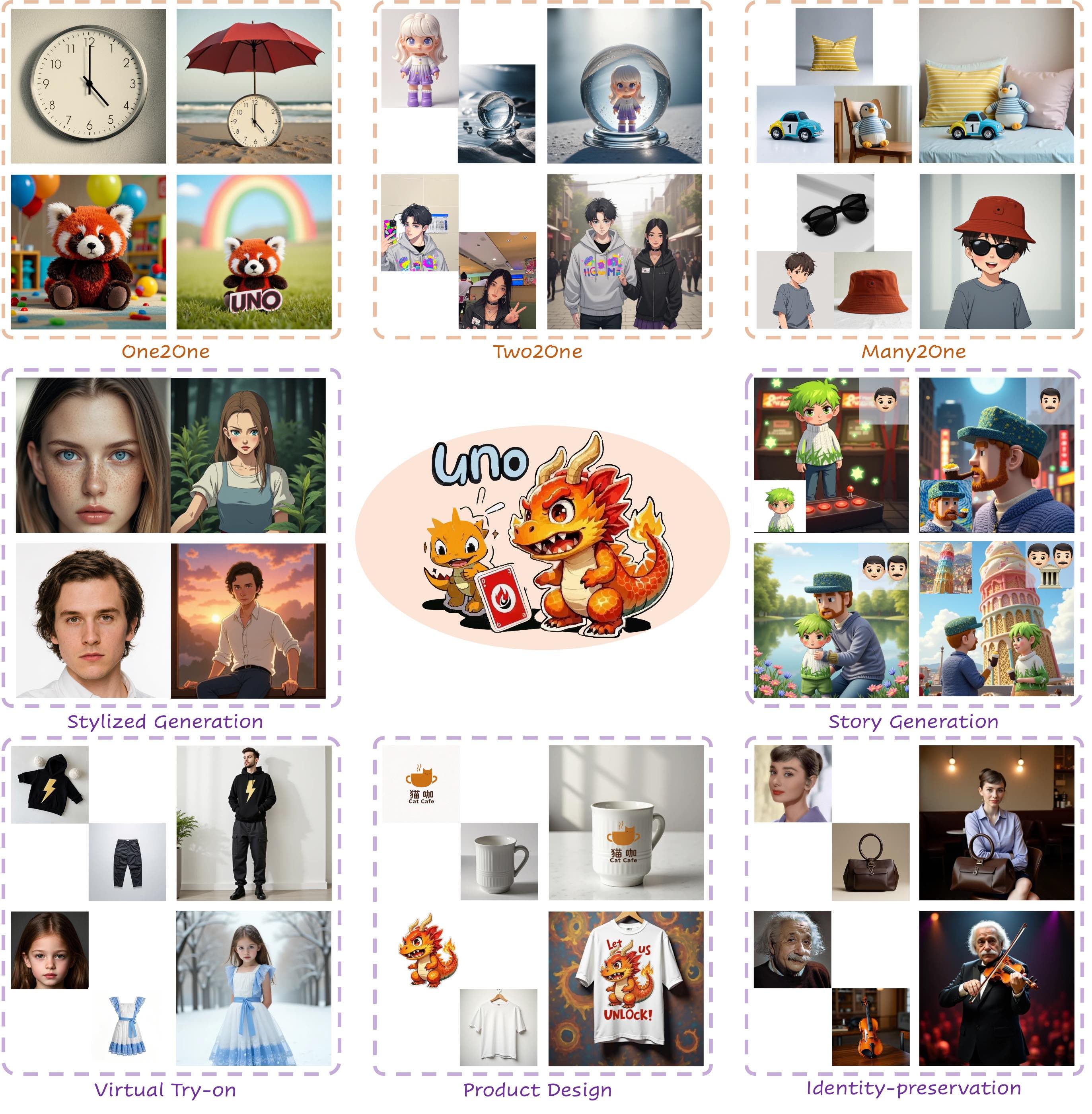

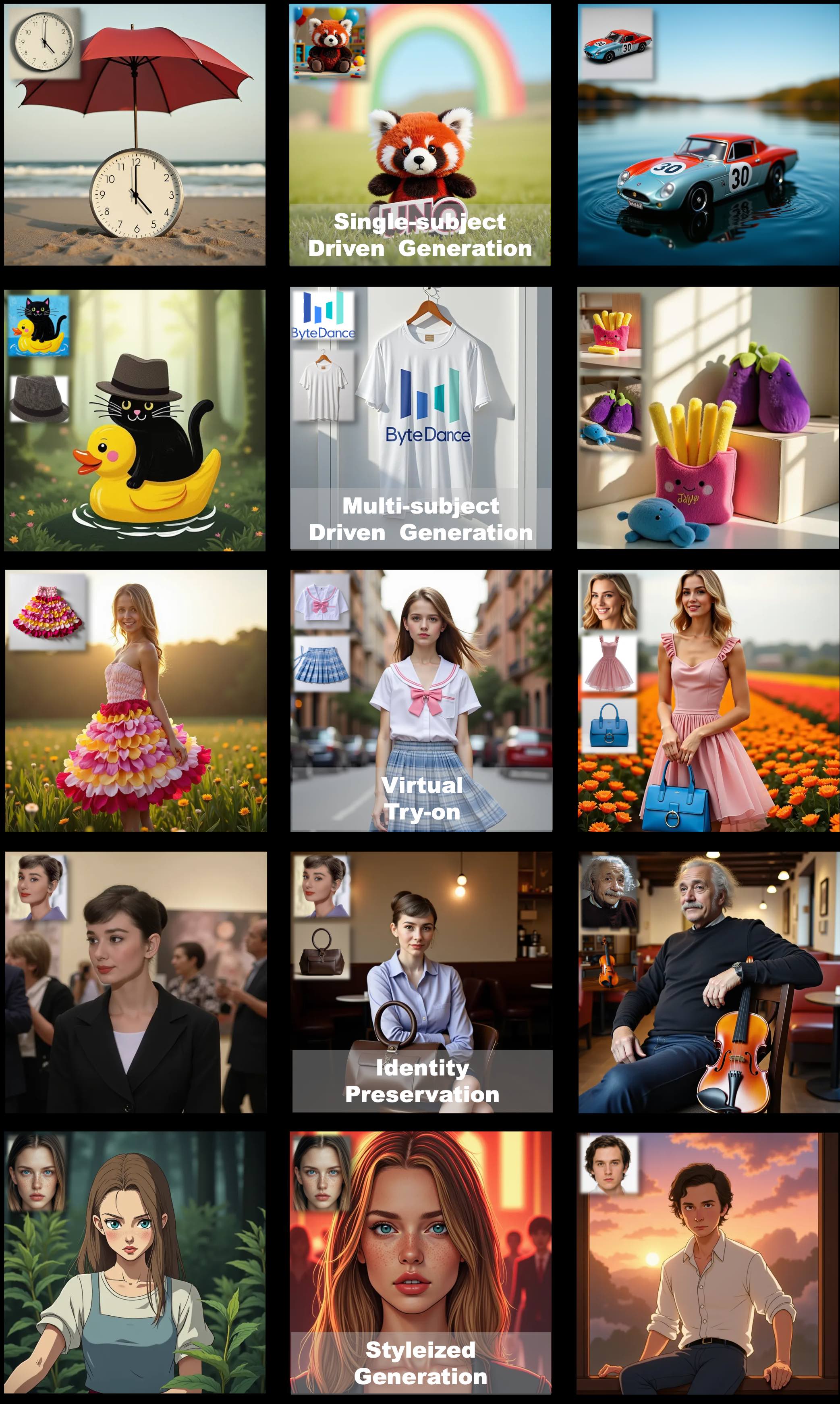

UNOモデルは多様な実用的能力を示し、以下のような用途に適用できます:

- 複数被写体のカスタマイズ生成:同じシーン内に複数の特定オブジェクトを配置し、それぞれの特性を維持

- バーチャル試着と製品展示:さまざまな環境で特定の製品やサービスを展示

- ブランドカスタマイズコンテンツ:ブランドの一貫性を維持しながら、さまざまなシーンにブランド要素を統合

- クリエイティブデザインとコンテンツ制作:デザイナーやコンテンツクリエイターにより豊かな創作可能性を提供

汎化能力の展示

UNOモデルは強力な汎化能力を示し、様々なタスクを統一的に処理できます:

- 単一被写体から複数被写体への移行:単純なシーンから複雑なシナリオへの拡張

- 異なるスタイルへの適応:被写体の特性を維持しながら、異なるスタイル要件に適応

- 複数の創造的タスクの統合:以前は複数の専門モデルを必要としたタスクを1つのモデルで処理

オンライン体験

以下のインターフェースを通じて、UNOの強力な機能を直接体験できます:

技術パラメータとオープンソース情報

UNOモデルはFLUX.1をベースに開発され、ByteDanceチームによってオープンソース化されており、トレーニングコード、推論コード、モデルの重みが含まれています。

このプロジェクトはGitHubで公開されており、研究者や開発者が自由に技術にアクセスして使用することができます。プロジェクトコードはApache 2.0ライセンスに従い、モデルの重みはCC BY-NC 4.0ライセンスの下で公開されています。FLUX.1-devベースモデルに関連するモデルは、元のライセンス条項に従う必要があることに注意が必要です。