Wan2.1 Fun Control ComfyUI ワークフロー - 完全ガイド

Wan2.1-Fun-Controlは、Alibabaチームによってリリースされた最新のビデオ制御機能で、深度、openpose、cannyなどのビデオ制御機能を実現できます。現在、このモデルは1.3Bと14Bの2つのカテゴリに分かれています。

- Wan2.1-Fun-1.3B-Control

- Wan2.1-Fun-14B-Control

- 対応するコードリポジトリ: VideoX-Fun

本ガイドでは、2種類のワークフローについて説明します。

- ComfyUIのネイティブワークフロー

-

- 完全ネイティブ(サードパーティのカスタムノードに依存しない)

-

- ネイティブワークフローの改良版(カスタムノードを使用)

- Kijaiの ComfyUI-WanVideoWrapper ワークフローを使用

- 2つのワークフローはモデルが基本的に同じですが、元のワークフローの状況やモデルの使用に合わせるために異なるソースのモデルを使用しています。

- 動画関連では、ComfyUI-VideoHelperSuite というカスタムノードパッケージを使用して、動画の読み込みやmp4動画の保存、結合などの豊富な動画操作を行うことができます。

- プラグインのインストールについては、カスタムノードのインストール方法を参照してください。

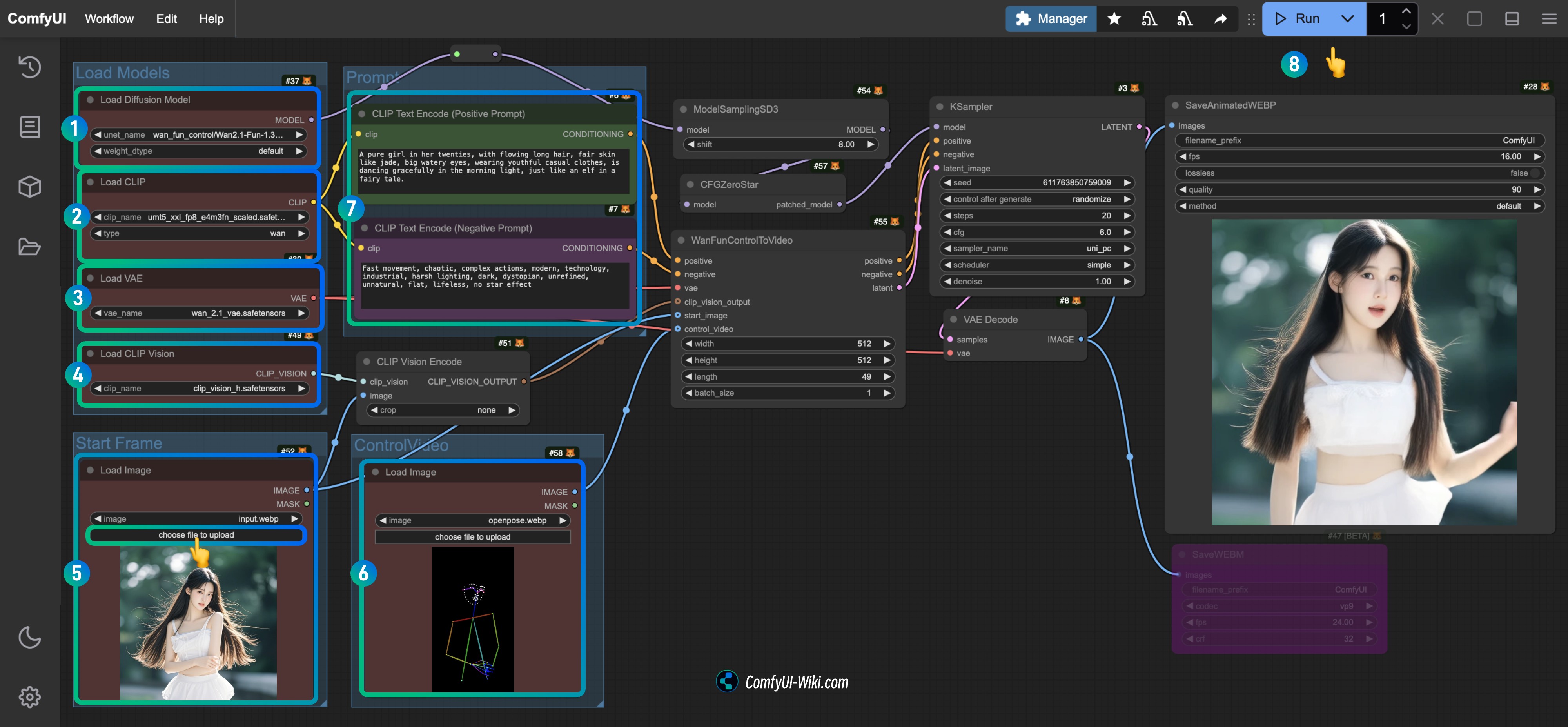

ComfyUI ネイティブ Wan2.1 Fun Control ワークフロー

現在、ComfyUIはWan Fun Controlモデルをネイティブにサポートしていますが、2025年4月10日現在、公式に対応するワークフローの例はリリースされていません。

開始する前に、あなたのComfyUIのバージョンが少なくともこのコミット以降であることを確認してください。そうしないと、対応するWanFunControlToVideoノードを見つけることができません。 ComfyUIの更新方法を参照して、ComfyUIを更新してください。

1.1 Wan2.1 Fun Control ワークフローファイルのダウンロード

1.1.1 ワークフローファイル

以下の画像をダウンロードし、ComfyUIにドラッグすると、対応するワークフローが読み込まれ、モデルのダウンロードが促されます。

Json形式でダウンロード

1.1.2 開始フレームおよび制御動画

以下の画像と動画をダウンロードし、入力条件として使用します。

- ここでは、サードパーティのカスタムノードに依存せず、完全にネイティブノードを使用するために、前処理された制御動画を提供しています。

- ComfyUI-comfyui_controlnet_auxのようなカスタムノードを使用して、動画の前処理を行うことができます。

1.2 手動モデルのインストール

対応するモデルが正常にダウンロードされなかった場合、以下のモデルのダウンロードリンクを参照してください。

Diffusion models から1.3Bまたは14Bを選択します。14Bのファイルサイズは大きく、性能が向上しますが、同時にデバイスの性能要求も高くなります。

- Wan2.1-Fun-1.3B-Control:ダウンロード後、

Wan2.1-Fun-1.3B-Control.safetensorsに名前を変更します。 - Wan2.1-Fun-14B-Control:ダウンロード後、

Wan2.1-Fun-14B-Control.safetensorsに名前を変更します。

Text encoders から以下の2つのモデルのいずれかを選択します。fp16はサイズが大きく、性能要求が高いです。

VAE

CLIP Vision 画像特徴を抽出するために使用します。

ファイルの保存場所

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └── Wan2.1-Fun-1.3B-Control.safetensors # または選択したバージョン

│ ├── 📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # または選択したバージョン

│ └── 📂 vae/

│ │ └── wan_2.1_vae.safetensors

│ └── 📂 clip_vision/

│ └── clip_vision_h.safetensors 1.3 ステップに従ってワークフローを実行する

Load Diffusion ModelノードがWan2.1-Fun-1.3B-Control.safetensorsモデルを読み込んでいることを確認します。Load CLIPノードがumt5_xxl_fp8_e4m3fn_scaled.safetensorsモデルを読み込んでいることを確認します。Load VAEノードがwan_2.1_vae.safetensorsモデルを読み込んでいることを確認します。Load CLIP Visionノードがclip_vision_h.safetensorsモデルを読み込んでいることを確認します。Load Imageノードに前に提供された入力画像をスタートフレームとして読み込みます。Load Imageノードに前に提供された動画をアップロードし、制御条件として使用します。- (オプション)

CLIP Text Encoderノードで動画のプロンプトを変更します。 Runボタンをクリックするか、ショートカットCtrl(cmd) + Enter(リターン)を使用して動画生成を実行します。

1.4 ワークフローの分析

ネイティブのワークフローは主に動画フレームの取得に関するもので、対応するWanFunControlToVideoノードのデフォルトの長さは81(15フレーム毎秒で5秒の動画を生成)ですが、私が提供した制御動画は49フレームしかないため、調整を行いました。 また、動画生成後にキャラクターが突然近づくのは、スタートフレーム画像と制御動画のサイズが一致しないため、処理中にトリミングや拡大が行われたためです。

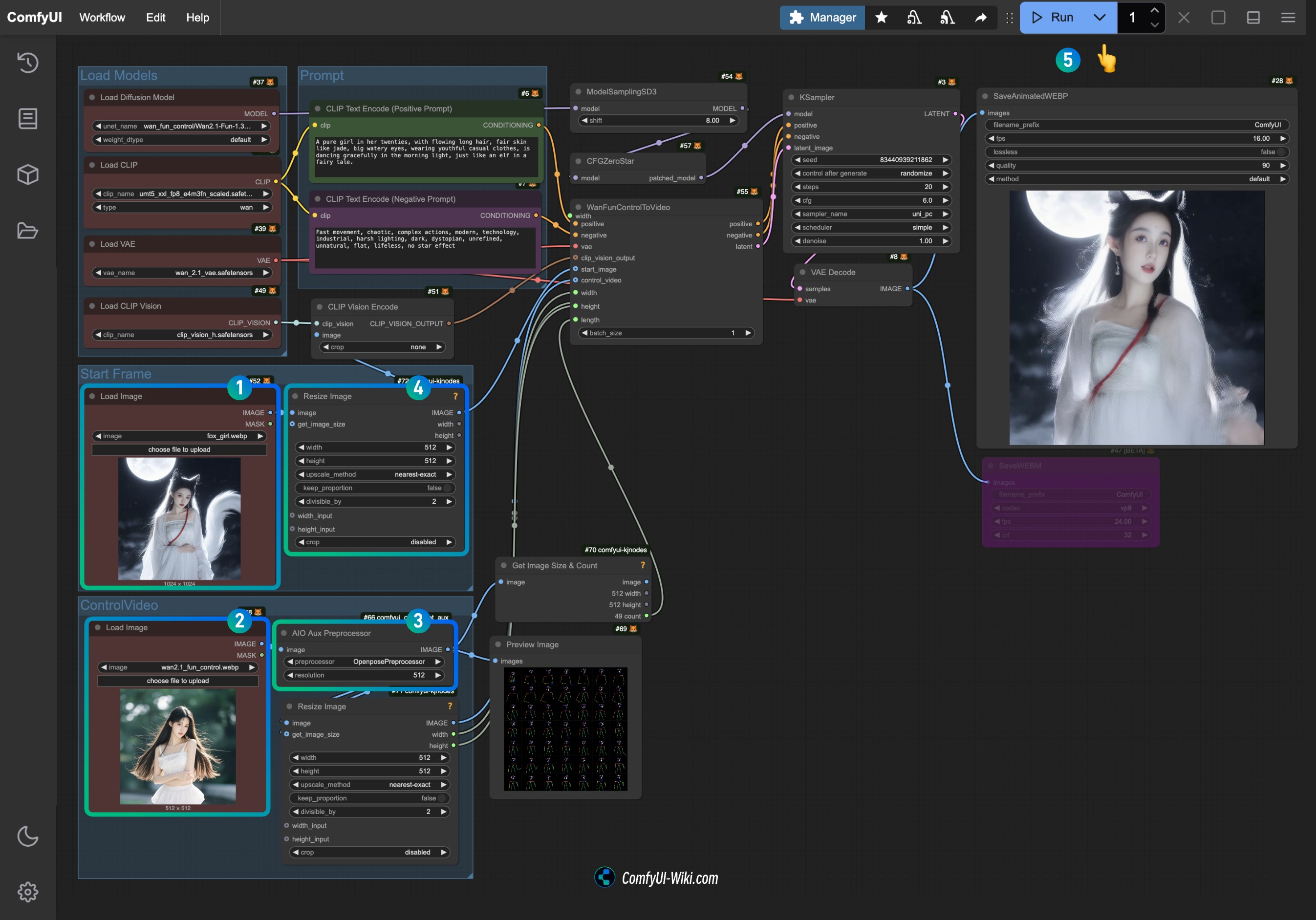

2. Wan2.1 Fun Control ネイティブワークフローの調整版

完全にネイティブなワークフローは動画のサイズとフレーム数の計算が便利ではないため、この改良版のワークフローでは以下のカスタムノードパッケージの一部ノードを使用しました:

- ComfyUI-KJNodes 動画のサイズを調整し、画像フレーム数を取得します。

- ComfyUI-comfyui_controlnet_aux: 動画画像の前処理を行います。

開始する前に、これらの2つのカスタムノードパッケージがインストールされていることを確認するか、ComfyUI-Managerを使用してワークフローの読み込み後にインストールしてください。

2.1 ワークフローファイルのダウンロード

2.1.1 ワークフローファイルのダウンロード

以下の画像をダウンロードし、ComfyUIにドラッグすると、対応するワークフローが読み込まれ、モデルのダウンロードが促されます。

2.1.2 入力動画のダウンロード

以下の画像と動画をダウンロードし、入力条件として使用します。

時間が足りなかったため、突然拡大効果のあるこの動画を入力として使用しました。

2.2 ステップに従ってワークフローを実行する

- スタートフレームの

Load Imageノードに提供された入力画像をアップロードします。 - コントロール動画の

Load Imageノードに前に提供された動画をアップロードし、制御条件として使用します。 AIO Aux Preprocessorで使用したい前処理器を選択します(初回実行時にHugging Faceから対応するモデルがダウンロードされます)。- サイズを調整する必要がある場合は、

Resize Imageノードのサイズ設定を変更し、両方のノードが一致するようにします。 Runボタンをクリックするか、ショートカットCtrl(cmd) + Enter(リターン)を使用して動画生成を実行します。

現在、Load Imageノードはmp4動画をサポートしていないため、入力動画が必要な場合は、ComfyUI-VideoHelperSuiteのLoad Video (Upload)ノードを使用して、さまざまな形式の動画入力を行うことができます。

3. 相关扩展

你可以在这些工作流基础上,再加上对应的图像生成的节点,从而能够不依赖输入参考图像而生成最后的视频

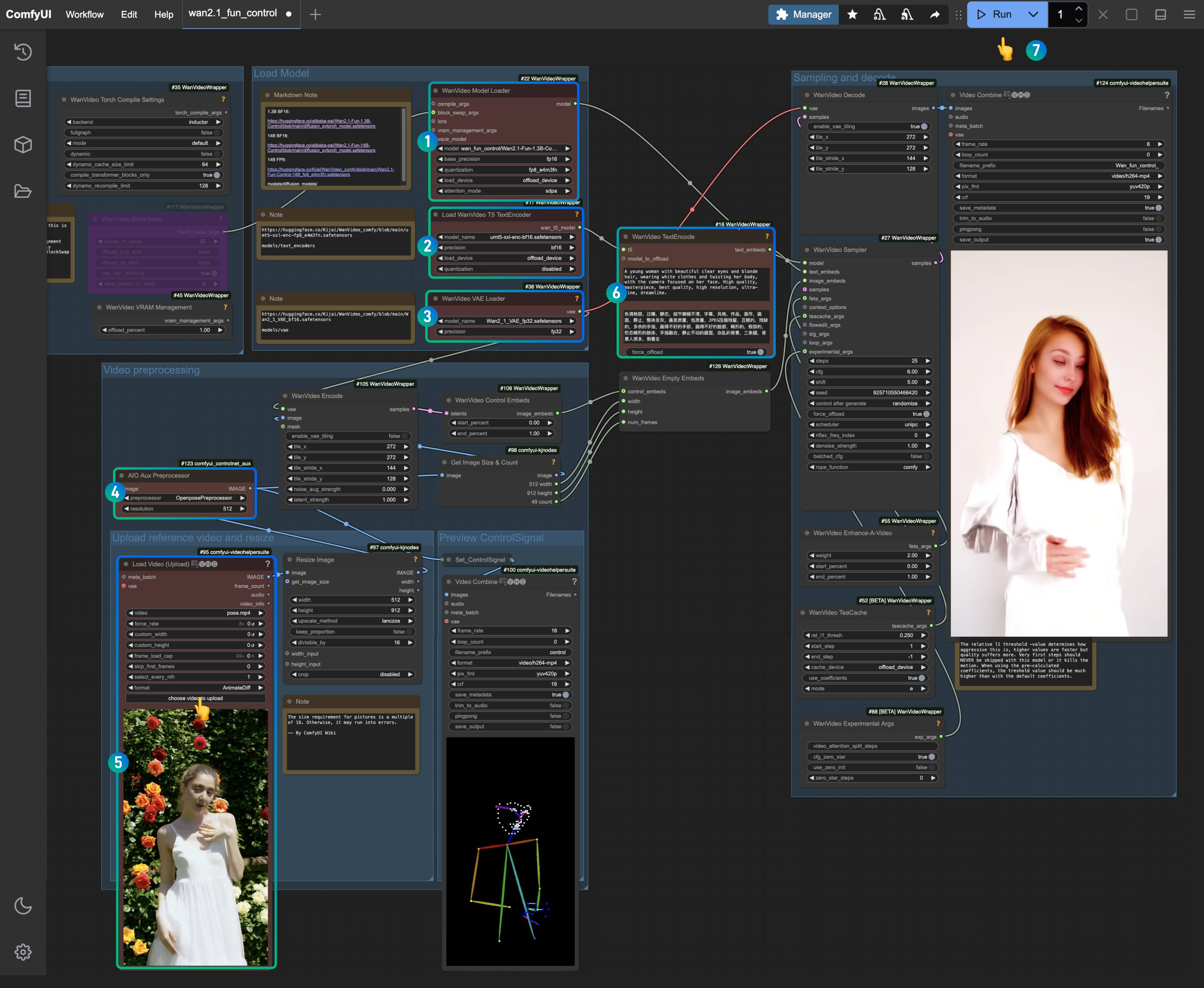

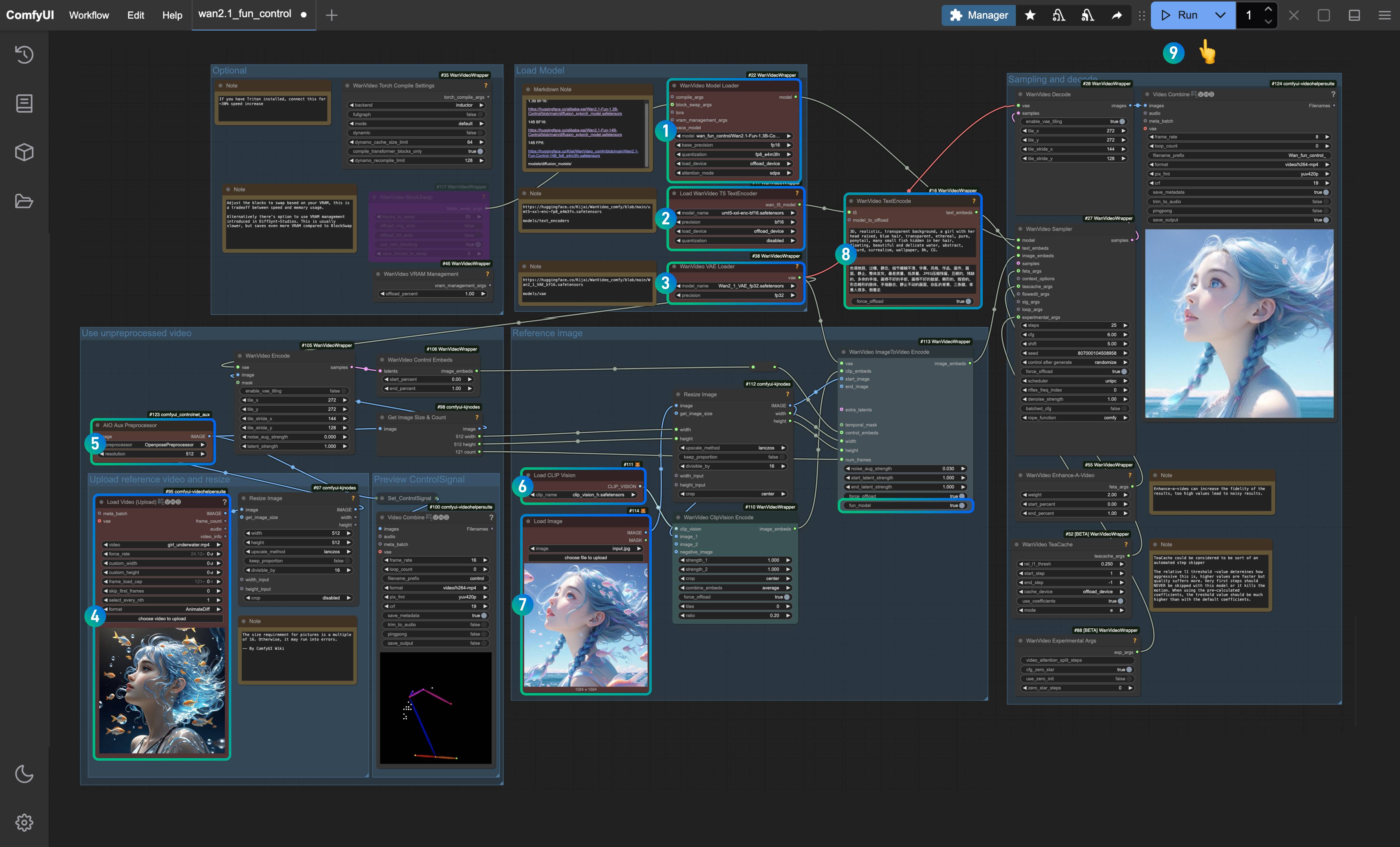

Kijai Wan Fun Control ワークフロー

KijaiのComfyUI-WanVideoWrapperプラグインを使用して、Fun-Controlの例を完成させます。Kijaiが提供する元のワークフローはこちらで見つけることができます。

このガイドに含まれるワークフローは、ComfyUI Wikiによって再編成されています。

このワークフローのセクションは、次の2つのカテゴリに分かれます:

- ビデオ制御条件のみを使用したテキストからビデオ画像への制御ワークフロー

- Clip_visionを使用して参照画像から特徴を分析および抽出し、ビデオ制御条件を追加する画像参照ビデオ生成の制御ワークフロー

関連インストール

カスタムノードのインストール

ワークフローがスムーズに動作することを保証するために、以下のプラグインをインストールする必要があります:

- ComfyUI-WanVideoWrapper:最新バージョンに更新する必要があります

- ComfyUI-VideoHelperSuite

- ComfyUI-KJNodes

- ComfyUI-comfyui_controlnet_aux:ビデオ画像の前処理用、または一般的に使用する画像前処理ノードに置き換えることができます

上記のカスタムノードを更新またはインストールするには、ComfyUI Managerを使用するか、カスタムノードのインストール方法を参照して対応するインストールを完了してください。

ComfyUI-comfyui_controlnet_auxは初回実行時に対応するモデルをダウンロードしますので、huggingfaceに正常にアクセスできることを確認してください。

モデルのインストール

Wan2.1 Fun Control 1.3Bと14Bの2つのモデルを提供しており、デバイスの性能に基づいて適切なモデルを選択できます。

- Wan2.1-Fun-1.3B-Control:ダウンロード後に

Wan2.1-Fun-1.3B-Control.safetensorsにリネーム - Wan2.1-Fun-14B-Control:ダウンロード後に

Wan2.1-Fun-14B-Control.safetensorsにリネーム - Kijai/Wan2.1-Fun-Control-14B_fp8_e4m3fn.safetensors

テキストエンコーダーから1つのバージョンを選んでダウンロード:

VAE

CLIP Vision

ファイル保存場所

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └── Wan2.1-Fun-1.3B-Control.safetensors # または選択したバージョン

│ ├── 📂 text_encoders/

│ │ └─── umt5-xxl-enc-bf16.safetensors # または選択したバージョン

│ ├── 📂 vae/

│ │ └── Wan2_1_VAE_bf16.safetensors

│ └── 📂clip_vision/

│ └── clip_vision_h.safetensors 1. ビデオ制御テキストからビデオへのワークフロー

1.1 ワークフローファイルのダウンロード

下の画像をComfyUIにドラッグして、対応するワークフローをロードします。

JSON形式でダウンロード。

以下のビデオを入力ビデオとしてダウンロード。

1.2 ワークフローステップの完了

以下の画像をダウンロードし、ComfyUIにドラッグして対応するワークフローをロードします。

対応するノードが、ダウンロードしたバージョンを使用して適切なモデルをロードしていることを確認してください。

WanVideo Model LoaderノードがWan2.1-Fun-1.3B-Control.safetensorsモデルをロードしていることを確認。Load WanVideo T5 TextEncoderノードがumt5-xxl-enc-bf16.safetensorsモデルをロードしていることを確認。WanVideo Vae LoaderノードがWan2_1_VAE_bf16.safetensorsモデルをロードしていることを確認。AIO AuxAux PreprocessorノードでOpenposePreprocessorノードを選択。Load Video(Upload)ノードで、先ほど提供した入力ビデオをアップロード。WanVideo TextEncodeで、生成したいビデオのプロンプトを入力(デフォルトのままでも可)。Runボタンをクリックするか、ショートカットCtrl(cmd) + Enterを使用してビデオ生成を実行。

1.3 ワークフローの分析

このバージョンのワークフローは、主に前処理された画像条件をエンコードし、その後ビデオを生成します。画像前処理ノードOpenposePreprocessorでは、Openpose、Depth、Cannyなどのさまざまな前処理方法を選択できます。ここでは、Openpose前処理方法を選択して、対応するキャラクターの動きの制御とエンコードを生成します。

2. ビデオ制御参照画像ビデオ生成ワークフロー

このワークフローは主にclip_vision_h.safetensorsモデルをロードし、参照画像の内容を効果的に理解します。ただし、一貫性を完全に保持してビデオを生成するのではなく、参照画像の特徴に基づいてビデオを生成します。

2.1 ワークフローファイルのダウンロード

以下の画像をダウンロードし、ComfyUIにドラッグして対応するワークフローをロードします。

JSON形式でダウンロード。

以下のビデオと画像をダウンロードし、入力条件として使用します。

2.2 ワークフローステップの完了

WanVideo Model LoaderノードがWan2.1-Fun-1.3B-Control.safetensorsモデルをロードしていることを確認。Load WanVideo T5 TextEncoderノードがumt5-xxl-enc-bf16.safetensorsモデルをロードしていることを確認。WanVideo Vae LoaderノードがWan2_1_VAE_bf16.safetensorsモデルをロードしていることを確認。Load Video(Upload)ノードで、先ほど提供した入力ビデオをアップロード。AIO AuxAux PreprocessorノードでOpenposePreprocessorノードを選択。Load CLIP Visionノードで、参照画像から特徴を抽出するためにclip_vision_h.safetensorsモデルがロードされていることを確認。Load Imageノードで、以前に提供した参照画像をアップロード。WanVideo TextEncodeで、生成したいビデオのプロンプトを入力(デフォルトのままでも可)。Runボタンをクリックするか、ショートカットCtrl(cmd) + Enterを使用してビデオ生成を実行。

2.3 ワークフローの分析

- Kijaiが対応するノードを更新したため、

WanVideo ImageToVideo Encodeノードにはfun_modelというオプションがあり、これをtrueに設定する必要があります。 - 他と比較して、参照画像の特徴を使用する方がより適しているため、参照画像の使用は依然として必要です。ただし、画像の特徴のみを抽出するため、キャラクターの一貫性を完全に維持することはできません。

- 画像前処理セクションでは、複数の前処理ノードを組み合わせて、より豊かな制御条件を生成することを試みることができます。