OpenMOSS 发布 MOVA - 开源音视频同步生成模型

2026/01/29

Wan2.2 Animate 代表了 AI 驱动角色动画的突破,为视频内容中的角色替换和动作转移提供了全面的解决方案。

这个高级框架使用户能够使用参考视频无缝地为静态角色图像制作动画,以显著的精度捕捉复杂的面部表情和身体动作。此外,它可以在保持原始环境背景和照明条件的同时替换视频中的现有角色。

关键功能

- 双重操作模式: 在角色动画和视频替换功能之间无缝切换

- 基于骨骼的动作控制: 利用先进的姿势估计技术进行精确动作复制

- 表情保真度: 保留源材料中的微妙面部表情和微动作

- 环境一致性: 保持原始视频的照明和色彩调节,实现自然的集成

- 扩展视频支持: 迭代处理确保在较长序列中平滑的动作连续性

关于 Wan2.2 Animate 工作流

在本教程中,我们将包含两种工作流:

- ComfyUI 官方原生版本(核心节点)

- Kijai ComfyUI-WanVideoWrapper 版本[待更新]

Comfy Org 直播回放

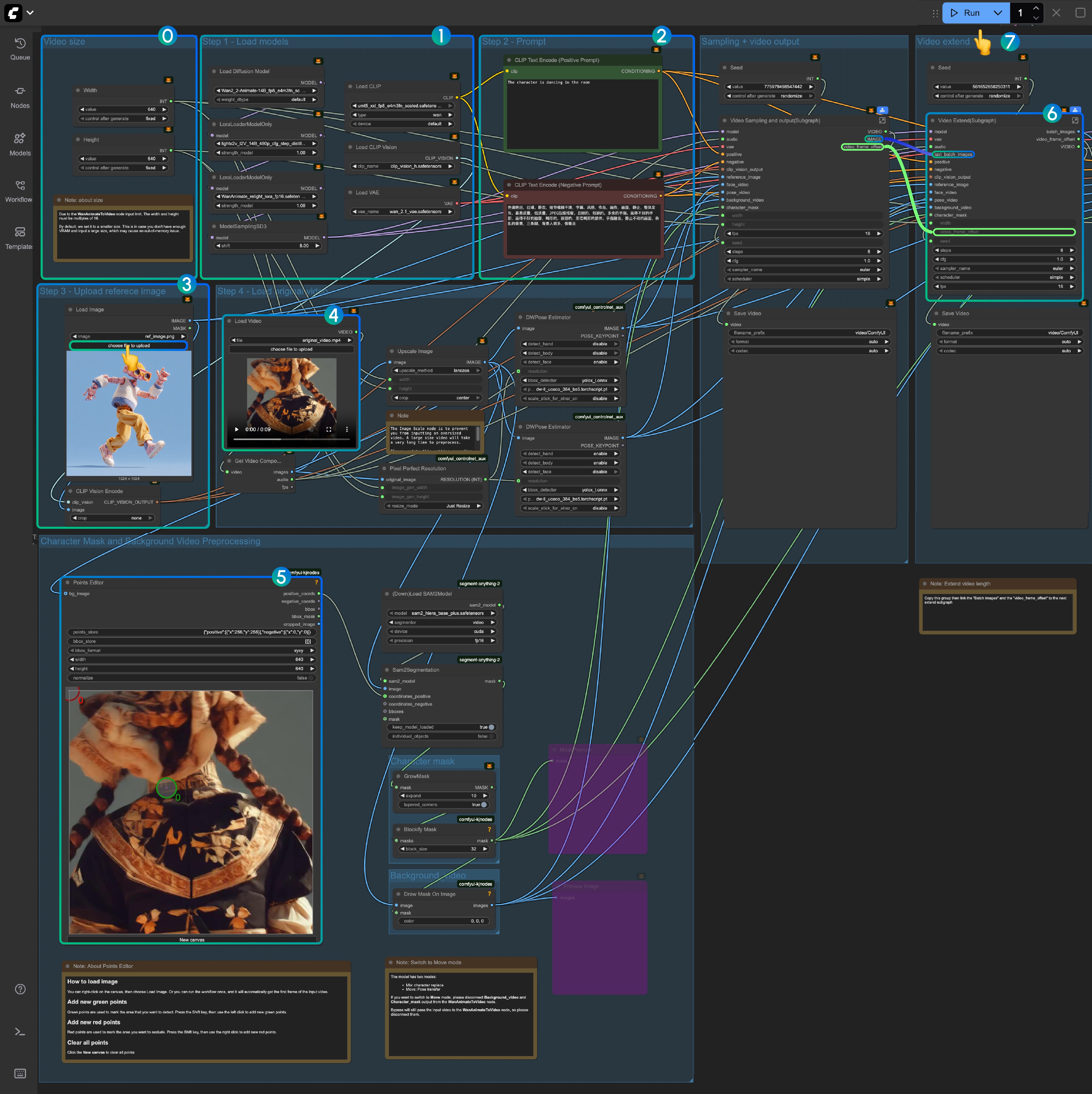

Wan2.2 Animate ComfyUI 原生工作流(核心节点)

1. 工作流设置

首先下载工作流文件并将其导入 ComfyUI。

所需输入素材:

参考图像:

输入视频

2. 模型下载

扩散模型

- Wan2_2-Animate-14B_fp8_e4m3fn_scaled_KJ.safetensors - Kijai 仓库的优化版本

- wan2.2_animate_14B_bf16.safetensors - 原始模型权重

CLIP 视觉模型

LoRA 模型

VAE 模型

文本编码器

ComfyUI/

├───📂 models/

│ ├───📂 diffusion_models/

│ │ ├─── Wan2_2-Animate-14B_fp8_e4m3fn_scaled_KJ.safetensors

│ │ └─── wan2.2_animate_14B_bf16.safetensors

│ ├───📂 loras/

│ │ └─── lightx2v_I2V_14B_480p_cfg_step_distill_rank64_bf16.safetensors

│ ├───📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors

│ ├───📂 clip_visions/

│ │ └─── clip_vision_h.safetensors

│ └───📂 vae/

│ └── wan_2.1_vae.safetensors3. 自定义节点安装

要获得完整的工作流体验,请使用 ComfyUI-Manager 或手动安装以下自定义节点:

必需扩展:

有关安装指南,请参阅 如何安装自定义节点

4. 工作流配置

Wan2.2 Animate 在两种不同模式下运行:

- 混合模式: 在现有视频内容中进行角色替换

- 移动模式: 动作转移以动画化静态角色图像

4.1 混合模式操作

设置指南:

-

初始测试: 首次执行时使用较小的视频尺寸以验证 VRAM 兼容性。由于

WanAnimateToVideo的限制,确保视频尺寸是 16 的倍数。 -

模型验证: 确认所有必需模型都已正确加载

-

提示词自定义: 根据特定用例需要修改文本提示词

-

参考图像: 上传目标角色图像

-

输入视频处理: 最初使用提供的示例视频。来自 comfyui_controlnet_aux 的 DWPose 估计器 自动将输入视频处理为姿势和面部控制序列

-

点编辑器配置: 来自 KJNodes 的

Points Editor需要初始帧加载。运行一次工作流或手动上传第一帧 -

视频扩展: “Video Extend” 组扩展输出长度

- 每次扩展添加 77 帧(约 4.8 秒)

- 5 秒以下视频跳过

- 对于更长的扩展,复制组并依次连接

batch_images和video_frame_offset输出

-

执行: 点击

Run或使用Ctrl(Cmd) + Enter开始生成

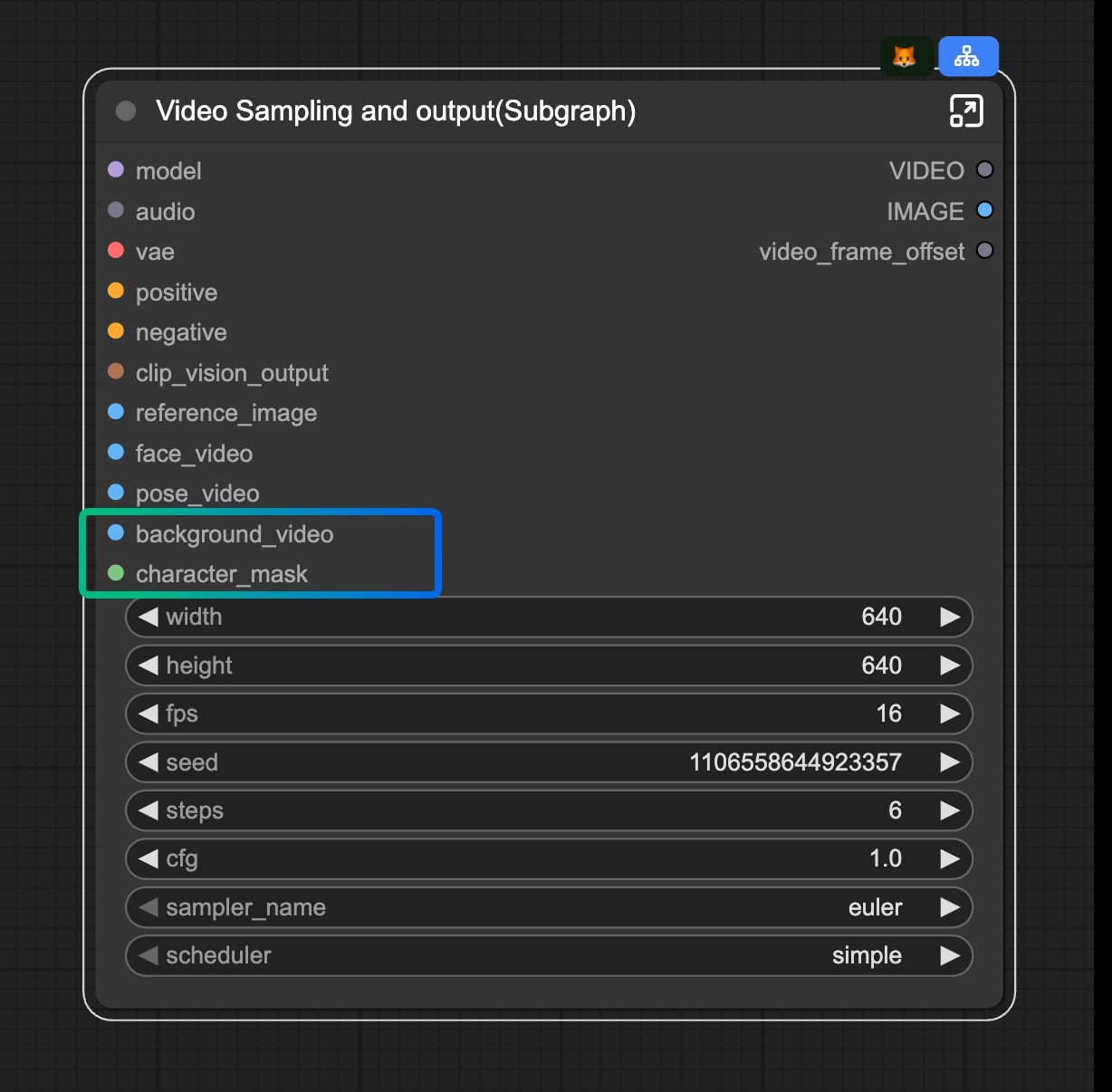

4.2 移动模式配置

工作流使用 子图 功能进行模式切换:

模式切换: 要激活移动模式,从 Video Sampling and output(Subgraph) 节点断开 background_video 和 character_mask 输入。

Wan2.2 Animate ComfyUI-WanVideoWrapper 工作流

[待更新]