OpenMOSS 发布 MOVA - 开源音视频同步生成模型

2026/01/29

Flux ControlNet

本文将会将整理目前适用于 Flux 生态的 ControlNet 模型

XLabs-AI/flux-controlnet-collections

XLabs-AI/flux-controlnet-collections 是一个为 FLUX.1-dev 模型提供的 ControlNet 检查点集合。这个仓库由 Black Forest Labs 开发,旨在为 Flux 生态系统提供更多的控制选项。

主要特点:

-

支持三种 ControlNet 模型:

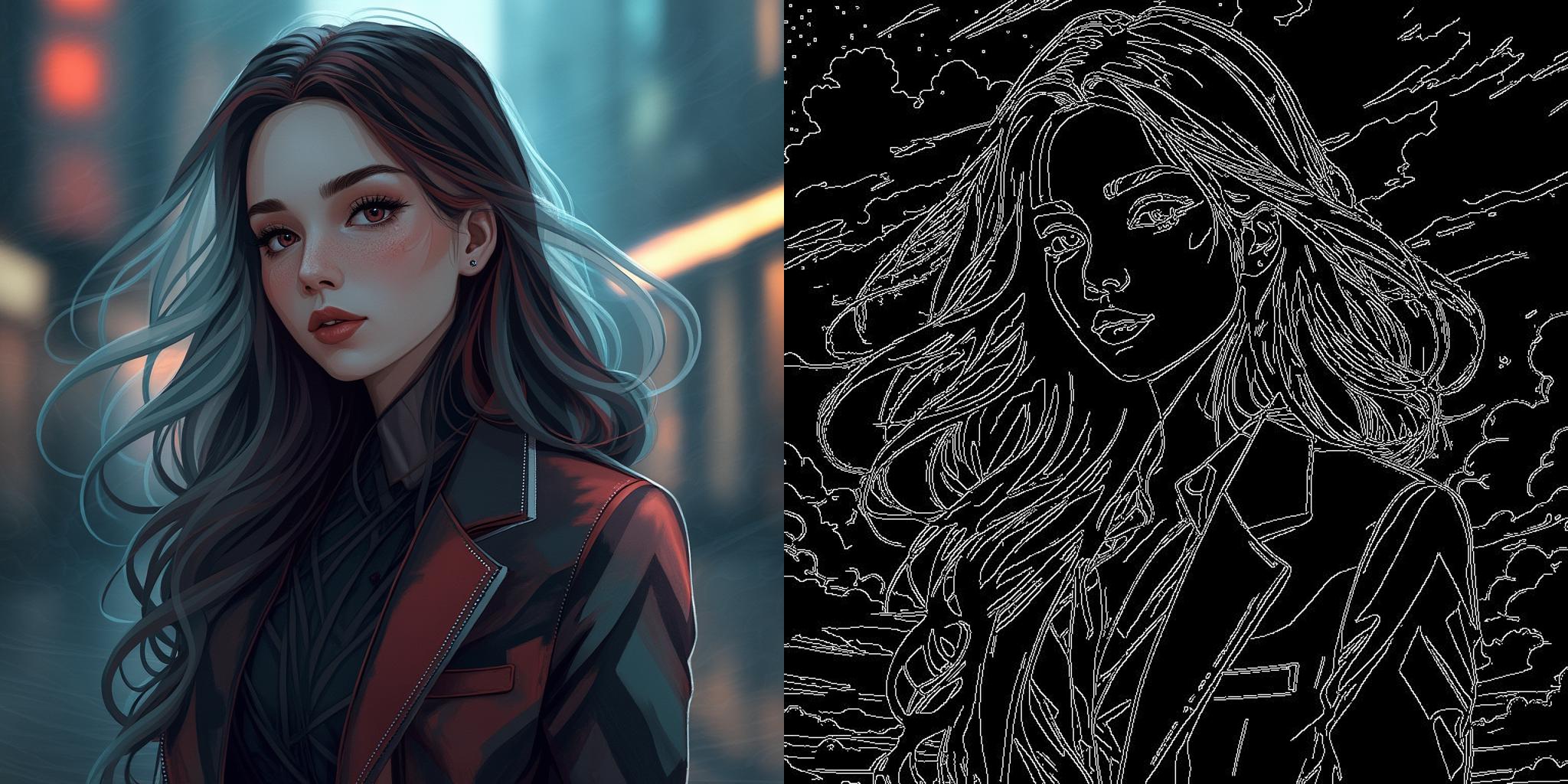

- Canny(边缘检测)

- HED(边缘检测)

- Depth(深度图,基于 Midas)

-

所有模型都在 1024x1024 分辨率上训练,适用于生成 1024x1024 分辨率的图像。

-

提供 v3 版本,这是经过改进的更真实的版本,可以直接在 ComfyUI 中使用。

-

提供了 ComfyUI 的自定义节点和工作流程,方便用户快速上手。

-

提供了示例图片和生成结果,展示了模型的效果。

使用方法:

- 通过官方仓库的 main.py 脚本使用。

- 在 ComfyUI 中使用提供的自定义节点和工作流程,官方提供的 workflow https://huggingface.co/XLabs-AI/flux-controlnet-collections/tree/main/workflows

- 使用 Gradio 演示界面。

在 comfyui 中使用官方的工作流 需要安装以下两个插件

许可证:

这些模型权重遵循 FLUX.1 [dev] 非商业许可证。

链接:

- 模型仓库:https://huggingface.co/XLabs-AI/flux-controlnet-collections

- GitHub 仓库:包含 ComfyUI 工作流程、训练脚本和推理演示脚本。

以下是 XLabs-AI/flux-controlnet-collections 仓库中提供的 ControlNet 模型列表:

| 模型名称 | 文件大小 | 上传日期 | 描述 | 模型链接 | 下载链接 |

|---|---|---|---|---|---|

| flux-canny-controlnet.safetensors | 1.49 GB | 2023 年 8 月 30 日 | Canny 边缘检测 ControlNet 模型(初始版本) | 查看 | 下载 |

| flux-canny-controlnet_v2.safetensors | 1.49 GB | 2023 年 8 月 30 日 | Canny 边缘检测 ControlNet 模型(v2 版本) | 查看 | 下载 |

| flux-canny-controlnet-v3.safetensors | 1.49 GB | 2023 年 8 月 30 日 | Canny 边缘检测 ControlNet 模型(v3 版本) | 查看 | 下载 |

| flux-depth-controlnet.safetensors | 1.49 GB | 2023 年 8 月 30 日 | 深度图 ControlNet 模型(初始版本) | 查看 | 下载 |

| flux-depth-controlnet_v2.safetensors | 1.49 GB | 2023 年 8 月 30 日 | 深度图 ControlNet 模型(v2 版本) | 查看 | 下载 |

| flux-depth-controlnet-v3.safetensors | 1.49 GB | 2023 年 8 月 30 日 | 深度图 ControlNet 模型(v3 版本) | 查看 | 下载 |

| flux-hed-controlnet.safetensors | 1.49 GB | 2023 年 8 月 30 日 | HED 边缘检测 ControlNet 模型(初始版本) | 查看 | 下载 |

| flux-hed-controlnet-v3.safetensors | 1.49 GB | 2023 年 8 月 30 日 | HED 边缘检测 ControlNet 模型(v3 版本) | 查看 | 下载 |

这个项目为 Flux 生态系统提供了强大的 ControlNet 模型,使用户能够更精确地控制图像生成过程,特别适合需要基于边缘检测或深度信息进行图像生成的应用场景。

InstantX Flux Union ControlNet

InstantX Flux Union ControlNet 是一个多功能的 ControlNet 模型,专为 FLUX.1 开发版设计。这个模型整合了多种控制模式,使用户能够更灵活地控制图像生成过程。

主要特点:

-

多种控制模式:支持多种控制模式,包括 Canny 边缘检测、Tile(图块)、深度图、模糊、姿势控制等。

-

高性能:大多数控制模式都达到了较高的有效性,特别是 Canny、Tile、深度图、模糊和姿势控制等模式。

-

持续优化:开发团队正在不断改进模型,以提高其性能和稳定性。

-

兼容性:与 FLUX.1 开发版基础模型完全兼容,可以轻松集成到现有的 FLUX 工作流程中。

-

多控制推理:支持同时使用多个控制模式,为用户提供更精细的图像生成控制。

使用方法:

-

单一控制模式:

- 加载 Union ControlNet 模型

- 选择所需的控制模式(如 Canny、深度图等)

- 设置控制图像和相关参数

- 生成图像

-

多控制模式:

- 加载 Union ControlNet 模型作为 FluxMultiControlNetModel

- 为每个控制模式设置不同的控制图像和参数

- 同时应用多个控制模式来生成图像

注意事项:

- 当前版本是 beta 版本,可能还未完全训练完成,在使用过程中可能会遇到一些不完美的情况。

- 某些控制模式(如灰度控制)的有效性可能较低,建议优先使用高有效性的模式。

- 与专门的单一功能 ControlNet 模型相比,Union 模型在某些特定任务上的表现可能略有不及,但它提供了更大的灵活性和多功能性。

资源链接:

| 文件名 | 大小 | 查看链接 | 下载链接 |

|---|---|---|---|

| diffusion_pytorch_model.safetensors | 6.6 GB | 查看 | 下载 |

注意:下载模型后,建议将文件重命名为更具描述性的名称,如 “flux_union_controlnet.safetensors”,以便于今后的文件管理和识别。

这个 Union ControlNet 模型为 FLUX 生态系统提供了强大而灵活的图像控制工具,特别适合需要在单个模型中实现多种控制功能的用户。随着持续的优化和更新,它有望成为 FLUX 平台上最全面和强大的 ControlNet 模型之一。

InstantX Flux Canny ControlNet

除了 Union ControlNet 模型,InstantX 还提供了专门用于 Canny 边缘检测的 ControlNet 模型。这个模型专注于使用 Canny 边缘检测算法来控制图像生成过程,为用户提供了更精确的边缘控制能力。

主要特点:

-

专注于 Canny 边缘检测:这个模型专门针对 Canny 边缘检测进行了优化,可以更好地处理和利用边缘信息。

-

高分辨率训练:模型在总像素数为 10241024 的多尺度环境下进行训练,使用 88 的批量大小训练了 30k 步。

-

与 FLUX.1 兼容:专为 FLUX.1 开发版设计,可以无缝集成到 FLUX 工作流程中。

-

使用 bfloat16 精度:模型使用 bfloat16 精度,可以在保持精度的同时提高计算效率。

使用方法:

- 安装最新版本的 Diffusers 库。

- 加载 Flux Canny ControlNet 模型和 FLUX.1 基础模型。

- 准备输入图像并应用 Canny 边缘检测。

- 使用检测到的边缘作为控制输入生成图像。

Jasperai Flux.1-dev ControlNets 系列

Jasperai 为 Flux.1-dev 开发了一系列 ControlNet 模型,这些模型旨在为 AI 图像生成提供更精确的控制。这个系列包括表面法线、深度图和超分辨率模型,为用户提供了多样化的创作工具。

您可以在 Hugging Face 上的 Jasperai 集合页面 查看这些模型的详细信息。

1. 表面法线 ControlNet 模型

表面法线 ControlNet 模型 使用表面法线图来指导图像生成。这个模型专门针对表面法线信息进行了优化,可以更好地处理和利用物体表面的几何信息。

主要特点:

- 专注于表面法线处理

- 提供物体表面的精确几何信息

- 增强图像的深度感和真实感

- 与 FLUX.1 开发版兼容

2. 深度图 ControlNet 模型

深度图 ControlNet 模型 利用深度信息来控制图像生成。这个模型专门针对深度图信息进行了优化,可以更好地理解和利用场景的空间结构信息。

主要特点:

- 专注于深度图处理

- 提供场景的空间结构信息

- 改善图像的透视感和空间感

- 与 FLUX.1 开发版兼容

3. 超分辨率 ControlNet 模型

超分辨率 ControlNet 模型 专注于提高低分辨率图像的质量。这个模型可以将低质量图像转换为高分辨率版本,重建和增强图像细节。

主要特点:

- 专注于图像超分辨率处理

- 将低分辨率图像转换为高分辨率版本

- 重建和增强图像细节

- 与 FLUX.1 开发版兼容

这些模型为 AI 图像生成提供了更精确的控制,使创作者能够生成更加真实和细致的图像。每个模型都针对特定的图像处理需求而设计,为用户提供了多样化的创作工具。用户可以根据自己的需求选择合适的模型来实现不同的图像生成效果。