OpenMOSS, MOVA 출시 - 오픈소스 동영상·오디오 동기화 생성 모델

2026. 01. 29.

Wan2.2 Animate는 AI 기반 캐릭터 애니메이션 분야에서 혁신을 이룬 것으로, 비디오 콘텐츠 내에서 캐릭터 교체 및 모션 전송을 모두 지원하는 포괄적인 솔루션을 제공합니다.

이 고급 프레임워크는 사용자가 참조 영상을 사용하여 정적인 캐릭터 이미지를 매끄럽게 애니메이션화할 수 있게 하며, 놀랄 만큼 정확한 표현으로 미세한 얼굴 표정과 몸의 움직임을 캡처할 수 있습니다. 또한 기존 영상의 환경적 맥락과 조명 조건을 유지하면서 기존 캐릭터를 교체할 수도 있습니다.

핵심 기능

- 이중 운영 모드: 캐릭터 애니메이션 및 영상 대체 기능 간 원활한 전환

- 스켈레톤 기반 모션 제어: 정확한 움직임 복제를 위한 고급 포즈 추정 기술 활용

- 표현 정확도: 원본 소스의 미묘한 얼굴 표정 및 미세 움직임 보존

- 환경 일관성: 자연스러운 통합을 위한 원래 영상의 조명 및 컬러 그레이딩 유지

- 장기 영상 지원: 반복 처리를 통해 긴 시퀀스에서도 매끄러운 동작 지속성 보장

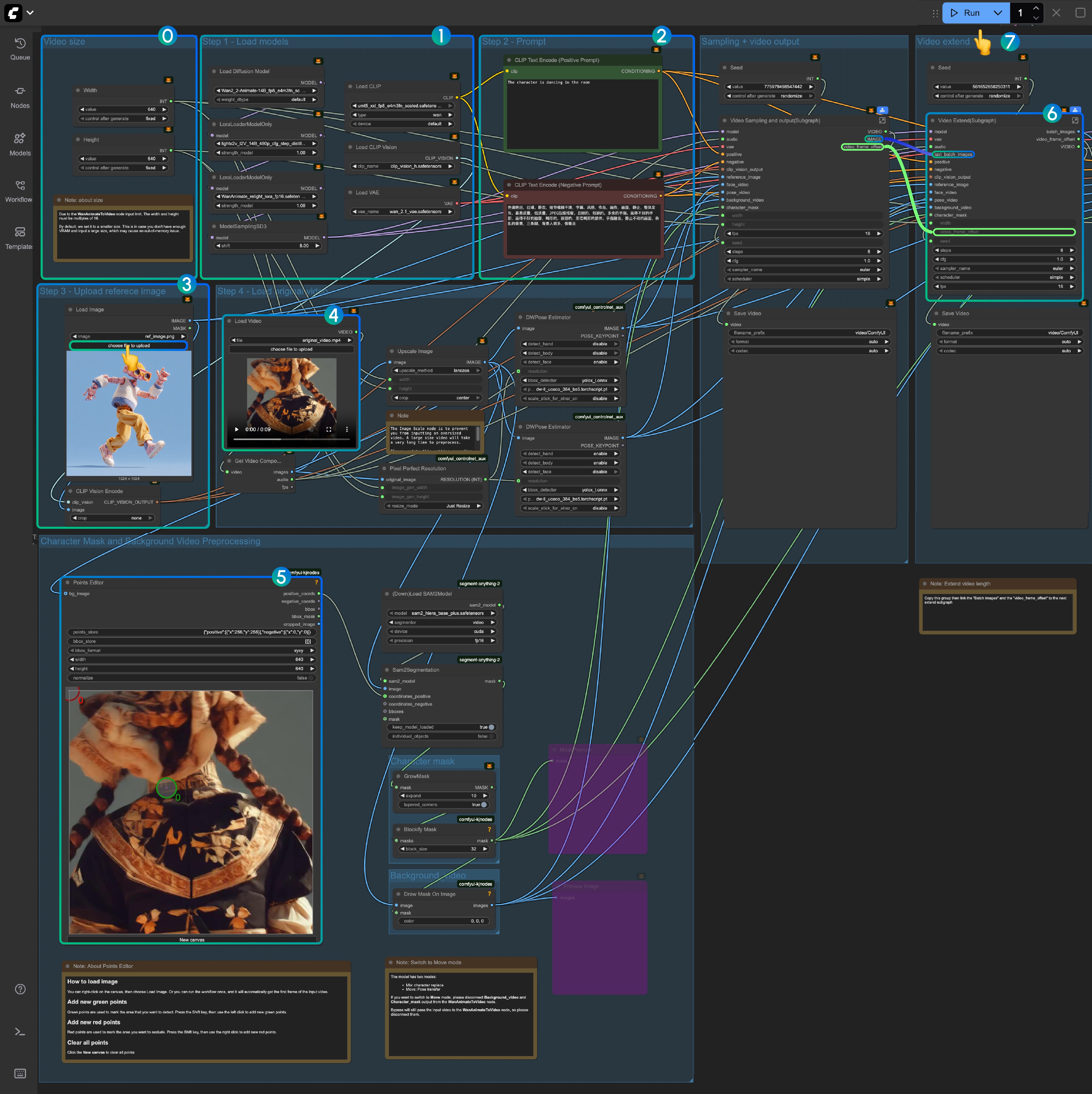

Wan2.2 Animate 워크플로우 소개

이 튜토리얼에서는 두 가지 워크플로우를 포함합니다:

- ComfyUI 공식 네이티브 버전 (핵심 노드)

- Kijai ComfyUI-WanVideoWrapper 버전 [업데이트 예정]

Comfy Org 라이브 방송 다시보기

Wan2.2 Animate ComfyUI 네이티브 워크플로우 (핵심 노드)

1. 워크플로우 설정

워크플로우 파일을 다운로드하여 ComfyUI에 가져오는 것으로 시작합니다.

필수 입력 자료:

참조 이미지:

입력 영상

2. 모델 다운로드

디퓨전 모델

- Wan2_2-Animate-14B_fp8_e4m3fn_scaled_KJ.safetensors - Kijai의 저장소에서 제공하는 최적화 버전

- wan2.2_animate_14B_bf16.safetensors - 원본 모델 가중치

CLIP 비전 모델

LoRA 모델

VAE 모델

텍스트 인코더

ComfyUI/

├───📂 models/

│ ├───📂 diffusion_models/

│ │ ├─── Wan2_2-Animate-14B_fp8_e4m3fn_scaled_KJ.safetensors

│ │ └─── wan2.2_animate_14B_bf16.safetensors

│ ├───📂 loras/

│ │ └─── lightx2v_I2V_14B_480p_cfg_step_distill_rank64_bf16.safetensors

│ ├───📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors

│ ├───📂 clip_visions/

│ │ └─── clip_vision_h.safetensors

│ └───📂 vae/

│ └── wan_2.1_vae.safetensors3. 사용자 정의 노드 설치

전체 워크플로우 경험을 위해 ComfyUI-Manager 또는 수동으로 다음 사용자 정의 노드를 설치합니다:

필수 확장 기능:

설치 지침은 사용자 정의 노드 설치 방법을 참조하세요.

4. 워크플로우 설정

Wan2.2 Animate는 두 가지 분명한 모드로 작동합니다:

- 믹스 모드: 기존 영상 콘텐츠 내 캐릭터 교체

- 무브 모드: 정적인 캐릭터 이미지에 모션 전송하여 애니메이션화

4.1 믹스 모드 작동

설정 지침:

-

초기 테스트: VRAM 호환성 확인을 위해 최초 실행 시 작은 영상 크기를 사용합니다.

WanAnimateToVideo제한으로 인해 영상 크기는 16의 배수여야 합니다. -

모델 확인: 모든 필수 모델이 올바르게 로드되었는지 확인합니다

-

프롬프트 사용자 정의: 특정 사용 사례에 맞게 텍스트 프롬프트를 수정합니다

-

참조 이미지: 대상 캐릭터 이미지를 업로드합니다

-

입력 영상 처리: 처음에는 제공된 샘플 영상을 사용합니다. comfyui_controlnet_aux의 DWPose Estimator는 자동으로 입력 영상을 포즈 및 얼굴 제어 시퀀스로 처리합니다

-

포인트 편집기 설정: KJNodes의

Points Editor는 초기 프레임 로드가 필요합니다. 워크플로우를 한 번 실행하거나 수동으로 첫 프레임을 업로드합니다 -

영상 확장: “Video Extend” 그룹은 출력 길이를 확장합니다

- 각 확장은 77프레임(약 4.8초)을 추가합니다

- 5초 미만 영상은 생략합니다

- 더 긴 확장을 위해서는 그룹을 복제하고

batch_images및video_frame_offset출력을 순차적으로 연결합니다

-

실행:

Run을 클릭하거나Ctrl(Cmd) + Enter를 사용하여 생성을 시작합니다

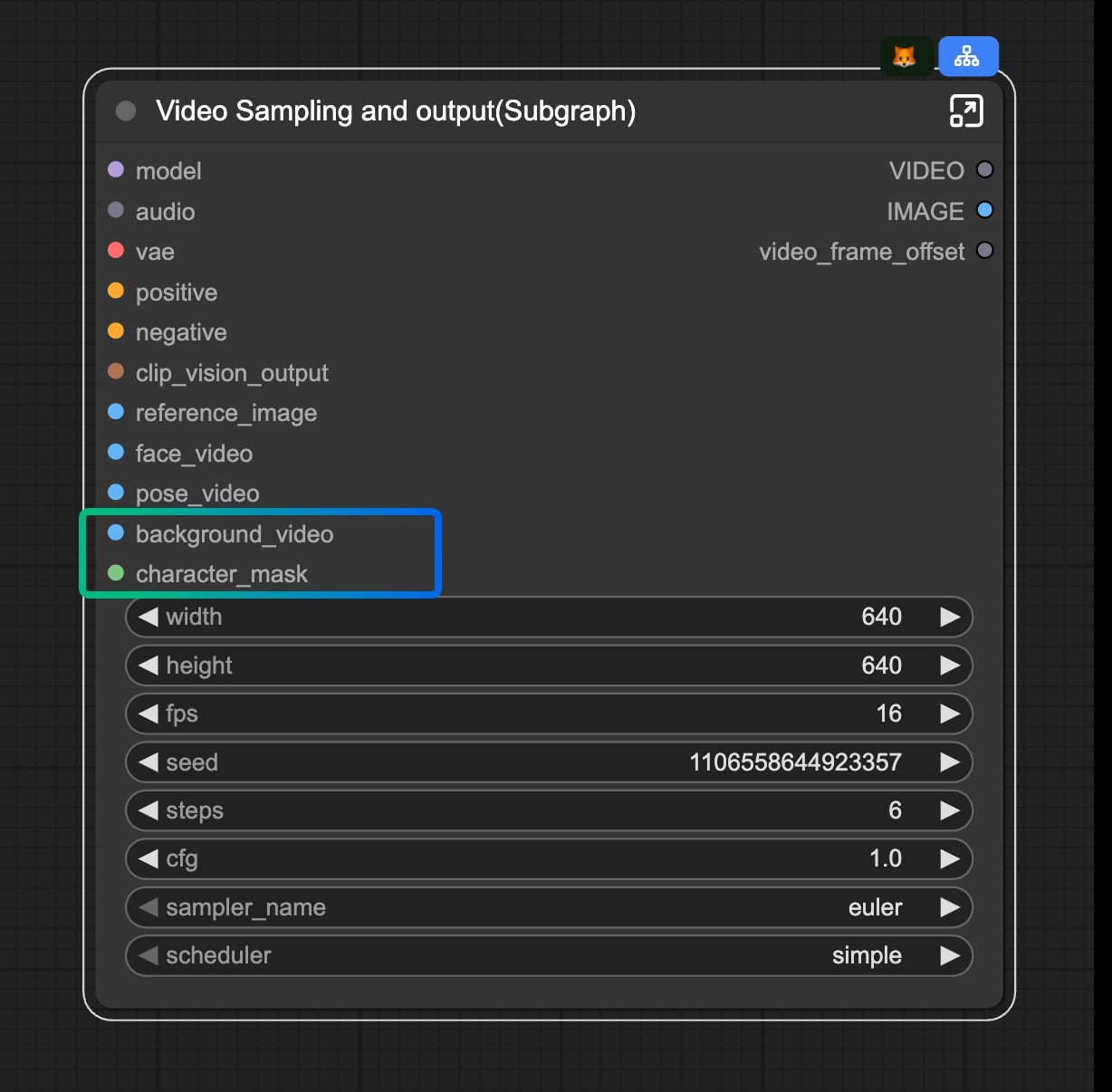

4.2 무브 모드 설정

워크플로우는 모드 전환을 위해 서브그래프 기능을 사용합니다:

모드 전환: 무브 모드를 활성화하려면 Video Sampling and output(Subgraph) 노드에서 background_video 및 character_mask 입력을 분리합니다.

Wan2.2 Animate ComfyUI-WanVideoWrapper 워크플로우

[업데이트 예정]