OpenMOSS, MOVA 출시 - 오픈소스 동영상·오디오 동기화 생성 모델

2026. 01. 29.

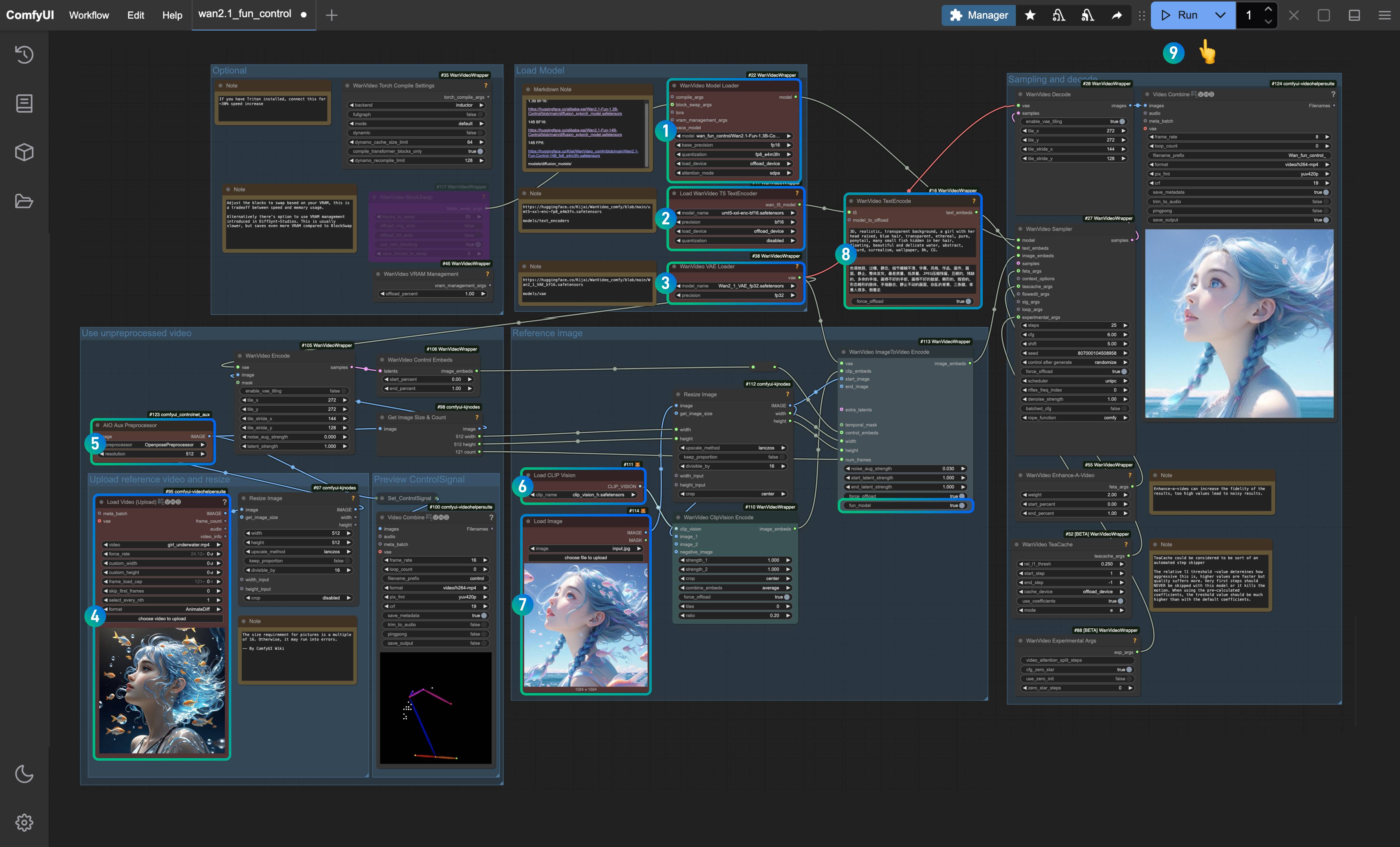

Wan2.1 Fun Control ComfyUI 워크플로우 - 완전 가이드

Wan2.1-Fun-Control은 Alibaba 팀에서 출시한 최신 비디오 제어 기능으로, 깊이, openpose, canny와 같은 비디오 제어 기능을 구현할 수 있습니다. 현재 이 모델은 1.3B와 14B 모델로 나뉩니다.

이 가이드는 두 가지 워크플로우를 다룹니다.

- ComfyUI 기본 워크플로우

-

- 완전 기본(서드파티 사용자 정의 노드에 의존하지 않음)

-

- 기본 워크플로우의 개선 버전(사용자 정의 노드를 사용함)

- Kijai의 ComfyUI-WanVideoWrapper 워크플로우 사용

- 두 워크플로우는 모델이 기본적으로 동일하지만, 원래 워크플로우의 상황과 모델 사용에 더 적합하도록 서로 다른 출처의 모델을 사용했습니다.

- 비디오 관련 작업을 위해 ComfyUI-VideoHelperSuite 사용자 정의 노드 패키지를 사용하여 비디오 로드, mp4 비디오 저장 및 병합 등 다양한 비디오 작업을 수행할 수 있습니다.

- 플러그인 설치는 사용자 정의 노드 설치 방법 가이드를 참조하십시오.

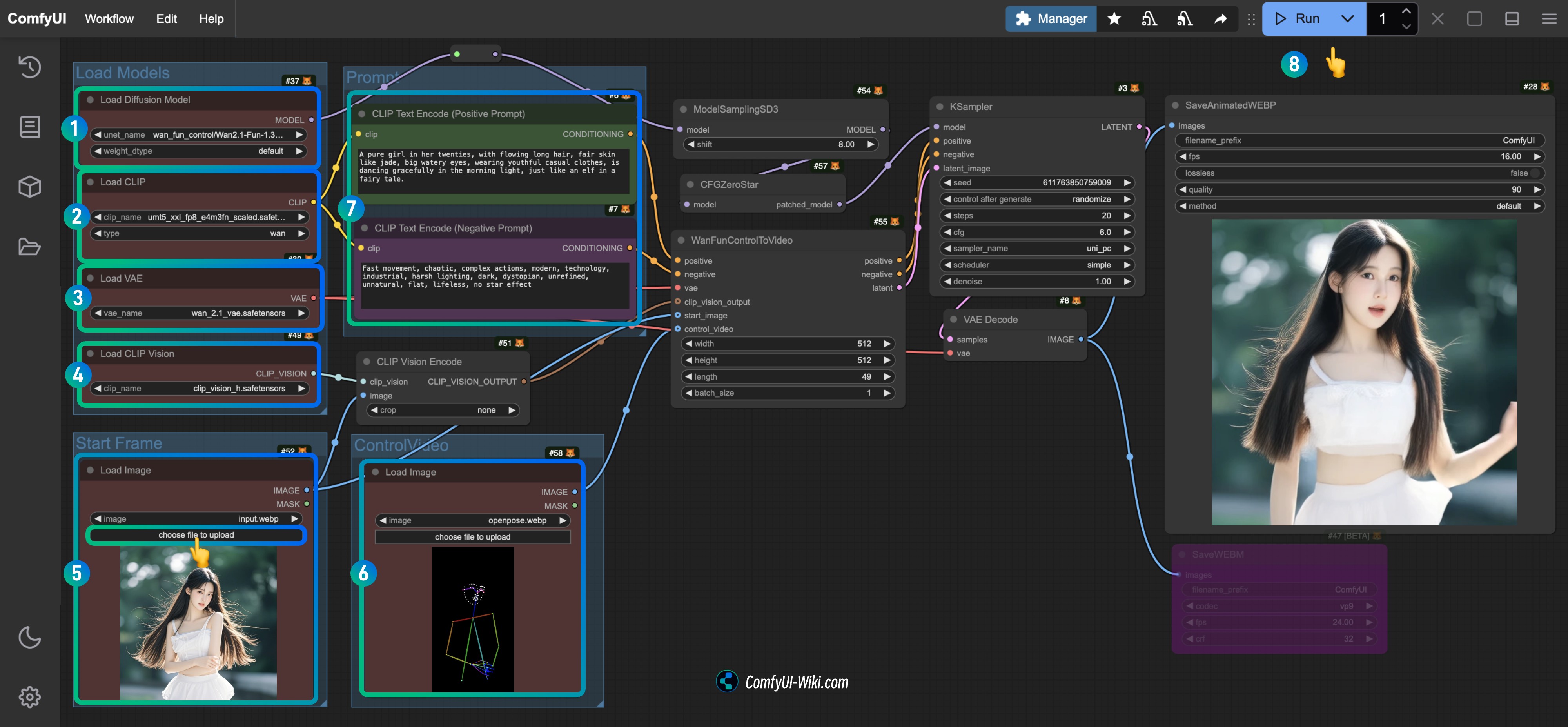

ComfyUI 기본 Wan2.1 Fun Control 워크플로우

현재 ComfyUI는 Wan Fun Control 모델을 기본적으로 지원하지만, 현재(2025-04-10)까지 공식적으로 해당 워크플로우 예제를 발표하지 않았습니다.

시작하기 전에 ComfyUI 버전이 최소한 이 커밋 이후인지 확인해야 하며, 그래야 WanFunControlToVideo 노드를 찾을 수 있습니다. ComfyUI 업데이트 방법을 참조하여 ComfyUI 버전을 업데이트하십시오.

1.1 Wan2.1 Fun Control 워크플로우 파일 다운로드

1.1.1 워크플로우 파일

아래 이미지를 다운로드하고 ComfyUI에 드래그하면 해당 워크플로우가 로드되고 모델 다운로드가 안내됩니다.

Json 형식 다운로드

1.1.2 시작 프레임 및 제어 비디오

아래 이미지와 비디오를 다운로드하여 입력 조건으로 사용합니다.

- 여기서는 서드파티 사용자 정의 노드에 의존하지 않고 완전히 기본 노드만 사용하기 위해 전처리된 제어 비디오를 제공합니다.

- ComfyUI-comfyui_controlnet_aux와 같은 사용자 정의 노드를 사용하여 비디오 전처리를 수행할 수 있습니다.

1.2 수동 모델 설치

해당 모델이 성공적으로 다운로드되지 않은 경우, 아래에서 모델 다운로드 주소를 확인하십시오.

Diffusion models 1.3B 또는 14B 중 하나를 선택하십시오. 14B는 파일 크기가 더 크고 성능이 더 좋지만, 장치 성능 요구 사항도 더 높습니다.

- Wan2.1-Fun-1.3B-Control: 다운로드 후

Wan2.1-Fun-1.3B-Control.safetensors로 이름을 변경하십시오. - Wan2.1-Fun-14B-Control: 다운로드 후

Wan2.1-Fun-14B-Control.safetensors로 이름을 변경하십시오.

Text encoders 아래 두 모델 중 하나를 선택하십시오. fp16은 크기가 크고 성능 요구 사항이 높습니다.

VAE

CLIP Vision 이미지 특징 추출에 사용됩니다.

파일 저장 위치

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └── Wan2.1-Fun-1.3B-Control.safetensors # 또는 선택한 버전

│ ├── 📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # 또는 선택한 버전

│ └── 📂 vae/

│ │ └── wan_2.1_vae.safetensors

│ └── 📂 clip_vision/

│ └── clip_vision_h.safetensors 1.3 단계별로 워크플로우 실행하기

Load Diffusion Model노드가Wan2.1-Fun-1.3B-Control.safetensors모델을 로드했는지 확인합니다.Load CLIP노드가umt5_xxl_fp8_e4m3fn_scaled.safetensors모델을 로드했는지 확인합니다.Load VAE노드가wan_2.1_vae.safetensors모델을 로드했는지 확인합니다.Load CLIP Vision노드가clip_vision_h.safetensors모델을 로드했는지 확인합니다.Load Image노드에 앞서 제공된 입력 이미지를 시작 프레임으로 로드합니다.Load Image노드에 앞서 제공된 비디오를 업로드하여 제어 조건으로 사용합니다.- (선택 사항)

CLIP Text Encoder노드에서 비디오 프롬프트를 수정합니다. Run버튼을 클릭하거나 단축키Ctrl(cmd) + Enter(리턴)을 사용하여 비디오 생성을 실행합니다.

1.4 워크플로우 분석

원주율 워크플로우는 주로 비디오 프레임을 가져오는 데 중점을 두며, 해당 WanFunControlToVideo 노드에서 제공하는 기본 Length는 81(초당 15프레임으로 5초 비디오 생성)입니다. 그러나 제가 제공한 제어 비디오는 49프레임만 포함되어 있어 조정이 필요했습니다. 또한 비디오 생성 후 인물이 갑자기 확대된 것을 볼 수 있는데, 이는 시작 프레임 이미지와 제어 비디오의 크기가 일치하지 않아 처리 과정에서 잘리거나 확대되었기 때문입니다.

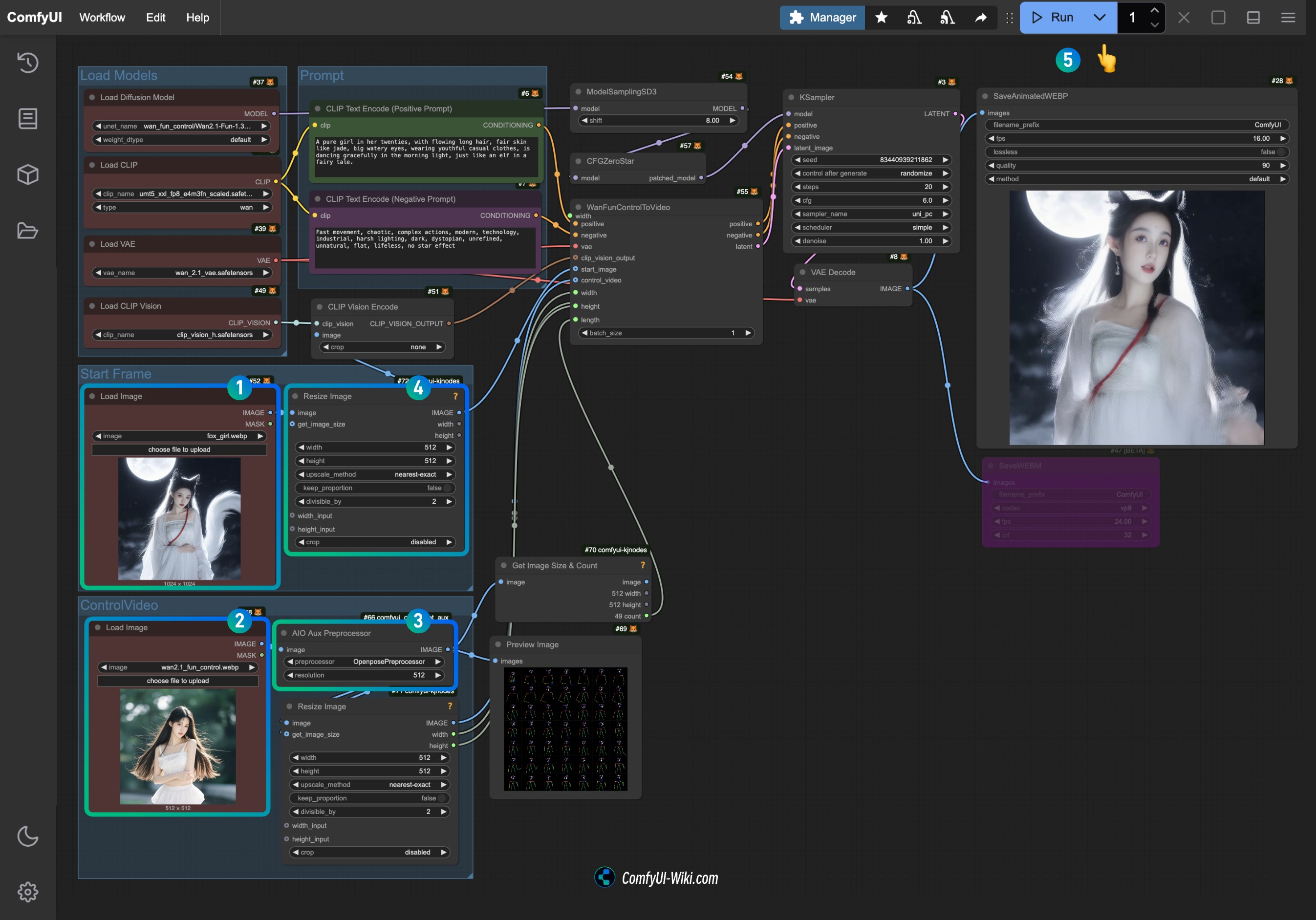

2. Wan2.1 Fun Control 원주율 워크플로우 조정 버전

완전 원주율 워크플로우는 비디오 크기와 프레임 수 계산이 불편하기 때문에, 이 개선된 버전의 워크플로우에서는 아래의 사용자 정의 노드 패키지에서 일부 노드를 사용했습니다:

- ComfyUI-KJNodes 비디오 크기 조정 및 이미지 프레임 수 가져오기

- ComfyUI-comfyui_controlnet_aux: 비디오 이미지 전처리 수행

시작하기 전에 이 두 개의 사용자 정의 노드 패키지가 설치되어 있는지 확인하거나, ComfyUI-Manager를 사용하여 워크플로우 로드 후 설치합니다.

2.1 워크플로우 파일 다운로드

2.1.1 워크플로우 파일 다운로드

아래 이미지를 다운로드하고 ComfyUI에 드래그하면 해당 워크플로우가 로드되고 모델 다운로드가 안내됩니다.

2.1.2 입력 비디오 다운로드

아래 이미지와 비디오를 다운로드하여 입력 조건으로 사용합니다.

시간이 부족하여 갑자기 확대되는 효과가 있는 이 비디오를 입력으로 사용했습니다.

2.2 단계별로 워크플로우 실행하기

- Start Frame의

Load Image노드에 제공된 입력 이미지를 업로드합니다. - Control Video의

Load Image노드에 앞서 제공된 비디오를 업로드하여 제어 조건으로 사용합니다. AIO Aux Preprocessor에서 사용하고자 하는 전처리기를 선택합니다(첫 실행 시 Hugging Face에서 해당 모델을 다운로드합니다).- 크기를 조정해야 하는 경우

Resize Image노드의 크기 설정을 수정하고 두 노드가 일치하도록 합니다. Run버튼을 클릭하거나 단축키Ctrl(cmd) + Enter(리턴)을 사용하여 비디오 생성을 실행합니다.

현재 Load Image 노드는 mp4 비디오를 지원하지 않으므로 입력 비디오가 필요하다면 ComfyUI-VideoHelperSuite의 Load Video (Upload) 노드를 사용하여 다양한 형식의 비디오 입력을 수행할 수 있습니다.

3. 相关扩展

你可以在这些工作流基础上,再加上对应的图像生成的节点,从而能够不依赖输入参考图像而生成最后的视频

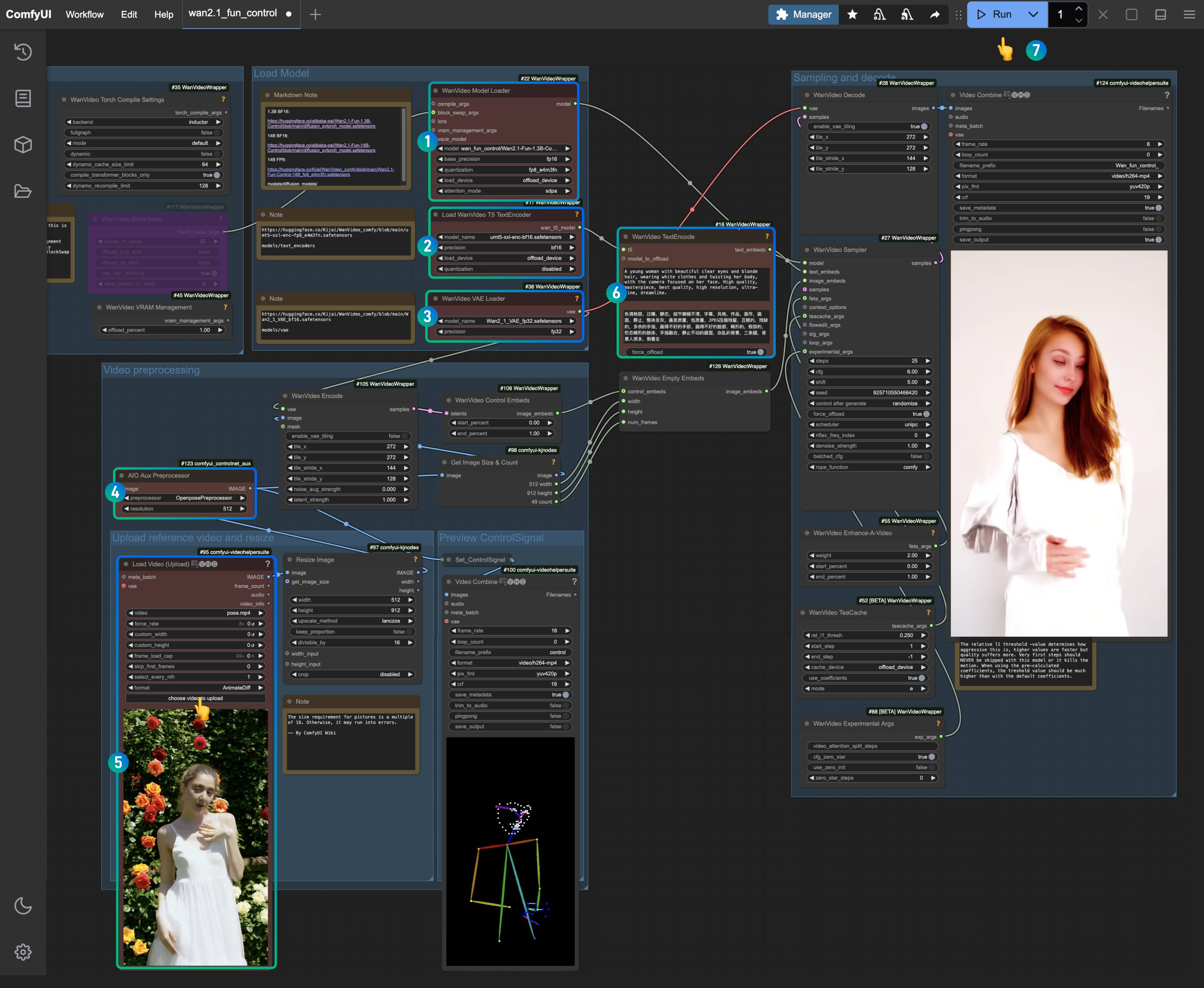

Kijai Wan Fun Control 워크플로우

Kijai의 ComfyUI-WanVideoWrapper 플러그인을 사용하여 Fun-Control 예제를 완성할 것입니다. Kijai가 제공한 원래 워크플로우는 여기에서 찾을 수 있습니다.

이 가이드에 포함된 워크플로우는 ComfyUI Wiki에 의해 재구성되었습니다.

이 워크플로우 섹션은 두 가지 범주로 나뉩니다:

- 비디오 제어 조건만을 사용한 텍스트-비디오 이미지 제어 워크플로우

- Clip_vision을 사용하여 참조 이미지에서 특징을 분석 및 추출하고 비디오 제어 조건을 추가하는 이미지 참조 비디오 생성 제어 워크플로우

관련 설치

커스텀 노드 설치

워크플로우가 원활하게 작동하도록 하기 위해 다음 플러그인을 설치해야 합니다:

- ComfyUI-WanVideoWrapper: 최신 버전으로 업데이트해야 합니다

- ComfyUI-VideoHelperSuite

- ComfyUI-KJNodes

- ComfyUI-comfyui_controlnet_aux: 비디오 이미지 전처리를 위해 사용하거나, 일반적으로 사용하는 이미지 전처리 노드로 대체할 수 있습니다

위에 언급된 커스텀 노드를 업데이트하거나 설치하려면 ComfyUI Manager를 사용하거나 커스텀 노드 설치 방법을 참조하여 해당 설치를 완료할 수 있습니다.

ComfyUI-comfyui_controlnet_aux는 첫 실행 시 해당 모델을 다운로드하므로, huggingface에 정상적으로 접근할 수 있는지 확인하세요.

모델 설치

Wan2.1 Fun Control 1.3B와 14B 두 가지 모델을 제공하며, 기기 성능에 따라 적절한 모델을 선택할 수 있습니다.

- Wan2.1-Fun-1.3B-Control: 다운로드 후

Wan2.1-Fun-1.3B-Control.safetensors로 이름 변경 - Wan2.1-Fun-14B-Control: 다운로드 후

Wan2.1-Fun-14B-Control.safetensors로 이름 변경 - Kijai/Wan2.1-Fun-Control-14B_fp8_e4m3fn.safetensors

텍스트 인코더에서 한 가지 버전을 선택하여 다운로드:

VAE

CLIP Vision

파일 저장 위치

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └── Wan2.1-Fun-1.3B-Control.safetensors # 또는 선택한 버전

│ ├── 📂 text_encoders/

│ │ └─── umt5-xxl-enc-bf16.safetensors # 또는 선택한 버전

│ ├── 📂 vae/

│ │ └── Wan2_1_VAE_bf16.safetensors

│ └── 📂clip_vision/

│ └── clip_vision_h.safetensors 1. 비디오 제어 텍스트-비디오 워크플로우

1.1 워크플로우 파일 다운로드

아래 이미지를 다운로드하고 ComfyUI에 드래그하여 해당 워크플로우를 로드하세요.

JSON 형식으로 다운로드하세요.

아래 비디오를 입력 비디오로 다운로드하세요.

1.2 워크플로우 단계 완료

아래 이미지를 다운로드하고 ComfyUI에 드래그하여 해당 워크플로우를 로드하세요.

다운로드한 버전을 사용하여 해당 노드가 적절한 모델을 로드했는지 확인하세요.

WanVideo Model Loader노드가Wan2.1-Fun-1.3B-Control.safetensors모델을 로드했는지 확인하세요.Load WanVideo T5 TextEncoder노드가umt5-xxl-enc-bf16.safetensors모델을 로드했는지 확인하세요.WanVideo Vae Loader노드가Wan2_1_VAE_bf16.safetensors모델을 로드했는지 확인하세요.AIO AuxAux Preprocessor노드에서OpenposePreprocessor노드를 선택하세요.Load Video(Upload)노드에서 이전에 제공한 입력 비디오를 업로드하세요.WanVideo TextEncode에서 생성하고자 하는 비디오의 프롬프트를 입력하세요 (기본값으로 유지할 수 있습니다).Run버튼을 클릭하거나 단축키Ctrl(cmd) + Enter를 사용하여 비디오 생성을 실행하세요.

1.3 워크플로우 분석

이 버전의 워크플로우는 주로 전처리된 이미지 조건을 인코딩한 후 비디오를 생성합니다. 이미지 전처리 노드 OpenposePreprocessor에서는 Openpose, Depth, Canny 등 다양한 전처리 방법을 선택할 수 있습니다. 여기서는 Openpose 전처리 방법을 선택하여 해당 캐릭터의 모션 제어 및 인코딩을 생성합니다.

2. 비디오 제어 참조 이미지 비디오 생성 워크플로우

이 워크플로우는 주로 clip_vision_h.safetensors 모델을 로드하여 참조 이미지의 내용을 효과적으로 이해할 수 있습니다. 그러나 일관성을 완전히 유지하여 비디오를 생성하는 것이 아니라 참조 이미지의 특징을 기반으로 비디오를 생성합니다.

2.1 워크플로우 파일 다운로드

아래 이미지를 다운로드하고 ComfyUI에 드래그하여 해당 워크플로우를 로드하세요.

JSON 형식으로 다운로드하세요.

아래 비디오와 이미지를 다운로드하여 입력 조건으로 사용하세요.

2.2 워크플로우 단계 완료

WanVideo Model Loader노드가Wan2.1-Fun-1.3B-Control.safetensors모델을 로드했는지 확인하세요.Load WanVideo T5 TextEncoder노드가umt5-xxl-enc-bf16.safetensors모델을 로드했는지 확인하세요.WanVideo Vae Loader노드가Wan2_1_VAE_bf16.safetensors모델을 로드했는지 확인하세요.Load Video(Upload)노드에서 이전에 제공한 입력 비디오를 업로드하세요.AIO AuxAux Preprocessor노드에서OpenposePreprocessor노드를 선택하세요.Load CLIP Vision노드에서 참조 이미지의 특징을 추출하기 위해clip_vision_h.safetensors모델이 로드되었는지 확인하세요.Load Image노드에서 이전에 제공한 참조 이미지를 업로드하세요.WanVideo TextEncode에서 생성하고자 하는 비디오의 프롬프트를 입력하세요 (기본값으로 유지할 수 있습니다).Run버튼을 클릭하거나 단축키Ctrl(cmd) + Enter를 사용하여 비디오 생성을 실행하세요.

2.3 워크플로우 분석

- Kijai가 해당 노드를 업데이트했으므로,

WanVideo ImageToVideo Encode노드에fun_model이라는 옵션이 있으며, 이를 true로 설정해야 합니다. - 다른 것과 비교했을 때, 참조 이미지의 특징을 사용하는 것이 더 적합하므로 참조 이미지를 사용하는 것이 여전히 필요합니다. 그러나 이미지의 특징만 추출하므로 캐릭터의 일관성을 완전히 유지할 수는 없습니다.

- 이미지 전처리 섹션에서는 여러 전처리 노드를 결합하여 더 풍부한 제어 조건을 생성할 수 있습니다.