OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

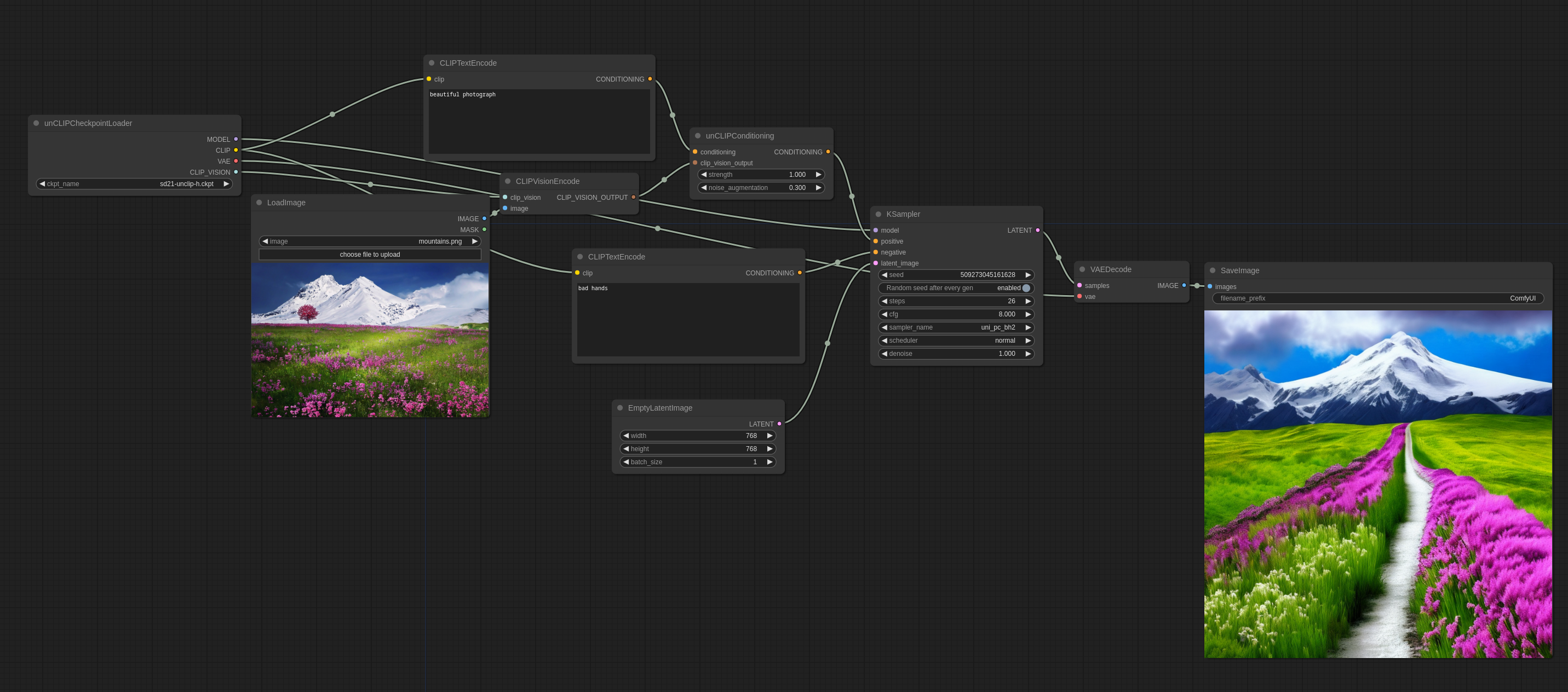

Ejemplos del Modelo unCLIP

Los modelos unCLIP son versiones de los modelos SD especialmente ajustados para recibir conceptos de imágenes como entrada, además de tu prompt de texto. Las imágenes se codifican usando la visión CLIP que estos modelos vienen con, y luego los conceptos extraídos por ella se pasan al modelo principal al muestrear.

Básicamente, te permite usar imágenes en tu prompt.

Aquí está cómo se usa en ComfyUI (puedes arrastrar esto en ComfyUI para obtener el flujo de trabajo):

La augmentación de ruido controla cuán cerca intentará seguir el modelo el concepto de la imagen. Cuanto menor sea el valor, más seguirá el concepto.

La fuerza es cómo influirá fuertemente en la imagen.

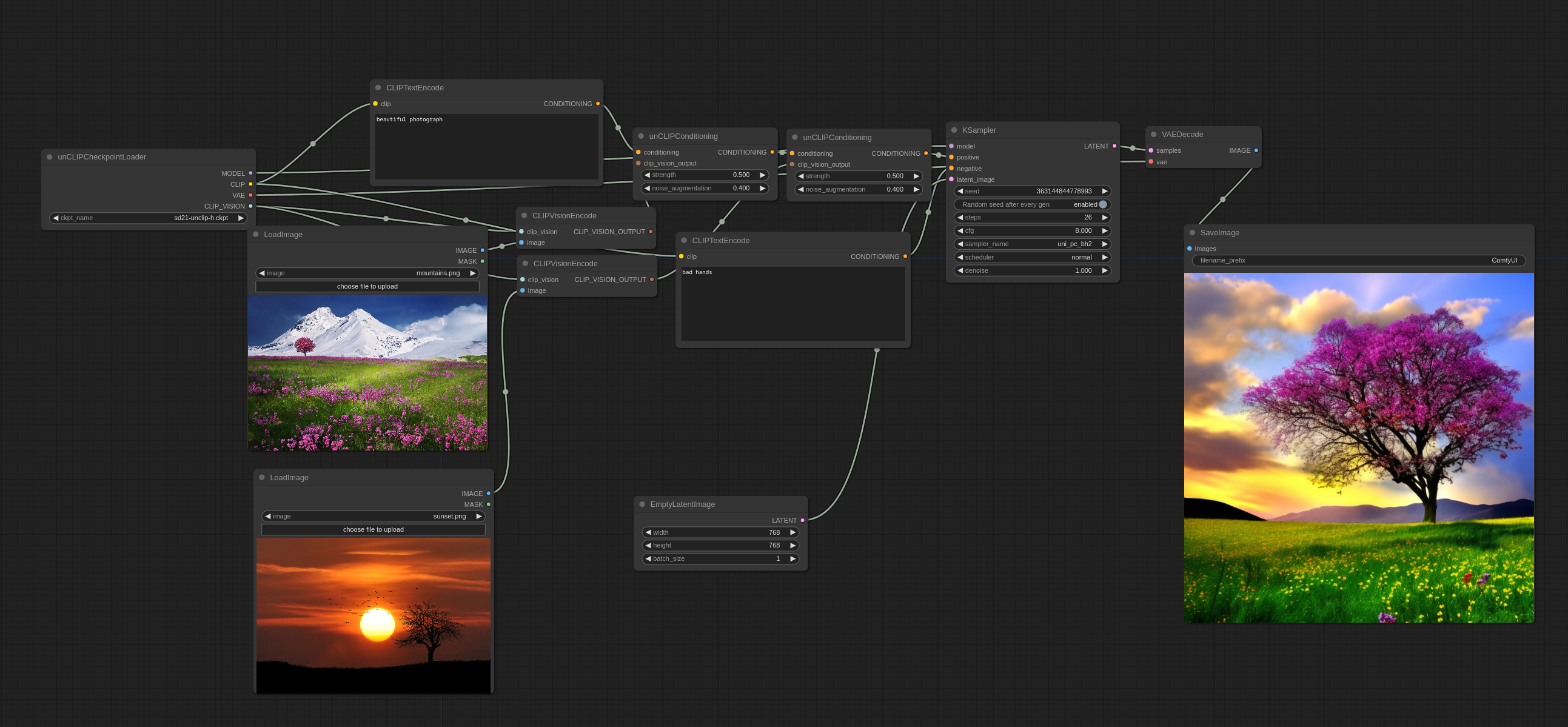

Se pueden usar múltiples imágenes de esta manera:

Notarás cómo no mezcla las imágenes juntas en el sentido tradicional, sino que realmente selecciona algunos conceptos de ambas y crea una imagen coherente.

Imagenes de entrada:

Puedes encontrar los puntos de control oficiales de unCLIP aquí

Puedes encontrar algunos puntos de control de unCLIP que creé a partir de algunos puntos de control existentes de 768-v con algunas fusiones astutas aquí (basado en WD1.5 beta 2) y aquí (basado en iluminati Diffusion)

Flujos de Trabajo más Avanzados

Una buena forma de usar los puntos de control de unCLIP es usarlos para el primer paso de un flujo de trabajo de 2 pasos y luego cambiar a un modelo 1.x para el segundo paso. Esto es cómo se generó la siguiente imagen. (puedes cargarla en ComfyUI para obtener el flujo de trabajo):