OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

Guía de flujo de trabajo de ByteDance USO ComfyUI, transferencia de estilo de imagen y generación de imágenes con preservación de identidad de sujeto

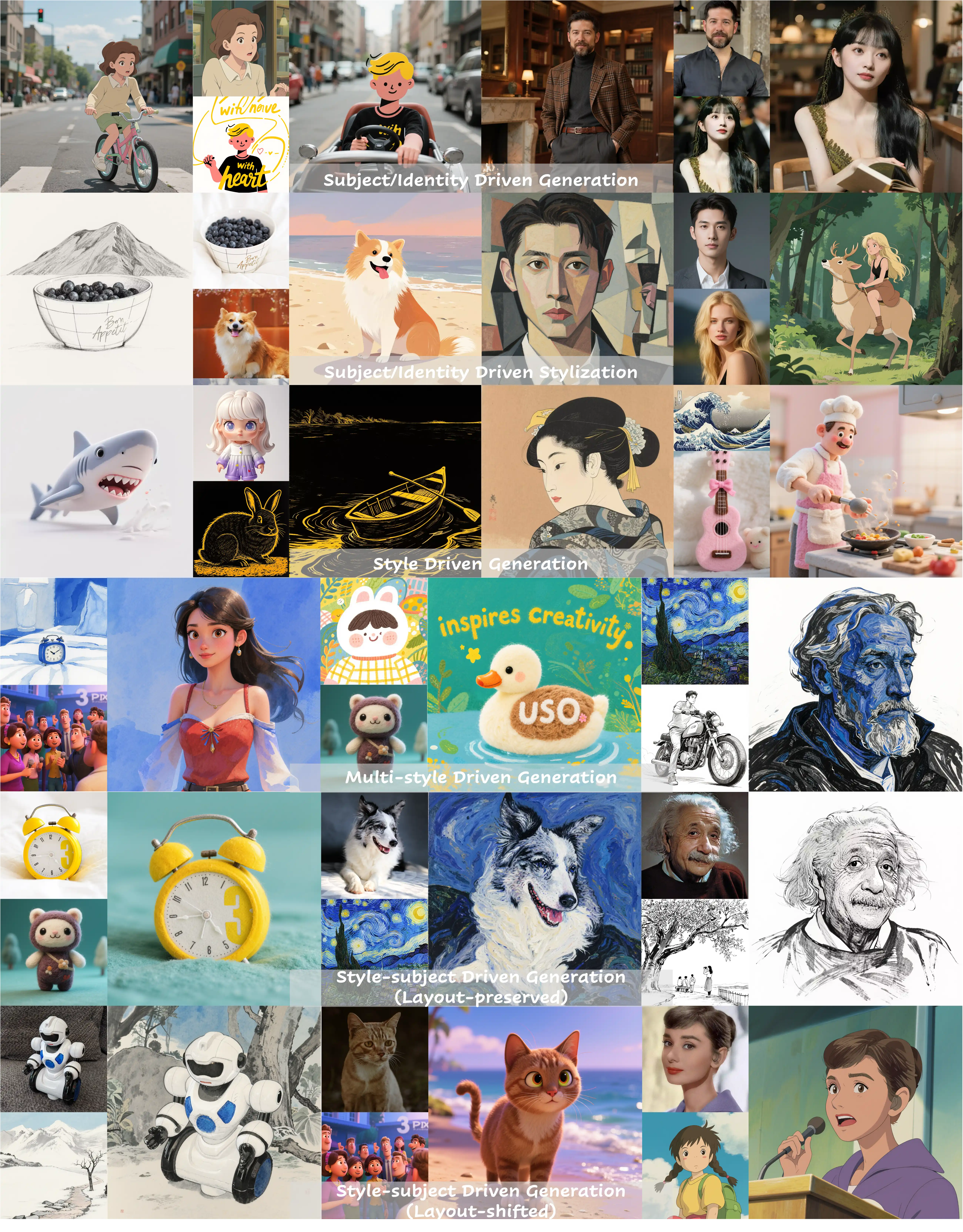

USO (Unified Style and Subject-Driven Generation) es un modelo desarrollado por el equipo UXO de ByteDance que unifica las tareas de generación impulsadas por estilo y sujeto. Construido sobre la arquitectura FLUX.1-dev, el modelo aborda el problema donde los métodos tradicionales tratan la generación impulsada por estilo y sujeto como tareas opuestas. USO resuelve esto a través de un marco unificado con el desacoplamiento y recombinación de contenido y estilo como objetivo central.

El modelo adopta un método de entrenamiento en dos etapas:

- Etapa Uno: Alinear incrustaciones SigLIP mediante entrenamiento de alineación de estilo para obtener un modelo con capacidades de estilo

- Etapa Dos: Desacoplar el codificador condicional y entrenar en datos triple para lograr generación condicional conjunta

USO admite múltiples modos de generación:

- Generación impulsada por sujeto: Mantiene la consistencia de identidad del sujeto, adecuado para estilizar sujetos específicos como personas y objetos

- Generación impulsada por estilo: Logra transferencia de estilo de alta calidad aplicando el estilo de imágenes de referencia a nuevo contenido

- Generación impulsada por identidad: Realiza estilización manteniendo características de identidad, particularmente adecuado para estilización de retratos

- Generación conjunta de estilo y sujeto: Controla simultáneamente sujeto y estilo para lograr expresiones creativas complejas

- Generación de estilo mixto múltiple: Admite la aplicación de fusión de múltiples estilos

Enlaces relacionados

Flujo de trabajo nativo de ByteDance USO en ComfyUI

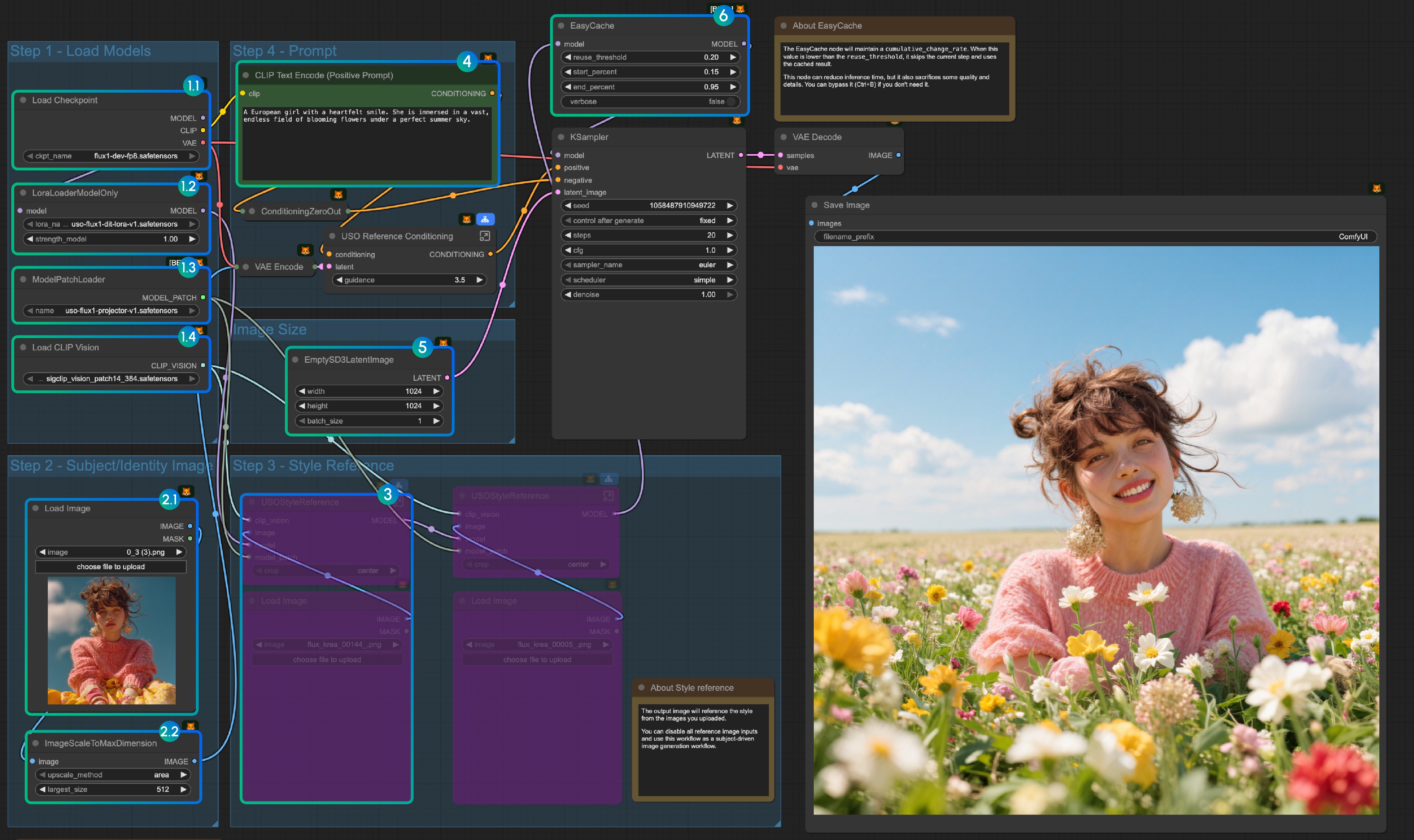

1. Flujo de trabajo y entrada

Descargue la imagen a continuación y arrástrela a ComfyUI para cargar el flujo de trabajo correspondiente.

Use la imagen a continuación como imagen de entrada.

2. Enlaces de modelos

checkpoints

loras

model_patches

clip_visions

Descargue todos los modelos y colóquelos en los siguientes directorios:

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 checkpoints/

│ │ └── flux1-dev-fp8.safetensors

│ ├── 📂 loras/

│ │ └── uso-flux1-dit-lora-v1.safetensors

│ ├── 📂 model_patches/

│ │ └── uso-flux1-projector-v1.safetensors

│ ├── 📂 clip_visions/

│ │ └── sigclip_vision_patch14_384.safetensors3. Instrucciones del flujo de trabajo

- Cargar modelos:

- 1.1 Asegúrese de que el nodo

Load Checkpointtenga cargadoflux1-dev-fp8.safetensors - 1.2 Asegúrese de que el nodo

LoraLoaderModelOnlytenga cargadodit_lora.safetensors - 1.3 Asegúrese de que el nodo

ModelPatchLoadertenga cargadoprojector.safetensors - 1.4 Asegúrese de que el nodo

Load CLIP Visiontenga cargadosigclip_vision_patch14_384.safetensors

- 1.1 Asegúrese de que el nodo

- Referencia de contenido:

- 2.1 Haga clic en

Uploadpara cargar la imagen de entrada que proporcionamos - 2.2 El nodo

ImageScaleToMaxDimensionescalará su imagen de entrada para referencia de contenido, 512px mantendrá más características del personaje, pero si solo usa la cabeza del personaje como entrada, la imagen de salida final a menudo tiene problemas como que el personaje ocupe demasiado espacio. Establecerlo en 1024px da resultados mucho mejores.

- 2.1 Haga clic en

- En el ejemplo, solo usamos la entrada de imagen

referencia de contenido. Si desea usar la entrada de imagenreferencia de estilo, puede usarCtrl-Bpara omitir el grupo de nodos marcado. - Escriba su indicación o mantenga la predeterminada

- Establezca el tamaño de imagen si lo necesita

- El nodo EasyCache es para aceleración de inferencia, pero también sacrificará algo de calidad y detalles. Puede omitirlo (Ctrl+B) si no necesita usarlo.

- Haga clic en el botón

Run, o use el atajoCtrl(Cmd) + Enterpara ejecutar el flujo de trabajo

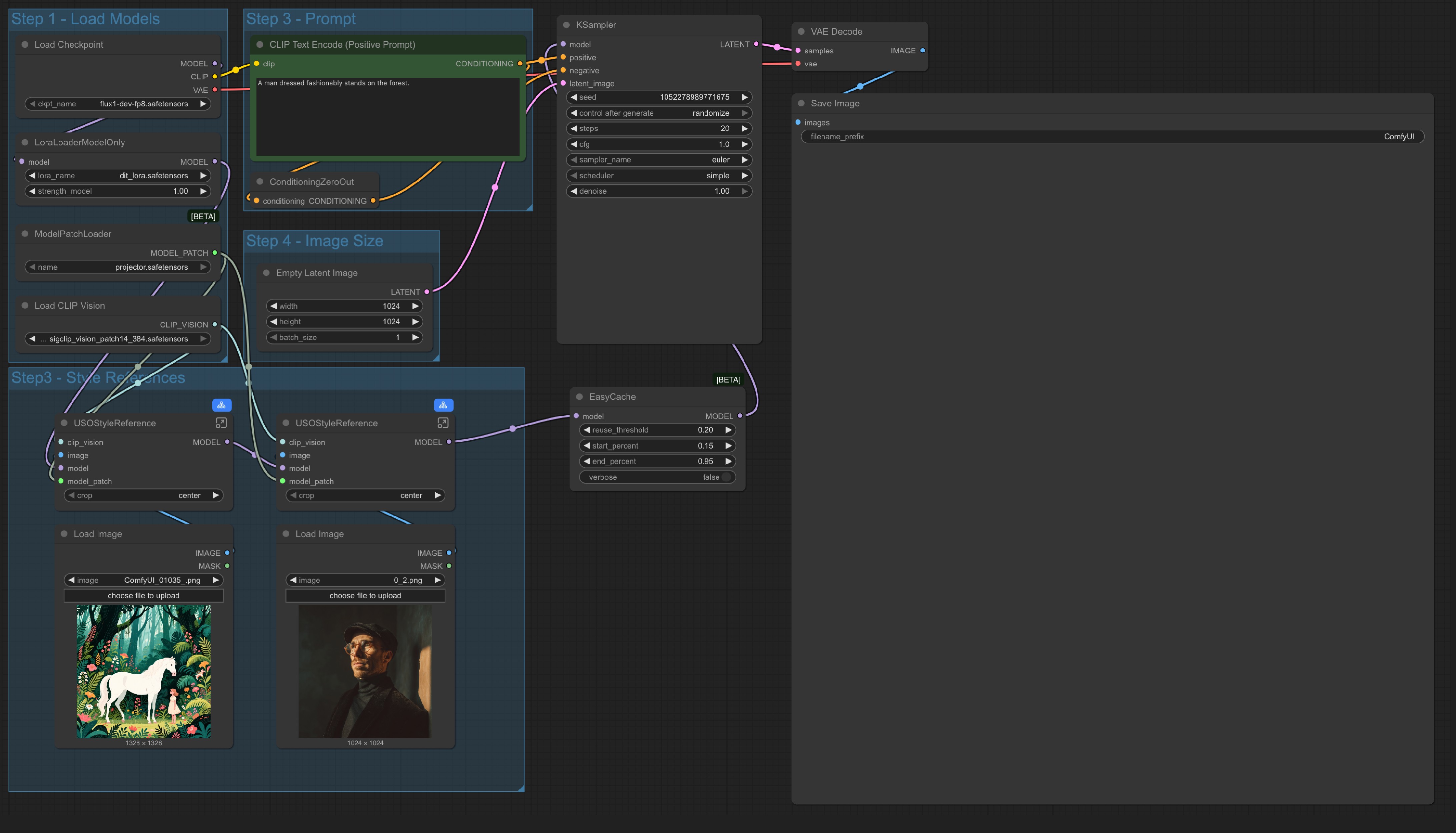

4. Notas adicionales

- Solo referencia de estilo:

También proporcionamos un flujo de trabajo que solo usa referencia de estilo en el mismo flujo de trabajo que proporcionamos

La única diferencia es que reemplazamos el nodo

La única diferencia es que reemplazamos el nodo referencia de contenido y solo usamos un nodo Empty Latent Image.

- También puede omitir todo el grupo

Referencia de estiloy usar el flujo de trabajo como un flujo de trabajo de texto a imagen, lo que significa que este flujo de trabajo tiene 4 variaciones:

- Generación impulsada por sujeto: Solo usar referencia de contenido (sujeto)

- Generación impulsada por estilo: Solo usar referencia de estilo

- Generación conjunta de estilo y sujeto: Referencia de contenido y estilo mixta

- Generación de texto a imagen: Como un flujo de trabajo estándar de texto a imagen