OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

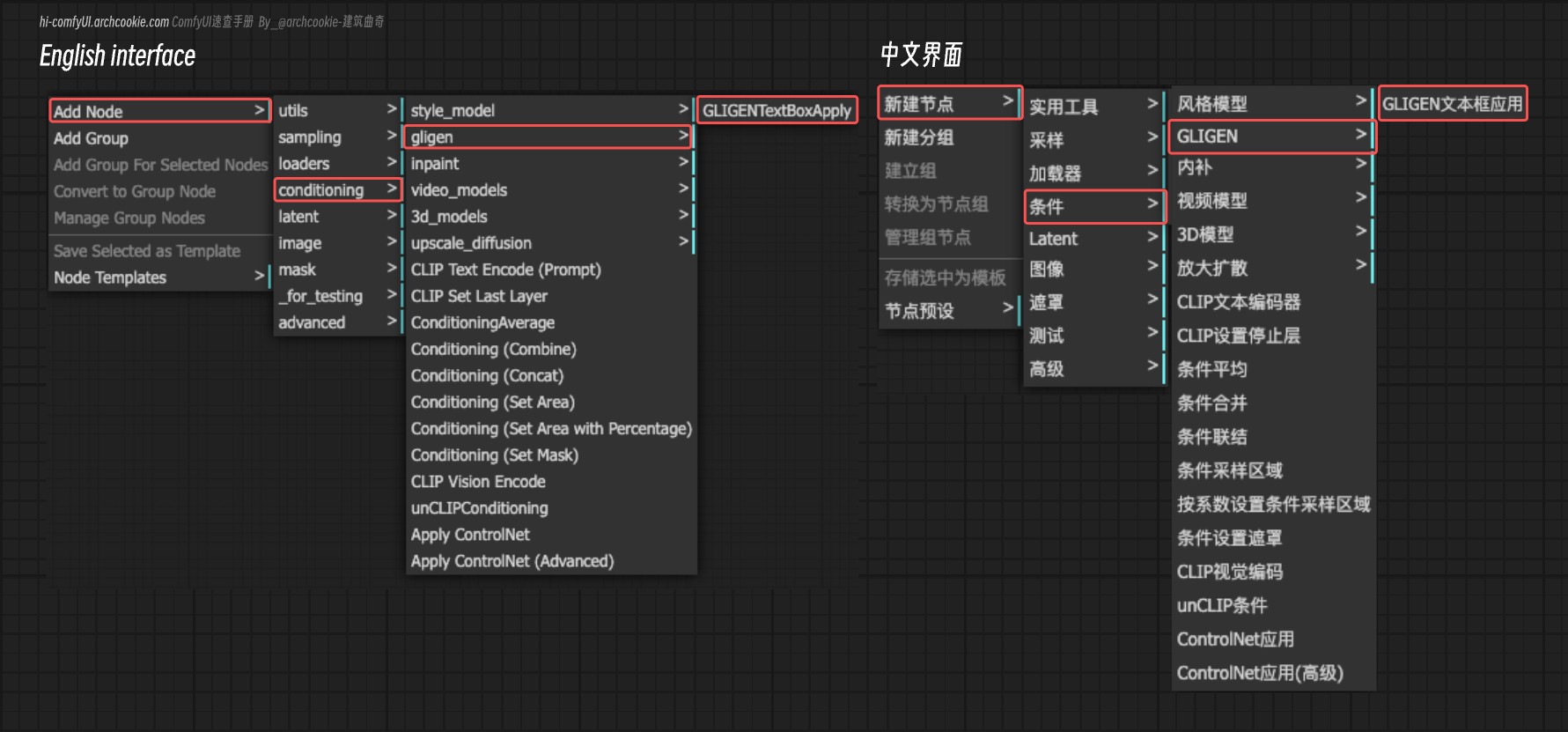

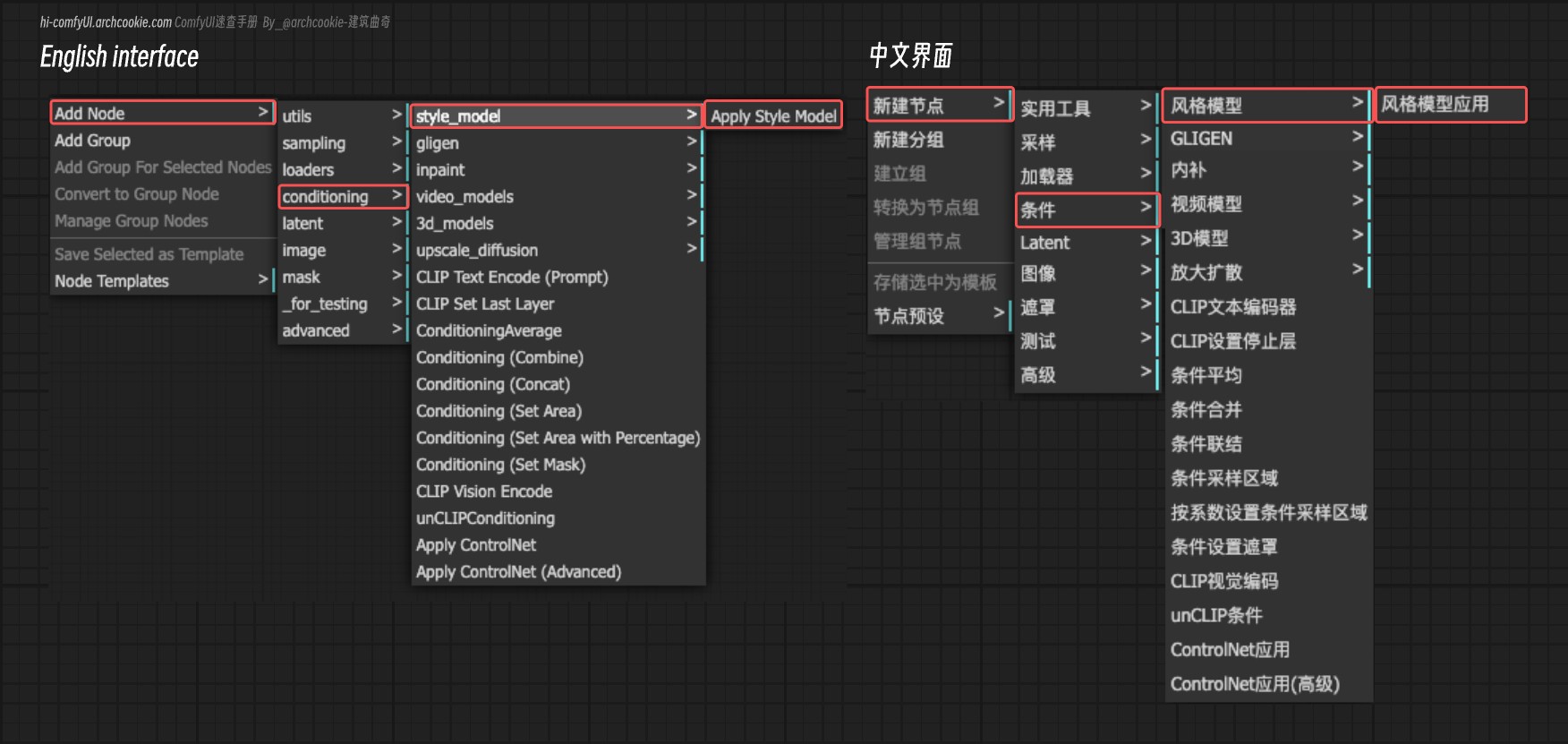

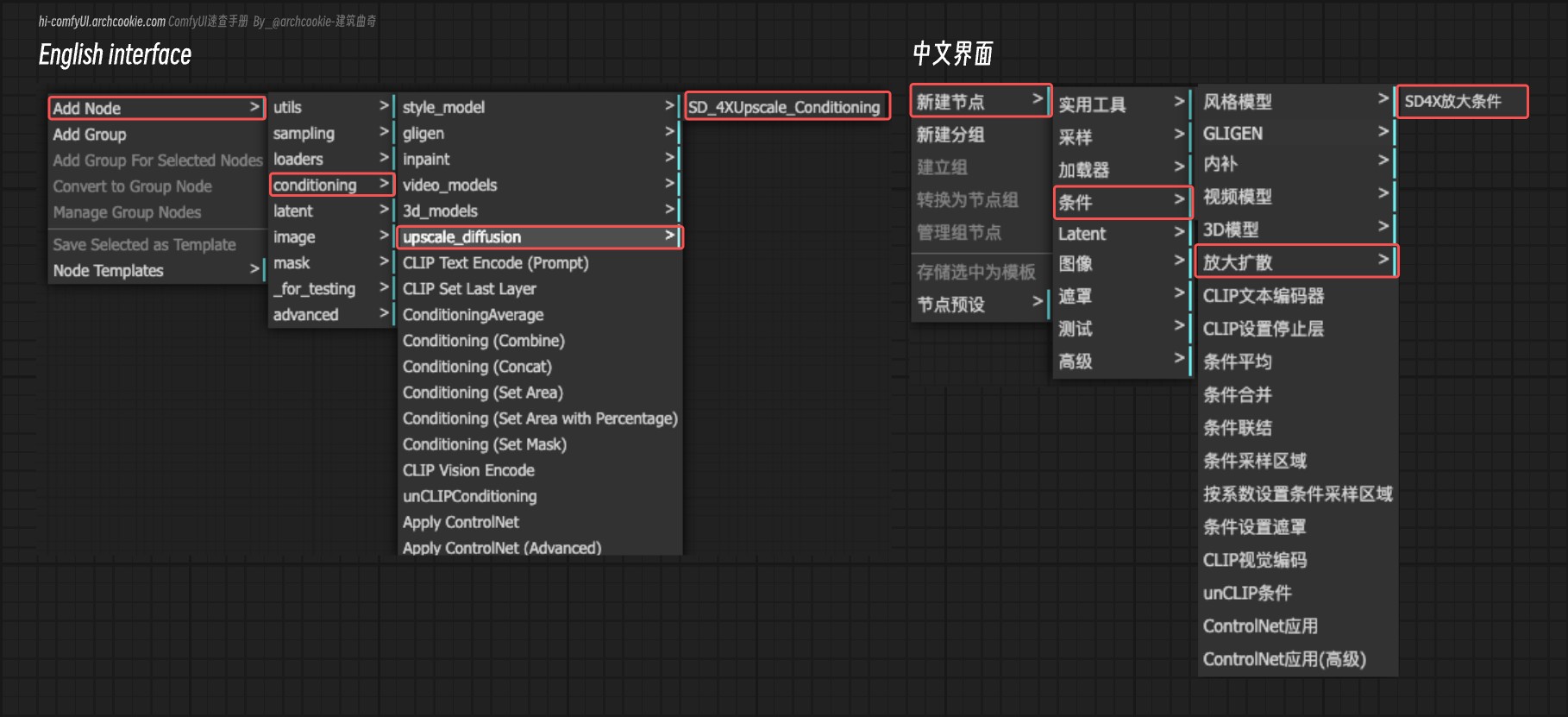

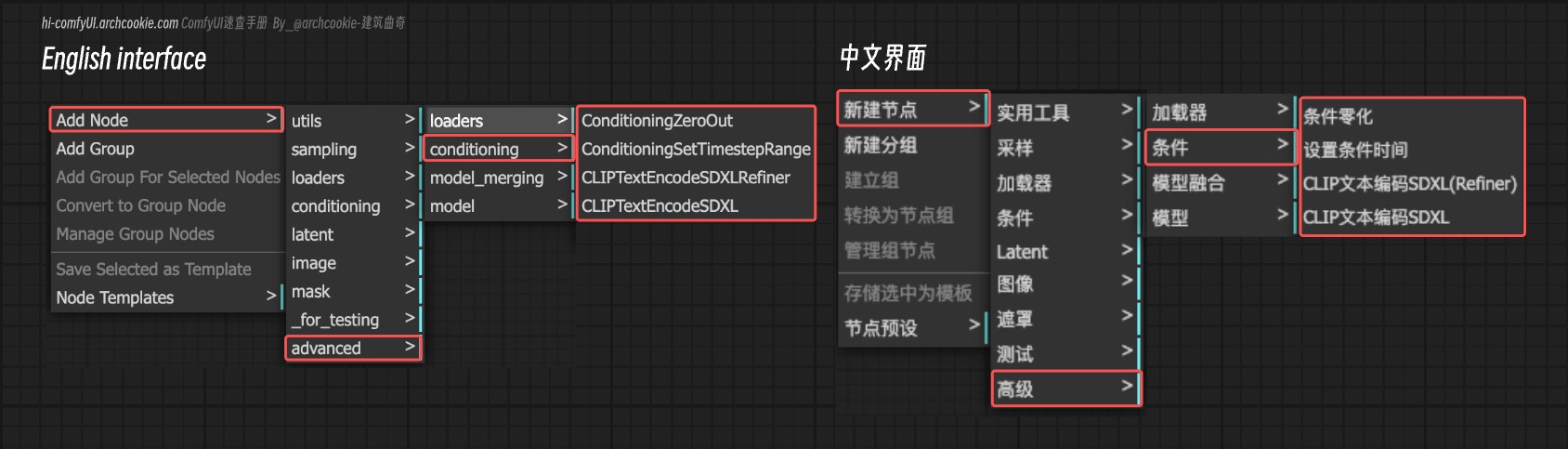

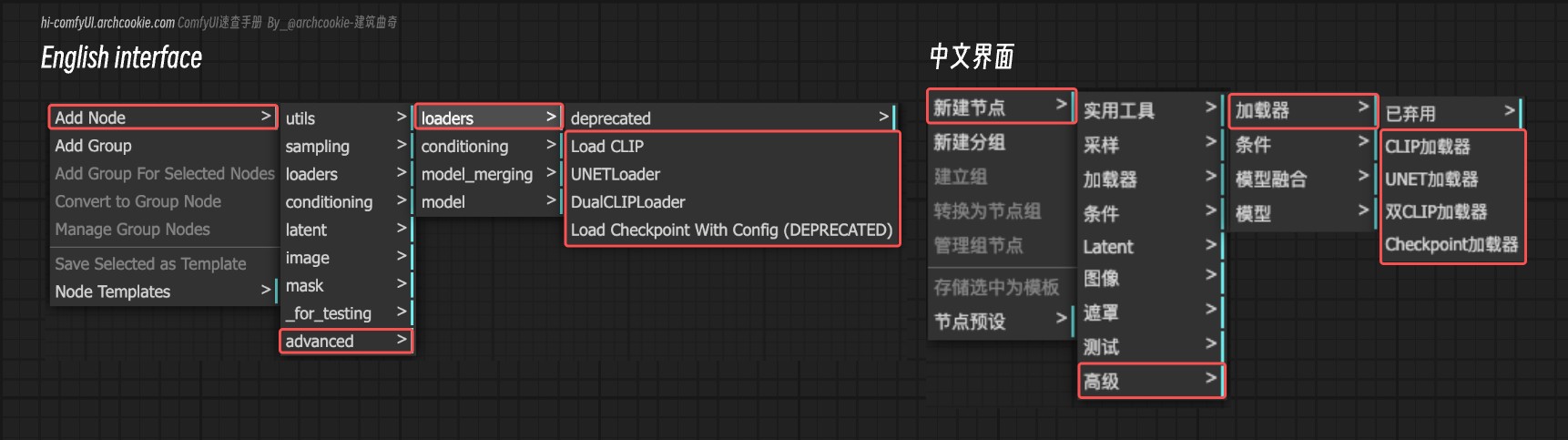

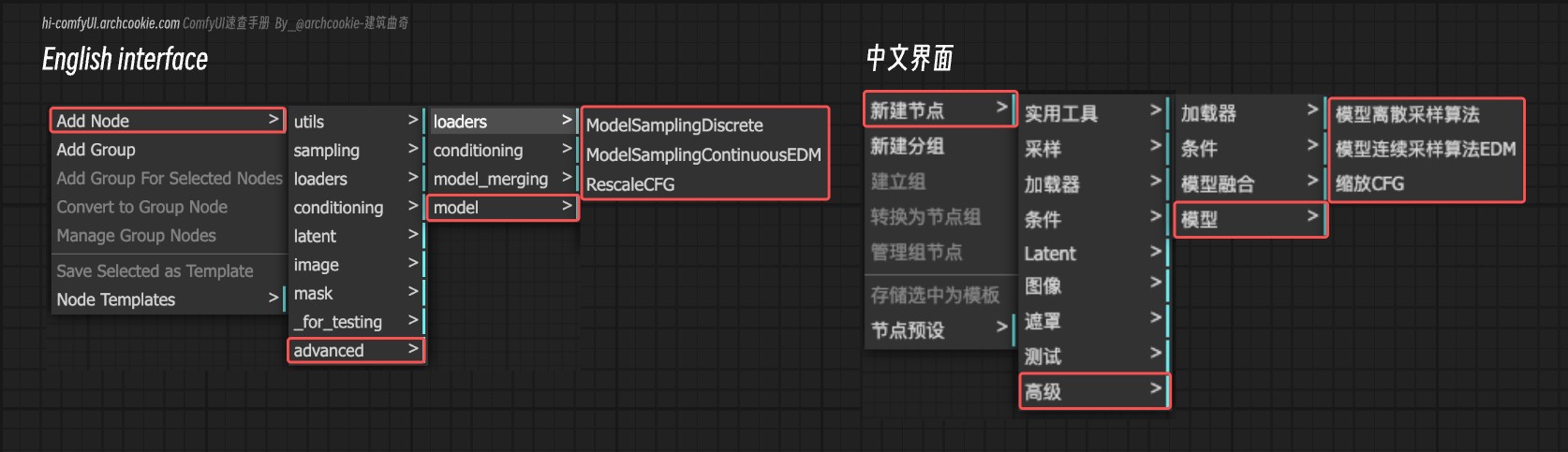

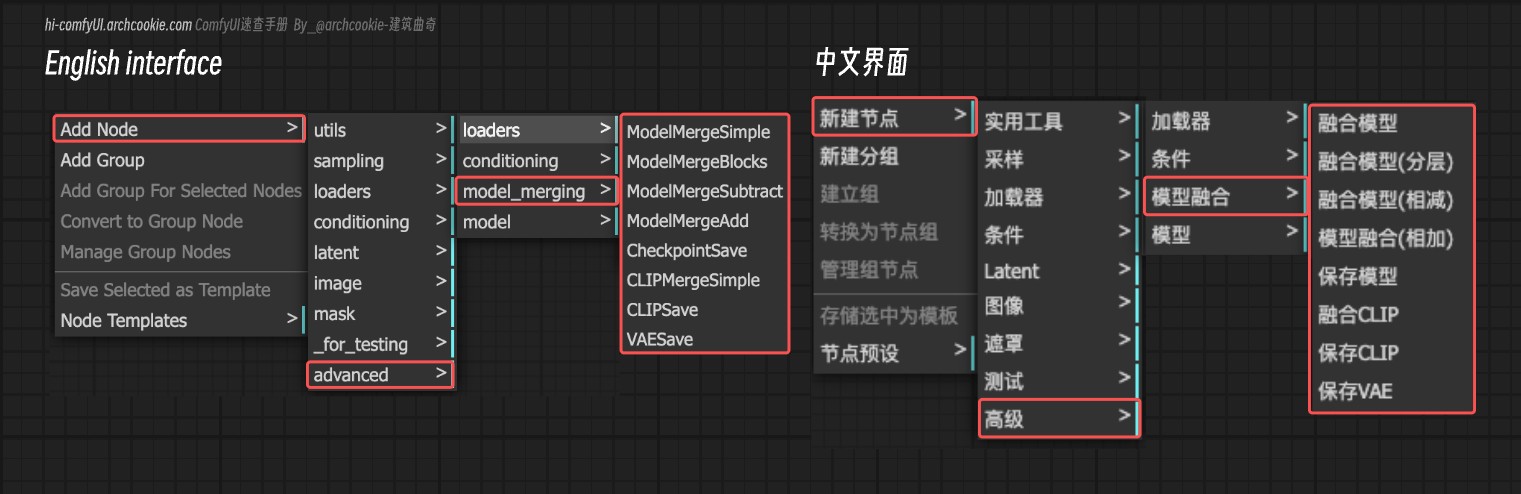

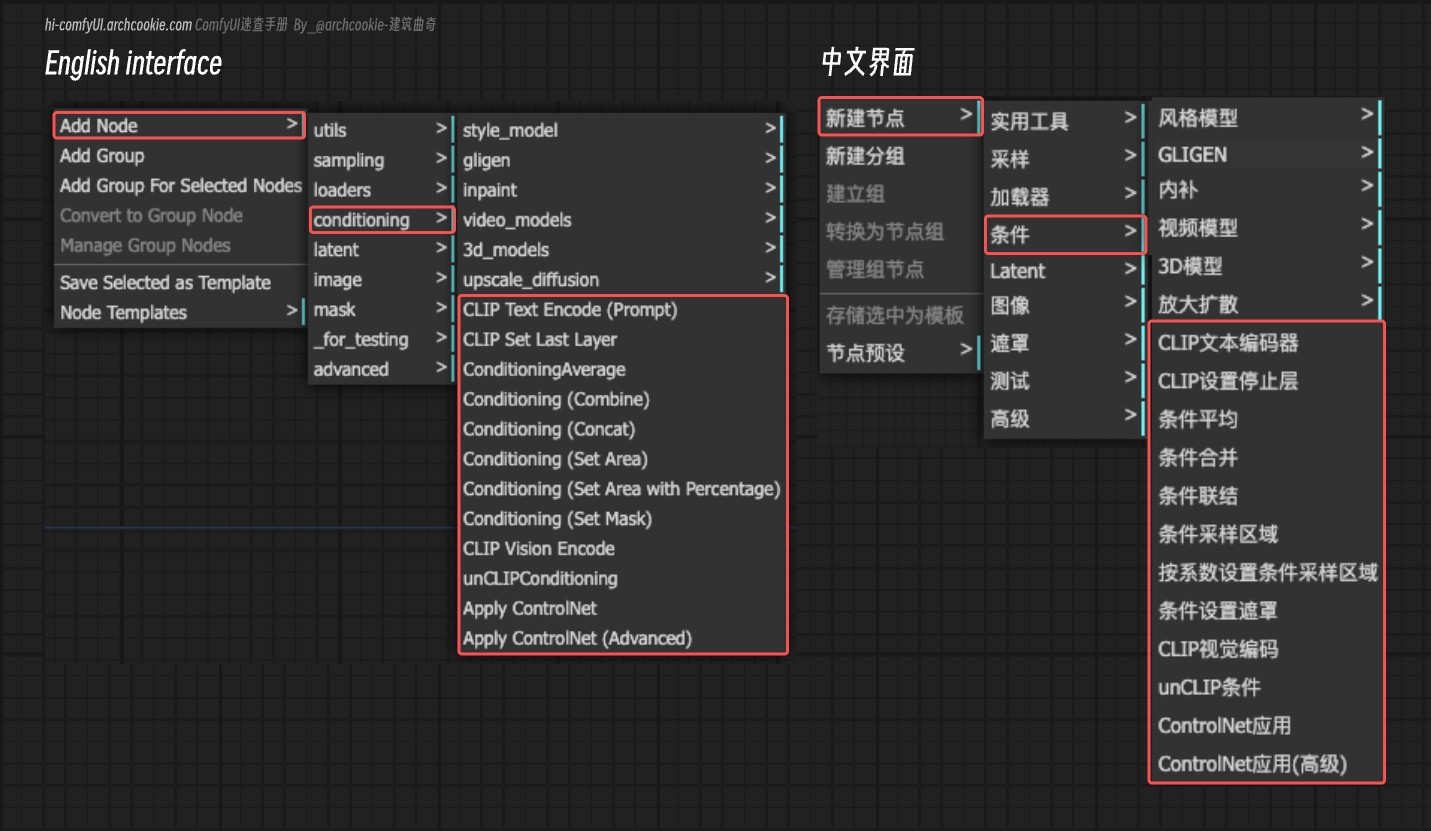

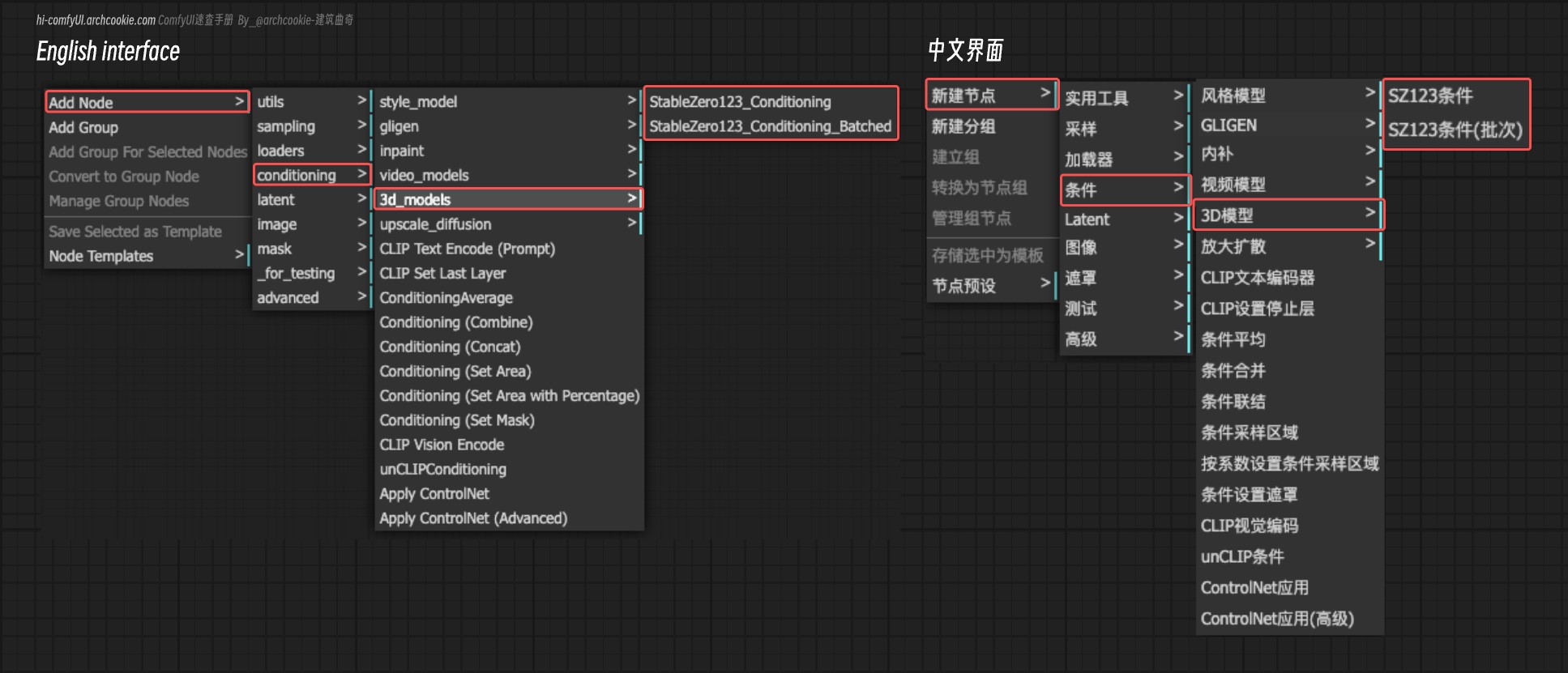

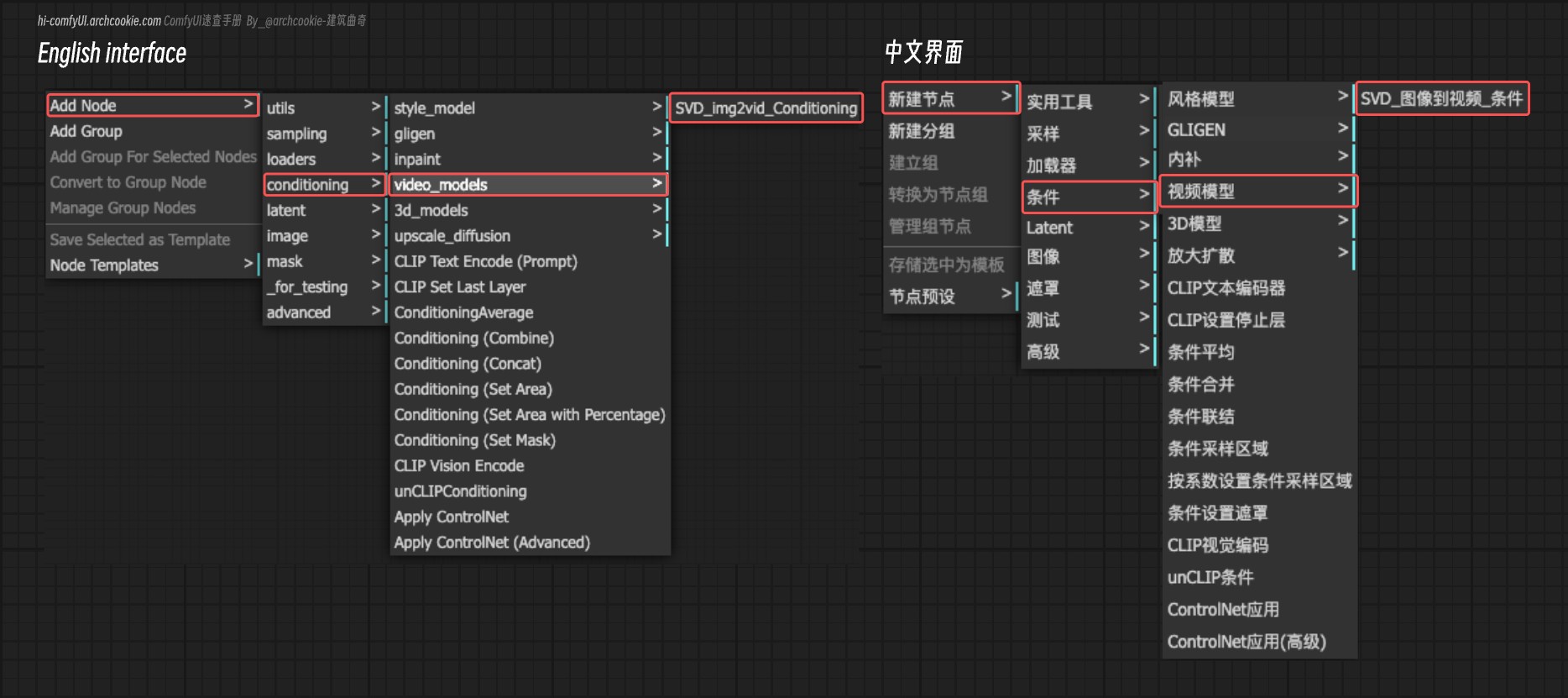

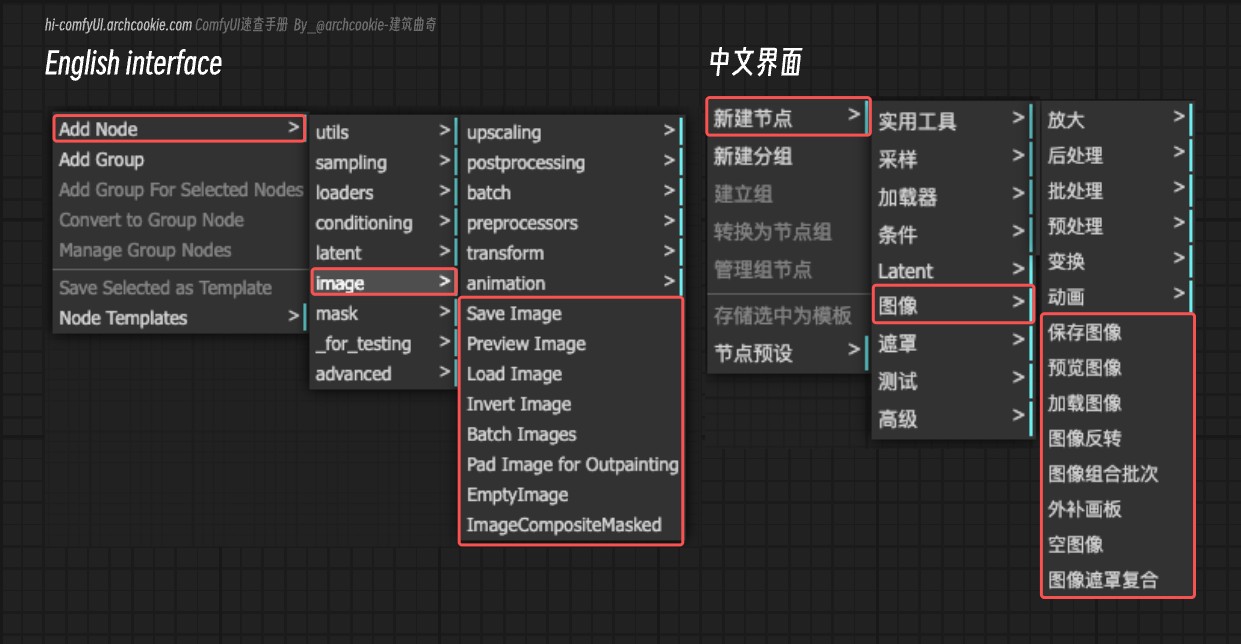

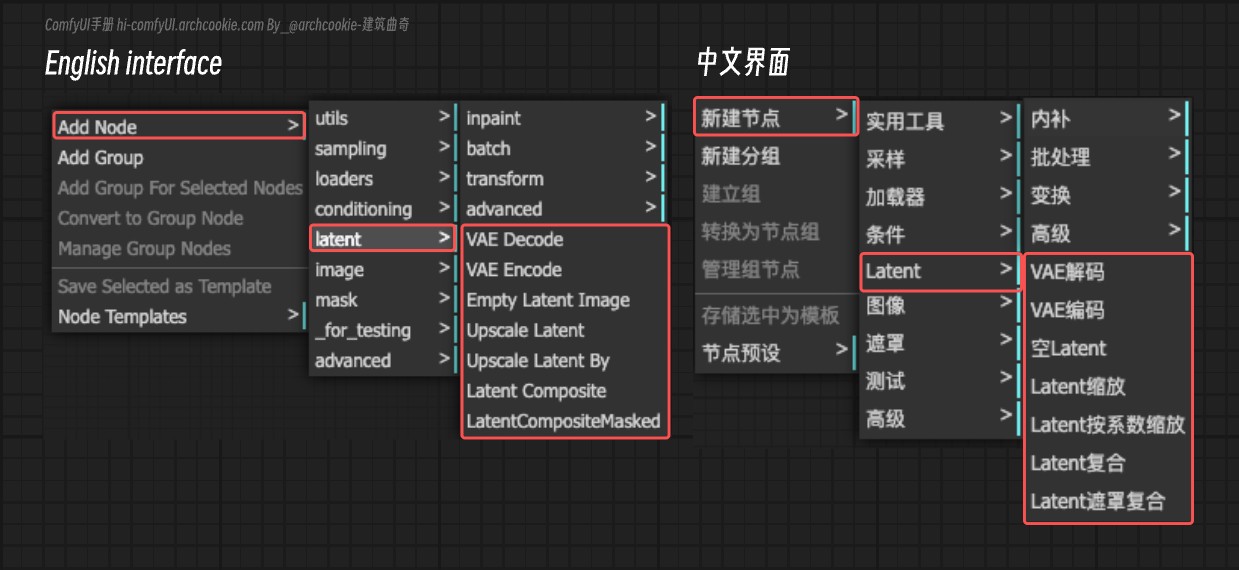

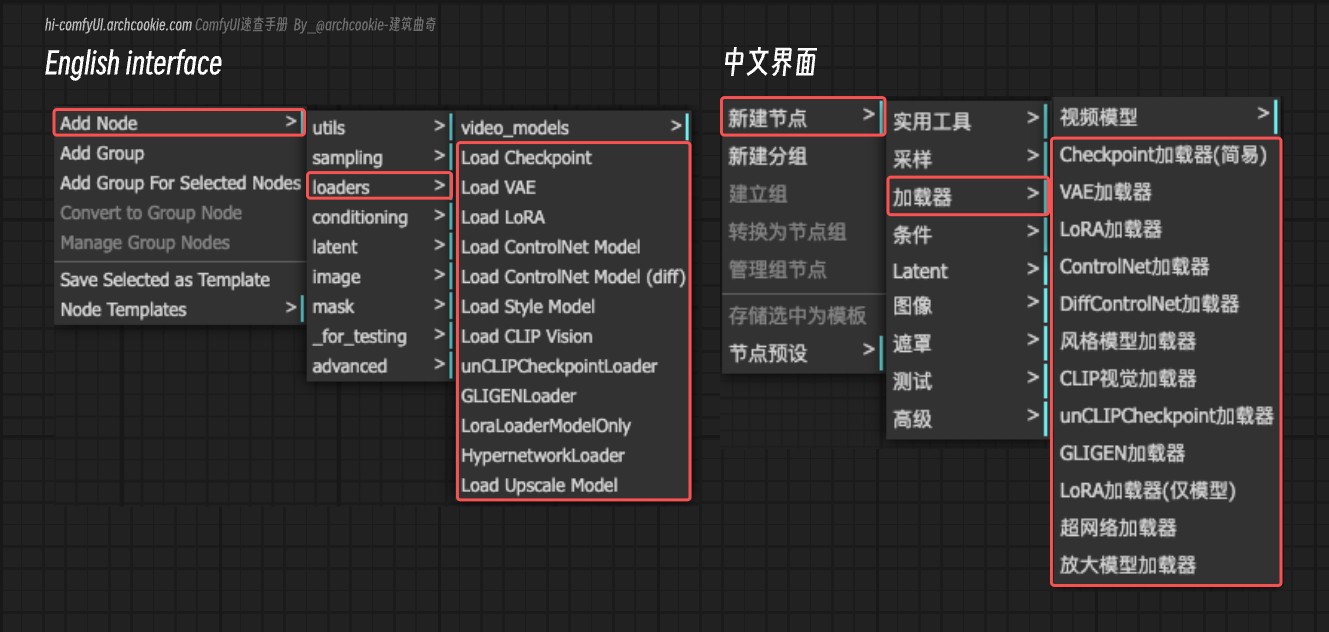

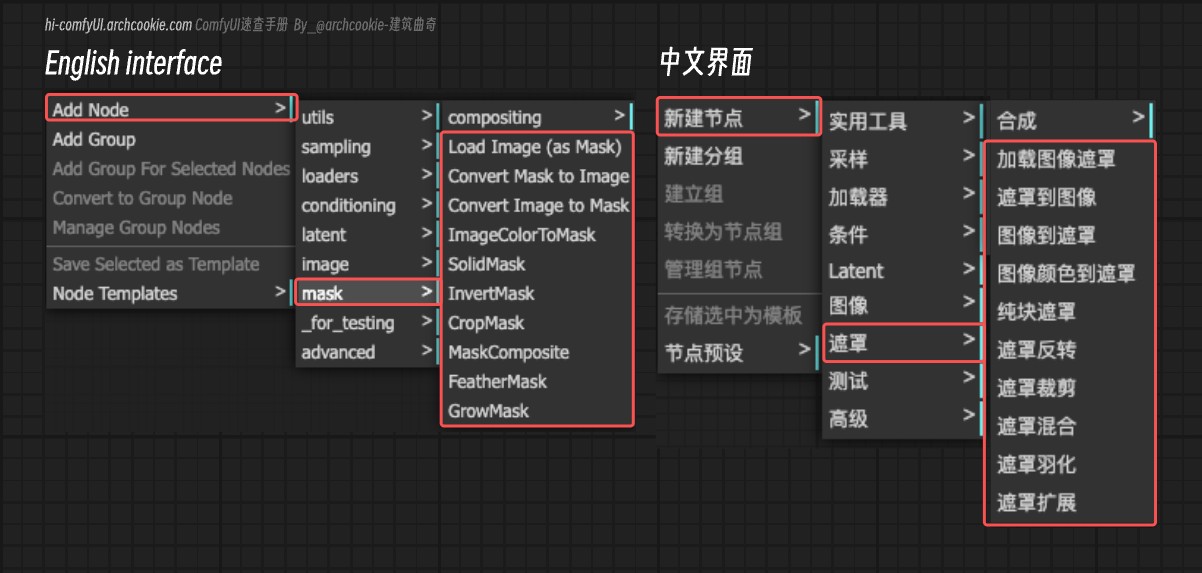

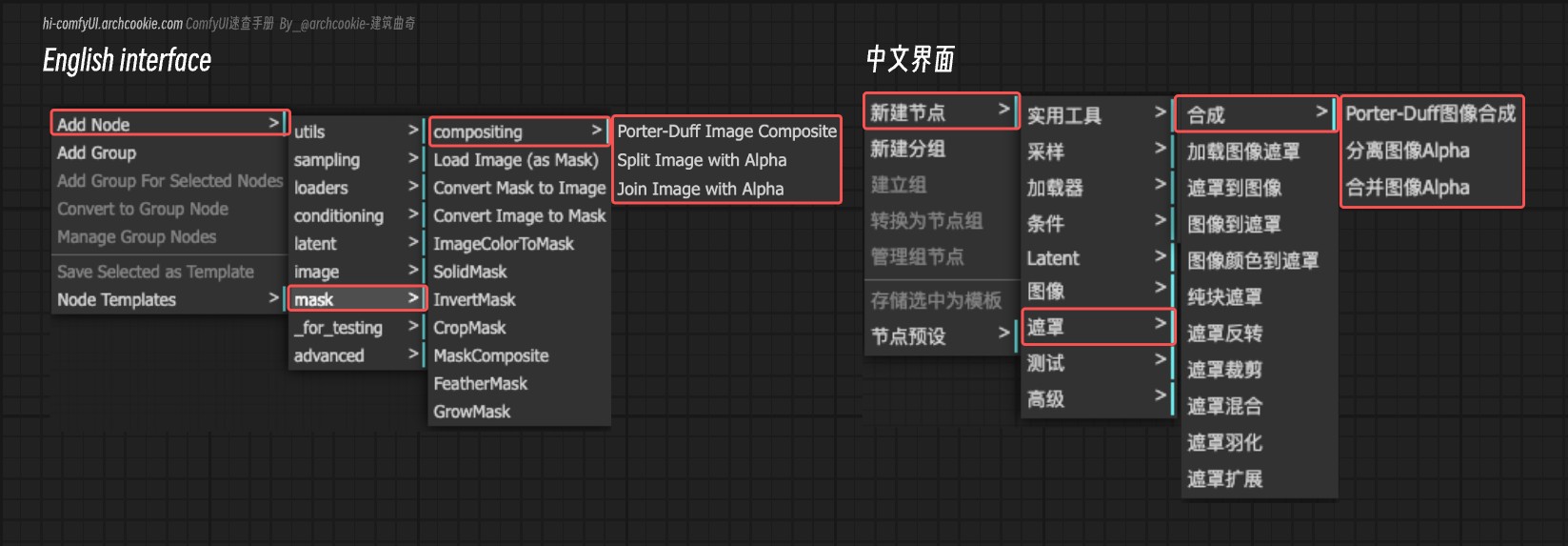

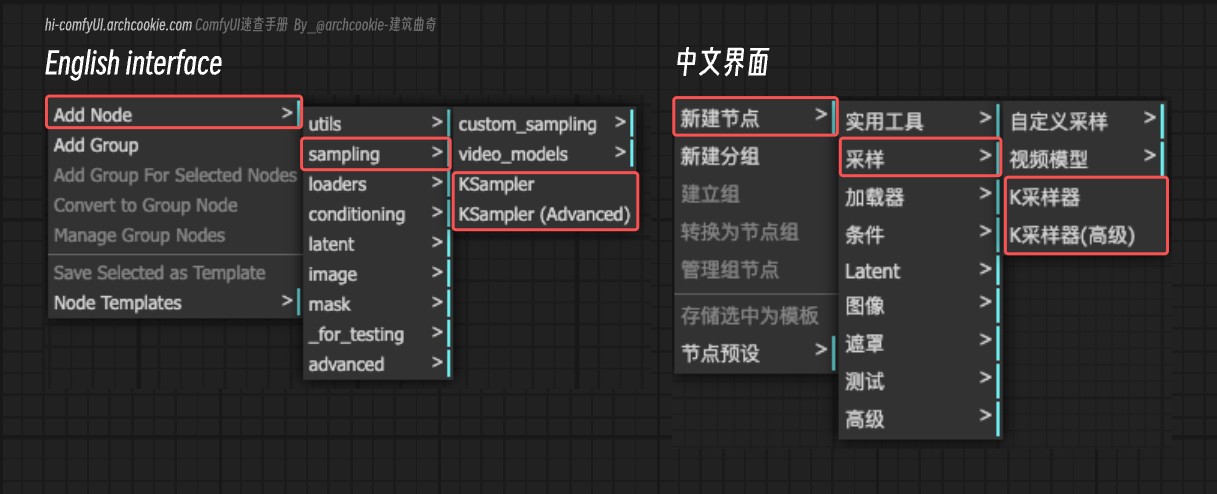

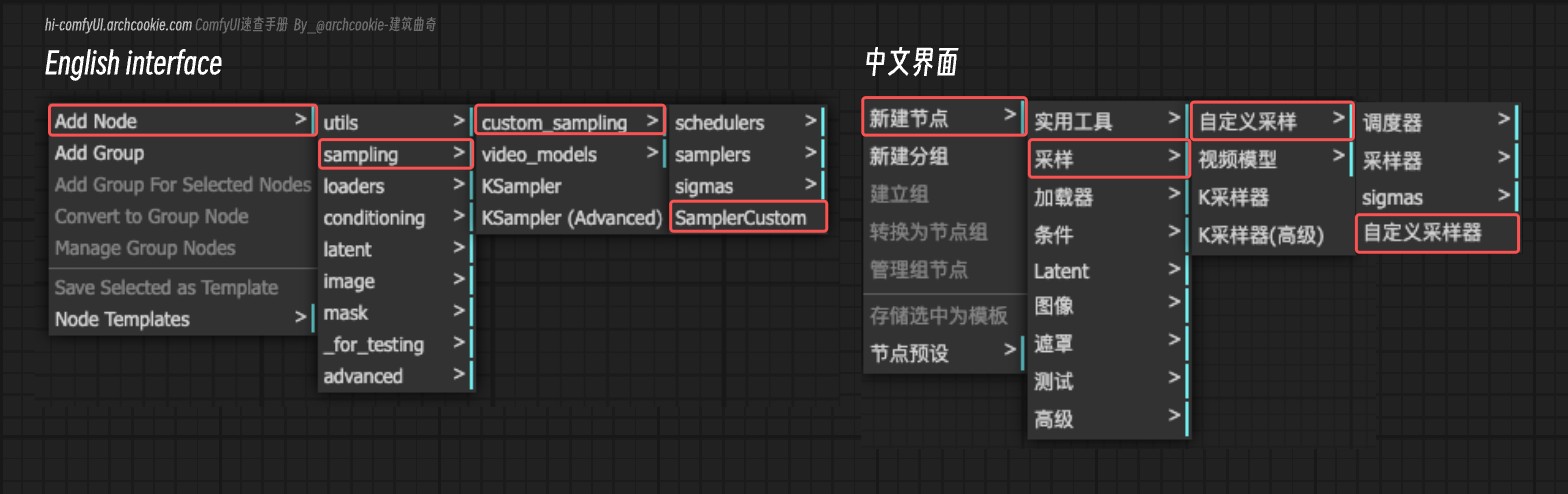

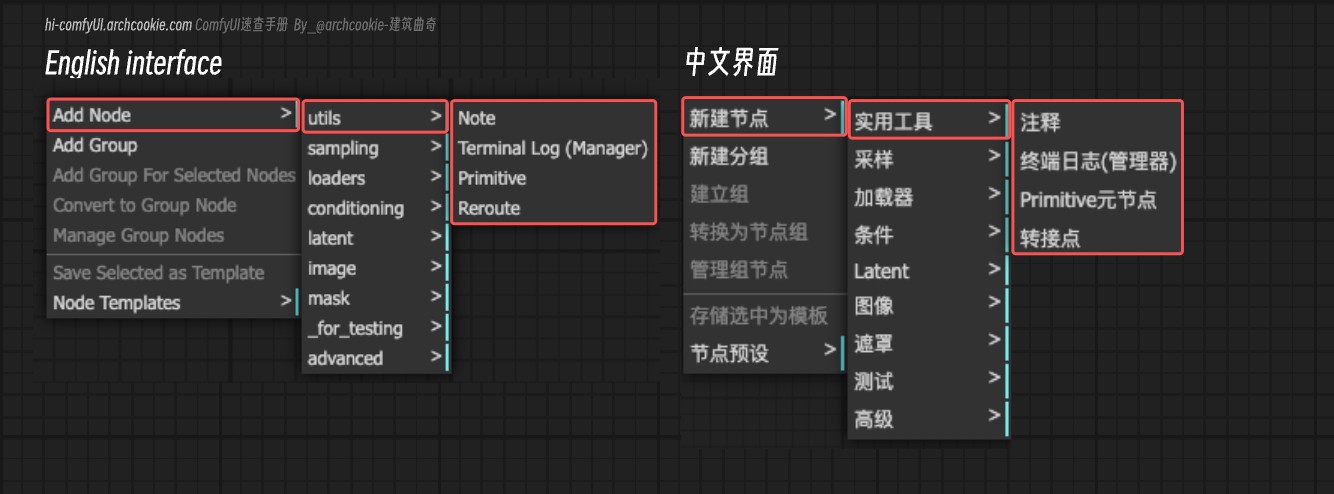

Explicación Detallada de los Nodos de ComfyUI

Esta sección se centra principalmente en la introducción de los nodos y las funcionalidades relacionadas en ComfyUI. El orden sigue la secuencia del menú contextual derecho en ComfyUI. Se recomienda usar la función de búsqueda de documentos para una recuperación rápida.

Las porciones en inglés del documento se originaron de: https://docs.getsalt.ai/ y han sido reorganizadas.

Avanzado

Características y ajustes avanzados

Codificación de Texto CLIP SDXL

Aprende sobre el nodo de Codificación de Texto CLIP SDXL en ComfyUI, que codifica las entradas de texto utilizando modelos CLIP específicamente adaptados para la arquitectura SDXL, convirtiendo descripciones textuales en un formato adecuado para tareas de generación o manipulación de imágenes.

Ver DocsRefinador de Codificación de Texto CLIP SDXL

Aprende sobre el nodo Refinador de Codificación de Texto CLIP SDXL en ComfyUI, que refina la codificación de las entradas de texto utilizando modelos CLIP, mejorando el condicionamiento para tareas generativas al incorporar puntuaciones estéticas y dimensiones.

Ver DocsCLIP Text Encode Hunyuan DiT

Documentación del nodo CLIPTextEncodeHunyuanDiT de ComfyUI, incluyendo tipos de entrada/salida, métodos, introducción a BERT y mT5-XL, y consejos de uso.

Ver DocsRango de Tiempos de Ajuste de Condicionamiento

Aprende sobre el nodo Rango de Tiempos de Ajuste de Condicionamiento en ComfyUI, que ajusta el aspecto temporal del condicionamiento al establecer un rango específico de tiempos, permitiendo una generación más dirigida y eficiente.

Ver DocsCero de Condicionamiento

Aprende sobre el nodo Cero de Condicionamiento en ComfyUI, que anula elementos específicos dentro de la estructura de datos de condicionamiento, neutralizando efectivamente su influencia en los pasos de procesamiento posteriores.

Ver DocsExplicación del Nodo CLIPTextEncodeFlux para ComfyUI

Descubre las funcionalidades del nodo CLIPTextEncodeFlux en ComfyUI para la codificación avanzada de texto y la generación de imágenes condicionales.

Ver DocsFluxGuidance - Descripción de la funcionalidad del nodo ComfyUI

Aprende sobre el nodo FluxGuidance en ComfyUI, que controla la influencia de los mensajes de texto en la generación de imágenes.

Ver DocsCargador CLIP

Aprende sobre el nodo Cargador CLIP en ComfyUI, diseñado para cargar modelos CLIP, soportando diferentes tipos como difusión estable y cascada estable. Este nodo abstrae las complejidades de cargar y configurar modelos CLIP para su uso en diversas aplicaciones, proporcionando una forma simplificada de acceder a estos modelos con configuraciones específicas.

Ver DocsCargar Punto de Control con Configuración (DEPRECATED)

Aprende sobre el nodo Cargar Punto de Control con Configuración (DEPRECATED) en ComfyUI, diseñado para cargar puntos de control de modelos junto con sus configuraciones. Este nodo abstrae las complejidades de cargar y configurar puntos de control de modelos para su uso en diversas aplicaciones, proporcionando una forma simplificada de acceder a estos modelos con configuraciones específicas.

Ver DocsCargador de Difusores

Aprende sobre el nodo Cargador de Difusores en ComfyUI, diseñado para cargar modelos de la biblioteca de difusores, manejando específicamente la carga de modelos UNet, CLIP y VAE según las rutas de modelo proporcionadas. Facilita la integración de estos modelos en el marco de ComfyUI, habilitando funcionalidades avanzadas como la generación de imágenes a partir de texto, manipulación de imágenes y más.

Ver DocsCargador Dual CLIP - Cómo funciona y cómo usarlo.

Aprende sobre el nodo Cargador Dual CLIP en ComfyUI, que está diseñado para cargar dos modelos CLIP simultáneamente, facilitando operaciones que requieren la integración o comparación de características de ambos modelos.

Ver DocsQuadrupleCLIPLoader | Cargador QuadrupleCLIP - Nodo ComfyUI

El nodo QuadrupleCLIPLoader es uno de los nodos centrales de ComfyUI, que se agregó por primera vez para el soporte de la versión HiDream I1.

Ver DocsGuía del Cargador UNET | Cargar Modelo de Difusión - Documentación y Ejemplo

Aprende sobre el nodo Cargador UNET en ComfyUI, diseñado para cargar modelos U-Net por nombre, facilitando el uso de arquitecturas U-Net preentrenadas dentro del sistema.

Ver DocsMuestreo de Modelo Continuo EDM

Aprende sobre el nodo Muestreo de Modelo Continuo EDM en ComfyUI, que mejora las capacidades de muestreo de un modelo al integrar técnicas de muestreo EDM (Modelos de Difusión Basados en Energía) continuas. Permite el ajuste dinámico de los niveles de ruido dentro del proceso de muestreo del modelo, ofreciendo un control más refinado sobre la calidad y diversidad de la generación.

Ver DocsMuestreo de Modelo Discreto

Aprende sobre el nodo Muestreo de Modelo Discreto en ComfyUI, que modifica el comportamiento de muestreo de un modelo aplicando una estrategia de muestreo discreto. Permite la selección de diferentes métodos de muestreo, como epsilon, v_prediction, lcm o x0, y ajusta opcionalmente la estrategia de reducción de ruido del modelo según la configuración del ratio de ruido cero disparo (zsnr).

Ver DocsEscalar CFG

Aprende sobre el nodo Escalar CFG en ComfyUI, que ajusta las escalas de condicionamiento y descondicionamiento de la salida de un modelo en función de un multiplicador especificado, con el objetivo de lograr un proceso de generación más equilibrado y controlado. Funciona reescalando la salida del modelo para modificar la influencia de los componentes condicionados y descondicionados, lo que potencialmente mejora el rendimiento o la calidad de salida del modelo.

Ver DocsGuardar Checkpoint

Aprende sobre el nodo Guardar Checkpoint en ComfyUI, diseñado para guardar el estado de varios componentes del modelo, incluyendo modelos, CLIP y VAE, en un archivo de checkpoint. Esta funcionalidad es crucial para preservar el progreso de entrenamiento o la configuración de los modelos para su uso posterior o para compartir.

Ver DocsFusión CLIP Simple

Aprende sobre el nodo Fusión CLIP Simple en ComfyUI, que se especializa en fusionar dos modelos CLIP basándose en una proporción especificada, combinando efectivamente sus características. Aplica selectivamente parches de un modelo a otro, excluyendo componentes específicos como los IDs de posición y la escala de logit, para crear un modelo híbrido que combina características de ambos modelos fuente.

Ver DocsGuardar CLIP

Aprende sobre el nodo Guardar CLIP en ComfyUI, diseñado para guardar modelos CLIP junto con información adicional como prompts y metadatos extra en PNG. Este nodo encapsula la funcionalidad para serializar y almacenar el estado del modelo, facilitando la preservación y el intercambio de configuraciones de modelos y sus prompts creativos asociados.

Ver DocsFusión de Modelos por Suma

Aprende sobre el nodo Fusión de Modelos por Suma en ComfyUI, diseñado para fusionar dos modelos añadiendo parches clave de un modelo a otro. Este proceso implica clonar el primer modelo y luego aplicar parches del segundo modelo, permitiendo la combinación de características o comportamientos de ambos modelos.

Ver DocsBloques de Fusión de Modelos

Aprende sobre el nodo ModelMergeBlocks en ComfyUI, diseñado para operaciones avanzadas de fusión de modelos, permitiendo la integración de dos modelos con proporciones de mezcla personalizables para diferentes partes de los modelos. Este nodo facilita la creación de modelos híbridos al fusionar selectivamente componentes de dos modelos fuente según parámetros especificados.

Ver DocsFusión de Modelos Simple

Aprende sobre el nodo ModelMergeSimple en ComfyUI, diseñado para fusionar dos modelos mediante la mezcla de sus parámetros según una proporción especificada. Este nodo facilita la creación de modelos híbridos que combinan las fortalezas o características de ambos modelos de entrada.

Ver DocsModel Merge Subtract

Aprende sobre el nodo `ModelMergeSubtract` en ComfyUI, diseñado para operaciones avanzadas de fusión de modelos, específicamente para restar los parámetros de un modelo de otro basado en un multiplicador especificado. Permite la personalización de los comportamientos del modelo ajustando la influencia de los parámetros de un modelo sobre otro, facilitando la creación de nuevos modelos híbridos.

Ver DocsVAE Save (Guardar VAE)

Aprende sobre el nodo VAESave en ComfyUI, diseñado para guardar modelos VAE junto con sus metadatos, incluyendo prompts e información adicional en PNG, en un directorio de salida especificado. Este nodo encapsula la funcionalidad para serializar el estado del modelo y la información asociada en un archivo, facilitando la preservación y el intercambio de modelos entrenados.

Ver DocsAcondicionamiento

Codificación de Texto CLIP SDXL

Aprende sobre el nodo de Codificación de Texto CLIP SDXL en ComfyUI, que codifica las entradas de texto utilizando modelos CLIP específicamente adaptados para la arquitectura SDXL, convirtiendo descripciones textuales en un formato adecuado para tareas de generación o manipulación de imágenes.

Ver DocsRefinador de Codificación de Texto CLIP SDXL

Aprende sobre el nodo Refinador de Codificación de Texto CLIP SDXL en ComfyUI, que refina la codificación de las entradas de texto utilizando modelos CLIP, mejorando el condicionamiento para tareas generativas al incorporar puntuaciones estéticas y dimensiones.

Ver DocsCLIP Text Encode Hunyuan DiT

Documentación del nodo CLIPTextEncodeHunyuanDiT de ComfyUI, incluyendo tipos de entrada/salida, métodos, introducción a BERT y mT5-XL, y consejos de uso.

Ver DocsRango de Tiempos de Ajuste de Condicionamiento

Aprende sobre el nodo Rango de Tiempos de Ajuste de Condicionamiento en ComfyUI, que ajusta el aspecto temporal del condicionamiento al establecer un rango específico de tiempos, permitiendo una generación más dirigida y eficiente.

Ver DocsCero de Condicionamiento

Aprende sobre el nodo Cero de Condicionamiento en ComfyUI, que anula elementos específicos dentro de la estructura de datos de condicionamiento, neutralizando efectivamente su influencia en los pasos de procesamiento posteriores.

Ver DocsExplicación del Nodo CLIPTextEncodeFlux para ComfyUI

Descubre las funcionalidades del nodo CLIPTextEncodeFlux en ComfyUI para la codificación avanzada de texto y la generación de imágenes condicionales.

Ver DocsFluxGuidance - Descripción de la funcionalidad del nodo ComfyUI

Aprende sobre el nodo FluxGuidance en ComfyUI, que controla la influencia de los mensajes de texto en la generación de imágenes.

Ver DocsCargadores

Cargador CLIP

Aprende sobre el nodo Cargador CLIP en ComfyUI, diseñado para cargar modelos CLIP, soportando diferentes tipos como difusión estable y cascada estable. Este nodo abstrae las complejidades de cargar y configurar modelos CLIP para su uso en diversas aplicaciones, proporcionando una forma simplificada de acceder a estos modelos con configuraciones específicas.

Ver DocsCargar Punto de Control con Configuración (DEPRECATED)

Aprende sobre el nodo Cargar Punto de Control con Configuración (DEPRECATED) en ComfyUI, diseñado para cargar puntos de control de modelos junto con sus configuraciones. Este nodo abstrae las complejidades de cargar y configurar puntos de control de modelos para su uso en diversas aplicaciones, proporcionando una forma simplificada de acceder a estos modelos con configuraciones específicas.

Ver DocsCargador de Difusores

Aprende sobre el nodo Cargador de Difusores en ComfyUI, diseñado para cargar modelos de la biblioteca de difusores, manejando específicamente la carga de modelos UNet, CLIP y VAE según las rutas de modelo proporcionadas. Facilita la integración de estos modelos en el marco de ComfyUI, habilitando funcionalidades avanzadas como la generación de imágenes a partir de texto, manipulación de imágenes y más.

Ver DocsCargador Dual CLIP - Cómo funciona y cómo usarlo.

Aprende sobre el nodo Cargador Dual CLIP en ComfyUI, que está diseñado para cargar dos modelos CLIP simultáneamente, facilitando operaciones que requieren la integración o comparación de características de ambos modelos.

Ver DocsQuadrupleCLIPLoader | Cargador QuadrupleCLIP - Nodo ComfyUI

El nodo QuadrupleCLIPLoader es uno de los nodos centrales de ComfyUI, que se agregó por primera vez para el soporte de la versión HiDream I1.

Ver DocsGuía del Cargador UNET | Cargar Modelo de Difusión - Documentación y Ejemplo

Aprende sobre el nodo Cargador UNET en ComfyUI, diseñado para cargar modelos U-Net por nombre, facilitando el uso de arquitecturas U-Net preentrenadas dentro del sistema.

Ver DocsModelo

Muestreo de Modelo Continuo EDM

Aprende sobre el nodo Muestreo de Modelo Continuo EDM en ComfyUI, que mejora las capacidades de muestreo de un modelo al integrar técnicas de muestreo EDM (Modelos de Difusión Basados en Energía) continuas. Permite el ajuste dinámico de los niveles de ruido dentro del proceso de muestreo del modelo, ofreciendo un control más refinado sobre la calidad y diversidad de la generación.

Ver DocsMuestreo de Modelo Discreto

Aprende sobre el nodo Muestreo de Modelo Discreto en ComfyUI, que modifica el comportamiento de muestreo de un modelo aplicando una estrategia de muestreo discreto. Permite la selección de diferentes métodos de muestreo, como epsilon, v_prediction, lcm o x0, y ajusta opcionalmente la estrategia de reducción de ruido del modelo según la configuración del ratio de ruido cero disparo (zsnr).

Ver DocsEscalar CFG

Aprende sobre el nodo Escalar CFG en ComfyUI, que ajusta las escalas de condicionamiento y descondicionamiento de la salida de un modelo en función de un multiplicador especificado, con el objetivo de lograr un proceso de generación más equilibrado y controlado. Funciona reescalando la salida del modelo para modificar la influencia de los componentes condicionados y descondicionados, lo que potencialmente mejora el rendimiento o la calidad de salida del modelo.

Ver DocsFusión de Modelos

Guardar Checkpoint

Aprende sobre el nodo Guardar Checkpoint en ComfyUI, diseñado para guardar el estado de varios componentes del modelo, incluyendo modelos, CLIP y VAE, en un archivo de checkpoint. Esta funcionalidad es crucial para preservar el progreso de entrenamiento o la configuración de los modelos para su uso posterior o para compartir.

Ver DocsFusión CLIP Simple

Aprende sobre el nodo Fusión CLIP Simple en ComfyUI, que se especializa en fusionar dos modelos CLIP basándose en una proporción especificada, combinando efectivamente sus características. Aplica selectivamente parches de un modelo a otro, excluyendo componentes específicos como los IDs de posición y la escala de logit, para crear un modelo híbrido que combina características de ambos modelos fuente.

Ver DocsGuardar CLIP

Aprende sobre el nodo Guardar CLIP en ComfyUI, diseñado para guardar modelos CLIP junto con información adicional como prompts y metadatos extra en PNG. Este nodo encapsula la funcionalidad para serializar y almacenar el estado del modelo, facilitando la preservación y el intercambio de configuraciones de modelos y sus prompts creativos asociados.

Ver DocsFusión de Modelos por Suma

Aprende sobre el nodo Fusión de Modelos por Suma en ComfyUI, diseñado para fusionar dos modelos añadiendo parches clave de un modelo a otro. Este proceso implica clonar el primer modelo y luego aplicar parches del segundo modelo, permitiendo la combinación de características o comportamientos de ambos modelos.

Ver DocsBloques de Fusión de Modelos

Aprende sobre el nodo ModelMergeBlocks en ComfyUI, diseñado para operaciones avanzadas de fusión de modelos, permitiendo la integración de dos modelos con proporciones de mezcla personalizables para diferentes partes de los modelos. Este nodo facilita la creación de modelos híbridos al fusionar selectivamente componentes de dos modelos fuente según parámetros especificados.

Ver DocsFusión de Modelos Simple

Aprende sobre el nodo ModelMergeSimple en ComfyUI, diseñado para fusionar dos modelos mediante la mezcla de sus parámetros según una proporción especificada. Este nodo facilita la creación de modelos híbridos que combinan las fortalezas o características de ambos modelos de entrada.

Ver DocsModel Merge Subtract

Aprende sobre el nodo `ModelMergeSubtract` en ComfyUI, diseñado para operaciones avanzadas de fusión de modelos, específicamente para restar los parámetros de un modelo de otro basado en un multiplicador especificado. Permite la personalización de los comportamientos del modelo ajustando la influencia de los parámetros de un modelo sobre otro, facilitando la creación de nuevos modelos híbridos.

Ver DocsVAE Save (Guardar VAE)

Aprende sobre el nodo VAESave en ComfyUI, diseñado para guardar modelos VAE junto con sus metadatos, incluyendo prompts e información adicional en PNG, en un directorio de salida especificado. Este nodo encapsula la funcionalidad para serializar el estado del modelo y la información asociada en un archivo, facilitando la preservación y el intercambio de modelos entrenados.

Ver DocsAcondicionamiento

Controla el proceso de generación

Stable Zero 123 Conditioning (Condicionamiento de Stable Zero 123)

Aprende sobre el nodo StableZero123_Conditioning en ComfyUI, diseñado para procesar información de condicionamiento específicamente adaptada para el modelo StableZero123. Se centra en preparar la entrada en un formato específico que es compatible y optimizado para estos modelos.

Ver DocsStable Zero 123 Conditioning Batched (Condicionamiento por Lotes de Stable Zero 123)

Aprende sobre el nodo StableZero123_Conditioning_Batched en ComfyUI, diseñado para procesar información de condicionamiento de manera por lotes, específicamente adaptado para el modelo StableZero123. Se centra en manejar eficientemente múltiples conjuntos de datos de condicionamiento simultáneamente, optimizando el flujo de trabajo para escenarios donde el procesamiento por lotes es crucial.

Ver DocsCLIP Set Last Layer (Capa Final de CLIP)

Aprende sobre el nodo CLIPSetLastLayer en ComfyUI, que está diseñado para modificar el comportamiento de un modelo CLIP al establecer una capa específica como la última en ejecutarse. Permite la personalización de la profundidad de procesamiento dentro del modelo CLIP, lo que puede afectar la salida del modelo al limitar la cantidad de información procesada.

Ver DocsCLIP Text Encode (Prompt)

Aprende sobre el nodo CLIPTextEncode en ComfyUI, que está diseñado para codificar entradas textuales utilizando un modelo CLIP, transformando el texto en una forma que puede ser utilizada para el condicionamiento en tareas generativas. Abstrae la complejidad de la tokenización y codificación de texto, proporcionando una interfaz simplificada para generar vectores de condicionamiento basados en texto.

Ver DocsCLIP Vision Encode (Codificación de Visión CLIP)

Aprende sobre el nodo CLIPVisionEncode en ComfyUI, que está diseñado para codificar imágenes utilizando un modelo de visión CLIP, transformando la entrada visual en un formato adecuado para un procesamiento o análisis posterior. Abstrae la complejidad de la codificación de imágenes, ofreciendo una interfaz simplificada para convertir imágenes en representaciones codificadas.

Ver DocsConditioning Average (Promedio de Condicionamiento)

Aprende sobre el nodo ConditioningAverage en ComfyUI, que está diseñado para mezclar dos conjuntos de datos de condicionamiento, aplicando un promedio ponderado basado en una fuerza especificada. Este proceso permite el ajuste dinámico de la influencia del condicionamiento, facilitando el ajuste fino del contenido o características generadas.

Ver DocsConditioning (Combine) (Condicionamiento Combinado)

Aprende sobre el nodo Conditioning(Combine) en ComfyUI, que está diseñado para fusionar dos conjuntos de datos de condicionamiento, combinando efectivamente su información. Proporciona una interfaz sencilla para integrar entradas de condicionamiento, permitiendo el ajuste dinámico del contenido o características generadas.

Ver DocsConditioning (Concat) (Condicionamiento Concatenado)

Aprende sobre el nodo Conditioning(Concat) en ComfyUI, que está diseñado para concatenar vectores de condicionamiento, fusionando efectivamente el vector 'conditioning_from' en el vector 'conditioning_to'. Proporciona una interfaz sencilla para integrar entradas de condicionamiento, permitiendo el ajuste dinámico del contenido o características generadas.

Ver DocsConditioning (Set Area) - Ajuste de Área

Aprende sobre el nodo Conditioning(SetArea) en ComfyUI, diseñado para modificar la información de condicionamiento estableciendo áreas específicas dentro del contexto de condicionamiento. Permite la manipulación espacial precisa de los elementos de condicionamiento, habilitando ajustes y mejoras dirigidas basadas en dimensiones y fuerza especificadas.

Ver DocsConditioning (Set Area with Percentage) - Condicionamiento (Establecer Área con Porcentaje)

Aprende sobre el nodo Conditioning(SetAreaWithPercentage) en ComfyUI, diseñado para ajustar el área de influencia de los elementos de condicionamiento basado en valores porcentuales. Permite especificar las dimensiones y la posición del área como porcentajes del tamaño total de la imagen, junto con un parámetro de fuerza para modular la intensidad del efecto de condicionamiento.

Ver DocsConditioning (Set Area Strength) - Ajuste de Fuerza de Área

Aprende sobre el nodo Conditioning(SetAreaStrength) en ComfyUI, diseñado para ajustar la fuerza de los elementos de acondicionamiento dentro de un área específica. Permite especificar las dimensiones y la posición del área como porcentajes del tamaño total de la imagen, junto con un parámetro de fuerza para modular la intensidad del efecto de acondicionamiento.

Ver DocsConditioning (Set Mask) - Ajuste de Máscara

Aprende sobre el nodo Conditioning(SetMask) en ComfyUI, diseñado para modificar la información de condicionamiento aplicando una máscara con una fuerza especificada a ciertas áreas. Permite ajustes dirigidos dentro del condicionamiento, habilitando un control más preciso sobre el proceso de generación.

Ver DocsApply ControlNet - Aplicar ControlNet

Aprende sobre el nodo ApplyControlNet en ComfyUI, diseñado para aplicar transformaciones de control net a los datos de acondicionamiento basados en una imagen y un modelo de control net. Permite ajustes precisos de la influencia del control net sobre el contenido generado, habilitando modificaciones más precisas y variadas al acondicionamiento.

Ver DocsApply ControlNet (Advanced) - Aplicar ControlNet (Avanzado)

Aprende sobre el nodo ApplyControlNet(Advanced) en ComfyUI, diseñado para aplicar transformaciones avanzadas de control net a los datos de acondicionamiento basados en una imagen y un modelo de control net. Permite ajustes precisos de la influencia del control net sobre el contenido generado, habilitando modificaciones más precisas y variadas al acondicionamiento.

Ver DocsGLIGEN Text Box Apply (Aplicación de Cuadro de Texto GLIGEN)

Aprende sobre el nodo GLIGENTextBoxApply en ComfyUI, que está diseñado para integrar la condicionamiento basado en texto en la entrada de un modelo generativo, específicamente aplicando parámetros de cuadro de texto y codificándolos utilizando un modelo CLIP. Este proceso enriquece la condicionamiento con información espacial y textual, facilitando una generación más precisa y consciente del contexto.

Ver DocsInpaint Model Conditioning (Condicionamiento del Modelo de Inpainting)

Aprende sobre el nodo InpaintModelConditioning en ComfyUI, que está diseñado para facilitar el proceso de condicionamiento para modelos de inpainting, permitiendo la integración y manipulación de diversas entradas de condicionamiento para personalizar la salida de inpainting. Abarca una amplia gama de funcionalidades, desde cargar puntos de control de modelos específicos y aplicar modelos de estilo o control, hasta codificar y combinar elementos de condicionamiento, sirviendo así como una herramienta integral para personalizar tareas de inpainting.

Ver DocsApply Style Model (Aplicar Modelo de Estilo)

Aprende sobre el nodo StyleModelApply en ComfyUI, que está diseñado para aplicar un modelo de estilo a una condición dada, mejorando o alterando su estilo basado en la salida de un modelo de visión CLIP. Integra la condición del modelo de estilo en la condición existente, permitiendo una fusión fluida de estilos en el proceso de generación.

Ver DocsunCLIP Conditioning (Condicionamiento unCLIP)

Aprende sobre el nodo unCLIPConditioning en ComfyUI, diseñado para integrar las salidas de visión CLIP en el proceso de condicionamiento, ajustando la influencia de estas salidas según los parámetros de fuerza y aumento de ruido especificados. Enriquece el condicionamiento con contexto visual, mejorando el proceso de generación.

Ver DocsSD_4X Upscale Conditioning (Condicionamiento de Aumento SD_4X)

Aprende sobre el nodo SD_4XUpscale_Conditioning en ComfyUI, que está diseñado para mejorar la resolución de las imágenes a través de un proceso de aumento de 4x, incorporando elementos de condicionamiento para refinar la salida. Aprovecha técnicas de difusión para aumentar la resolución de las imágenes, permitiendo ajustes en la relación de escala y la augmentación de ruido para afinar el proceso de mejora.

Ver DocsSVD img2vid Conditioning (Condicionamiento SVD img2vid)

Aprende sobre el nodo SVD_img2vid_Conditioning en ComfyUI, que está diseñado para generar datos de condicionamiento para tareas de generación de video, específicamente adaptado para su uso con modelos SVD_img2vid. Toma varias entradas, incluyendo imágenes iniciales, parámetros de video y un modelo VAE para producir datos de condicionamiento que pueden ser utilizados para guiar la generación de fotogramas de video.

Ver DocsNodo ComfyUI WanFunControlToVideo

Conozca el nodo WanFunControlToVideo en ComfyUI, diseñado para generar datos condicionales para tareas de generación de video, especialmente adecuado para su uso con el modelo Wan 2.1 Fun Control. Acepta diversas entradas, incluyendo imágenes iniciales, parámetros de video y modelos VAE, para generar datos condicionales que pueden guiar la generación de fotogramas de video.

Ver DocsModelos 3D

Stable Zero 123 Conditioning (Condicionamiento de Stable Zero 123)

Aprende sobre el nodo StableZero123_Conditioning en ComfyUI, diseñado para procesar información de condicionamiento específicamente adaptada para el modelo StableZero123. Se centra en preparar la entrada en un formato específico que es compatible y optimizado para estos modelos.

Ver DocsStable Zero 123 Conditioning Batched (Condicionamiento por Lotes de Stable Zero 123)

Aprende sobre el nodo StableZero123_Conditioning_Batched en ComfyUI, diseñado para procesar información de condicionamiento de manera por lotes, específicamente adaptado para el modelo StableZero123. Se centra en manejar eficientemente múltiples conjuntos de datos de condicionamiento simultáneamente, optimizando el flujo de trabajo para escenarios donde el procesamiento por lotes es crucial.

Ver DocsModelos de Video

SVD img2vid Conditioning (Condicionamiento SVD img2vid)

Aprende sobre el nodo SVD_img2vid_Conditioning en ComfyUI, que está diseñado para generar datos de condicionamiento para tareas de generación de video, específicamente adaptado para su uso con modelos SVD_img2vid. Toma varias entradas, incluyendo imágenes iniciales, parámetros de video y un modelo VAE para producir datos de condicionamiento que pueden ser utilizados para guiar la generación de fotogramas de video.

Ver DocsNodo ComfyUI WanFunControlToVideo

Conozca el nodo WanFunControlToVideo en ComfyUI, diseñado para generar datos condicionales para tareas de generación de video, especialmente adecuado para su uso con el modelo Wan 2.1 Fun Control. Acepta diversas entradas, incluyendo imágenes iniciales, parámetros de video y modelos VAE, para generar datos condicionales que pueden guiar la generación de fotogramas de video.

Ver DocsImagen

Procesamiento y manipulación de imágenes

Save Animated PNG - Guardar PNG Animado

Aprende sobre el nodo SaveAnimatedPNG en ComfyUI, diseñado para crear y guardar imágenes PNG animadas a partir de una secuencia de fotogramas. Maneja el ensamblaje de fotogramas individuales en una animación coherente, permitiendo la personalización de la duración de los fotogramas, el bucle y la inclusión de metadatos.

Ver DocsSave Animated WEBP (Guardar WEBP Animado)

Aprende sobre el nodo SaveAnimatedWEBP en ComfyUI, diseñado para guardar una secuencia de imágenes como un archivo WEBP animado. Maneja la agregación de fotogramas individuales en una animación cohesiva, aplicando metadatos especificados y optimizando la salida según la calidad y configuraciones de compresión.

Ver DocsImage From Batch (Imagen Desde Lote)

Aprende sobre el nodo ImageFromBatch en ComfyUI, diseñado para extraer un segmento específico de imágenes de un lote basado en el índice y la longitud proporcionados. Permite un control más granular sobre las imágenes en lotes, habilitando operaciones en imágenes individuales o subconjuntos dentro de un lote más grande.

Ver DocsRebatch Images (Reorganizar Imágenes)

Aprende sobre el nodo RebatchImages en ComfyUI, diseñado para reorganizar un lote de imágenes en una nueva configuración de lote, ajustando el tamaño del lote según lo especificado. Este proceso es esencial para gestionar y optimizar el procesamiento de datos de imágenes en operaciones por lotes, asegurando que las imágenes se agrupen según el tamaño de lote deseado para un manejo eficiente.

Ver DocsRepeat Image Batch (Repetir Lote de Imágenes)

Aprende sobre el nodo RepeatImageBatch en ComfyUI, diseñado para replicar una imagen dada un número específico de veces, creando un lote de imágenes idénticas. Esta funcionalidad es útil para operaciones que requieren múltiples instancias de la misma imagen, como el procesamiento por lotes o la ampliación de datos.

Ver DocsEmpty Image | Imagen Vacía

Aprende sobre el nodo EmptyImage en ComfyUI, diseñado para generar imágenes en blanco de dimensiones y color especificados. Permite la creación de imágenes de color uniforme que pueden servir como fondos o marcadores de posición en varias tareas de procesamiento de imágenes.

Ver DocsImage Batch | Lote de Imágenes

Aprende sobre el nodo ImageBatch en ComfyUI, diseñado para combinar dos imágenes en un solo lote. Si las dimensiones de las imágenes no coinciden, automáticamente redimensiona la segunda imagen para que coincida con las dimensiones de la primera antes de combinarlas.

Ver DocsImage Composite Masked | Composición de Imagen enmascarada

Aprende sobre el nodo ImageCompositeMasked en ComfyUI, diseñado para componer imágenes, permitiendo la superposición de una imagen fuente sobre una imagen de destino en coordenadas especificadas, con redimensionamiento y enmascaramiento opcionales.

Ver DocsInvert Image | Invertir Imagen

Aprende sobre el nodo ImageInvert en ComfyUI, diseñado para invertir los colores de una imagen, transformando efectivamente el valor de color de cada píxel a su color complementario en la rueda de colores. Esta operación es útil para crear imágenes negativas o para efectos visuales que requieren inversión de color.

Ver DocsImage Pad For Outpainting | Acolchado de Imagen para Extensión

Aprende sobre el nodo ImagePadForOutpaint en ComfyUI, diseñado para preparar imágenes para el proceso de extensión añadiendo acolchado alrededor de ellas. Ajusta las dimensiones de la imagen para asegurar la compatibilidad con los algoritmos de extensión, facilitando la generación de áreas de imagen extendidas más allá de los límites originales.

Ver DocsLoad Image | Cargar Imagen

Aprende sobre el nodo LoadImage en ComfyUI, diseñado para cargar y preprocesar imágenes desde una ruta especificada. Maneja formatos de imagen con múltiples fotogramas, aplica transformaciones necesarias como la rotación basada en datos EXIF, normaliza los valores de los píxeles y, opcionalmente, genera una máscara para imágenes con un canal alfa. Este nodo es esencial para preparar imágenes para un procesamiento o análisis posterior dentro de una tubería.

Ver DocsImage Blend (Mezcla de Imágenes)

Aprende sobre el nodo ImageBlend en ComfyUI, diseñado para mezclar dos imágenes juntas basándose en un modo de mezcla y un factor de mezcla especificados. Soporta varios modos de mezcla como normal, multiplicar, pantalla, superponer, luz suave y diferencia, permitiendo técnicas versátiles de manipulación y composición de imágenes. Este nodo es esencial para crear imágenes compuestas ajustando la interacción visual entre dos capas de imagen.

Ver DocsImage Blur (Desenfoque de Imagen)

Aprende sobre el nodo ImageBlur en ComfyUI, diseñado para aplicar un desenfoque gaussiano a una imagen, suavizando bordes y reduciendo detalles y ruido. Proporciona control sobre la intensidad y el alcance del desenfoque a través de parámetros.

Ver DocsImage Quantize (Cuantización de Imagen)

Aprende sobre el nodo ImageQuantize en ComfyUI, diseñado para reducir el número de colores en una imagen a un número especificado, aplicando opcionalmente técnicas de dithering para mantener la calidad visual. Este proceso es útil para crear imágenes basadas en paletas o reducir la complejidad de color para ciertas aplicaciones.

Ver DocsImage Sharpen (Afilado de Imagen)

Aprende sobre el nodo ImageSharpen en ComfyUI, diseñado para mejorar la claridad de una imagen acentuando sus bordes y detalles. Aplica un filtro de afilado a la imagen, que se puede ajustar en intensidad y radio, haciendo que la imagen parezca más definida y nítida.

Ver DocsCanny Node (Nodo Canny)

Aprende sobre el nodo Canny en ComfyUI, diseñado para la detección de bordes en imágenes, utilizando el algoritmo Canny para identificar y resaltar los bordes. Este proceso implica aplicar una serie de filtros a la imagen de entrada para detectar áreas de alto gradiente, que corresponden a bordes, mejorando así los detalles estructurales de la imagen.

Ver DocsPreview Image | Vista Previa de Imagen

Aprende sobre el nodo PreviewImage en ComfyUI, que está diseñado para crear imágenes de vista previa temporales. Genera automáticamente un nombre de archivo temporal único para cada imagen, comprime la imagen a un nivel especificado y la guarda en un directorio temporal. Esta funcionalidad es particularmente útil para generar vistas previas de imágenes durante el procesamiento sin afectar los archivos originales.

Ver DocsSave Image | Guardar Imagen - Guardar imágenes localmente en ComfyUI

Aprende sobre el nodo SaveImage en ComfyUI, diseñado para guardar imágenes en disco. Maneja el proceso de convertir datos de imagen de tensores a un formato de imagen adecuado, aplicando metadatos opcionales y escribiendo las imágenes en ubicaciones especificadas con niveles de compresión configurables.

Ver DocsImage Crop (Recorte de Imagen)

Aprende sobre el nodo ImageCrop en ComfyUI, diseñado para recortar imágenes a un ancho y alto especificados comenzando desde una coordenada x e y dada. Esta funcionalidad es esencial para enfocar regiones específicas de una imagen o para ajustar el tamaño de la imagen para cumplir con ciertos requisitos.

Ver DocsImage Scale (Escala de Imagen)

Aprende sobre el nodo ImageScale en ComfyUI, diseñado para redimensionar imágenes a dimensiones específicas, ofreciendo una selección de métodos de escalado y la capacidad de recortar la imagen redimensionada. Abstrae la complejidad del escalado y recorte de imágenes, proporcionando una interfaz sencilla para modificar las dimensiones de la imagen según los parámetros definidos por el usuario.

Ver DocsImage Scale By Node (Nodo Escalar Imagen Por)

Aprende sobre el nodo ImageScaleBy en ComfyUI, diseñado para escalar imágenes por un factor de escala especificado utilizando varios métodos de interpolación. Permite ajustar el tamaño de la imagen de manera flexible, adaptándose a diferentes necesidades de escalado.

Ver Docsimage-scale-to-total-pixels

Ver DocsImage Upscale With Model | Ampliar Imagen usando Modelo

Aprende sobre el nodo ImageUpscaleWithModel en ComfyUI, diseñado para ampliar imágenes utilizando un modelo de ampliación especificado. Maneja el proceso de ampliación ajustando la imagen al dispositivo adecuado, gestionando la memoria de manera eficiente y aplicando el modelo de ampliación de manera segmentada para evitar posibles errores de falta de memoria.

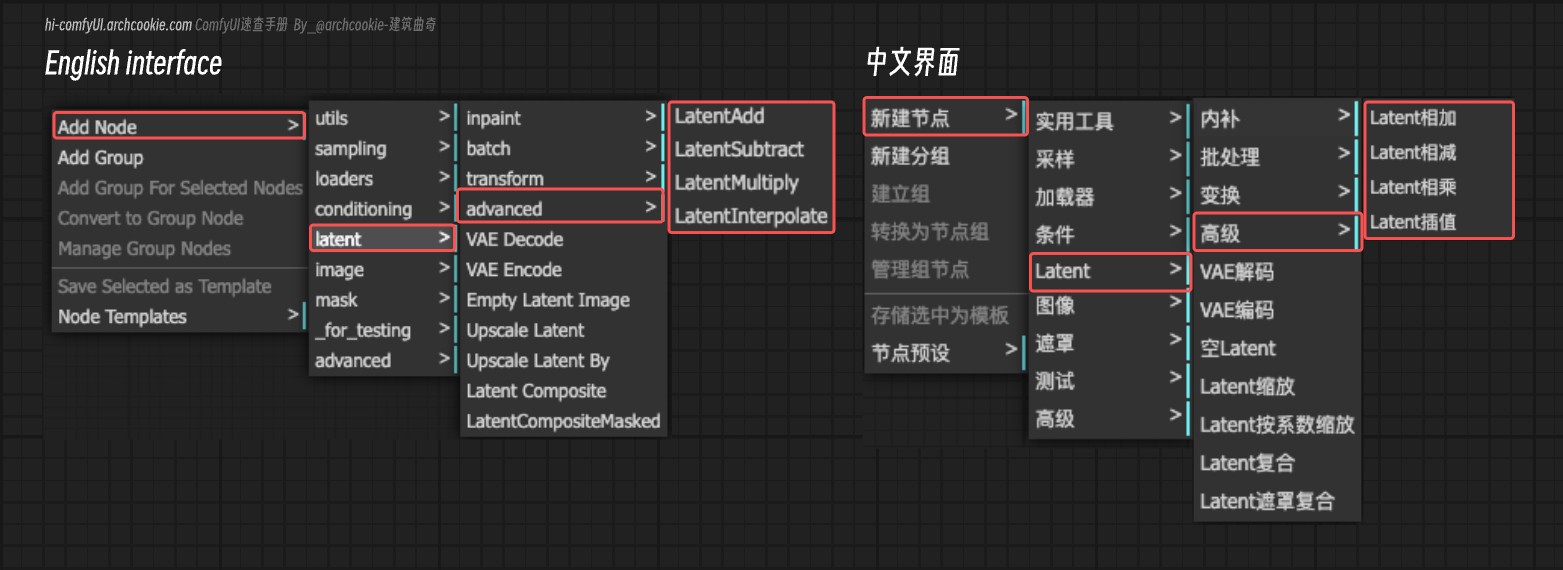

Ver DocsLatente

Operaciones en el espacio latente

Latent Upscale

Aprende sobre el nodo LatentUpscale en ComfyUI, diseñado para ampliar las representaciones latentes de imágenes. Permite ajustar las dimensiones de la imagen de salida y el método de ampliación, proporcionando flexibilidad en la mejora de la resolución de imágenes latentes.

Ver DocsEmpty Latent Image

Aprende sobre el nodo EmptyLatentImage en ComfyUI, diseñado para generar una representación de espacio latente en blanco con dimensiones y tamaño de lote especificados. Este nodo sirve como un paso fundamental en la generación o manipulación de imágenes en el espacio latente, proporcionando un punto de partida para procesos adicionales de síntesis o modificación de imágenes.

Ver DocsLatent Upscale By

Aprende sobre el nodo LatentUpscaleBy en ComfyUI, diseñado para ampliar las representaciones latentes de imágenes por un factor de escala especificado. Este nodo permite el ajuste del factor de escala y el método de ampliación, proporcionando flexibilidad en la mejora de la resolución de muestras latentes.

Ver DocsLatent Composite

Aprende sobre el nodo LatentComposite en ComfyUI, diseñado para mezclar o fusionar dos representaciones latentes en una sola salida. Este proceso es esencial para crear imágenes o características compuestas combinando las características de las latentes de entrada de manera controlada.

Ver DocsVAE Decode

Aprende sobre el nodo VAEDecode en ComfyUI, diseñado para decodificar representaciones latentes en imágenes utilizando un Autoencoder Variacional (VAE) especificado. Sirve para generar imágenes a partir de representaciones de datos comprimidos, facilitando la reconstrucción de imágenes desde sus codificaciones en el espacio latente.

Ver DocsVAE Encode

Aprende sobre el nodo VAEEncode en ComfyUI, diseñado para codificar imágenes en una representación de espacio latente utilizando un Autoencoder Variacional (VAE) especificado. Abstrae la complejidad del proceso de codificación, proporcionando una forma sencilla de transformar imágenes en sus representaciones latentes.

Ver DocsLatent Composite Masked

Aprende sobre el nodo LatentCompositeMasked en ComfyUI, diseñado para mezclar dos representaciones latentes en coordenadas especificadas, utilizando opcionalmente una máscara para una composición más controlada. Este nodo permite la creación de imágenes latentes complejas al superponer partes de una imagen sobre otra, con la capacidad de redimensionar la imagen fuente para un ajuste perfecto.

Ver DocsLatent Add | Latente Sumar

Aprende sobre el nodo LatentAdd en ComfyUI, diseñado para la suma de dos representaciones latentes. Facilita la combinación de características o propiedades codificadas en estas representaciones mediante la suma elemento a elemento.

Ver DocsLatent Batch Seed Behavior | Comportamiento de Semilla de Lote Latente

Aprende sobre el nodo LatentBatchSeedBehavior en ComfyUI, diseñado para modificar el comportamiento de la semilla de un lote de muestras latentes. Permite aleatorizar o fijar la semilla en todo el lote, influyendo así en el proceso de generación al introducir variabilidad o mantener la consistencia en los resultados generados.

Ver DocsLatent Interpolate | Interpolación Latente

Aprende sobre el nodo LatentInterpolate en ComfyUI, diseñado para realizar la interpolación entre dos conjuntos de muestras latentes basándose en una proporción especificada, combinando las características de ambos conjuntos para producir un nuevo conjunto intermedio de muestras latentes.

Ver DocsLatent Multiply | Multiplicación Latente

Aprende sobre el nodo LatentMultiply en ComfyUI, diseñado para escalar la representación latente de muestras mediante un multiplicador especificado, permitiendo el ajuste fino del contenido generado o la exploración de variaciones dentro de una dirección latente dada.

Ver DocsLatent Subtract | Resta Latente

Aprende sobre el nodo LatentSubtract en ComfyUI, diseñado para restar una representación latente de otra. Esta operación se puede utilizar para manipular o modificar las características de las salidas de modelos generativos eliminando efectivamente características o atributos representados en un espacio latente de otro.

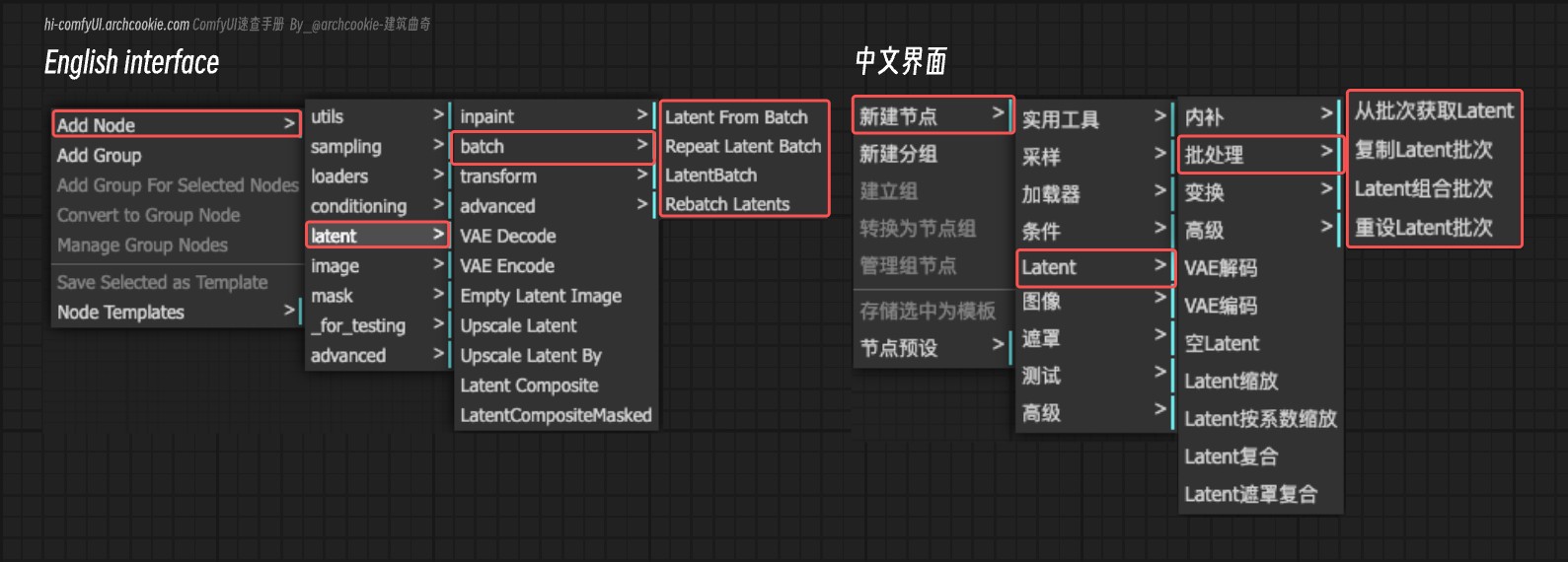

Ver DocsLatent Batch | Lote Latente

Aprende sobre el nodo LatentBatch en ComfyUI, diseñado para fusionar dos conjuntos de muestras latentes en un solo lote, potencialmente redimensionando un conjunto para que coincida con las dimensiones del otro antes de la concatenación. Esta operación facilita la combinación de diferentes representaciones latentes para tareas de procesamiento o generación adicionales.

Ver DocsLatent From Batch | Latente Desde Lote

Aprende sobre el nodo LatentFromBatch en ComfyUI, diseñado para extraer un subconjunto específico de muestras latentes de un lote dado basado en el índice de lote y la longitud especificados. Permite el procesamiento selectivo de muestras latentes, facilitando operaciones en segmentos más pequeños del lote para eficiencia o manipulación dirigida.

Ver DocsRebatch Latents | Reorganizar Latentes

Aprende sobre el nodo RebatchLatents en ComfyUI, diseñado para reorganizar un lote de representaciones latentes en una nueva configuración de lote, basado en un tamaño de lote especificado. Asegura que las muestras latentes se agrupen adecuadamente, manejando variaciones en dimensiones y tamaños, para facilitar un procesamiento o inferencia de modelo adicional.

Ver DocsRepeat Latent Batch | Repetir Lote Latente

Aprende sobre el nodo RepeatLatentBatch en ComfyUI, diseñado para replicar un lote dado de representaciones latentes un número específico de veces, potencialmente incluyendo datos adicionales como máscaras de ruido e índices de lote. Esta funcionalidad es crucial para operaciones que requieren múltiples instancias del mismo dato latente, como la augmentación de datos o tareas generativas específicas.

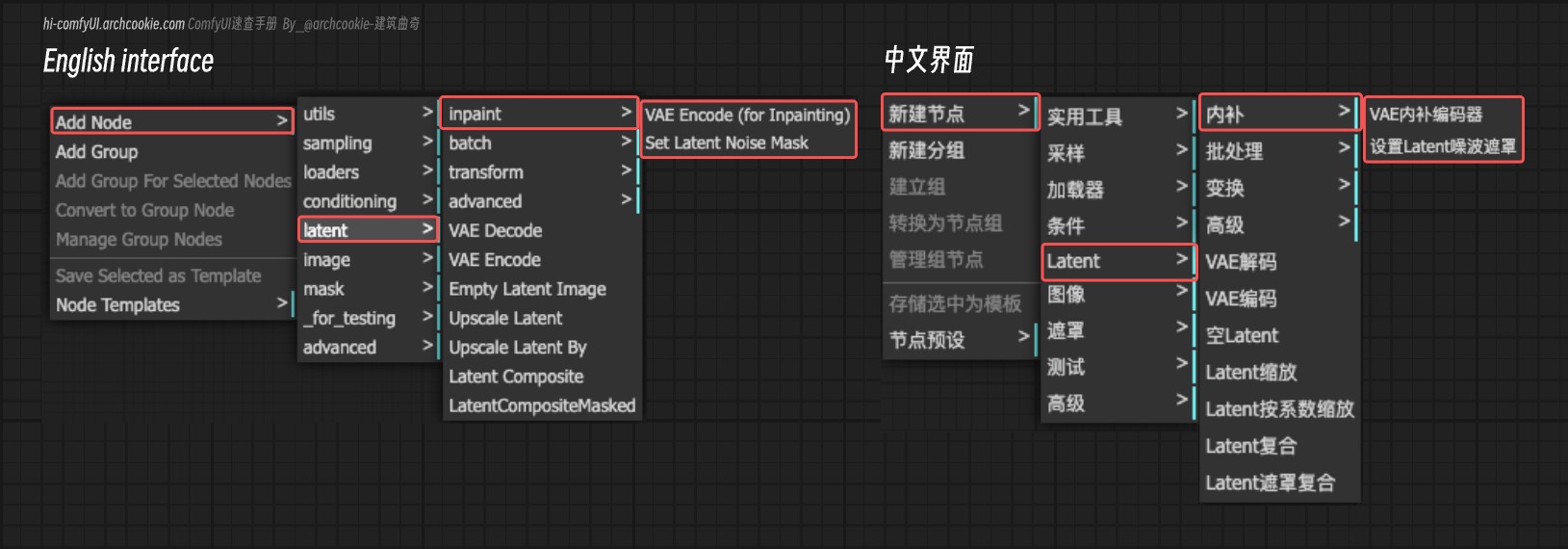

Ver DocsSet Latent Noise Mask | Establecer Máscara de Ruido Latente

Aprende sobre el nodo SetLatentNoiseMask en ComfyUI, diseñado para aplicar una máscara de ruido a un conjunto de muestras latentes. Modifica las muestras de entrada integrando una máscara especificada, alterando así sus características de ruido.

Ver DocsVAE Encode (for Inpainting) | Codificación VAE (para Relleno)

Aprende sobre el nodo VAEEncodeForInpaint en ComfyUI, diseñado para codificar imágenes en una representación latente adecuada para tareas de relleno, incorporando pasos de preprocesamiento adicionales para ajustar la imagen de entrada y la máscara para una codificación óptima por el modelo VAE.

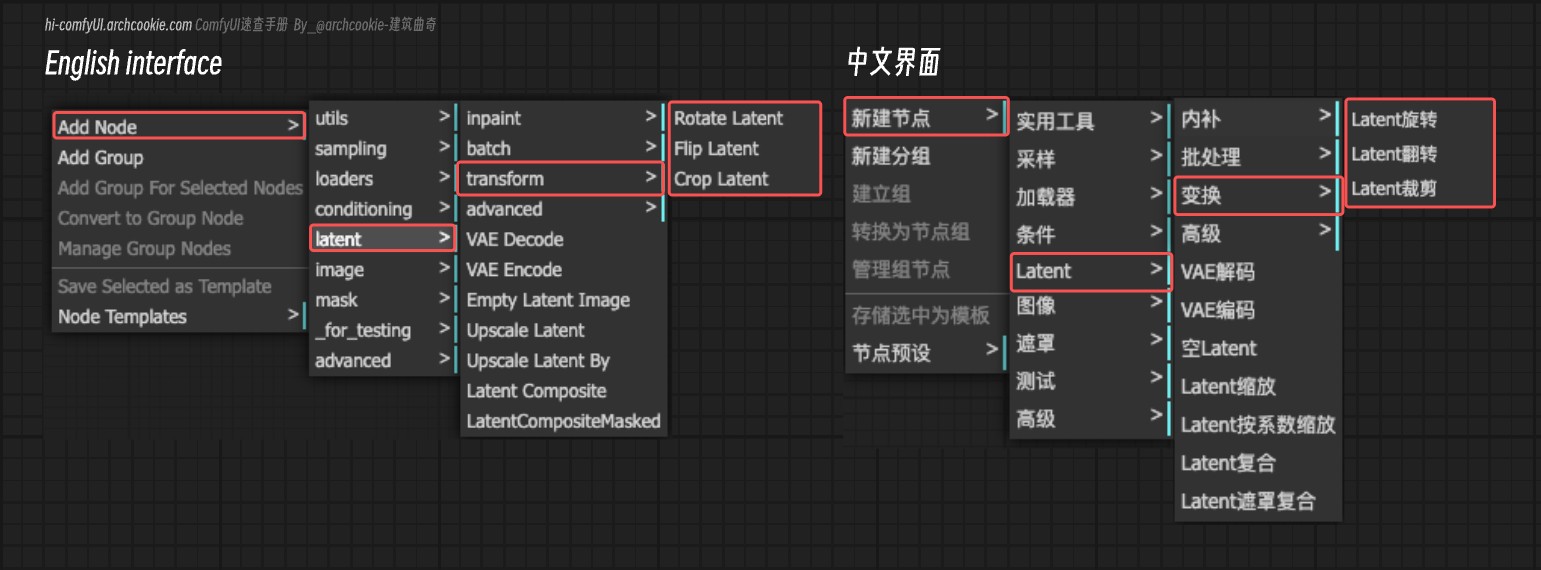

Ver DocsCrop Latent | Recortar Latente

Aprende sobre el nodo LatentCrop en ComfyUI, diseñado para realizar operaciones de recorte en representaciones latentes de imágenes. Permite especificar las dimensiones y la posición del recorte, habilitando modificaciones específicas del espacio latente.

Ver DocsFlip Latent | Voltear Latente

Aprende sobre el nodo LatentFlip en ComfyUI, diseñado para manipular representaciones latentes volteándolas vertical u horizontalmente. Esta operación permite la transformación del espacio latente, potencialmente descubriendo nuevas variaciones o perspectivas dentro de los datos.

Ver DocsRotate Latent | Rotar Latente

Aprende sobre el nodo LatentRotate en ComfyUI, diseñado para rotar representaciones latentes de imágenes por ángulos especificados. Abstrae la complejidad de manipular el espacio latente para lograr efectos de rotación, permitiendo a los usuarios transformar fácilmente imágenes en el espacio latente de un modelo generativo.

Ver DocsTutoriel du nœud Empty Hunyuan Latent Video

Découvrez les fonctionnalités, la configuration des paramètres et l'utilisation du nœud Empty Hunyuan Latent Video dans ComfyUI. Ce nœud crée des canevas vidéo latents vides pour la génération de vidéos utilisant le modèle vidéo Hunyuan de Tencent.

Ver DocsAvanzado

Latent Add | Latente Sumar

Aprende sobre el nodo LatentAdd en ComfyUI, diseñado para la suma de dos representaciones latentes. Facilita la combinación de características o propiedades codificadas en estas representaciones mediante la suma elemento a elemento.

Ver DocsLatent Batch Seed Behavior | Comportamiento de Semilla de Lote Latente

Aprende sobre el nodo LatentBatchSeedBehavior en ComfyUI, diseñado para modificar el comportamiento de la semilla de un lote de muestras latentes. Permite aleatorizar o fijar la semilla en todo el lote, influyendo así en el proceso de generación al introducir variabilidad o mantener la consistencia en los resultados generados.

Ver DocsLatent Interpolate | Interpolación Latente

Aprende sobre el nodo LatentInterpolate en ComfyUI, diseñado para realizar la interpolación entre dos conjuntos de muestras latentes basándose en una proporción especificada, combinando las características de ambos conjuntos para producir un nuevo conjunto intermedio de muestras latentes.

Ver DocsLatent Multiply | Multiplicación Latente

Aprende sobre el nodo LatentMultiply en ComfyUI, diseñado para escalar la representación latente de muestras mediante un multiplicador especificado, permitiendo el ajuste fino del contenido generado o la exploración de variaciones dentro de una dirección latente dada.

Ver DocsLatent Subtract | Resta Latente

Aprende sobre el nodo LatentSubtract en ComfyUI, diseñado para restar una representación latente de otra. Esta operación se puede utilizar para manipular o modificar las características de las salidas de modelos generativos eliminando efectivamente características o atributos representados en un espacio latente de otro.

Ver DocsLote

Latent Batch | Lote Latente

Aprende sobre el nodo LatentBatch en ComfyUI, diseñado para fusionar dos conjuntos de muestras latentes en un solo lote, potencialmente redimensionando un conjunto para que coincida con las dimensiones del otro antes de la concatenación. Esta operación facilita la combinación de diferentes representaciones latentes para tareas de procesamiento o generación adicionales.

Ver DocsLatent From Batch | Latente Desde Lote

Aprende sobre el nodo LatentFromBatch en ComfyUI, diseñado para extraer un subconjunto específico de muestras latentes de un lote dado basado en el índice de lote y la longitud especificados. Permite el procesamiento selectivo de muestras latentes, facilitando operaciones en segmentos más pequeños del lote para eficiencia o manipulación dirigida.

Ver DocsRebatch Latents | Reorganizar Latentes

Aprende sobre el nodo RebatchLatents en ComfyUI, diseñado para reorganizar un lote de representaciones latentes en una nueva configuración de lote, basado en un tamaño de lote especificado. Asegura que las muestras latentes se agrupen adecuadamente, manejando variaciones en dimensiones y tamaños, para facilitar un procesamiento o inferencia de modelo adicional.

Ver DocsRepeat Latent Batch | Repetir Lote Latente

Aprende sobre el nodo RepeatLatentBatch en ComfyUI, diseñado para replicar un lote dado de representaciones latentes un número específico de veces, potencialmente incluyendo datos adicionales como máscaras de ruido e índices de lote. Esta funcionalidad es crucial para operaciones que requieren múltiples instancias del mismo dato latente, como la augmentación de datos o tareas generativas específicas.

Ver DocsInpintado

Set Latent Noise Mask | Establecer Máscara de Ruido Latente

Aprende sobre el nodo SetLatentNoiseMask en ComfyUI, diseñado para aplicar una máscara de ruido a un conjunto de muestras latentes. Modifica las muestras de entrada integrando una máscara especificada, alterando así sus características de ruido.

Ver DocsVAE Encode (for Inpainting) | Codificación VAE (para Relleno)

Aprende sobre el nodo VAEEncodeForInpaint en ComfyUI, diseñado para codificar imágenes en una representación latente adecuada para tareas de relleno, incorporando pasos de preprocesamiento adicionales para ajustar la imagen de entrada y la máscara para una codificación óptima por el modelo VAE.

Ver DocsTransformación

Crop Latent | Recortar Latente

Aprende sobre el nodo LatentCrop en ComfyUI, diseñado para realizar operaciones de recorte en representaciones latentes de imágenes. Permite especificar las dimensiones y la posición del recorte, habilitando modificaciones específicas del espacio latente.

Ver DocsFlip Latent | Voltear Latente

Aprende sobre el nodo LatentFlip en ComfyUI, diseñado para manipular representaciones latentes volteándolas vertical u horizontalmente. Esta operación permite la transformación del espacio latente, potencialmente descubriendo nuevas variaciones o perspectivas dentro de los datos.

Ver DocsRotate Latent | Rotar Latente

Aprende sobre el nodo LatentRotate en ComfyUI, diseñado para rotar representaciones latentes de imágenes por ángulos especificados. Abstrae la complejidad de manipular el espacio latente para lograr efectos de rotación, permitiendo a los usuarios transformar fácilmente imágenes en el espacio latente de un modelo generativo.

Ver DocsCargadores

Carga de varios modelos y recursos

Checkpoint Loader (Simple) | Cargador de Checkpoint (Simple)

Aprende sobre el nodo CheckpointLoaderSimple en ComfyUI, diseñado para cargar checkpoints de modelos sin necesidad de especificar una configuración. Simplifica el proceso de carga de checkpoints al requerir solo el nombre del checkpoint, haciéndolo más accesible para usuarios que pueden no estar familiarizados con los detalles de configuración.

Ver DocsCLIP Vision Loader | Cargador de Visión CLIP

Aprende sobre el nodo CLIPVisionLoader en ComfyUI, diseñado para cargar modelos de Visión CLIP desde rutas especificadas. Abstrae las complejidades de localizar e inicializar modelos de Visión CLIP, haciéndolos fácilmente disponibles para tareas de procesamiento o inferencia adicionales.

Ver DocsControlNet Loader | Cargador de ControlNet

Aprende sobre el nodo ControlNetLoader en ComfyUI, diseñado para cargar modelos ControlNet desde rutas especificadas. Abstrae las complejidades de localizar e inicializar modelos ControlNet, haciéndolos fácilmente disponibles para tareas de procesamiento o inferencia adicionales.

Ver DocsDiff ControlNet Loader | Cargador de ControlNet Diferencial

Aprende sobre el nodo DiffControlNetLoader en ComfyUI, diseñado para cargar redes de control diferenciales desde rutas especificadas. Abstrae las complejidades de localizar e inicializar redes de control diferenciales, haciéndolas fácilmente disponibles para tareas de procesamiento o inferencia adicionales.

Ver DocsGLIGEN Loader | Cargador de GLIGEN

Aprende sobre el nodo GLIGENLoader en ComfyUI, diseñado para cargar modelos GLIGEN desde rutas especificadas. Abstrae las complejidades de localizar e inicializar modelos GLIGEN, haciéndolos fácilmente disponibles para tareas de procesamiento o inferencia adicionales.

Ver DocsHypernetwork Loader | Cargador de Hypernetwork

Aprende sobre el nodo HypernetworkLoader en ComfyUI, diseñado para cargar hypernetworks desde rutas especificadas. Abstrae las complejidades de localizar e inicializar hypernetworks, haciéndolos fácilmente disponibles para tareas de procesamiento o inferencia adicionales.

Ver DocsLora Loader - Documentación del Nodo ComfyUI

Este nodo está diseñado para cargar y aplicar dinámicamente ajustes LoRA (Adaptación de Bajo Rango) a modelos e instancias CLIP basándose en intensidades y nombres de archivo LoRA especificados. Facilita la personalización de modelos pre-entrenados aplicando ajustes finos sin alterar directamente los pesos del modelo original.

Ver DocsLora Loader Model Only | Cargador de Lora Solo Modelo

Learn about the LoraLoaderModelOnly node in ComfyUI, which is designed to load LoRA models without requiring a CLIP model, focusing on enhancing or modifying a given model based on LoRA parameters. It allows for the dynamic adjustment of the model's strength through LoRA parameters, facilitating fine-tuned control over the model's behavior.

Ver DocsStyle Model Loader | Cargador de Modelo de Estilo

Aprende sobre el nodo StyleModelLoader en ComfyUI, diseñado para cargar modelos de estilo desde rutas especificadas. Abstrae las complejidades de localizar e inicializar modelos de estilo, haciéndolos fácilmente disponibles para tareas de procesamiento o inferencia.

Ver DocsunCLIP Checkpoint Loader | Cargador de Checkpoint unCLIP

Aprende sobre el nodo unCLIPCheckpointLoader en ComfyUI, diseñado para cargar checkpoints específicamente adaptados para modelos unCLIP. Facilita la recuperación e inicialización de modelos, módulos de visión CLIP y VAEs desde un checkpoint especificado, agilizando el proceso de configuración para operaciones o análisis posteriores.

Ver DocsUpscale Model Loader | Cargador de Modelo de Escalado

Aprende sobre el nodo UpscaleModelLoader en ComfyUI, diseñado para cargar modelos de escalado desde rutas especificadas. Abstrae las complejidades de localizar e inicializar modelos de escalado, haciéndolos fácilmente disponibles para tareas de procesamiento o inferencia.

Ver DocsVAE Loader | Cargador de VAE

Aprende sobre el nodo VAELoader en ComfyUI, diseñado para cargar modelos de Autoencoder Variacional (VAE), específicamente adaptados para manejar tanto VAEs estándar como aproximados. Soporta la carga de VAEs por nombre, incluyendo un manejo especializado para los modelos 'taesd' y 'taesdxl', y se ajusta dinámicamente según la configuración específica del VAE.

Ver DocsImage Only Checkpoint Loader (img2vid model) | Cargador de Checkpoint Solo Imagen (modelo img2vid)

Aprende sobre el nodo ImageOnlyCheckpointLoader en ComfyUI, diseñado para cargar checkpoints específicamente para modelos basados en imágenes dentro de flujos de trabajo de generación de video. Recupera y configura eficientemente los componentes necesarios de un checkpoint dado, centrándose en los aspectos relacionados con la imagen del modelo.

Ver DocsMáscara

Creación y manipulación de máscaras

Join Image with Alpha | Unir Imagen con Alpha

Ver DocsPorter-Duff Image Composite | Composición de Imagen Porter-Duff

El nodo PorterDuffImageComposite está diseñado para realizar la composición de imágenes utilizando los operadores de composición Porter-Duff. Permite la combinación de imágenes de origen y destino según varios modos de mezcla, habilitando la creación de efectos visuales complejos al manipular la transparencia de las imágenes y superponer imágenes de manera creativa.

Ver DocsSplit Image with Alpha | Separar Imagen con Alpha

El nodo SplitImageWithAlpha está diseñado para separar los componentes de color y alfa de una imagen. Procesa un tensor de imagen de entrada, extrayendo los canales RGB como el componente de color y el canal alfa como el componente de transparencia, facilitando operaciones que requieren la manipulación de estos aspectos distintos de la imagen.

Ver DocsCrop Mask | Recorte de Máscara

El nodo CropMask está diseñado para recortar un área específica de una máscara dada. Permite a los usuarios definir la región de interés especificando coordenadas y dimensiones, extrayendo efectivamente una porción de la máscara para su posterior procesamiento o análisis.

Ver DocsFeather Mask | Máscara de Desvanecimiento

El nodo FeatherMask está diseñado para aplicar un efecto de desvanecimiento a los bordes de una máscara dada, haciendo una transición suave de los bordes de la máscara al ajustar su opacidad según las distancias especificadas desde cada borde. Esto crea un efecto de borde más suave y difuminado.

Ver DocsGrow Mask | Crecer Máscara

El nodo GrowMask está diseñado para modificar el tamaño de una máscara dada, ya sea expandiéndola o contrayéndola, mientras opcionalmente aplica un efecto de afinado a las esquinas. Esta funcionalidad es crucial para ajustar dinámicamente los límites de la máscara en tareas de procesamiento de imágenes, permitiendo un control más flexible y preciso sobre el área de interés.

Ver DocsImage Color To Mask | Imagen Color A Máscara

El nodo ImageColorToMask está diseñado para convertir un color especificado en una imagen a una máscara. Procesa una imagen y un color objetivo, generando una máscara donde el color especificado está resaltado, facilitando operaciones como la segmentación basada en color o la aislamiento de objetos.

Ver DocsImage To Mask | Imagen a Máscara

El nodo ImageToMask está diseñado para convertir una imagen en una máscara basada en un canal de color especificado. Permite la extracción de capas de máscara correspondientes a los canales rojo, verde, azul o alfa de una imagen, facilitando operaciones que requieren enmascaramiento o procesamiento específico de canales.

Ver DocsInvert Mask | Invertir Máscara

El nodo InvertMask está diseñado para invertir los valores de una máscara dada, invirtiendo efectivamente las áreas enmascaradas y no enmascaradas. Esta operación es fundamental en tareas de procesamiento de imágenes donde el foco de interés necesita cambiarse entre el primer plano y el fondo.

Ver DocsLoad Image (as Mask) | Cargar Imagen (como Máscara)

El nodo LoadImageMask está diseñado para cargar imágenes y sus máscaras asociadas desde una ruta especificada, procesándolas para asegurar su compatibilidad con tareas posteriores de manipulación o análisis de imágenes. Se centra en manejar varios formatos de imagen y condiciones, como la presencia de un canal alfa para máscaras, y prepara las imágenes y máscaras para el procesamiento posterior convirtiéndolas a un formato estandarizado.

Ver DocsMask Composite | Composición de Máscara

El nodo MaskComposite está diseñado para combinar dos entradas de máscara a través de una variedad de operaciones como adición, sustracción y operaciones lógicas, para producir una nueva máscara modificada. Maneja abstractamente la manipulación de datos de máscara para lograr efectos de enmascaramiento complejos, sirviendo como un componente crucial en flujos de trabajo de edición y procesamiento de imágenes basados en máscaras.

Ver DocsMask To Image | Máscara a Imagen

El nodo MaskToImage está diseñado para convertir una máscara en un formato de imagen. Esta transformación permite la visualización y el procesamiento adicional de máscaras como imágenes, facilitando un puente entre las operaciones basadas en máscaras y las aplicaciones basadas en imágenes.

Ver DocsSolid Mask | Máscara Sólida

El nodo SolidMask genera una máscara uniforme con un valor especificado en toda su área. Está diseñado para crear máscaras de dimensiones e intensidad específicas, útiles en diversas tareas de procesamiento de imágenes y enmascaramiento.

Ver DocsComposición

Join Image with Alpha | Unir Imagen con Alpha

Ver DocsPorter-Duff Image Composite | Composición de Imagen Porter-Duff

El nodo PorterDuffImageComposite está diseñado para realizar la composición de imágenes utilizando los operadores de composición Porter-Duff. Permite la combinación de imágenes de origen y destino según varios modos de mezcla, habilitando la creación de efectos visuales complejos al manipular la transparencia de las imágenes y superponer imágenes de manera creativa.

Ver DocsSplit Image with Alpha | Separar Imagen con Alpha

El nodo SplitImageWithAlpha está diseñado para separar los componentes de color y alfa de una imagen. Procesa un tensor de imagen de entrada, extrayendo los canales RGB como el componente de color y el canal alfa como el componente de transparencia, facilitando operaciones que requieren la manipulación de estos aspectos distintos de la imagen.

Ver DocsMuestreo

En la Difusión Estable, el papel de un muestreador es iterativamente denoizar una imagen de ruido dada (imagen del espacio latente) para producir una imagen clara. Este proceso se realiza a través de pasos iterativos, cada uno haciendo que la imagen sea más clara hasta alcanzar la calidad deseada o el número predeterminado de iteraciones.

SamplerCustom | Muestrador Personalizado

El nodo SamplerCustom está diseñado para proporcionar un mecanismo de muestreo flexible y personalizable para diversas aplicaciones. Permite a los usuarios seleccionar y configurar diferentes estrategias de muestreo adaptadas a sus necesidades específicas, mejorando la adaptabilidad y eficiencia del proceso de muestreo.

Ver DocsKSampler Select | Selección de KSampler

El nodo KSamplerSelect está diseñado para seleccionar un sampler específico basado en el nombre del sampler proporcionado. Abstrae la complejidad de la selección de samplers, permitiendo a los usuarios cambiar fácilmente entre diferentes estrategias de muestreo para sus tareas.

Ver DocsSampler DPMPP_2M_SDE | Muestrador DPMPP_2M_SDE

El nodo SamplerDPMPP_2M_SDE está diseñado para generar un muestrador para el modelo DPMPP_2M_SDE, permitiendo la creación de muestras basadas en tipos de solucionadores especificados, niveles de ruido y preferencias de dispositivo computacional. Abstrae las complejidades de la configuración del muestrador, proporcionando una interfaz simplificada para generar muestras con configuraciones personalizadas.

Ver DocsSampler DPMPP_SDE | Muestrador DPMPP_SDE

El nodo SamplerDPMPP_SDE está diseñado para generar un muestrador para el modelo DPMPP_SDE, permitiendo la creación de muestras basadas en tipos de solucionadores especificados, niveles de ruido y preferencias de dispositivo computacional. Abstrae las complejidades de la configuración del muestrador, proporcionando una interfaz simplificada para generar muestras con configuraciones personalizadas.

Ver DocsBasic Scheduler | Programador Básico

El nodo BasicScheduler está diseñado para calcular una secuencia de valores sigma para modelos de difusión basados en el programador, modelo y parámetros de reducción de ruido proporcionados. Ajusta dinámicamente el número total de pasos según el factor de reducción de ruido para afinar el proceso de difusión.

Ver DocsExponential Scheduler | Programador Exponencial

El nodo ExponentialScheduler está diseñado para generar una secuencia de valores sigma siguiendo un programa exponencial para procesos de muestreo de difusión. Proporciona un enfoque personalizable para controlar los niveles de ruido aplicados en cada paso del proceso de difusión, permitiendo un ajuste fino del comportamiento de muestreo.

Ver DocsKarras Scheduler | Programador de Karras

El nodo KarrasScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en el programa de ruido de Karras et al. (2022). Este programador es útil para controlar el proceso de difusión en modelos generativos, permitiendo ajustes finos a los niveles de ruido aplicados en cada paso del proceso de generación.

Ver DocsPolyexponential Scheduler | Programador Poliexponencial

El nodo PolyexponentialScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en un programa de ruido poliexponencial. Este programa es una función polinómica en el logaritmo de sigma, permitiendo una progresión flexible y personalizable de los niveles de ruido a lo largo del proceso de difusión.

Ver DocsSD Turbo Scheduler | Programador Turbo SD

El nodo SDTurboScheduler está diseñado para generar una secuencia de valores sigma para el muestreo de imágenes, ajustando la secuencia según el nivel de reducción de ruido y el número de pasos especificados. Aprovecha las capacidades de muestreo de un modelo específico para producir estos valores sigma, que son cruciales para controlar el proceso de reducción de ruido durante la generación de imágenes.

Ver DocsVP Scheduler | Programador VP

El nodo VPScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en el método de programación de Preservación de Varianza (VP). Esta secuencia es crucial para guiar el proceso de eliminación de ruido en modelos de difusión, permitiendo la generación controlada de imágenes u otros tipos de datos.

Ver DocsFlip Sigmas | Invertir Sigmas

El nodo FlipSigmas está diseñado para manipular la secuencia de valores sigma utilizados en modelos de difusión invirtiendo su orden y asegurando que el primer valor no sea cero si originalmente lo era. Esta operación es crucial para adaptar los niveles de ruido en orden inverso, facilitando el proceso de generación en modelos que operan reduciendo gradualmente el ruido de los datos.

Ver DocsSplit Sigmas | Dividir Sigmas

El nodo SplitSigmas está diseñado para dividir una secuencia de valores sigma en dos partes basándose en un paso especificado. Esta funcionalidad es crucial para operaciones que requieren un manejo o procesamiento diferente de las partes inicial y subsecuente de la secuencia de sigma, permitiendo una manipulación más flexible y dirigida de estos valores.

Ver DocsKSampler | KSampler

El nodo KSampler está diseñado para proporcionar un mecanismo básico de muestreo para diversas aplicaciones. Permite a los usuarios seleccionar y configurar diferentes estrategias de muestreo adaptadas a sus necesidades específicas, mejorando la adaptabilidad y eficiencia del proceso de muestreo.

Ver DocsKSampler (Advanced) | KSampler (Avanzado)

El nodo KSamplerAdvanced está diseñado para mejorar el proceso de muestreo proporcionando configuraciones y técnicas avanzadas. Su objetivo es ofrecer opciones más sofisticadas para generar muestras a partir de un modelo, mejorando las funcionalidades básicas de KSampler.

Ver DocsSampler | Muestrador

El nodo Sampler está diseñado para proporcionar un mecanismo básico de muestreo para diversas aplicaciones. Permite a los usuarios seleccionar y configurar diferentes estrategias de muestreo adaptadas a sus necesidades específicas, mejorando la adaptabilidad y eficiencia del proceso de muestreo.

Ver DocsVideo Linear CFG Guidance | Guía CFG Lineal de Video

El nodo VideoLinearCFGGuidance aplica una escala de guía de condicionamiento lineal a un modelo de video, ajustando la influencia de los componentes condicionados y no condicionados en un rango especificado. Esto permite un control dinámico sobre el proceso de generación, permitiendo un ajuste fino de la salida del modelo basado en el nivel deseado de condicionamiento.

Ver DocsMuestreo Personalizado

SamplerCustom | Muestrador Personalizado

El nodo SamplerCustom está diseñado para proporcionar un mecanismo de muestreo flexible y personalizable para diversas aplicaciones. Permite a los usuarios seleccionar y configurar diferentes estrategias de muestreo adaptadas a sus necesidades específicas, mejorando la adaptabilidad y eficiencia del proceso de muestreo.

Ver DocsKSampler Select | Selección de KSampler

El nodo KSamplerSelect está diseñado para seleccionar un sampler específico basado en el nombre del sampler proporcionado. Abstrae la complejidad de la selección de samplers, permitiendo a los usuarios cambiar fácilmente entre diferentes estrategias de muestreo para sus tareas.

Ver DocsSampler DPMPP_2M_SDE | Muestrador DPMPP_2M_SDE

El nodo SamplerDPMPP_2M_SDE está diseñado para generar un muestrador para el modelo DPMPP_2M_SDE, permitiendo la creación de muestras basadas en tipos de solucionadores especificados, niveles de ruido y preferencias de dispositivo computacional. Abstrae las complejidades de la configuración del muestrador, proporcionando una interfaz simplificada para generar muestras con configuraciones personalizadas.

Ver DocsSampler DPMPP_SDE | Muestrador DPMPP_SDE

El nodo SamplerDPMPP_SDE está diseñado para generar un muestrador para el modelo DPMPP_SDE, permitiendo la creación de muestras basadas en tipos de solucionadores especificados, niveles de ruido y preferencias de dispositivo computacional. Abstrae las complejidades de la configuración del muestrador, proporcionando una interfaz simplificada para generar muestras con configuraciones personalizadas.

Ver DocsBasic Scheduler | Programador Básico

El nodo BasicScheduler está diseñado para calcular una secuencia de valores sigma para modelos de difusión basados en el programador, modelo y parámetros de reducción de ruido proporcionados. Ajusta dinámicamente el número total de pasos según el factor de reducción de ruido para afinar el proceso de difusión.

Ver DocsExponential Scheduler | Programador Exponencial

El nodo ExponentialScheduler está diseñado para generar una secuencia de valores sigma siguiendo un programa exponencial para procesos de muestreo de difusión. Proporciona un enfoque personalizable para controlar los niveles de ruido aplicados en cada paso del proceso de difusión, permitiendo un ajuste fino del comportamiento de muestreo.

Ver DocsKarras Scheduler | Programador de Karras

El nodo KarrasScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en el programa de ruido de Karras et al. (2022). Este programador es útil para controlar el proceso de difusión en modelos generativos, permitiendo ajustes finos a los niveles de ruido aplicados en cada paso del proceso de generación.

Ver DocsPolyexponential Scheduler | Programador Poliexponencial

El nodo PolyexponentialScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en un programa de ruido poliexponencial. Este programa es una función polinómica en el logaritmo de sigma, permitiendo una progresión flexible y personalizable de los niveles de ruido a lo largo del proceso de difusión.

Ver DocsSD Turbo Scheduler | Programador Turbo SD

El nodo SDTurboScheduler está diseñado para generar una secuencia de valores sigma para el muestreo de imágenes, ajustando la secuencia según el nivel de reducción de ruido y el número de pasos especificados. Aprovecha las capacidades de muestreo de un modelo específico para producir estos valores sigma, que son cruciales para controlar el proceso de reducción de ruido durante la generación de imágenes.

Ver DocsVP Scheduler | Programador VP

El nodo VPScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en el método de programación de Preservación de Varianza (VP). Esta secuencia es crucial para guiar el proceso de eliminación de ruido en modelos de difusión, permitiendo la generación controlada de imágenes u otros tipos de datos.

Ver DocsFlip Sigmas | Invertir Sigmas

El nodo FlipSigmas está diseñado para manipular la secuencia de valores sigma utilizados en modelos de difusión invirtiendo su orden y asegurando que el primer valor no sea cero si originalmente lo era. Esta operación es crucial para adaptar los niveles de ruido en orden inverso, facilitando el proceso de generación en modelos que operan reduciendo gradualmente el ruido de los datos.

Ver DocsSplit Sigmas | Dividir Sigmas

El nodo SplitSigmas está diseñado para dividir una secuencia de valores sigma en dos partes basándose en un paso especificado. Esta funcionalidad es crucial para operaciones que requieren un manejo o procesamiento diferente de las partes inicial y subsecuente de la secuencia de sigma, permitiendo una manipulación más flexible y dirigida de estos valores.

Ver DocsMuestreadores

KSampler Select | Selección de KSampler

El nodo KSamplerSelect está diseñado para seleccionar un sampler específico basado en el nombre del sampler proporcionado. Abstrae la complejidad de la selección de samplers, permitiendo a los usuarios cambiar fácilmente entre diferentes estrategias de muestreo para sus tareas.

Ver DocsSampler DPMPP_2M_SDE | Muestrador DPMPP_2M_SDE

El nodo SamplerDPMPP_2M_SDE está diseñado para generar un muestrador para el modelo DPMPP_2M_SDE, permitiendo la creación de muestras basadas en tipos de solucionadores especificados, niveles de ruido y preferencias de dispositivo computacional. Abstrae las complejidades de la configuración del muestrador, proporcionando una interfaz simplificada para generar muestras con configuraciones personalizadas.

Ver DocsSampler DPMPP_SDE | Muestrador DPMPP_SDE

El nodo SamplerDPMPP_SDE está diseñado para generar un muestrador para el modelo DPMPP_SDE, permitiendo la creación de muestras basadas en tipos de solucionadores especificados, niveles de ruido y preferencias de dispositivo computacional. Abstrae las complejidades de la configuración del muestrador, proporcionando una interfaz simplificada para generar muestras con configuraciones personalizadas.

Ver DocsProgramadores

Basic Scheduler | Programador Básico

El nodo BasicScheduler está diseñado para calcular una secuencia de valores sigma para modelos de difusión basados en el programador, modelo y parámetros de reducción de ruido proporcionados. Ajusta dinámicamente el número total de pasos según el factor de reducción de ruido para afinar el proceso de difusión.

Ver DocsExponential Scheduler | Programador Exponencial

El nodo ExponentialScheduler está diseñado para generar una secuencia de valores sigma siguiendo un programa exponencial para procesos de muestreo de difusión. Proporciona un enfoque personalizable para controlar los niveles de ruido aplicados en cada paso del proceso de difusión, permitiendo un ajuste fino del comportamiento de muestreo.

Ver DocsKarras Scheduler | Programador de Karras

El nodo KarrasScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en el programa de ruido de Karras et al. (2022). Este programador es útil para controlar el proceso de difusión en modelos generativos, permitiendo ajustes finos a los niveles de ruido aplicados en cada paso del proceso de generación.

Ver DocsPolyexponential Scheduler | Programador Poliexponencial

El nodo PolyexponentialScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en un programa de ruido poliexponencial. Este programa es una función polinómica en el logaritmo de sigma, permitiendo una progresión flexible y personalizable de los niveles de ruido a lo largo del proceso de difusión.

Ver DocsSD Turbo Scheduler | Programador Turbo SD

El nodo SDTurboScheduler está diseñado para generar una secuencia de valores sigma para el muestreo de imágenes, ajustando la secuencia según el nivel de reducción de ruido y el número de pasos especificados. Aprovecha las capacidades de muestreo de un modelo específico para producir estos valores sigma, que son cruciales para controlar el proceso de reducción de ruido durante la generación de imágenes.

Ver DocsVP Scheduler | Programador VP

El nodo VPScheduler está diseñado para generar una secuencia de niveles de ruido (sigmas) basada en el método de programación de Preservación de Varianza (VP). Esta secuencia es crucial para guiar el proceso de eliminación de ruido en modelos de difusión, permitiendo la generación controlada de imágenes u otros tipos de datos.

Ver DocsSigmas

Flip Sigmas | Invertir Sigmas

El nodo FlipSigmas está diseñado para manipular la secuencia de valores sigma utilizados en modelos de difusión invirtiendo su orden y asegurando que el primer valor no sea cero si originalmente lo era. Esta operación es crucial para adaptar los niveles de ruido en orden inverso, facilitando el proceso de generación en modelos que operan reduciendo gradualmente el ruido de los datos.

Ver DocsSplit Sigmas | Dividir Sigmas

El nodo SplitSigmas está diseñado para dividir una secuencia de valores sigma en dos partes basándose en un paso especificado. Esta funcionalidad es crucial para operaciones que requieren un manejo o procesamiento diferente de las partes inicial y subsecuente de la secuencia de sigma, permitiendo una manipulación más flexible y dirigida de estos valores.

Ver DocsUtils

Las opciones del nodo utils incluyen varios nodos auxiliares.

Note | Nota

El nodo Note está diseñado para proporcionar un mecanismo básico de muestreo para diversas aplicaciones. Permite a los usuarios seleccionar y configurar diferentes estrategias de muestreo adaptadas a sus necesidades específicas, mejorando la adaptabilidad y eficiencia del proceso de muestreo.

Ver DocsPrimitive | Primitivo

El nodo Primitive puede reconocer el tipo de entrada conectada a él y proporcionar datos de entrada en consecuencia. Cuando este nodo se conecta a diferentes tipos de entrada, cambiará a diferentes estados de entrada. Se puede usar para utilizar un parámetro unificado entre varios nodos diferentes, como usar la misma semilla en múltiples Ksampler.

Ver DocsReroute | Redirigir

El nodo Reroute está diseñado para proporcionar un mecanismo básico de muestreo para diversas aplicaciones. Permite a los usuarios seleccionar y configurar diferentes estrategias de muestreo adaptadas a sus necesidades específicas, mejorando la adaptabilidad y eficiencia del proceso de muestreo.

Ver DocsTerminal Log (Manager) | Registro de Terminal (Gestor)

El nodo Terminal Log (Manager) se utiliza principalmente para mostrar la información de ejecución de ComfyUI en el terminal dentro de la interfaz de ComfyUI. Para usarlo, necesitas configurar el `mode` en modo **logging**. Esto le permitirá registrar la información de registro correspondiente durante la tarea de generación de imágenes. Si el `mode` está configurado en modo **stop**, no registrará información de registro. Cuando accedes y usas ComfyUI a través de conexiones remotas o conexiones de red de área local, el nodo Terminal Log (Manager) se vuelve particularmente útil. Te permite ver directamente los mensajes de error del CMD dentro de la interfaz de ComfyUI, facilitando la comprensión del estado actual del funcionamiento de ComfyUI.