OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

ControlNet de Flux

Este artículo compilará los modelos ControlNet actualmente disponibles para el ecosistema Flux.

XLabs-AI/colecciones-controlnet-flux

XLabs-AI/colecciones-controlnet-flux es una colección de puntos de control ControlNet proporcionados para el modelo FLUX.1-dev. Este repositorio fue desarrollado por Black Forest Labs, con el objetivo de proporcionar más opciones de control para el ecosistema Flux.

Características principales:

-

Soporta tres modelos ControlNet:

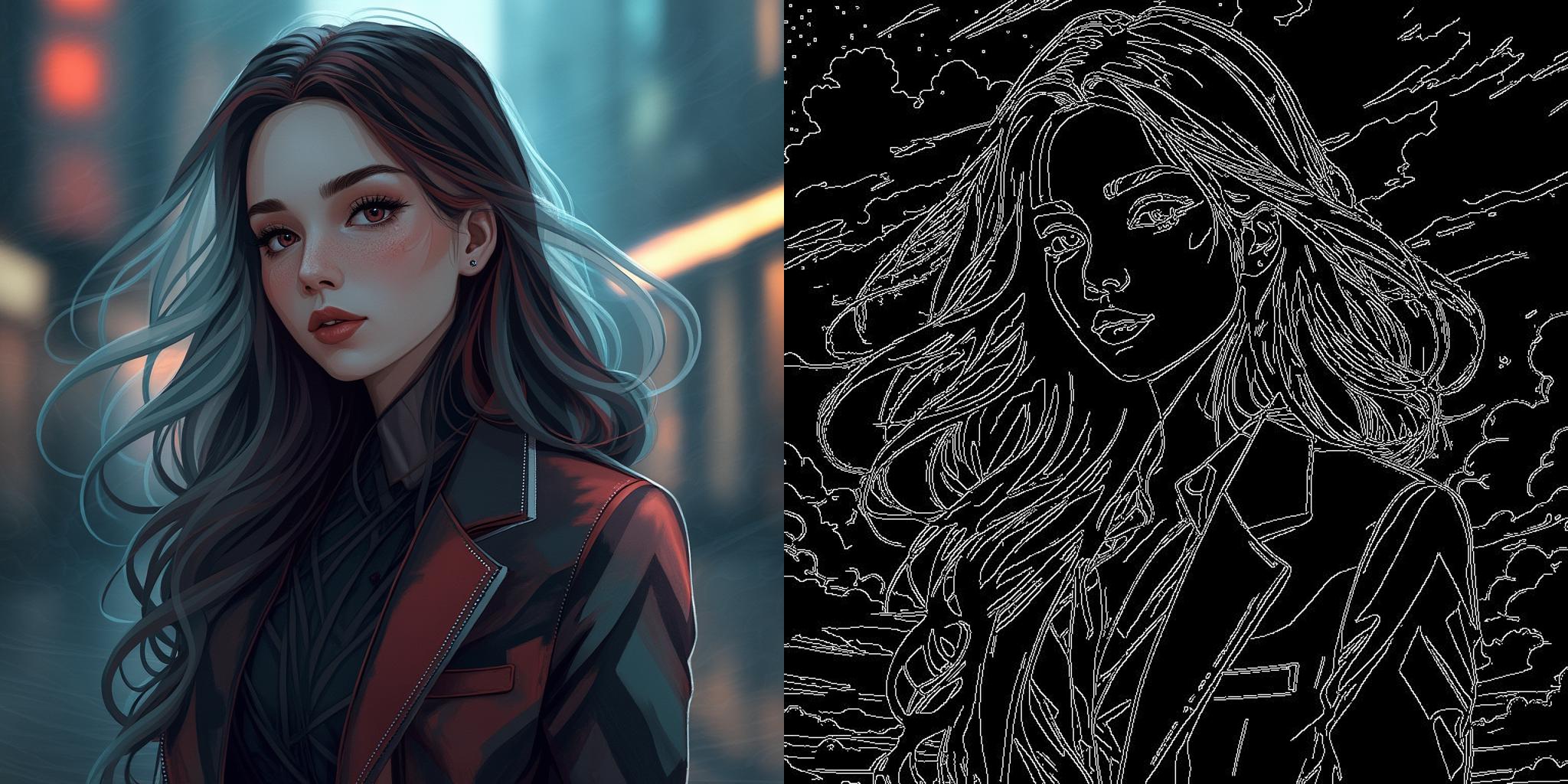

- Canny (detección de bordes)

- HED (detección de bordes)

- Profundidad (mapa de profundidad, basado en Midas)

-

Todos los modelos están entrenados a una resolución de 1024x1024, adecuados para generar imágenes de resolución 1024x1024.

-

Proporciona la versión v3, que es una versión mejorada y más realista que se puede usar directamente en ComfyUI.

-

Ofrece nodos y flujos de trabajo personalizados para ComfyUI, facilitando a los usuarios comenzar rápidamente.

-

Proporciona imágenes de muestra y resultados de generación, mostrando los efectos del modelo.

Uso:

- Usar a través del script main.py del repositorio oficial.

- Usar los nodos y flujos de trabajo personalizados proporcionados en ComfyUI, flujo de trabajo oficial disponible en https://huggingface.co/XLabs-AI/flux-controlnet-collections/tree/main/workflows

- Usar la interfaz de demostración de Gradio.

Licencia:

Estos pesos de modelo siguen la licencia no comercial FLUX.1 [dev].

Enlaces:

- Repositorio del modelo: https://huggingface.co/XLabs-AI/flux-controlnet-collections

- Repositorio de GitHub: Contiene flujos de trabajo de ComfyUI, scripts de entrenamiento y scripts de demostración de inferencia.

Aquí hay una lista de modelos ControlNet proporcionados en el repositorio XLabs-AI/colecciones-controlnet-flux:

| Nombre del Modelo | Tamaño del Archivo | Fecha de Carga | Descripción | Enlace del Modelo | Enlace de Descarga |

|---|---|---|---|---|---|

| flux-canny-controlnet.safetensors | 1.49 GB | 30 de agosto de 2023 | Modelo ControlNet de detección de bordes Canny (versión inicial) | Ver | Descargar |

| flux-canny-controlnet_v2.safetensors | 1.49 GB | 30 de agosto de 2023 | Modelo ControlNet de detección de bordes Canny (versión v2) | Ver | Descargar |

| flux-canny-controlnet-v3.safetensors | 1.49 GB | 30 de agosto de 2023 | Modelo ControlNet de detección de bordes Canny (versión v3) | Ver | Descargar |

| flux-depth-controlnet.safetensors | 1.49 GB | 30 de agosto de 2023 | Modelo ControlNet de mapa de profundidad (versión inicial) | Ver | Descargar |

| flux-depth-controlnet_v2.safetensors | 1.49 GB | 30 de agosto de 2023 | Modelo ControlNet de mapa de profundidad (versión v2) | Ver | Descargar |

| flux-depth-controlnet-v3.safetensors | 1.49 GB | 30 de agosto de 2023 | Modelo ControlNet de mapa de profundidad (versión v3) | Ver | Descargar |

| flux-hed-controlnet.safetensors | 1.49 GB | 30 de agosto de 2023 | Modelo ControlNet de detección de bordes HED (versión inicial) | Ver | Descargar |

| flux-hed-controlnet-v3.safetensors | 1.49 GB | 30 de agosto de 2023 | Modelo ControlNet de detección de bordes HED (versión v3) | Ver | Descargar |

Este proyecto proporciona potentes modelos ControlNet para el ecosistema Flux, permitiendo a los usuarios controlar el proceso de generación de imágenes de manera más precisa, especialmente adecuado para aplicaciones que requieren generación de imágenes basadas en detección de bordes o información de profundidad.

InstantX Flux Union ControlNet

InstantX Flux Union ControlNet es un modelo ControlNet versátil diseñado para la versión de desarrollo FLUX.1. Este modelo integra múltiples modos de control, permitiendo a los usuarios controlar el proceso de generación de imágenes de manera más flexible.

Características principales:

-

Múltiples modos de control: Soporta varios modos de control, incluyendo detección de bordes Canny, Tile, mapa de profundidad, desenfoque, control de pose, etc.

-

Alto rendimiento: La mayoría de los modos de control han logrado una alta efectividad, especialmente los modos Canny, Tile, mapa de profundidad, desenfoque y control de pose.

-

Optimización continua: El equipo de desarrollo está constantemente mejorando el modelo para aumentar su rendimiento y estabilidad.

-

Compatibilidad: Totalmente compatible con el modelo base de la versión de desarrollo FLUX.1, integrándose fácilmente en flujos de trabajo existentes de FLUX.

-

Inferencia de control múltiple: Soporta el uso simultáneo de múltiples modos de control, proporcionando a los usuarios un control más detallado sobre la generación de imágenes.

Uso:

-

Modo de control único:

- Cargar el modelo Union ControlNet

- Seleccionar el modo de control deseado (por ejemplo, Canny, mapa de profundidad, etc.)

- Establecer la imagen de control y los parámetros relacionados

- Generar la imagen

-

Modo de control múltiple:

- Cargar el modelo Union ControlNet como FluxMultiControlNetModel

- Establecer diferentes imágenes de control y parámetros para cada modo de control

- Aplicar múltiples modos de control simultáneamente para generar la imagen

Notas:

- La versión actual es una versión beta y puede no estar completamente entrenada, por lo que puede encontrar algunas imperfecciones durante su uso.

- Algunos modos de control (como el control en escala de grises) pueden tener una efectividad menor, por lo que se recomienda priorizar los modos de alta efectividad.

- En comparación con modelos ControlNet de función única especializados, el modelo Union puede tener un rendimiento ligeramente inferior en ciertas tareas específicas, pero ofrece mayor flexibilidad y versatilidad.

Enlaces de recursos:

- Descarga del modelo: InstantX/FLUX.1-dev-Controlnet-Union-alpha

| Nombre del Archivo | Tamaño | Enlace de Vista | Enlace de Descarga |

|---|---|---|---|

| diffusion_pytorch_model.safetensors | 6.6 GB | Ver | Descargar |

Nota: Después de descargar el modelo, se recomienda renombrar el archivo a un nombre más descriptivo, como “flux_union_controlnet.safetensors”, para facilitar la gestión y identificación de archivos en el futuro.

Este modelo Union ControlNet proporciona una herramienta de control de imágenes poderosa y flexible para el ecosistema FLUX, especialmente adecuada para usuarios que necesitan implementar múltiples funciones de control en un solo modelo. Con optimizaciones y actualizaciones continuas, tiene el potencial de convertirse en uno de los modelos ControlNet más completos y potentes en la plataforma FLUX.

InstantX Flux Canny ControlNet

Además del modelo Union ControlNet, InstantX también proporciona un modelo ControlNet específicamente para la detección de bordes Canny. Este modelo se centra en utilizar el algoritmo de detección de bordes Canny para controlar el proceso de generación de imágenes, proporcionando a los usuarios capacidades de control de bordes más precisas.

Características principales:

-

Enfoque en la detección de bordes Canny: Este modelo está específicamente optimizado para la detección de bordes Canny, permitiendo un mejor procesamiento y utilización de la información de bordes.

-

Entrenamiento de alta resolución: El modelo fue entrenado en un entorno multiescalar con un total de píxeles de 10241024, utilizando un tamaño de lote de 88 durante 30k pasos.

-

Compatible con FLUX.1: Diseñado para la versión de desarrollo FLUX.1, puede integrarse sin problemas en los flujos de trabajo de FLUX.

-

Utiliza precisión bfloat16: El modelo utiliza precisión bfloat16, lo que puede mejorar la eficiencia computacional mientras mantiene la precisión.

Uso:

- Instalar la última versión de la biblioteca Diffusers.

- Cargar el modelo Flux Canny ControlNet y el modelo base FLUX.1.

- Preparar la imagen de entrada y aplicar la detección de bordes Canny.

- Usar los bordes detectados como entrada de control para generar la imagen.

Serie de ControlNets de Jasperai Flux.1-dev

Jasperai ha desarrollado una serie de modelos ControlNet para Flux.1-dev, diseñados para proporcionar un control más preciso para la generación de imágenes AI. Esta serie incluye modelos de normales de superficie, mapas de profundidad y super-resolución, ofreciendo a los usuarios un conjunto diverso de herramientas creativas.

Puede ver información detallada sobre estos modelos en la página de colección de Jasperai en Hugging Face.

1. Modelo ControlNet de Normales de Superficie

El Modelo ControlNet de Normales de Superficie utiliza mapas de normales de superficie para guiar la generación de imágenes. Este modelo está específicamente optimizado para la información de normales de superficie, permitiendo un mejor procesamiento y utilización de la información geométrica de la superficie de los objetos.

Características principales:

- Se centra en el procesamiento de normales de superficie

- Proporciona información geométrica precisa de las superficies de los objetos

- Mejora la percepción de profundidad y realismo de la imagen

- Compatible con la versión de desarrollo FLUX.1

2. Modelo ControlNet de Mapa de Profundidad

El Modelo ControlNet de Mapa de Profundidad utiliza información de profundidad para controlar la generación de imágenes. Este modelo está específicamente optimizado para la información de mapas de profundidad, permitiendo una mejor comprensión y utilización de la información de la estructura espacial de la escena.

Características principales:

- Se centra en el procesamiento de mapas de profundidad

- Proporciona información de la estructura espacial de las escenas

- Mejora la perspectiva de la imagen y el sentido espacial

- Compatible con la versión de desarrollo FLUX.1

3. Modelo ControlNet de Super-resolución

El Modelo ControlNet de Super-resolución se centra en mejorar la calidad de las imágenes de baja resolución. Este modelo puede convertir imágenes de baja calidad en versiones de alta resolución, reconstruyendo y mejorando los detalles de la imagen.

Características principales:

- Se centra en el procesamiento de super-resolución de imágenes

- Convierte imágenes de baja resolución en versiones de alta resolución

- Reconstruye y mejora los detalles de la imagen

- Compatible con la versión de desarrollo FLUX.1

Estos modelos proporcionan un control más preciso para la generación de imágenes AI, permitiendo a los creadores generar imágenes más realistas y detalladas. Cada modelo está diseñado para necesidades específicas de procesamiento de imágenes, ofreciendo a los usuarios un conjunto diverso de herramientas creativas. Los usuarios pueden elegir el modelo apropiado según sus necesidades para lograr diferentes efectos de generación de imágenes.