OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

Guía Completa del Flujo de Trabajo Wan2.1 Fun Control en ComfyUI

Wan2.1-Fun-Control es la última capacidad de control de video lanzada por el equipo de Alibaba, que puede lograr capacidades de control de video como profundidad, openpose y canny. Actualmente, este modelo se divide en dos categorías: modelos de 1.3B y 14B.

- Wan2.1-Fun-1.3B-Control

- Wan2.1-Fun-14B-Control

- Repositorio de código correspondiente: VideoX-Fun

Esta guía cubrirá dos tipos de flujos de trabajo:

- Flujo de trabajo nativo de ComfyUI

-

- Totalmente nativo (no depende de nodos personalizados de terceros)

-

- Versión mejorada del flujo de trabajo nativo (utiliza nodos personalizados)

- Flujo de trabajo utilizando el ComfyUI-WanVideoWrapper de Kijai

- Ambos flujos de trabajo son esencialmente los mismos en términos de modelos, pero utilicé modelos de diferentes fuentes para alinearlos mejor con el flujo de trabajo y el uso del modelo originales.

- Para tareas relacionadas con video, puedes utilizar el paquete de nodos personalizados ComfyUI-VideoHelperSuite para realizar la carga de video, guardar como mp4, fusionar y otras operaciones de video ricas.

- Para la instalación de complementos, consulta la guía sobre cómo instalar nodos personalizados.

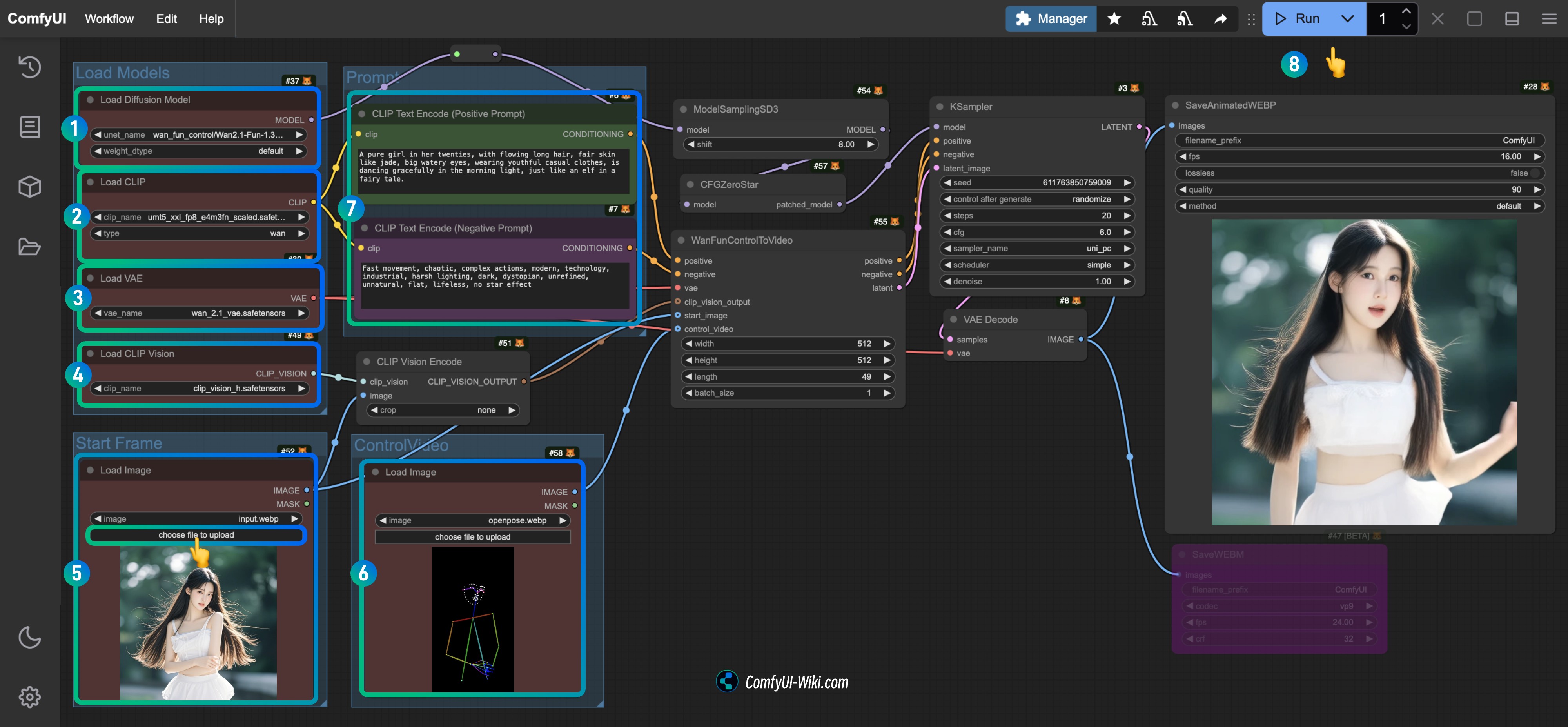

Flujo de trabajo nativo de Wan2.1 Fun Control en ComfyUI

Actualmente, ComfyUI admite oficialmente el modelo Wan Fun Control de forma nativa, pero hasta ahora (2025-04-10), no hay un ejemplo de flujo de trabajo oficialmente publicado.

Antes de comenzar, asegúrate de que tu versión de ComfyUI sea al menos posterior a este commit para que puedas encontrar el nodo correspondiente WanFunControlToVideo. Consulta cómo actualizar ComfyUI para actualizar tu versión de ComfyUI.

1.1 Descarga del archivo del flujo de trabajo Wan2.1 Fun Control

1.1.1 Archivo del flujo de trabajo

Descarga la imagen a continuación y arrástrala a ComfyUI, lo que cargará el flujo de trabajo correspondiente y solicitará la descarga del modelo.

Descargar en formato Json

1.1.2 Fotograma inicial y video de control

Descarga las imágenes y videos a continuación, que utilizaremos como condiciones de entrada.

- Aquí, proporciono un video de control preprocesado para utilizar nodos nativos sin depender completamente de nodos personalizados de terceros.

- Puedes utilizar nodos personalizados como ComfyUI-comfyui_controlnet_aux para completar el preprocesamiento de video.

1.2 Instalación manual del modelo

Si el modelo correspondiente no se descargó correctamente, aquí están los enlaces de descarga para los modelos.

Modelos de difusión Elige entre 1.3B o 14B. El modelo de 14B es más grande y ofrece un mejor rendimiento, pero también requiere un mayor rendimiento del dispositivo.

- Wan2.1-Fun-1.3B-Control: Después de descargar, renómbralo a

Wan2.1-Fun-1.3B-Control.safetensors - Wan2.1-Fun-14B-Control: Después de descargar, renómbralo a

Wan2.1-Fun-14B-Control.safetensors

Codificadores de texto Elige uno de los dos modelos a continuación, fp16 es más grande y requiere un mayor rendimiento.

VAE

CLIP Vision Utilizado para extraer características de imagen

Ubicación de guardado del archivo

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └── Wan2.1-Fun-1.3B-Control.safetensors # O la versión que elijas

│ ├── 📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # O la versión que elijas

│ └── 📂 vae/

│ │ └── wan_2.1_vae.safetensors

│ └── 📂 clip_vision/

│ └── clip_vision_h.safetensors 1.3 Ejecución Paso a Paso del Flujo de Trabajo

- Asegúrate de que el nodo

Load Diffusion Modelhaya cargado el modeloWan2.1-Fun-1.3B-Control.safetensors. - Asegúrate de que el nodo

Load CLIPhaya cargado el modeloumt5_xxl_fp8_e4m3fn_scaled.safetensors. - Asegúrate de que el nodo

Load VAEhaya cargado el modelowan_2.1_vae.safetensors. - Asegúrate de que el nodo

Load CLIP Visionhaya cargado el modeloclip_vision_h.safetensors. - Carga la imagen de entrada proporcionada como el fotograma inicial en el nodo

Load Image. - Sube el video proporcionado en el nodo

Load Imagecomo la condición de control. - (Opcional) Modifica el aviso de video en el nodo

CLIP Text Encoder. - Haz clic en el botón

Runo utiliza el atajoCtrl(cmd) + Enterpara ejecutar la generación de video.

1.4 Análisis del Flujo de Trabajo

El flujo de trabajo nativo se centra principalmente en la adquisición de fotogramas de video. La longitud predeterminada proporcionada por el nodo WanFunControlToVideo es de 81 (lo que genera un video de 5 segundos a 15 fotogramas por segundo), pero el video de control que proporcioné solo tiene 49 fotogramas, por lo que hice ajustes. Además, es posible que notes que el personaje se acerca repentinamente después de la generación del video. Esto se debe a que la imagen del fotograma inicial y el video de control tienen dimensiones diferentes, lo que lleva a recortes y acercamientos durante el procesamiento.

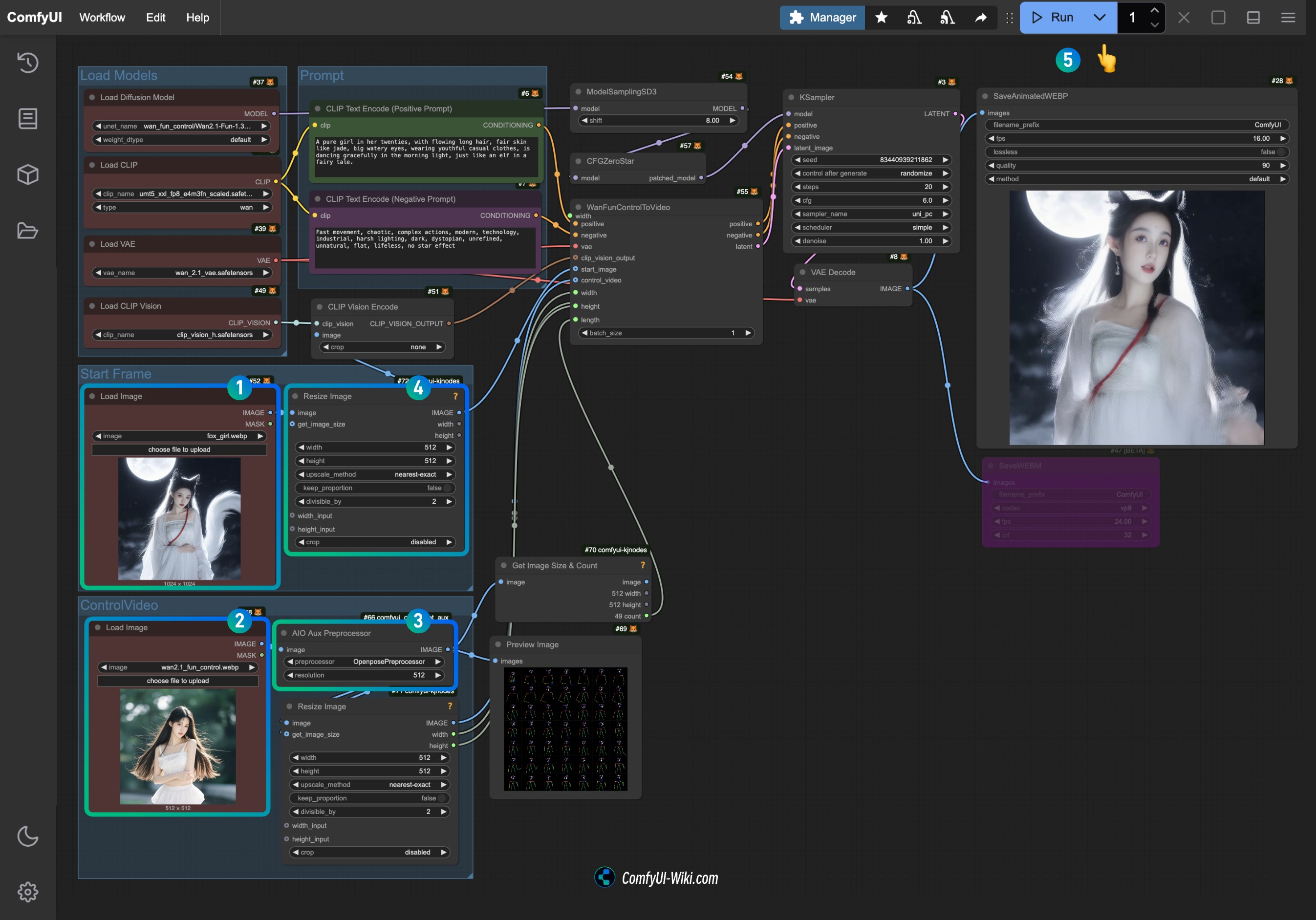

2. Versión Ajustada del Flujo de Trabajo Nativo de Wan2.1 Fun Control

Dado que el flujo de trabajo completamente nativo no es muy conveniente para los cálculos de tamaño de video y conteo de fotogramas, utilicé algunos nodos de los siguientes paquetes de nodos personalizados en esta versión mejorada:

- ComfyUI-KJNodes para ajustar el tamaño del video y obtener el conteo de fotogramas de imagen.

- ComfyUI-comfyui_controlnet_aux para el preprocesamiento de imágenes de video.

Antes de comenzar, asegúrate de haber instalado estos dos paquetes de nodos personalizados, o utiliza ComfyUI-Manager para instalarlos después de cargar el flujo de trabajo.

2.1 Descarga del Archivo del Flujo de Trabajo

2.1.1 Descarga del Archivo del Flujo de Trabajo

Descarga la imagen a continuación y arrástrala a ComfyUI para cargar el flujo de trabajo correspondiente, lo que solicitará la descarga del modelo.

2.1.2 Descarga del Video de Entrada

Descarga la imagen y el video a continuación para las condiciones de entrada.

Debido a limitaciones de tiempo, el video con el efecto de zoom repentino todavía se utiliza como entrada.

2.2 Ejecución Paso a Paso del Flujo de Trabajo

- Sube la imagen de entrada proporcionada en el nodo

Load Imagedel Fotograma Inicial. - Sube el video proporcionado en el nodo

Load Imagedel Video de Control como la condición de control. - Selecciona el preprocesador que deseas usar en el

AIO Aux Preprocessor(el modelo correspondiente se descargará de Hugging Face en la primera ejecución). - Si necesitas ajustar el tamaño, puedes modificar la configuración de tamaño del nodo

Resize Image, asegurándote de que ambos nodos permanezcan consistentes. - Haz clic en el botón

Runo utiliza el atajoCtrl(cmd) + Enterpara ejecutar la generación de video.

Dado que el nodo Load Image actualmente no admite videos mp4, si deseas tener videos de entrada, puedes usar el nodo Load Video (Upload) de ComfyUI-VideoHelperSuite para manejar varios formatos de video.

3. Extensiones Relacionadas

Puedes agregar nodos de generación de imágenes correspondientes a estos flujos de trabajo para generar el video final sin depender de imágenes de referencia de entrada.

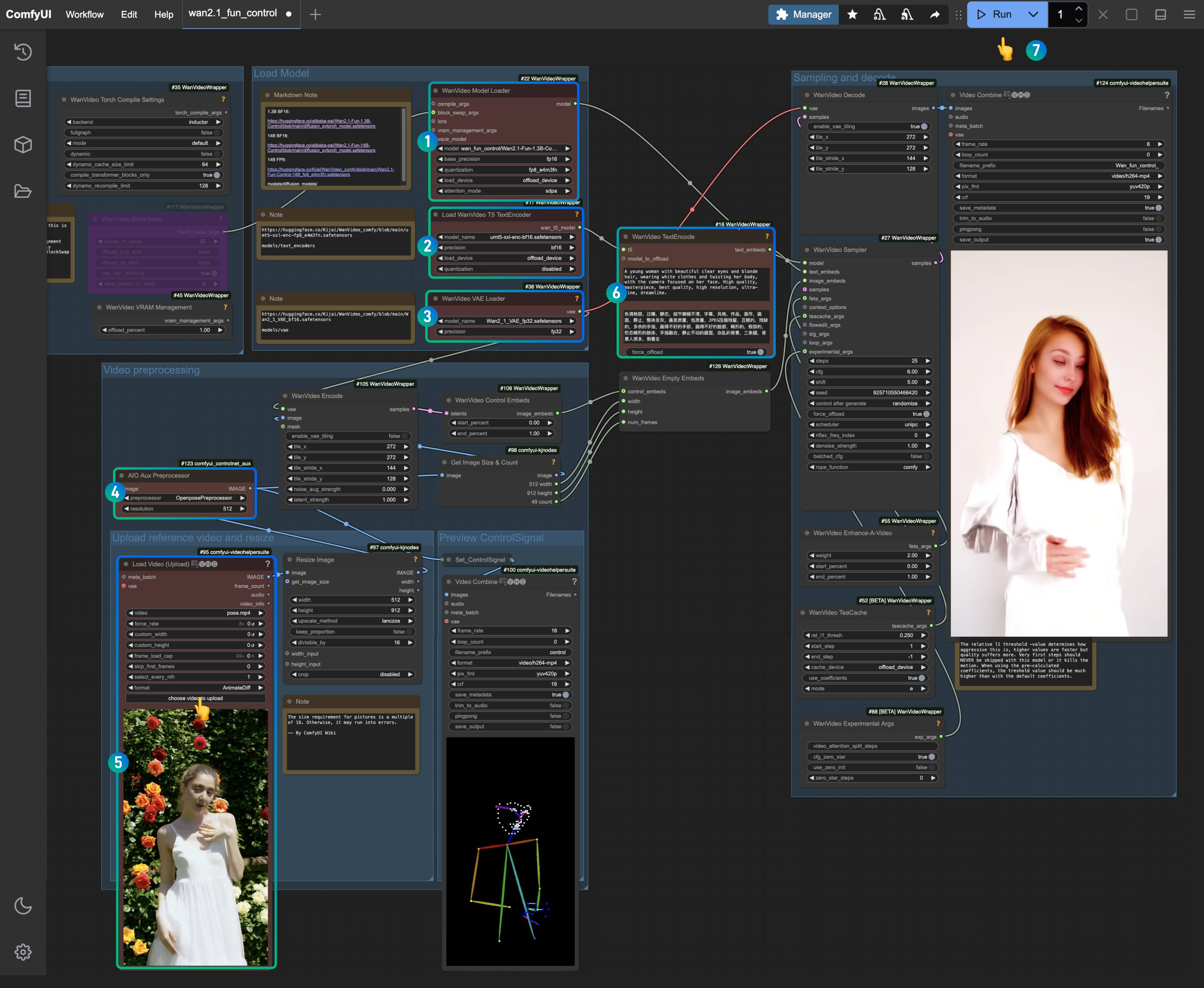

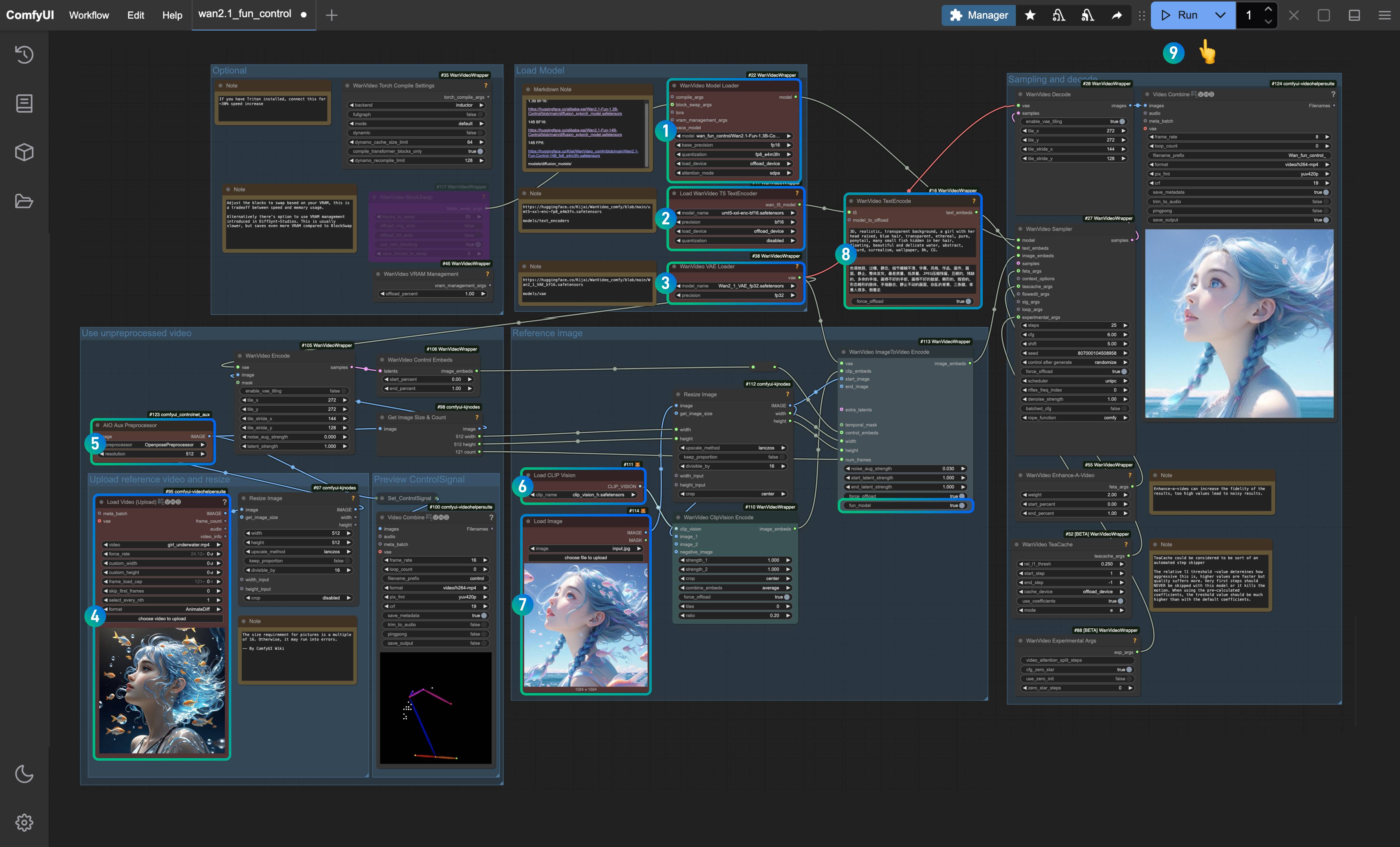

Flujo de Trabajo Kijai Wan Fun Control

Usaremos el plugin ComfyUI-WanVideoWrapper de Kijai para completar el ejemplo de Fun-Control. Puedes encontrar el flujo de trabajo original proporcionado por Kijai aquí.

El flujo de trabajo involucrado en esta guía ha sido reorganizado por ComfyUI Wiki.

Esta sección del flujo de trabajo se dividirá en dos categorías:

- Flujo de trabajo de control para imagen de texto a video utilizando solo condiciones de control de video

- Flujo de trabajo de control para generación de video de referencia de imagen que analiza y extrae características de imágenes de referencia utilizando Clip_vision y agrega condiciones de control de video

Instalación Relacionada

Instalación de Nodo Personalizado

Necesitas instalar los siguientes plugins para asegurar que el flujo de trabajo funcione sin problemas:

- ComfyUI-WanVideoWrapper: necesita ser actualizado a la última versión

- ComfyUI-VideoHelperSuite

- ComfyUI-KJNodes

- ComfyUI-comfyui_controlnet_aux: para el preprocesamiento de imágenes de video, o puedes reemplazarlo con tus nodos de preprocesamiento de imágenes comúnmente utilizados

Puedes usar el ComfyUI Manager para actualizar o instalar los nodos personalizados mencionados anteriormente, o consultar cómo instalar nodos personalizados para completar la instalación correspondiente.

ComfyUI-comfyui_controlnet_aux descargará el modelo correspondiente en la primera ejecución, asegúrate de que puedes acceder a huggingface normalmente.

Instalación del Modelo

Wan2.1 Fun Control Proporciona dos modelos: 1.3B y 14B, puedes elegir el modelo apropiado según el rendimiento de tu dispositivo.

- Wan2.1-Fun-1.3B-Control: renombrar a

Wan2.1-Fun-1.3B-Control.safetensorsdespués de descargar - Wan2.1-Fun-14B-Control: renombrar a

Wan2.1-Fun-14B-Control.safetensorsdespués de descargar - Kijai/Wan2.1-Fun-Control-14B_fp8_e4m3fn.safetensors

Elige una versión de Codificadores de texto para descargar:

VAE

CLIP Vision

Ubicación de guardado del archivo

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └── Wan2.1-Fun-1.3B-Control.safetensors # O la versión que elijas

│ ├── 📂 text_encoders/

│ │ └─── umt5-xxl-enc-bf16.safetensors # O la versión que elijas

│ ├── 📂 vae/

│ │ └── Wan2_1_VAE_bf16.safetensors

│ └── 📂clip_vision/

│ └── clip_vision_h.safetensors 1. Flujo de Trabajo de Control de Video Texto-a-Video

1.1 Descargar Archivos del Flujo de Trabajo

Descarga la imagen a continuación y arrástrala a ComfyUI para cargar el flujo de trabajo correspondiente.

Descarga en formato JSON.

Descarga el video a continuación como el video de entrada.

1.2 Completar los Pasos del Flujo de Trabajo

Descarga la imagen a continuación y arrástrala a ComfyUI para cargar el flujo de trabajo correspondiente.

Asegúrate de que los nodos correspondientes hayan cargado los modelos apropiados, utilizando las versiones que descargaste.

- Asegúrate de que el nodo

Cargador de Modelos WanVideohaya cargado el modeloWan2.1-Fun-1.3B-Control.safetensors. - Asegúrate de que el nodo

Cargar Codificador de Texto WanVideo T5haya cargado el modeloumt5-xxl-enc-bf16.safetensors. - Asegúrate de que el nodo

Cargador de VAE WanVideohaya cargado el modeloWan2_1_VAE_bf16.safetensors. - En el nodo

Preprocesador AIO AuxAux, selecciona el nodoPreprocesador Openpose. - En el nodo

Cargar Video (Subir), sube el video de entrada que proporcionamos anteriormente. - En el

Codificador de Texto WanVideo, ingresa el aviso para el video que deseas generar (puedes dejarlo como predeterminado). - Haz clic en el botón

Cola, o usa el atajoCtrl(cmd) + Enterpara ejecutar la generación del video.

1.3 Análisis del Flujo de Trabajo

Esta versión del flujo de trabajo codifica principalmente las condiciones de la imagen preprocesada y luego genera el video. En el nodo de preprocesamiento de imágenes Preprocesador Openpose, puedes elegir varios métodos de preprocesamiento, como Openpose, Depth, Canny, etc. Aquí, elegimos el método de preprocesamiento Openpose para generar el control y la codificación del movimiento del personaje correspondiente.

2. Flujo de Trabajo de Generación de Video de Imagen de Referencia de Control de Video

Este flujo de trabajo carga principalmente un modelo clip_vision_h.safetensors, que puede entender eficazmente el contenido de la imagen de referencia. Sin embargo, no genera el video preservando completamente la consistencia, sino que genera el video basado en las características de la imagen de referencia.

2.1 Descargar Archivos del Flujo de Trabajo

Descarga la imagen a continuación y arrástrala a ComfyUI para cargar el flujo de trabajo correspondiente.

Descarga en formato JSON.

Descarga el video y las imágenes a continuación, que utilizaremos como condiciones de entrada.

2.2 Completar los Pasos del Flujo de Trabajo

- Asegúrate de que el nodo

Cargador de Modelos WanVideohaya cargado el modeloWan2.1-Fun-1.3B-Control.safetensors. - Asegúrate de que el nodo

Cargar Codificador de Texto WanVideo T5haya cargado el modeloumt5-xxl-enc-bf16.safetensors. - Asegúrate de que el nodo

Cargador de VAE WanVideohaya cargado el modeloWan2_1_VAE_bf16.safetensors. - En el nodo

Cargar Video (Subir), sube el video de entrada que proporcionamos anteriormente. - En el nodo

Preprocesador AIO AuxAux, selecciona el nodoPreprocesador Openpose. - En el nodo

Cargar Visión CLIP, asegúrate de que el modeloclip_vision_h.safetensorsesté cargado, que se utilizará para extraer características de la imagen de referencia. - En el nodo

Cargar Imagen, sube la imagen de referencia proporcionada anteriormente. - En el

Codificador de Texto WanVideo, ingresa el aviso para el video que deseas generar (puedes dejarlo como predeterminado). - Haz clic en el botón

Cola, o usa el atajoCtrl(cmd) + Enterpara ejecutar la generación del video.

2.3 Análisis del Flujo de Trabajo

- Dado que Kijai ha actualizado los nodos correspondientes, ten en cuenta que el nodo

Codificación de Imagen a Video WanVideotiene una opción llamadafun_modelque debe configurarse en verdadero. - En comparación con otros, usar las características de la imagen de referencia será más adecuado, por lo que seguir utilizando una imagen de referencia sigue siendo necesario. Sin embargo, dado que solo extrae características de la imagen, no puede mantener completamente la consistencia del personaje.

- En la sección de preprocesamiento de imágenes, puedes intentar combinar múltiples nodos de preprocesamiento para generar condiciones de control más ricas.

Flujo de Trabajo Nativo Oficial de ComfyUI (Por Actualizar)

Actualmente, ComfyUI admite oficialmente el modelo de Control Divertido de Wan de manera nativa, pero aún no ha lanzado oficialmente los ejemplos de flujo de trabajo correspondientes. Los resultados del flujo de trabajo que he probado no son muy buenos, así que actualizaré el flujo de trabajo correspondiente aquí una vez que se publique el flujo de trabajo nativo oficial.

Antes de comenzar, debes asegurarte de que tu versión de ComfyUI sea al menos posterior a este commit para encontrar el nodo correspondiente WanFunControlToVideo .