unCLIP模型示例

unCLIP模型是SD模型的版本,特别调整以接收图像概念作为输入,以及您的文本提示。图像是使用这些模型附带的CLIPVision进行编码的,然后由它提取的概念在采样时传递给主模型。

它基本上允许您在提示中使用图像。

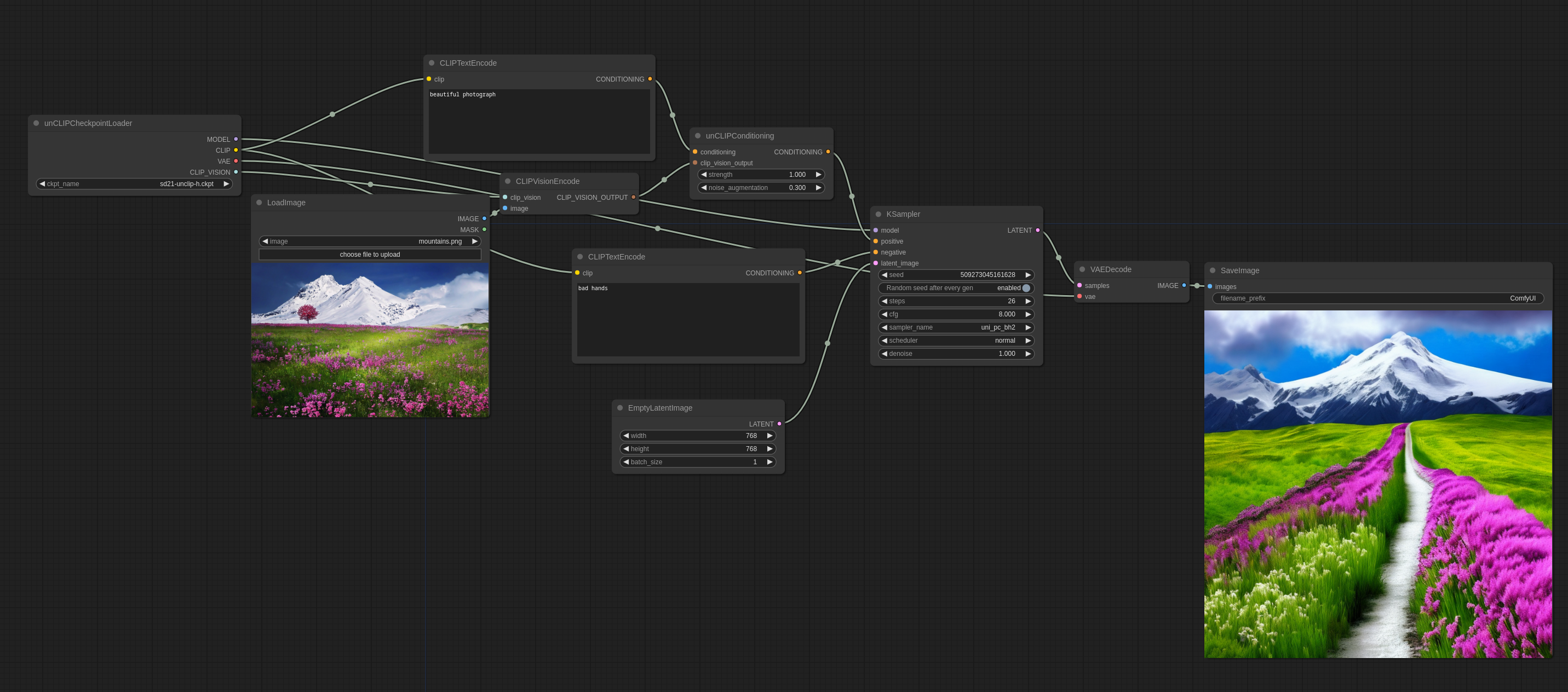

以下是如何在ComfyUI中使用它(您可以将其拖放到ComfyUI中以获取工作流程):

noise_augmentation控制模型将尝试遵循图像概念的紧密程度。值越低,它将越遵循概念。

strength是它将如何强烈地影响图像。

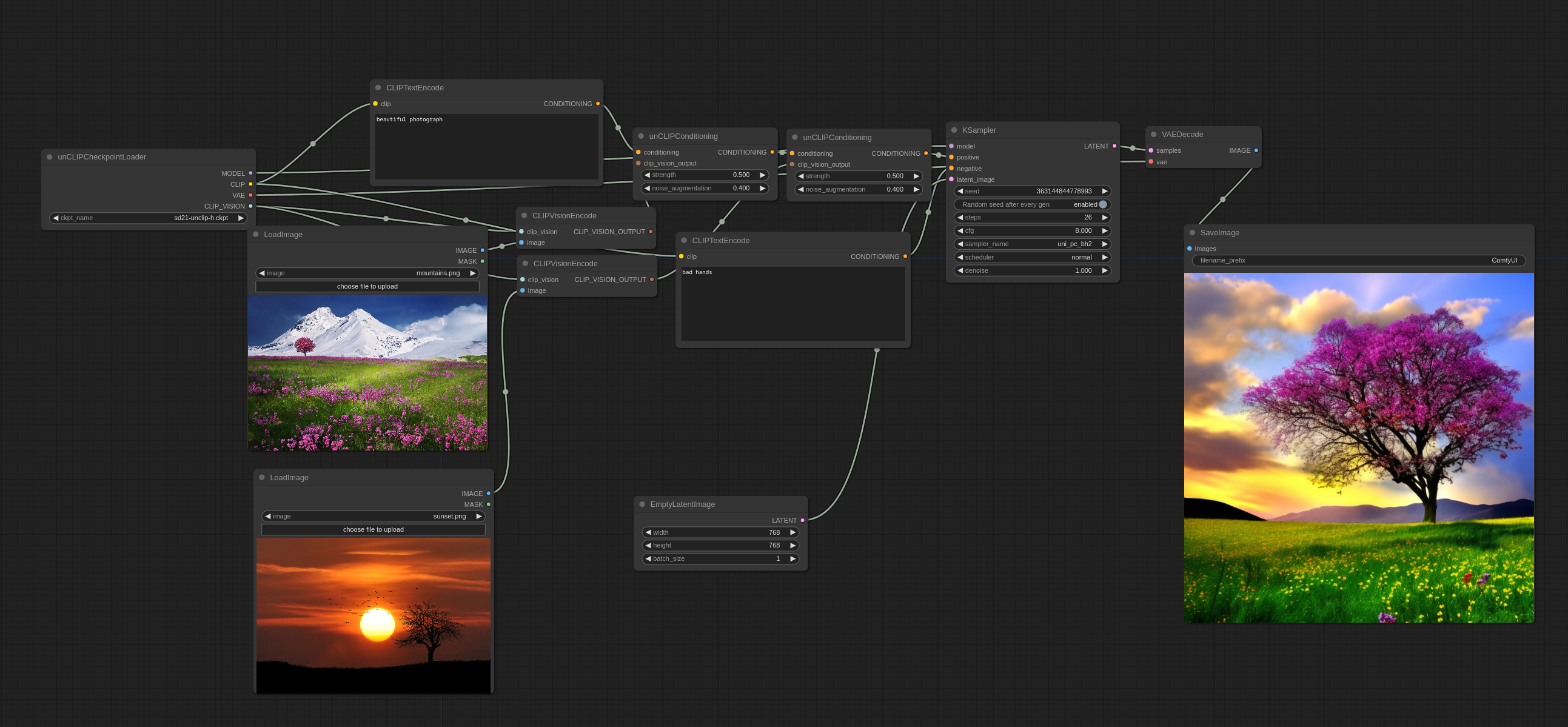

可以像这样使用多个图像:

您会注意到它不会以传统意义上的方式混合图像,而是实际上从两个图像中挑选一些概念,并制作出一张连贯的图像。

输入图像:

您可以在这里找到官方unCLIP检查点

您可以在这里(基于WD1.5 beta 2)和这里(基于Illuminati Diffusion)找到我制作的一些基于现有768-v检查点的unCLIP检查点

更高级的工作流程

使用unCLIP检查点的一个好方法是将其用于两阶段工作流程的第一阶段,然后切换到1.x模型进行第二阶段。以下图像的生成方式如下。(您可以将其加载到ComfyUI中以获取工作流程)