Exemples de Modèles unCLIP

Les modèles unCLIP sont des versions des modèles SD spécialement ajustées pour recevoir des concepts d’image en entrée en plus de votre texte. Les images sont encodées à l’aide de CLIPVision, fourni avec ces modèles, et les concepts extraits sont ensuite transmis au modèle principal lors de l’échantillonnage.

Cela vous permet essentiellement d’utiliser des images dans votre prompt.

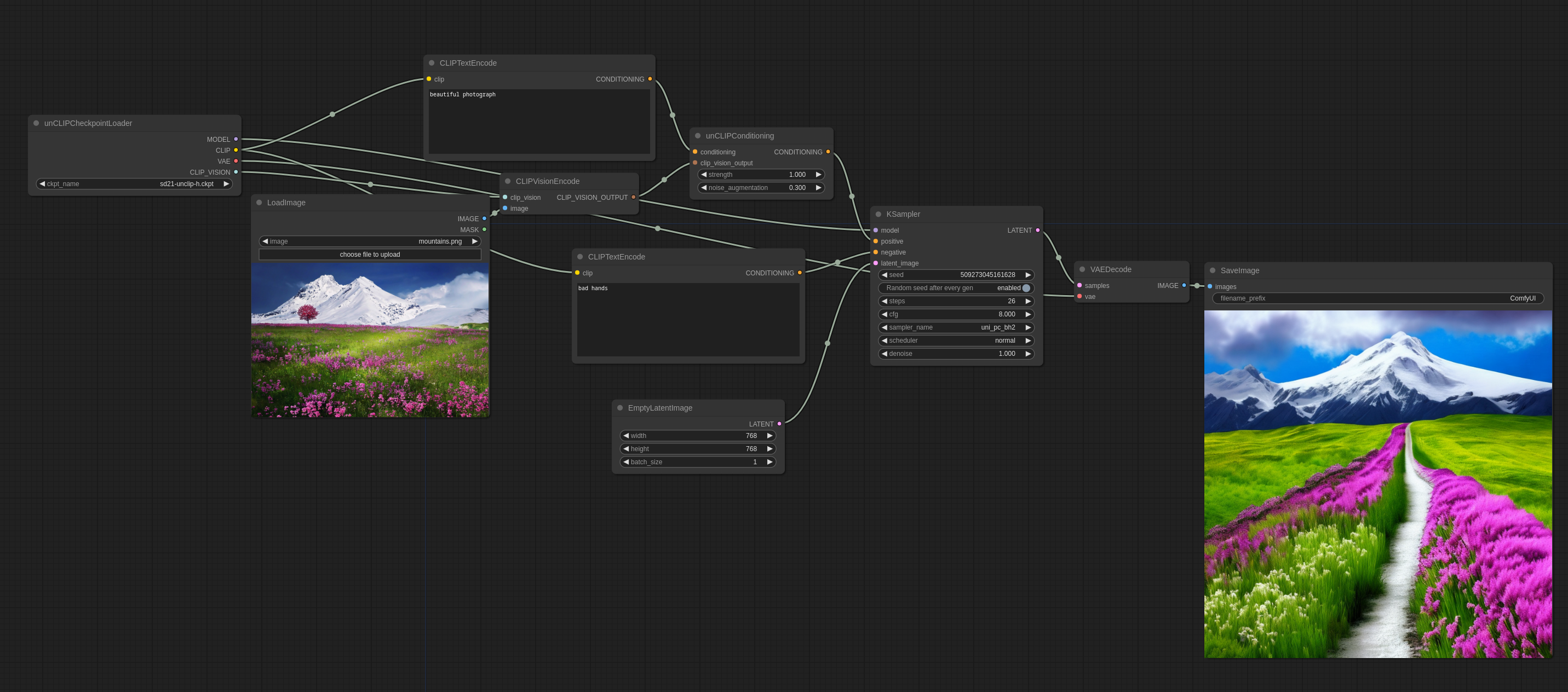

Voici comment l’utiliser dans ComfyUI (vous pouvez le glisser dans ComfyUI pour obtenir le workflow) :

noise_augmentation contrôle à quel point le modèle essaiera de suivre le concept d’image. Plus la valeur est basse, plus il suivra le concept.

strength détermine à quel point il influencera l’image.

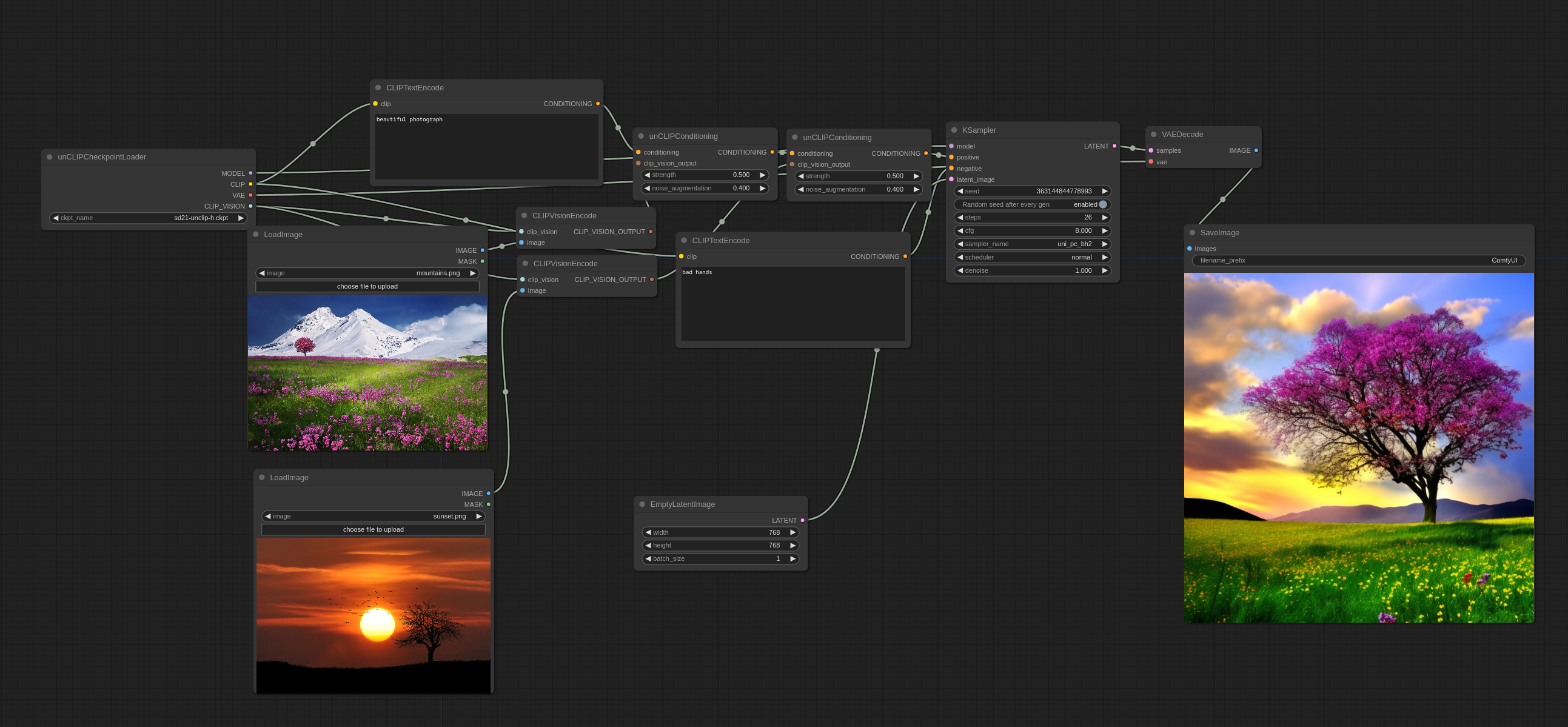

Plusieurs images peuvent être utilisées comme ceci :

Vous remarquerez qu’il ne mélange pas les images ensemble de manière traditionnelle, mais choisit en fait certains concepts des deux pour créer une image cohérente.

Images d’entrée :

Vous pouvez trouver les checkpoints officiels unCLIP ici

Vous pouvez trouver certains checkpoints unCLIP que j’ai créés à partir de checkpoints 768-v existants avec quelques fusions astucieuses ici (basé sur WD1.5 beta 2) et ici (basé sur illuminati Diffusion)

Workflows Plus Avancés

Une bonne façon d’utiliser les checkpoints unCLIP est de les utiliser pour le premier passage d’un workflow en deux passes, puis de passer à un modèle 1.x pour le second passage. C’est ainsi que l’image suivante a été générée. (vous pouvez le charger dans ComfyUI pour obtenir le workflow) :