Последние новости AIGC

Следите за последними новостями и обновлениями в сфере AIGC.

OpenMOSS выпускает MOVA - модель синхронизированной генерации видео и аудио с открытым исходным кодом

Команда OpenMOSS выпускает MOVA (MOSS Video and Audio) - фундаментальную модель сквозной синхронизированной генерации видео и аудио, которая генерирует видео и аудио за один проход вывода, обеспечивая точную синхронизацию губ и осознанные окружением звуковые эффекты, полностью открывая веса модели, код обучения и вывода

Alibaba Tongyi Lab Выпускает Z-Image-Base - Недистиллированная Высококачественная Модель Генерации Изображений

Alibaba Tongyi Lab выпускает Z-Image-Base, недистиллированную базовую модель серии Z-Image, сохраняющую полный генеративный потенциал и предоставляющую идеальную основу для тонкой настройки сообществом и индивидуальной разработки

DeepSeek выпускает DeepSeek-OCR-2 - модель понимания документов с визуальным причинным потоком

DeepSeek публикует в открытом доступе DeepSeek-OCR-2, представляя новый визуальный кодировщик DeepEncoder V2, который имитирует логику человеческого чтения через механизм визуального причинного потока, достигая точности 91.09% на OmniDocBench v1.5

Moonshot AI выпускает Kimi K2.5 - нативную мультимодальную агентную модель с 1T параметрами

Moonshot AI официально выпускает Kimi K2.5, нативную мультимодальную агентную модель с 1T параметрами, предварительно обученную на примерно 15 триллионах смешанных визуальных и текстовых токенов, поддерживающую понимание изображений и видео с механизмом автономной совместной работы Agent Swarm

Alibaba Qwen выпускает Qwen3-TTS - модель синтеза речи со сверхнизкой задержкой 97мс

Alibaba Qwen публикует в открытом доступе серию моделей генерации голоса Qwen3-TTS, достигая сверхнизкой задержки 97мс через моделирование Dual-Track, поддерживая клонирование голоса за 3 секунды и дизайн голоса на естественном языке, охватывая 10 основных языков

Microsoft выпускает VibeVoice-ASR - модель распознавания речи с поддержкой обработки 60-минутного длинного аудио за один проход

Microsoft публикует в открытом доступе VibeVoice-ASR, унифицированную модель распознавания речи с 9B параметрами, способную обрабатывать до 60 минут аудио за один проход, совместно завершая распознавание, диаризацию говорящих и генерацию временных меток в одном процессе вывода

NVIDIA выпускает PersonaPlex-7B-v1 - модель полнодуплексного голосового диалога

NVIDIA публикует в открытом доступе PersonaPlex-7B-v1, модель полнодуплексного голосового диалога с 7 миллиардами параметров на основе архитектуры Moshi, поддерживающую одновременное прослушивание и речь, естественные прерывания и настройку ролей с задержкой ответа на прерывания всего 240 миллисекунд

SVI 2.0 Pro Выпущен - Генерация Видео Бесконечной Длительности с Поддержкой Wan 2.2

Stable Video Infinity 2.0 Pro официально выпущен, добавлена поддержка базовой модели Wan 2.2, предоставляются версии HIGH и LOW моделей LoRA для генерации видеоконтента бесконечной длины в ComfyUI

Выпущен Qwen-Image-Layered - Модель генерации изображений с поддержкой редактирования по слоям

Qwen-Image-Layered может разлагать изображения на несколько RGBA слоев, каждый слой можно редактировать независимо, не затрагивая другой контент, поддерживая операции перекрашивания, замены, удаления, изменения размера и перемещения

Microsoft Выпускает TRELLIS.2 - Модель Генерации Изображения в 3D с 4 Миллиардами Параметров

Microsoft представляет TRELLIS.2, большую генеративную 3D модель с 4 миллиардами параметров, которая преобразует изображения в высококачественные 3D-ресурсы за секунды, с полными PBR материалами и поддержкой сложных топологий

Alibaba Cloud PAI выпускает Z-Image-Turbo-Fun-Controlnet-Union - Модель ControlNet с множественными условиями

Команда Alibaba Cloud PAI выпускает Z-Image-Turbo-Fun-Controlnet-Union, модель ControlNet с поддержкой нескольких условий управления, включая Canny, HED, Depth, Pose и MLSD, обученная на разрешении 1328

Alibaba AIDC-AI выпускает Ovis-Image — модель генерации изображений 7B, оптимизированную для рендеринга текста

Команда AIDC-AI от Alibaba выпустила Ovis-Image — модель преобразования текста в изображение с 7B параметрами, специализирующуюся на высококачественном рендеринге текста и показывающую отличные результаты на нескольких бенчмарках

Alibaba Tongyi Lab выпустила Z-Image-Turbo — эффективную модель генерации изображений с 6B параметрами

Alibaba Tongyi Lab выпустила Z-Image-Turbo — эффективную модель генерации изображений с 6B параметрами, которая создаёт качественные изображения всего за 8 шагов сэмплирования и работает на потребительских GPU с 16 ГБ видеопамяти

ByteDance представляет Sa2VA: Первую универсальную модель понимания изображений и видео

ByteDance представляет мультимодельную модель Sa2VA, объединяющую технологии SAM2 и LLaVA для достижения плотной сегментации и визуального ответа на вопросы как для изображений, так и для видео, достигая наилучших результатов в нескольких основных тестах

Tencent открывает исходный код Hunyuan Image 3.0 - крупнейшая в мире модель генерации изображений из текста с открытым исходным кодом

Tencent выпускает Hunyuan Image 3.0, первую коммерчески применимую нативную мультимодальную модель генерации изображений с открытым исходным кодом с общим количеством 80 млрд. параметров, обладающую возможностями рассуждения на основе мировых знаний и поддерживающую сложное понимание смысла на тысячах символов

Nunchaku выпускает 4-битную модель Qwen-Image-Edit-2509 Lightning

Команда Nunchaku выпускает оптимизированную версию 4-битной модели Qwen-Image-Edit-2509 Lightning, поддерживающую быструю инференцию за 4/8 шагов, плавно работающую в среде с 8 ГБ видеопамяти

Alibaba выпустила модель Wan-Animate - Единая технология анимации и замены персонажей

Лаборатория Tongyi от Alibaba запускает Wan-Animate, единый фреймворк анимации персонажей на базе Wan2.2, поддерживающий генерацию анимации персонажей и замену персонажей в видео, с открытыми весами модели и кодом вывода

Comfy Cloud — Лёгкий доступ к ComfyUI в облаке

Comfy Cloud предоставляет простой доступ к ComfyUI с мощными GPU, популярными моделями и пользовательскими нодами. Присоединяйтесь к закрытому бета-тесту и бесплатно пользуйтесь ComfyUI в облаке.

Tencent HunyuanWorld Voyager: Создание 3D видео исследований мира из одного изображения

Команда Tencent Hunyuan выпускает технологию Voyager, способную генерировать последовательности 3D облаков точек с согласованием мира из одного изображения и заданных пользователем путей камеры, поддерживающую бесконечное исследование мира и прямую 3D реконструкцию

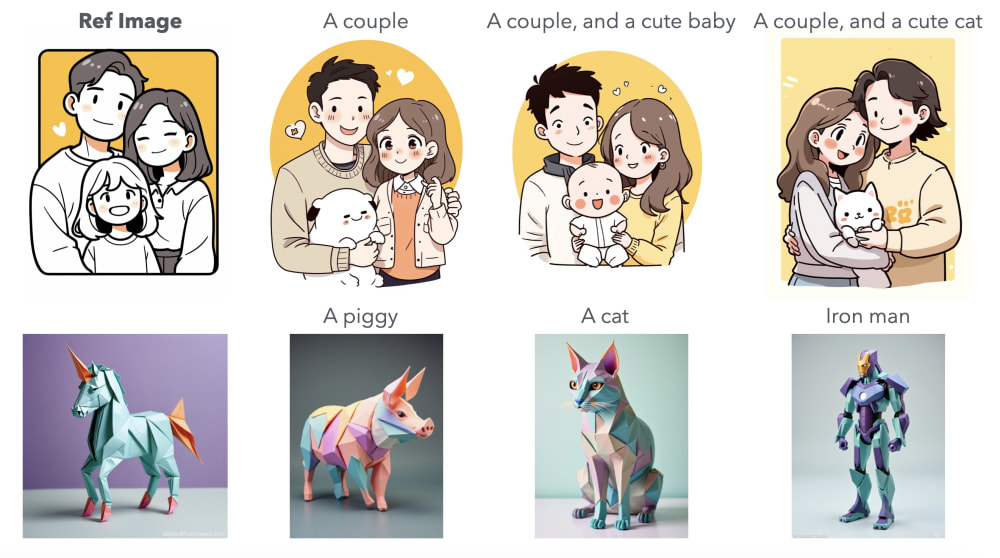

ByteDance выпустила USO: унифицированную модель генерации изображений с управлением стилем и субъектом

ByteDance представляет модель USO, которая может свободно комбинировать любые субъекты и стили, сохраняя согласованность субъектов и достигая высококачественных эффектов переноса стиля

Wan2.2-S2V: Выпущена модель генерации видео на основе аудио

Wan2.2-S2V - это модель генерации видео с ИИ, которая может преобразовывать статические изображения и аудио в видео, поддерживая потребности в создании контента, такие как диалог, пение и выступление.

ComfyUI Челлендж #1: Присоединяйтесь и выиграйте $100

Присоединяйтесь к первому еженедельному челленджу ComfyUI и выиграйте $100! Создайте видео, переворачивающее персонажа кошачьего человека, используя предоставленную карту глубины.

Открытый выпуск InfiniteTalk - Технология генерации видео на основе аудио с поддержкой неограниченной длины

Команда MeiGen-AI открыла модель InfiniteTalk с открытым исходным кодом, обеспечивающую точную синхронизацию губ и генерацию видео неограниченной длины. Поддерживает преобразование изображения в видео и видео в видео, что является прорывом в технологии цифровых людей.

ComfyUI Официально Выпускает Функцию Subgraph

ComfyUI официально выпускает функцию Subgraph, позволяя пользователям упаковывать сложные комбинации узлов в переиспользуемые отдельные узлы подграфа, значительно улучшая модульность и управление рабочим процессом.

Qwen-Image получил нативную поддержку в ComfyUI

Qwen-Image — модель MMDiT с 20 млрд параметров, ориентированная на сложный рендеринг текста и точное редактирование; теперь доступна нативно в ComfyUI. В заметке — ключевые возможности, лицензия и полезные ресурсы.

Команда Tencent Hunyuan открыла исходный код фреймворка MixGRPO для повышения эффективности обучения с выравниванием человеческих предпочтений

Команда Tencent Hunyuan выпустила фреймворк MixGRPO с открытым исходным кодом, первый, который интегрирует скользящее окно смешанного ODE-SDE сэмплинга для GRPO, достигая до 71% ускорения обучения для выравнивания человеческих предпочтений в диффузионных и поточных моделях.

Black Forest Labs выпускает открытую версию FLUX.1 Krea [dev] с нативной поддержкой ComfyUI

Сотрудничество Black Forest Labs и Krea официально выпускает модель FLUX.1 Krea [dev], лучшую открытую модель FLUX для генерации изображений из текста. ComfyUI реализовал нативную поддержку, позволяя пользователям испытать новейшую технологию генерации изображений из текста.

Выпуск открытой версии WAN2.2 и нативная поддержка ComfyUI с первого дня

Команда WAN официально выпустила открытую версию Wan2.2 с инновационной архитектурой MoE, которая значительно улучшает качество генерации видео. ComfyUI реализовала нативную поддержку, позволяя пользователям напрямую опробовать новейшие технологии генерации видео.

ByteDance открывает исходный код Seed-X 7B: компактная модель перевода с поддержкой 28 языков

ByteDance открыла исходный код модели Seed-X 7B, специально разработанной для задач перевода. Модель поддерживает перевод между 28 языками и подходит для интеграции в различные сценарии, такие как генерация изображений с помощью ИИ.

PUSA V1.0: Доступная и высокоэффективная модель генерации видео

PUSA V1.0 использует инновационную технологию VTA для создания качественного видео с поддержкой множества задач при минимальных затратах данных и ресурсов, включая преобразование изображения в видео, генерацию ключевых кадров, расширение видео, генерацию видео по тексту и другие функции.

AMAP выпускает FLUX-Text: новый подход к редактированию текста в сценах

Команда AMAP выпускает FLUX-Text, новый метод редактирования текста в сценах на основе диффузии, поддерживающий многоязычность, согласованность стилей и высококачественное редактирование текста.

OmniAvatar: выпуск эффективной модели генерации видео виртуальных людей, управляемой аудио

Модель OmniAvatar теперь с открытым исходным кодом, поддерживает генерацию видео виртуальных людей в полный рост, управляемую аудио, с естественными движениями и богатыми выражениями, подходит для подкастов, взаимодействий, динамических сцен и различных применений.

Tongyi Lab выпускает ThinkSound: новая парадигма для многомодальной генерации и редактирования аудио

Tongyi Lab открывает исходный код ThinkSound, первой унифицированной системы генерации и редактирования аудио Any2Audio, поддерживающей цепочку рассуждений, позволяющей многомодальные входы, включая видео, текст и аудио, с высоким качеством, сильной синхронизацией и возможностями интерактивного редактирования.

Выпущен XVerse: модель генерации изображений с высокой согласованностью и контролем идентичности нескольких объектов и семантических атрибутов

ByteDance открывает исходный код модели XVerse, позволяющей точный независимый контроль нескольких идентичностей объектов и семантических атрибутов (как поза, стиль, освещение), улучшая персонализацию и возможности сложных сцен в генерации ИИ-изображений.

Выпущена версия Flux.1 Kontext Dev с открытым исходным кодом с нативной поддержкой ComfyUI

Black Forest Labs выпускает версию Flux.1 Kontext Dev с открытым исходным кодом, модель диффузионного трансформера с 12 миллиардами параметров, с немедленной нативной поддержкой в ComfyUI

Выпущен OmniGen2: унифицированная модель понимания и генерации изображений с инструкциями на естественном языке

VectorSpaceLab выпускает OmniGen2, мощную многомодальную модель генерации, которая поддерживает точное локальное редактирование изображений через инструкции на естественном языке, включая удаление и замену объектов, перенос стиля, обработку фона и многое другое

NVIDIA выпускает UniRelight - универсальная технология переосвещения на основе диффузии

Исследовательская команда NVIDIA представляет UniRelight, универсальную технологию переосвещения на основе диффузии, которая достигает высококачественных эффектов переосвещения через одно изображение или видео

Национальный университет Сингапура выпускает OmniConsistency - достижение согласованности стилизации изображений с низкими затратами

Команда NUS представляет проект OmniConsistency, достигающий уровня согласованности стилизации изображений GPT-4o всего с 2600 парами изображений и 500 часами обучения на GPU, теперь поддерживает узлы ComfyUI

Black Forest Labs выпускает FLUX.1 Kontext: набор моделей для контекстно-осведомленного редактирования изображений

Black Forest Labs запускает серию моделей FLUX.1 Kontext, первые, достигшие контекстно-осведомленного редактирования на основе текстовых и изображений входов, поддерживающие сохранение согласованности персонажей и функции локализованного редактирования

ID-Patch: новый метод для генерации персонализированных групповых фотографий с множественной идентичностью

ByteDance и Университет штата Мичиган совместно предлагают метод ID-Patch, достигая генерации персонализированных изображений с множественной идентичностью с улучшенным сохранением идентичности и эффективностью генерации, подходящий для групповых фотографий, рекламы и других многоперсональных сценариев.

Tencent открывает исходный код модели цифрового человека с речевым управлением HunyuanVideo-Avatar: генерация естественных видео цифрового человека из одного изображения и аудио

Tencent выпускает HunyuanVideo-Avatar, обеспечивая высококачественные, эмоционально контролируемые видео цифрового человека из изображений и аудио, подходящие для коротких видео, рекламы электронной коммерции и многого другого.

Pixel-Reasoner: выпущена модель визуального рассуждения на пиксельном уровне с открытым исходным кодом

Pixel-Reasoner, основанная на Qwen2, предлагает глобальное и локальное пиксельное визуальное понимание и рассуждение, поддерживает детальный анализ с увеличением и продвигает визуальные языковые модели.

Выпуск IndexTTS 1.5: высококачественная модель преобразования текста в речь для китайского и английского языков

IndexTTS выпускает версию 1.5 со значительно улучшенной стабильностью модели и производительностью английского языка, поддерживая исправление произношения пиньинь и управляемые пунктуацией паузы, превосходя основные TTS системы в множественных тестах

StepFun открывает исходный код Step1X-3D - высококачественная структура генерации 3D-активов

StepFun выпускает структуру Step1X-3D с открытым исходным кодом, которая генерирует высококачественную 3D-геометрию и текстуры из одиночных изображений, включая 2M высококачественный набор данных, полный код обучения и веса модели

BAGEL: ByteDance открывает исходный код унифицированной мультимодальной базовой модели для понимания и генерации текста, изображений и видео

ByteDance выпускает BAGEL, мультимодальную базовую модель с открытым исходным кодом с 7B активными параметрами, поддерживающую понимание и генерацию текста, изображений и видео, и достигающую сильных результатов на публичных бенчмарках.

Уведомление об обновлении: пользовательские узлы, влияющие на фронтенд ComfyUI

После недавних обновлений ComfyUI некоторые пользовательские узлы могут вызывать проблемы с фронтендом. Эта статья суммирует затронутые плагины и решения, рекомендуя своевременные обновления или удаление соответствующих плагинов.

Step1X-3D выпускает высококачественную генерацию 3D-активов и план открытого исходного кода

Команда Step1X-3D выпустила решение генерации высококачественных 3D-активов, сделав модели, наборы данных и код открытым исходным кодом, поддерживая различные задачи генерации 3D-активов и текстур.

Tencent выпускает мультимодальную систему генерации видео HunyuanCustom

Tencent представляет HunyuanCustom, мультимодальный фреймворк кастомизации видео, который поддерживает текстовые, изображения, аудио и видео условия, обеспечивая высокосогласованную генерацию видео в множественных сценариях

Insert Anything: фреймворк с открытым исходным кодом для бесшовной вставки изображений

Insert Anything - это унифицированный фреймворк с открытым исходным кодом, который может бесшовно вставлять элементы, такие как люди, объекты и одежда из референсных изображений в целевые сцены, поддерживая различные сценарии применения

FlexiAct: Гибкий контроль действий в гетерогенных сценариях

FlexiAct, совместно разработанный Университетом Цинхуа и Tencent ARC Lab, может переносить действия из референсного видео на любое целевое изображение, сохраняя согласованность идентичности

Step1X-Edit: Фреймворк редактирования изображений ИИ с открытым исходным кодом

Step1X-Edit - это мощный фреймворк редактирования изображений с открытым исходным кодом, который поддерживает редактирование изображений через инструкции на естественном языке, предлагая возможности, подобные GPT-4o и Gemini2 Flash

Flex.2-preview: Выпущена модель генерации изображений ИИ с открытым исходным кодом

Flex.2-preview - это модель диффузии текст-в-изображение с открытым исходным кодом с универсальным контролем и встроенными возможностями инпейнтинга, предоставляющая создателям более мощные инструменты генерации изображений

Sand AI выпускает MAGI-1: авторегрессивная генерация видео в масштабе

Sand AI открыл исходный код MAGI-1, авторегрессивной модели, которая генерирует видео по частям, предлагая версии с 24B и 4.5B параметрами и поддерживая множественные режимы генерации видео

Выпущен SkyReels-V2: Модель с открытым исходным кодом, поддерживающая генерацию видео бесконечной длины

SkyworkAI выпускает новую модель генерации видео с открытым исходным кодом SkyReels-V2, поддерживающую видео бесконечной длины с возможностями текст-в-видео и изображение-в-видео

Nari Labs выпускает модель Dia 1.6B для преобразования текста в диалоговую речь

Nari Labs представляет модель преобразования текста в речь с открытым исходным кодом Dia 1.6B, способную генерировать многохарактерные диалоги напрямую из текста с эмоциями и невербальной коммуникацией

Kunlun Wanwei выпускает SkyReels-V2 - модель генерации фильмов бесконечной длины

Команда SkyReels Kunlun Wanwei выпускает и открывает исходный код SkyReels-V2, первой в мире модели генерации фильмов бесконечной длины, использующей фреймворк Diffusion Forcing, способной производить высококачественный, длительный видеоконтент

Shakker Labs выпускает FLUX.1-dev-ControlNet-Union-Pro-2.0

Shakker Labs запускает новую модель FLUX.1-dev-ControlNet-Union-Pro-2.0 с оптимизированными эффектами контроля, поддержкой множественных режимов контроля и меньшим размером модели

Tencent Hunyuan и команда InstantX выпускают проект с открытым исходным кодом InstantCharacter

InstantCharacter - это инновационный метод без настройки, который обеспечивает генерацию с сохранением персонажа из одного изображения, поддерживая различные нисходящие задачи

FramePack: Эффективная модель предсказания следующего кадра для генерации видео

Разработанная Lvmin Zhang, технология FramePack сжимает контекст входного кадра, делая рабочую нагрузку генерации видео инвариантной к длине видео, позволяя обрабатывать многочисленные кадры даже на GPU ноутбуков

ByteDance выпускает Seaweed-7B: Экономически эффективная базовая модель генерации видео

Seaweed-7B достигает производительности, превосходящей модели с 14B параметрами, имея только 7 миллиардов параметров, при стоимости обучения всего в одну треть от отраслевых стандартов, принося новые возможности в область генерации видео

FloED: Эффективный инпейнтинг видео с открытым исходным кодом с оптическим потоком-направленной диффузией

Новый фреймворк инпейнтинга видео FloED выпустил свой код и веса, достигая более высокой согласованности видео и вычислительной эффективности через направление оптического потока

PixelFlow: Генеративные модели, работающие напрямую в пиксельном пространстве

PixelFlow инновационно работает в сыром пиксельном пространстве, упрощая процесс генерации изображений без необходимости предобученных вариационных автоэнкодеров, обеспечивая сквозно обучаемые модели

VAST-AI выпускает HoloPart: Технология генеративной амодальной сегментации 3D частей

HoloPart может разлагать 3D модели на полные, семантически значимые части, решая проблемы редактирования в создании 3D контента

VAST-AI и Университет Цинхуа открывают исходный код UniRig: Фреймворк для автоматического скелетного риггинга всех 3D моделей

UniRig использует авторегрессионные модели для генерации высококачественных скелетных структур и весов скиннинга для разнообразных 3D моделей, значительно упрощая рабочий процесс анимации

OmniSVG: Университет Фудань и StepFun запускают унифицированную модель генерации векторной графики

OmniSVG - это новая унифицированная мультимодальная модель генерации SVG, способная производить высокосложную, редактируемую векторную графику из различных входных данных, включая текст, изображения или ссылки на персонажей

TTT-Video: Технология для генерации длинных видео

Исследователи разрабатывают модель TTT-Video, используя технологию Test-Time Training на основе CogVideoX 5B, способную генерировать согласованные видео длиной до 63 секунд

ByteDance выпускает UNO: Расширение возможностей генерации от меньшего к большему

Команда ByteDance Creative Intelligence выпускает модель UNO, разблокируя большую управляемость через генерацию в контексте, достигая генерации высококачественных изображений от одного до множественных объектов

EasyControl: Новый фреймворк для эффективного и гибкого управления Diffusion Transformer

Команда Tiamat AI выпускает фреймворк EasyControl, добавляющий возможности условного управления к моделям DiT, теперь поддерживается в ComfyUI через плагин ComfyUI-easycontrol

HiDream-I1 - Выпуск с открытым исходным кодом - Модель генерации изображений следующего поколения

HiDream.ai выпускает HiDream-I1, новую модель генерации изображений из текста с открытым исходным кодом с 17B параметрами, которая превосходит существующие модели с открытым исходным кодом в множественных бенчмарках, поддерживая генерацию высококачественных изображений в различных стилях

Hi3DGen: новая платформа для генерации высококачественной 3D геометрии через нормальное мостирование

Команда Stable-X представляет Hi3DGen, инновационную платформу для генерации высококачественных 3D моделей из изображений, решая проблему отсутствия геометрических деталей в существующих методах через технологию нормального мостирования

VAST AI Research открывает исходный код TripoSF: переопределение новых высот в технологии 3D генерации

TripoSF, основанный на инновационном представлении SparseFlex, поддерживает генерацию 3D моделей с разрешением до 1024³, способен обрабатывать открытые поверхности и сложные внутренние структуры, значительно улучшая качество 3D активов

Kunlun Wanwei открывает исходный код SkyReels-A2: коммерческая платформа генерации видео

Kunlun Wanwei выпускает первую в мире коммерческую контролируемую платформу генерации видео SkyReels-A2, обеспечивающую генерацию многоэлементного видео через двухветвевую архитектуру, принося новые возможности для электронной коммерции, кинопроизводства и многого другого

Лаборатория Tongyi Alibaba выпускает VACE: создание и редактирование видео вступает в эпоху унификации

Лаборатория Tongyi группы Alibaba представляет VACE, первую в мире унифицированную платформу для разнообразных задач с видео, охватывающую генерацию видео из текста, редактирование видео и сложные комбинации задач

StarVector: мультимодальная модель для генерации SVG кода

Проект StarVector реализует автоматическую генерацию SVG векторной графики из изображений и текста, предоставляя новые творческие инструменты для дизайнеров и разработчиков.

ByteDance выпускает InfiniteYou: гибкое пересоздание фотографий с сохранением личности пользователя

ByteDance представляет InfiniteYou (InfU), инновационную платформу на основе Diffusion Transformers, которая обеспечивает гибкое пересоздание фотографий с сохранением личности пользователя, решая ограничения существующих методов в отношении сходства личности, выравнивания текст-изображение и качества генерации

Stability AI выпускает Stable Virtual Camera: технология для преобразования 2D фотографий в 3D видео

Stability AI запускает новую ИИ-модель Stable Virtual Camera, способную конвертировать обычные фотографии в 3D видео с аутентичными эффектами глубины и перспективы, предоставляя создателям интуитивный контроль камеры

StdGEN: семантически разложенная генерация 3D персонажей из одиночных изображений

Университет Цинхуа и Tencent AI Lab совместно представляют StdGEN, инновационный пайплайн, который генерирует высококачественных семантически разложенных 3D персонажей из одиночных изображений, обеспечивая разделение тела, одежды и волос

Tencent выпускает Hunyuan3D 2.0 - инновационная система генерации 3D активов

Tencent запускает систему Hunyuan3D 2.0 с двухэтапным процессом для генерации высококачественных 3D моделей, включая несколько серий моделей с открытым исходным кодом, которые поддерживают создание высокоразрешающих 3D активов из текста и изображений

Kuaishou запускает технологию ReCamMaster для перекадрирования моноскопического видео

Kuaishou Technology запустила ReCamMaster, технологию генеративного видео, которая позволяет пользователям создавать новые перспективы камеры и пути движения из одного видео.

Выпущен Open-Sora 2.0: коммерческая генерация видео по низкой цене

LuChen Technology выпускает Open-Sora 2.0, модель генерации видео с открытым исходным кодом, достигая производительности, близкой к топовым коммерческим моделям, всего за $200,000 в затратах на обучение

Лаборатория Ali Tongyi выпускает VACE: универсальная модель для создания и редактирования видео

Лаборатория Ali Tongyi запускает многофункциональную модель создания и редактирования видео VACE, интегрирующую различные задачи обработки видео в единую платформу для снижения порога видеотворчества

Microsoft выпускает технологию ART для генерации многослойных прозрачных изображений

Microsoft Research представляет интеллектуальную многослойную генерацию на основе глобальных текстовых подсказок, поддерживающую создание прозрачных изображений с 50+ независимыми слоями

Tencent открывает исходный код модели HunyuanVideo-I2V для преобразования изображений в видео

Команда Hunyuan Tencent выпускает модель с открытым исходным кодом для генерации 5-секундных видео из одиночных изображений, с интеллектуальной генерацией движения и пользовательскими эффектами

Alibaba открывает исходный код ViDoRAG - интеллектуального инструмента анализа документов

Alibaba представляет систему анализа документов, способную понимать как текст, так и изображения, улучшая эффективность обработки сложных документов более чем на 10%

THUDM открывает исходный код CogView4 — DiT-модель генерации изображений с поддержкой китайского языка

THUDM выпускает модель генерации изображений CogView4 с открытым исходным кодом и нативной поддержкой китайского языка, лидирующую в нескольких бенчмарках

Sesame представляет голосовую модель CSM для естественных разговоров

Sesame Research представляет двухтрансформерную разговорную голосовую модель CSM, достигающую человеческого взаимодействия с архитектурой открытого исходного кода

Модель генерации видео Wan2.1 от Alibaba официально открыта

Alibaba официально открыла исходный код своей последней модели генерации видео Wan2.1, которая может работать всего с 8GB видеопамяти, поддерживая генерацию видео высокой четкости, динамические субтитры и многоязычное дублирование, превосходя модели как Sora с общим баллом 86.22% в таблице лидеров VBench

Alibaba выпускает ComfyUI Copilot: ИИ-управляемый интеллектуальный помощник рабочих процессов

Группа международной цифровой коммерции Alibaba (AIDC-AI) выпускает плагин ComfyUI Copilot, упрощающий пользовательский опыт ComfyUI через естественное языковое взаимодействие и ИИ-управляемую функциональность, поддерживая китайское взаимодействие и предлагая интеллектуальные рекомендации узлов и другие функции

Модель генерации видео WanX 2.1 от Alibaba будет открыта

Alibaba объявила, что ее последняя модель генерации видео WanX 2.1 будет открыта во втором квартале 2025 года, поддерживая генерацию видео высокой четкости, динамические субтитры и многоязычное дублирование, занимая первое место в таблице лидеров VBench с общим баллом 84.7%

Google выпускает PaliGemma 2 Mix: открытая визуально-языковая модель с поддержкой множества задач

Google представляет новую модель PaliGemma 2 mix, поддерживающую различные визуальные задачи, включая описание изображений, OCR, детекцию объектов, с версиями на 3B, 10B и 28B параметров

Skywork открывает исходный код SkyReels-V1: модель генерации видео для создания ИИ-короткометражек

Skywork открыл исходный код своей последней модели генерации видео SkyReels-V1, которая поддерживает генерацию из текста в видео и из изображения в видео, с кинематографическими эффектами освещения и естественным представлением движения, и теперь доступна для коммерческого использования.

Light-A-Video - технология переосвещения видео без обучения

Исследователи предложили новый метод переосвещения видео Light-A-Video, который достигает временно плавных эффектов переосвещения видео через Consistent Light Attention (CLA) и Progressive Light Fusion (PLF).

StepFun выпускает Step-Video-T2V: модель генерации видео из текста с 300 миллиардами параметров

StepFun выпустил модель генерации видео из текста Step-Video-T2V с открытым исходным кодом, которая имеет 300 миллиардов параметров, поддерживает генерацию высококачественных видео до 204 кадров и предоставляет платформу для онлайн-опыта

Kuaishou представляет CineMaster: прорыв в 3D-осознанной генерации видео

Kuaishou официально выпускает фреймворк генерации видео из текста CineMaster, обеспечивающий создание высококачественного видеоконтента с помощью 3D-осознанных технологий

Alibaba открывает исходный код InspireMusic: инновационная платформа для генерации музыки, песен и аудио

Последний проект Alibaba с открытым исходным кодом — InspireMusic, единая платформа для генерации аудио на базе FunAudioLLM, поддерживающая создание музыки, песен и различные задачи синтеза звука.

Alibaba открывает исходный код ACE++: генерация изображений с согласованными персонажами без обучения

Исследовательский институт Alibaba открывает исходный код инструмента генерации изображений ACE++, поддерживающего генерацию изображений с согласованными персонажами из одного входного изображения благодаря технологии контекстно-осознанного заполнения, предлагая онлайн-демо и три специализированные модели.

ByteDance выпускает OmniHuman: фреймворк анимации человека следующего поколения

Исследовательская команда ByteDance выпускает фреймворк анимации человека OmniHuman-1, способный генерировать высококачественные анимации человека из одного изображения и сигналов движения.

DeepSeek открывает исходный код Janus-Pro-7B: мультимодальная ИИ-модель

TurboDiffusion выпускает фреймворк ускорения генерации видео

Команда Университета Цинхуа выпускает в открытый доступ TurboDiffusion, фреймворк ускорения генерации видео, который достигает 100-205x ускорения сквозной генерации диффузии на одной RTX 5090 при сохранении качества видео

Tencent выпускает Hunyuan3D 2.0: модель генерации 3D с открытым исходным кодом и сквозной движок создания

Tencent выпускает Hunyuan3D 2.0, открывая исходный код полной модели DiT и запуская универсальный движок 3D-создания с инновационными функциями, включая скелетную анимацию и создание 3D из эскизов, революционизируя создание контента для метавселенной и игр

Двухлетний юбилей проекта ComfyUI

ComfyUI празднует свой второй день рождения, эволюционировав от личного проекта до самого популярного в мире инструмента генеративного ИИ для визуализации. С днем рождения, ComfyUI!

NVIDIA открывает исходный код Sana - ИИ-модель для эффективной генерации 4K изображений

NVIDIA выпускает новую модель Sana, способную быстро генерировать изображения до 4K разрешения на GPU потребительских ноутбуков, с поддержкой интеграции ComfyUI

ByteDance открывает исходный код LatentSync - технология высокоточного синхронизации губ на основе диффузионной модели

ByteDance выпускает инструмент синхронизации губ с открытым исходным кодом LatentSync, основанный на диффузионной модели латентного пространства с аудио-условиями, обеспечивающий точную синхронизацию губ как для реальных людей, так и для анимированных персонажей, одновременно решая проблемы дрожания кадров, распространенные в традиционных методах

VMix: ByteDance представляет инновационную технологию эстетического улучшения для диффузионных моделей текст-в-изображение

ByteDance и Университет науки и технологий Китая совместно запускают адаптер VMix, улучшающий эстетику ИИ-генерированных изображений через технологию контроля смешивания кросс-внимания, бесшовно интегрируясь с существующими моделями без переобучения

Tencent открывает исходный код StereoCrafter: однокликовое преобразование 2D в 3D видео

StereoCrafter, совместно разработанный Tencent AI Lab и ARC Lab, теперь открыт для использования. Он может преобразовывать любое 2D видео в высококачественное стереоскопическое 3D видео, поддерживая различные 3D устройства отображения, включая Apple Vision Pro

LuminaBrush: AI-редактор освещения от создателя ControlNet

lllyasviel, создатель ControlNet и IC-Light, выпускает LuminaBrush — новый AI-инструмент, обеспечивающий точный контроль освещения через двухэтапную архитектуру с интуитивным управлением кистью

Genesis: выпущен прорывной универсальный физический движок и платформа генеративного ИИ

Проект Genesis выпускает новый универсальный физический движок и платформу генеративного ИИ, интегрируя физическое моделирование, управление роботами и возможности генеративного ИИ для предоставления комплексных решений для робототехники и физических приложений ИИ

Odyssey выпускает Explorer — генеративную модель для создания 3D-миров

Odyssey представила Explorer — первую генеративную модель, способную преобразовывать 2D-изображения в полноценные 3D-миры с поддержкой динамических эффектов и интеграцией с популярными инструментами для творчества. Решение открывает новые возможности для кино, игр и других сфер.

В плагине ComfyUI Impact-Pack обнаружен майнинг-вирус - требуется срочное действие

В популярном плагине ComfyUI Impact-Pack обнаружен майнинг-вредонос через пакет Ultralytics, затронувший многочисленных пользователей. В статье подробно описана ситуация с вирусом и решения.

Luma запускает Photon - революционную модель генерации изображений ИИ с исключительной ценностью

Luma представляет революционные модели генерации изображений Photon и Photon Flash, переопределяя ИИ-творчество с выдающейся ценностью и превосходным качеством изображений

Tencent открывает исходный код HunyuanVideo — новая эра генерации видео

Tencent официально открыла исходный код HunyuanVideo — самой крупной на данный момент модели генерации видео с 13 миллиардами параметров, которая демонстрирует высокие показатели качества видео и стабильности движения

Stability AI выпускает модели ControlNet для Stable Diffusion 3.5 Large

Stability AI представила три новые модели ControlNet для Stable Diffusion 3.5 Large: Blur, Canny и Depth, которые обеспечивают более точное управление генерацией изображений

NVIDIA выпускает Edify 3D — технология генерации 3D-ассетов

NVIDIA представила новую технологию Edify 3D, которая позволяет создавать качественные 3D-ассеты всего за две минуты, включая детализированную геометрию, чёткую топологию, текстуры высокого разрешения и материалы PBR.

Lightricks выпускает модель генерации видео в реальном времени LTX-Video

Lightricks представляет модель генерации видео LTX-Video на основе DiT, поддерживающую создание высококачественных видео в реальном времени. Модель доступна с открытым исходным кодом на GitHub и Hugging Face.

InstantX выпускает модель IP-Adapter для FLUX.1-dev

Команда InstantX выпустила модель IP-Adapter на базе FLUX.1-dev, расширяя возможности работы с изображениями для модели FLUX

Выпущен набор официальных инструментов FLUX

Black Forest Labs выпускает различные официальные инструменты FLUX, включая локальную перерисовку, ControlNet и конвертацию стилей изображений

Выпуск IC-Light V2: улучшенные возможности редактирования изображений

IC-Light V2 - это модель редактирования изображений на основе Flux, которая поддерживает различные стилизованные обработки изображений, включая масляные картины и аниме стили. В статье подробно описаны новые функции и применения IC-Light V2.

Запущен Stable Diffusion 3.5: новая эра в генерации изображений ИИ

Stability AI выпускает Stable Diffusion 3.5, предлагая множественные мощные варианты моделей, поддерживая коммерческое использование и лидируя на рынке в качестве изображений и следовании промптам.

Выпущен ComfyUI V1: кроссплатформенное десктопное приложение с однокликовой установкой

ComfyUI выпустил версию 1, предлагая кроссплатформенное десктопное приложение с однокликовой установкой, обновленный пользовательский интерфейс и многочисленные улучшения функций, значительно улучшающие пользовательский опыт.

Kuaishou и Пекинский университет совместно представили модель генерации видео Pyramidal Flow Matching

Kuaishou Technology и Пекинский университет совместно разработали модель Pyramidal Flow Matching — авторегрессионную технологию генерации видео на основе flow matching, способную создавать качественный видеоконтент большой продолжительности.

Jasperai выпускает серию моделей ControlNet для Flux.1-dev

Jasperai представляет серию моделей ControlNet для Flux.1-dev, включая модели для работы с картами нормалей, картами глубины и суперразрешением, обеспечивая более точный контроль при генерации изображений с помощью ИИ.

ComfyUI-PuLID-Flux: Реализация PuLID-Flux в ComfyUI

ComfyUI-PuLID-Flux - это проект с открытым исходным кодом, который интегрирует PuLID-Flux в ComfyUI, предлагая мощные возможности генерации и редактирования изображений.

Meta представляет Movie Gen: революционная система генерации видео и аудио на основе ИИ

Meta анонсирует Movie Gen - инновационную систему, которая может генерировать высококачественные видео и аудио одновременно, используя продвинутые технологии искусственного интеллекта. Эта система открывает новые возможности для создания мультимедийного контента.

Ostris выпускает OpenFlux1: открытая модель генерации изображений на основе Flux

Ostris объявляет о выпуске OpenFlux1 - открытой модели генерации изображений, основанной на архитектуре Flux. Эта модель предоставляет сообществу доступ к передовым технологиям генерации изображений с открытым исходным кодом.

Black Forest Labs представляет революционную генеративную модель ИИ Flux 1.1 Pro

Black Forest Labs выпускает Flux 1.1 Pro - революционную генеративную модель ИИ, которая устанавливает новые стандарты в области генерации изображений. Модель демонстрирует исключительное качество и производительность, открывая новые возможности для творческих профессионалов.

THUDM открывает исходный код новых моделей генерации изображений: CogView3 и CogView-3Plus

THUDM открыла исходный код своих новейших моделей генерации изображений CogView3 и CogView-3Plus-3B, демонстрируя выдающуюся производительность и эффективность. CogView3 использует каскадную диффузионную технологию, а CogView-3Plus-3B — это легковесная модель на архитектуре DiT, что открывает новые возможности для текст-в-изображение генерации.