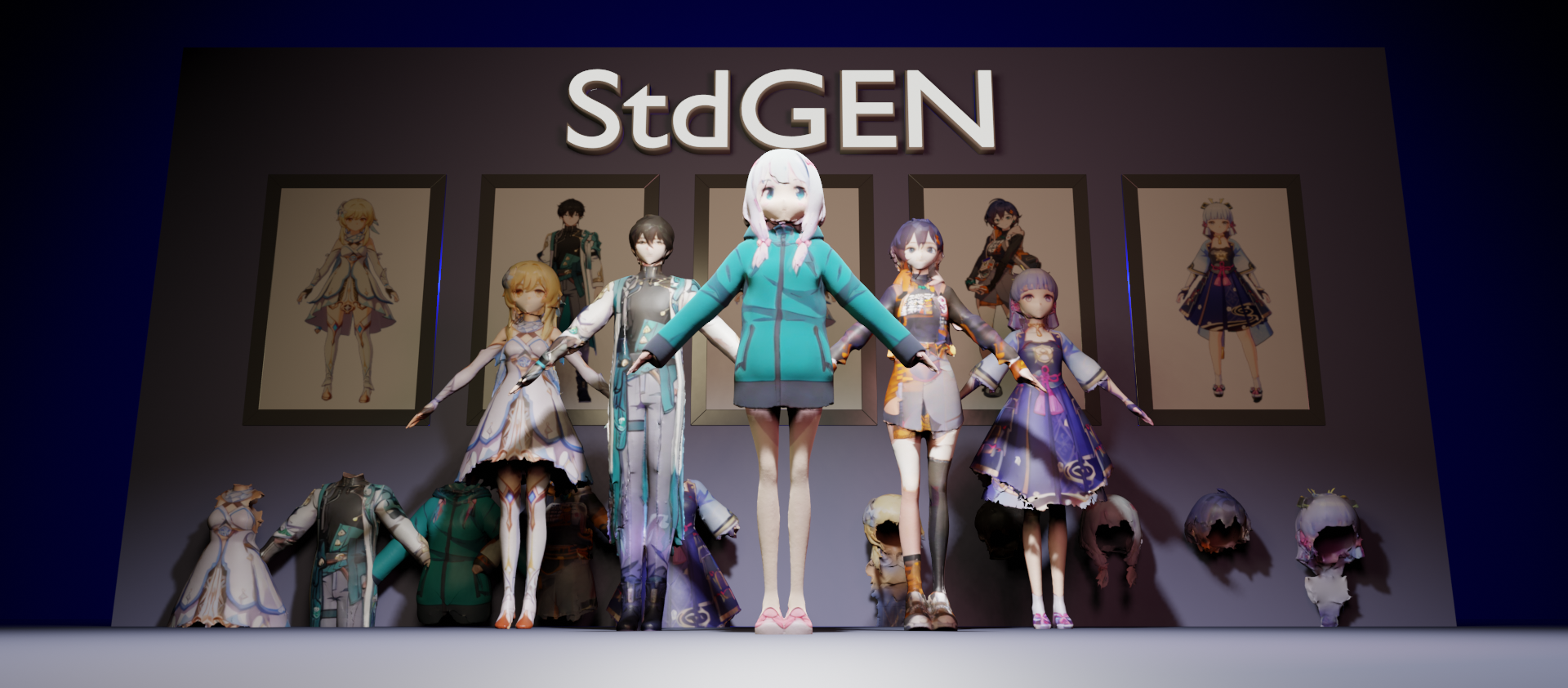

StdGEN: семантически разложенная генерация 3D персонажей из одиночных изображений

Исследователи из Университета Цинхуа и Tencent AI Lab недавно выпустили StdGEN (Semantic-Decomposed 3D Character Generation), инновационную технологию, способную генерировать высококачественные семантически разложенные 3D модели персонажей из одиночных изображений. Это исследование было принято ведущей конференцией по компьютерному зрению CVPR 2025.

Технические инновации

StdGEN реализует три ключевые функции через свой инновационный пайплайн:

- Семантическое разложение: Сгенерированные 3D модели персонажей могут быть полностью разделены на семантические компоненты, такие как тело, одежда и волосы, облегчая последующее редактирование и настройку.

- Эффективность: Процесс от одиночного изображения до полного 3D персонажа занимает всего 3 минуты.

- Высококачественная реконструкция: Сгенерированные 3D модели характеризуются тонкими геометрическими деталями и текстурами.

Основная технология

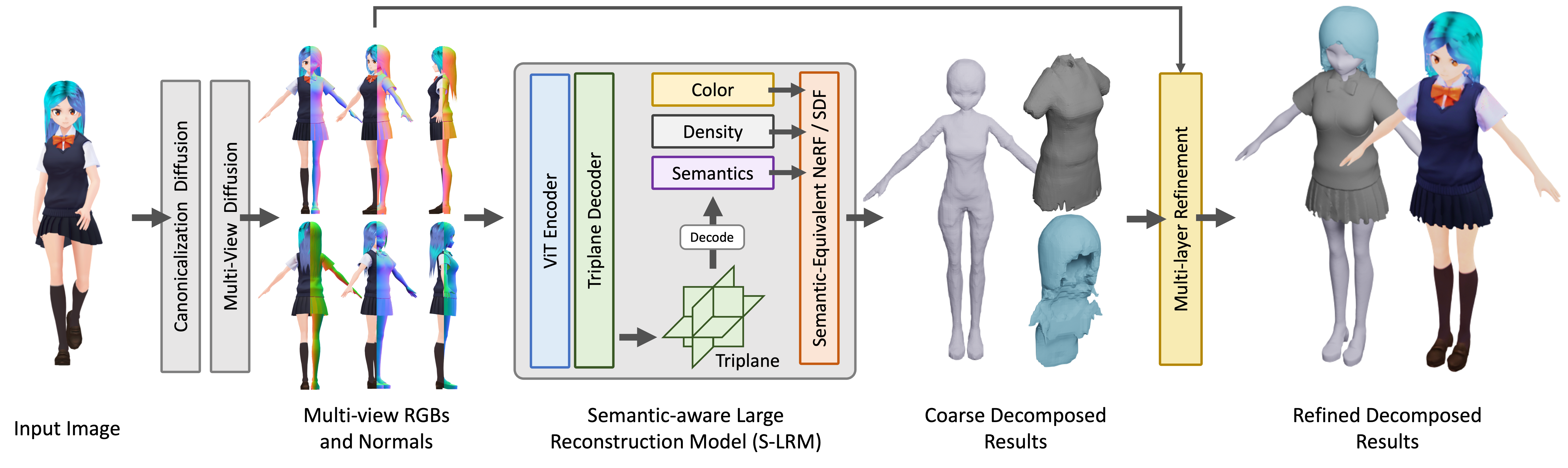

Ядром StdGEN является Semantic-aware Large Reconstruction Model (S-LRM), предложенная исследовательской командой. Это обобщаемая модель на основе Transformer, способная совместно реконструировать геометрию, цвет и семантическую информацию из многоракурсных изображений в прямом проходе.

Ядром StdGEN является Semantic-aware Large Reconstruction Model (S-LRM), предложенная исследовательской командой. Это обобщаемая модель на основе Transformer, способная совместно реконструировать геометрию, цвет и семантическую информацию из многоракурсных изображений в прямом проходе.

Кроме того, метод вводит следующие инновации:

- Дифференциальную многослойную схему извлечения семантической поверхности для получения мешей из гибридного неявного поля, реконструированного S-LRM

- Специализированную эффективную многоракурсную диффузионную модель

- Итеративный многослойный модуль уточнения поверхности

Перспективы применения

Эта технология имеет широкие перспективы применения в виртуальной реальности, разработке игр и кинопроизводстве. По сравнению с существующими методами, StdGEN достигает значительных улучшений в геометрии, текстуре и разложимости, предоставляя пользователям готовые к использованию семантически разложенные 3D персонажи, которые поддерживают гибкую настройку.

Исследовательская команда открыла исходный код вывода, наборы данных и предварительно обученные чекпоинты, а также предоставляет онлайн демонстрацию HuggingFace Gradio.