ByteDance представляет Sa2VA: Первую универсальную модель понимания изображений и видео

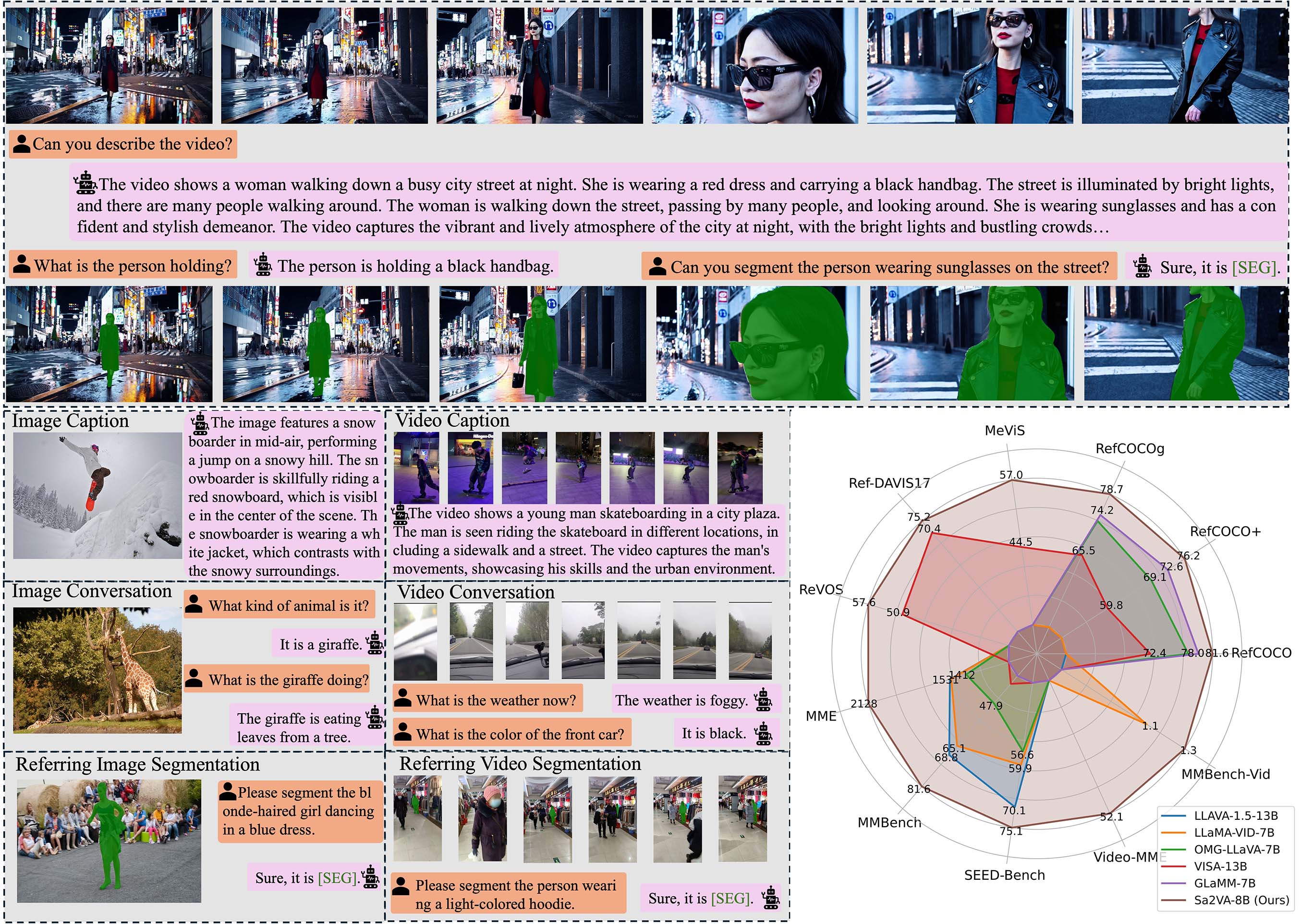

Сегодня ByteDance выпустила мультимодельную модель Sa2VA (SAM2 + LLaVA) на платформе Hugging Face. Это первая модель плотного сегментирования с пониманием, способная одновременно обрабатывать как изображения, так и видео. Sa2VA объединяет технологию сегментации SAM2 от Meta с возможностями визуального ответа на вопросы LLaVA, добавляя понимание визуальных подсказок и плотную сегментацию объектов, при этом сохраняя производительность в ответах на вопросы, сопоставимую с передовыми мультимодельными моделями.

Технические особенности: Новый прорыв в мультимодальном понимании

Ключевым инновационным решением Sa2VA является органическое объединение двух передовых технологий:

1. Возможности визуального сегментирования

- Плотная сегментация объектов: Способность точно идентифицировать и сегментировать несколько объектов на изображениях и видео

- Понимание визуальных подсказок: Поддержка интерактивной сегментации через визуальные сигналы, такие как маски

- Послекадровая согласованность: Поддержание временной непрерывности сегментации объектов при обработке видео

2. Мультимодальное ответы на вопросы

- Понимание изображений: Предоставление подробных описаний и анализа изображений

- Анализ видео: Понимание временных динамических изменений в видео контенте

- Интерактивный диалог: Поддержка многооборотных разговоров на основе визуального контента

Серия моделей: Различные спецификации для удовлетворения различных потребностей

ByteDance создала полное семейство моделей Sa2VA на основе серий Qwen2.5-VL и InternVL:

| Название модели | Базовая модель | Языковая модель | Объем параметров |

|---|---|---|---|

| Sa2VA-InternVL3-2B | InternVL3-2B | Qwen2.5-1.5B | 2 млрд |

| Sa2VA-InternVL3-8B | InternVL3-8B | Qwen2.5-7B | 8 млрд |

| Sa2VA-InternVL3-14B | InternVL3-14B | Qwen2.5-14B | 14 млрд |

| Sa2VA-Qwen2_5-VL-3B | Qwen2.5-VL-3B | Qwen2.5-3B | 3 млрд |

| Sa2VA-Qwen2_5-VL-7B | Qwen2.5-VL-7B | Qwen2.5-7B | 7 млрд |

Производительность: Лидирующие результаты в нескольких основных тестах

Sa2VA демонстрирует отличные результаты в нескольких стандартных тестах:

Возможности визуального ответа на вопросы

- Тест MME: Sa2VA-InternVL3-14B достигла 1746/724 баллов

- MMBench: 84.3 балла, приближаясь к уровням профессиональных моделей визуального понимания

Производительность задач сегментации

- Серия RefCOCO: Отлично справилась с задачами сегментации по референтным выражениям

- Сегментация видео: Достигла наилучших результатов в тестах MeVIS и DAVIS

Сценарии применения: Широкая практическая ценность

Унифицированная архитектура Sa2VA открывает новые возможности в нескольких областях:

1. Создание контента

- Редактирование видео: Автоматически идентифицирует и сегментирует объекты в видео, упрощая процессы пост-продакшена

- Аннотация изображений: Предоставляет точную сегментацию объектов и описания для больших наборов данных изображений

2. Образование и обучение

- Интерактивное преподавание: Помогает студентам понимать сложные концепции с помощью визуальных подсказок и ответов на вопросы

- Анализ контента: Автоматически анализирует ключевые информационные точки в обучающих видео

3. Безопасность и видеонаблюдение

- Интеллектуальный анализ: Анализ поведения людей и объектов в видео наблюдения в режиме реального времени

- Обнаружение аномалий: Идентифицирует аномальные ситуации, объединяя возможности визуального понимания и сегментации

4. Медицинская визуализация

- Вспомогательная диагностика: Анализирует медицинские изображения и предоставляет подробные региональные описания

- Локализация поражений: Точно сегментирует и аннотирует области интереса

Ресурсы с открытым исходным кодом и доступ

Sa2VA использует стратегию выпуска с открытым исходным кодом, обеспечивая удобство для исследователей и разработчиков:

Официальные ссылки на ресурсы:

- Домашняя страница проекта: GitHub Sa2VA

- Статья: arXiv:2501.04001

- Загрузка модели: Hugging Face серия Sa2VA

Выпуск Sa2VA знаменует эволюцию мультимодального ИИ в более унифицированном и практическом направлении. Подход к дизайну, глубоко интегрирующий визуальное сегментирование с языковым пониманием, открывает новые возможности для будущих приложений ИИ.