HiDream-I1 - это модель генерации изображений по тексту, официально открытая HiDream-ai 7 апреля 2025 года, с масштабом параметров 17B.

Тип лицензии Выпущена под MIT License, поддерживает использование для личных проектов, научных исследований и коммерческих целей. Модель показала хорошие результаты в множественных тестах производительности.

В этой статье мы рассмотрим следующее:

- Краткое введение в HiDream-I1

- Информация о различных версиях модели HiDream-I1, доступных в сообществе, и их поддержка

- Рабочие процессы для различных версий моделей

Поскольку полная версия этой модели имеет высокие требования к VRAM, вы можете выбрать версию, подходящую для вашего устройства, из раздела моделей сообщества и изучить соответствующие рабочие процессы. Пожалуйста, не забудьте обратиться к этой статье Обновление ComfyUI до последней версии, чтобы убедиться, что соответствующие узлы могут функционировать должным образом.

Введение в HiDream-I1

Особенности модели

Гибридная архитектура Объединяет диффузионные модели (DiT) с архитектурой смеси экспертов (MoE):

- Основная часть основана на Diffusion Transformer (DiT), обрабатывает мультимодальную информацию через двухпотоковый модуль MMDiT, в то время как однопотоковый модуль DiT оптимизирует глобальную согласованность.

- Механизм динамической маршрутизации гибко распределяет вычислительные ресурсы, улучшая способность обработки сложных сцен, и отлично работает в восстановлении цвета, обработке краев и других деталях.

Интеграция мультимодальных текстовых энкодеров Интегрирует четыре текстовых энкодера:

- OpenCLIP ViT-bigG, OpenAI CLIP ViT-L (визуально-семантическое выравнивание)

- T5-XXL (парсинг длинного текста)

- Llama-3.1-8B-Instruct (понимание инструкций) Эта комбинация достигает передовой производительности в сложном семантическом парсинге, связанном с цветом, количеством, пространственными отношениями и т.д., с значительно лучшей поддержкой китайских промптов по сравнению с аналогичными моделями с открытым исходным кодом.

Оригинальный репозиторий модели

HiDream-ai предоставляет три версии модели HiDream-I1 для удовлетворения различных потребностей сценариев. Ниже приведены ссылки на оригинальные репозитории моделей:

- Полная версия: 🤗 HiDream-I1-Full с 50 шагами вывода

- Дистиллированная версия для разработки: 🤗 HiDream-I1-Dev с 28 шагами вывода

- Дистиллированная быстрая версия: 🤗 HiDream-I1-Fast с 16 шагами вывода

Версии модели HiDream-I1 в сообществе

В настоящее время в сообществе существует множество вариантов версий модели HiDream-I1. Это коллекция существующих версий, организованная ComfyUI-Wiki. Однако из-за некоторых проблем, с которыми я столкнулся во время тестирования, я предоставлю только соответствующие рабочие процессы.

Переупакованные версии от ComfyOrg

Репозиторий ComfyOrg предлагает переупакованные версии Full, Dev и Fast, включая как полную версию, так и версию fp8. Полная версия требует примерно 20 ГБ VRAM, в то время как версия fp8 требует около 16 ГБ VRAM. Мы будем использовать нативный пример для завершения рабочего процесса.

Модели в формате GGUF

GGUF-версии моделей предоставлены пользователем city96:

В репозитории содержатся различные варианты моделей — от Q8 до Q2. Для запуска Q4 потребуется примерно 12 ГБ видеопамяти, а для Q2 — около 8 ГБ. Если вы не уверены, начните с самой маленькой версии для тестирования.

Для загрузки моделей необходимо использовать узел Unet loader(GGUF) из расширения ComfyUI-GGUF. Для завершения рабочего процесса потребуется небольшая модификация официальных узлов.

Модели в формате NF4

Эта версия использует 4-битную квантизацию для снижения потребления памяти и может работать примерно с 16 ГБ видеопамяти.

- HiDream-I1-Full-nf4

- HiDream-I1-Dev-nf4

- HiDream-I1-Fast-nf4

- Для работы с моделями NF4 используйте узел ComfyUI-HiDream-Sampler. Этот узел изначально был предоставлен lum3on.

ComfyUI-HiDream-Sampler автоматически скачает необходимые модели при первом запуске и реализует неофициальную функцию image-to-image. В этом руководстве также будут приведены соответствующие примеры.

Установка общих моделей

Ниже перечислены файлы моделей, которые используются в нескольких рабочих процессах. Вы можете заранее их скачать и ознакомиться с расположением файлов. Ссылки на скачивание диффузионных моделей будут приведены в соответствующих разделах.

Текстовые энкодеры:

- clip_l_hidream.safetensors

- clip_g_hidream.safetensors

- t5xxl_fp8_e4m3fn_scaled.safetensors — это облегчённая версия T5XXL, возможно, она у вас уже есть.

- llama_3.1_8b_instruct_fp8_scaled.safetensors

VAE

- ae.safetensors — это VAE-модель из Flux. Если вы уже использовали workflow Flux, этот файл у вас есть.

Диффузионные модели Ссылки на скачивание соответствующих моделей будут приведены в нужных разделах руководства.

Расположение файлов моделей

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 text_encoders/

│ │ ├─── clip_l_hidream.safetensors

│ │ ├─── clip_g_hidream.safetensors

│ │ ├─── t5xxl_fp8_e4m3fn_scaled.safetensors

│ │ └─── llama_3.1_8b_instruct_fp8_scaled.safetensors

│ └── 📂 vae/

│ │ └── ae.safetensors

│ └── 📂 diffusion_models/

│ └── ... # Установка будет описана в соответствующем разделе workflow Нативный workflow HiDream-I1 для ComfyUI

Нативный workflow подробно описан в официальной документации, которую я написал для Comfy: ComfyUI Native HiDream-I1 Workflow Example. Однако, поскольку официальная документация доступна только на китайском и английском языках, я также приведу соответствующие примеры в этом руководстве, учитывая многоязычную поддержку ComfyUI Wiki.

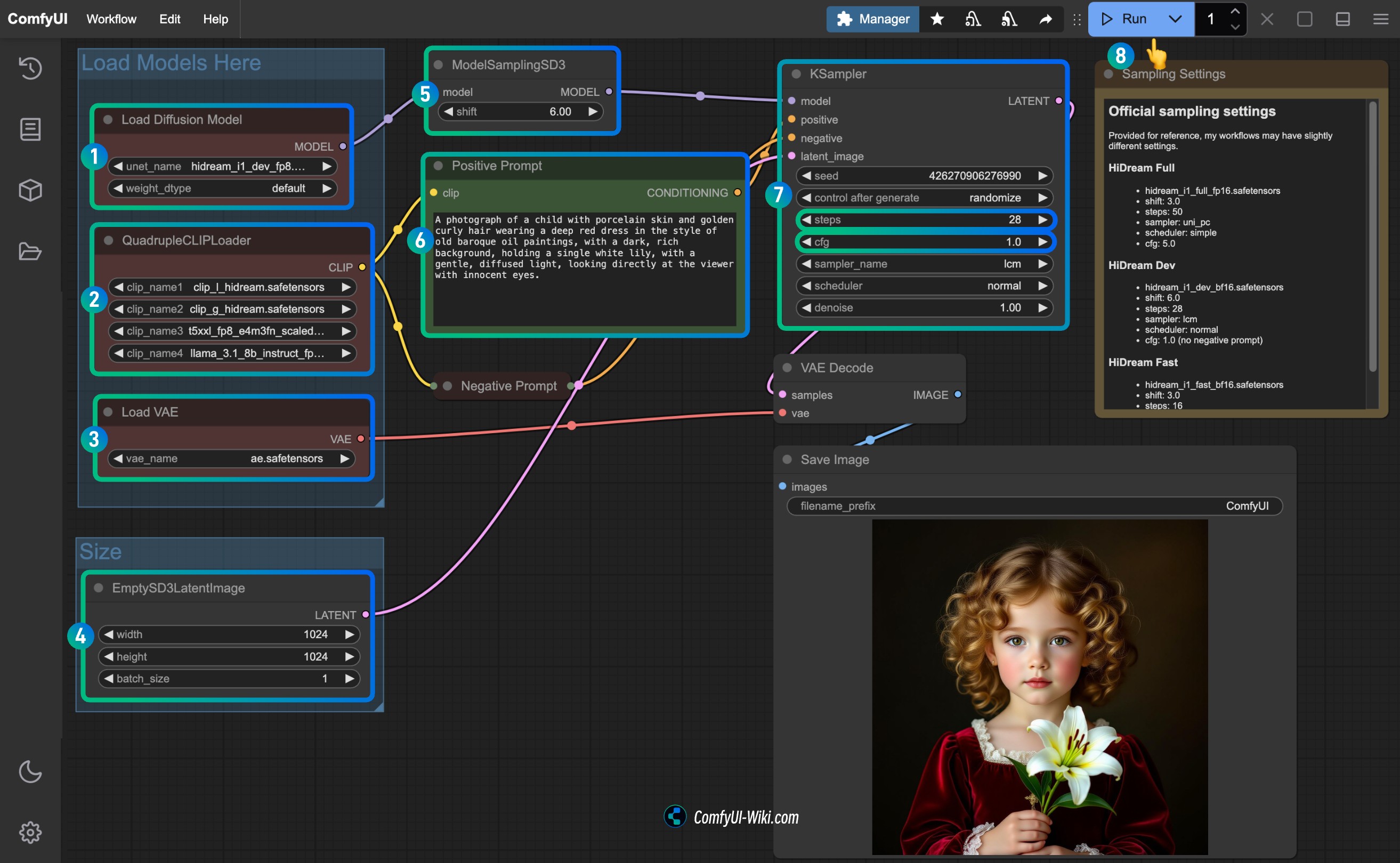

В официальной документации приведены полные workflows для версий full, dev и fast. Эти три workflow в целом используют одни и те же модели и последовательности, различаясь только некоторыми параметрами и файлами моделей. Поэтому здесь мы рассмотрим только одну версию workflow и дополним настройки для двух других, чтобы избежать излишнего повторения.

1. Загрузка файла workflow

Пожалуйста, скачайте изображение ниже и перетащите его в ComfyUI для загрузки соответствующего workflow. Файл содержит встроенную информацию о скачивании моделей, и ComfyUI проверит наличие соответствующих файлов моделей в подкаталогах первого уровня. Однако он не сможет проверить наличие файлов моделей во вложенных подкаталогах, например, ComfyUI/models/text_encoders/hidream/.

Если вы уже скачали соответствующие модели, можете проигнорировать предупреждения. Приведённый ниже workflow использует модель hidream_i1_dev_fp8.safetensors. Если вам нужна другая версия, обратитесь к разделу ручной загрузки моделей.

Скачать workflow в формате JSON:

2. Ручная загрузка моделей

Ниже приведены файлы моделей для разных версий HiDream-I1. Выберите подходящую версию в зависимости от объёма вашей видеопамяти и сохраните её в папку ComfyUI/models/diffusion_models/.

| Имя модели | Версия | Точность | Размер файла | Требования к VRAM | Ссылка для скачивания |

|---|---|---|---|---|---|

| hidream_i1_full_fp16.safetensors | full | fp16 | 34.2 GB | 20GB | Скачать |

| hidream_i1_dev_bf16.safetensors | dev | bf16 | 34.2 GB | 20GB | Скачать |

| hidream_i1_fast_bf16.safetensors | fast | bf16 | 34.2 GB | 20GB | Скачать |

| hidream_i1_full_fp8.safetensors | full | fp8 | 17.1 GB | 16GB | Скачать |

| hidream_i1_dev_fp8.safetensors | dev | fp8 | 17.1 GB | 16GB | Скачать |

| hidream_i1_fast_fp8.safetensors | fast | fp8 | 17.1 GB | 16GB | Скачать |

Для справки: версия dev fp8 генерирует первое изображение за 62 секунды, второе — за 20 секунд на 4090 с 24ГБ VRAM.

3. Пошаговое выполнение workflow

Пошаговая инструкция:

- Убедитесь, что узел

Load Diffusion Modelиспользует файлhidream_i1_dev_fp8.safetensorsили ту версию, которую вы скачали. - Проверьте, что четыре текстовых энкодера в узле

QuadrupleCLIPLoaderзагружены корректно:- clip_l_hidream.safetensors

- clip_g_hidream.safetensors

- t5xxl_fp8_e4m3fn_scaled.safetensors

- llama_3.1_8b_instruct_fp8_scaled.safetensors

- Убедитесь, что узел

Load VAEиспользует файлae.safetensors. - Для версии dev установите параметр

shiftв узлеModelSamplingSD3: 3.0 для full, 6.0 для dev, 3.0 для fast. - В узле

Ksamplerнастройте параметры в зависимости от версии модели:steps: 50 для full, 28 для dev, 16 для fast.cfg: 5.0 для full, 1.0 для dev и fast (для dev и fast не используются negative prompts).- (Опционально)

sampler: lcm. - (Опционально)

scheduler: normal.

- Нажмите кнопку

Runили используйте сочетание клавишCtrl(cmd) + Enterдля запуска генерации изображения.

4. Настройки параметров для разных версий моделей HiDream-I1

Вы можете использовать соответствующий workflow из шаблонов ComfyUI. При сотрудничестве с ComfyOrg для выпуска поддержки моделей я уже задал нужные параметры для каждой версии.

HiDream Full

- Файл модели: hidream_i1_full_fp16.safetensors

- Параметр

shiftв узлеModelSamplingSD3: 3.0 - Узел

Ksampler:- steps: 50

- sampler: uni_pc

- scheduler: simple

- cfg: 5.0

HiDream Dev

- Файл модели: hidream_i1_dev_bf16.safetensors

- Параметр

shiftв узлеModelSamplingSD3: 6.0 - Узел

Ksampler:- steps: 28

- sampler: lcm

- scheduler: normal

- cfg: 1.0 (без negative prompts)

HiDream Fast

- Файл модели: hidream_i1_fast_bf16.safetensors

- Параметр

shiftв узлеModelSamplingSD3: 3.0 - Узел

Ksampler:- steps: 16

- sampler: lcm

- scheduler: normal

- cfg: 1.0 (без negative prompts)

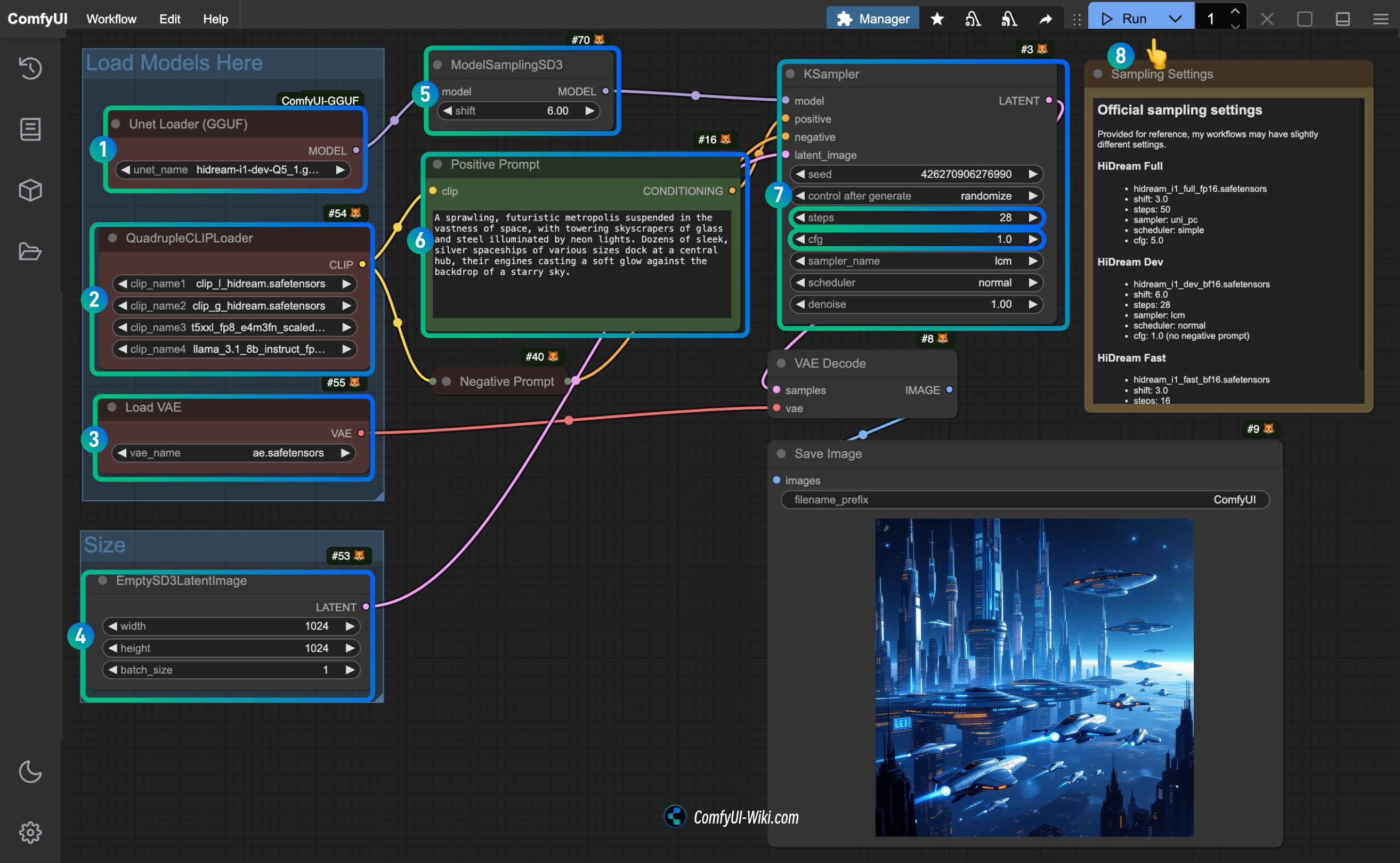

Workflow HiDream-I1 GGUF версии

GGUF-версия использует модель в формате GGUF, предоставленную city96. Мы немного модифицируем официальные узлы для завершения workflow.

Вам нужно установить плагин ComfyUI-GGUF или обновить уже установленную версию и использовать узел Unet loader(GGUF) для загрузки модели. Позже вы можете загрузить мой workflow и воспользоваться функцией проверки недостающих узлов в ComfyUI-Manager для установки нужных узлов, либо вручную установить их по инструкции.

1. Ручная загрузка моделей

Встраивание информации о моделях в файлы workflow ComfyUI поддерживается только для файлов .sft и .safetensors, поэтому для GGUF-версии модель нужно скачать вручную.

В соответствующих репозиториях full, dev и fast доступны несколько вариантов моделей от Q8 до Q2 для каждой версии. Выберите подходящую под вашу видеопамять и скачайте в папку ComfyUI/models/diffusion_models/.

Для справки: версия dev-Q5-1 генерирует первое изображение за 162 секунды, второе — за 58 секунд на 4090 с 24ГБ VRAM.

Для остальных необходимых моделей смотрите раздел установка общих моделей.

2. Файл workflow

Пожалуйста, скачайте изображение ниже и перетащите его в ComfyUI для загрузки соответствующего workflow.

Скачать workflow в формате JSON:

3. Пошаговое выполнение workflow

Поскольку мы заменили только узел Load Diffusion Model на Unet loader(GGUF), всё остальное полностью совпадает с оригинальным workflow.

Пошаговая инструкция:

- Убедитесь, что узел

Unet loader(GGUF)использует скачанный вами файл модели GGUF. - Проверьте, что четыре текстовых энкодера в узле

QuadrupleCLIPLoaderзагружены корректно:- clip_l_hidream.safetensors

- clip_g_hidream.safetensors

- t5xxl_fp8_e4m3fn_scaled.safetensors

- llama_3.1_8b_instruct_fp8_scaled.safetensors

- Убедитесь, что узел

Load VAEиспользует файлae.safetensors. - Для версии dev установите параметр

shiftв узлеModelSamplingSD3: 3.0 для full, 6.0 для dev, 3.0 для fast. - В узле

Ksamplerнастройте параметры в зависимости от версии модели:steps: 50 для full, 28 для dev, 16 для fast.cfg: 5.0 для full, 1.0 для dev и fast (для dev и fast не используются negative prompts).- (Опционально)

sampler: lcm. - (Опционально)

scheduler: normal.

- Нажмите кнопку

Runили используйте сочетание клавишCtrl(cmd) + Enterдля запуска генерации изображения.

4. Настройки параметров для разных моделей HiDream-I1 GGUF

Смотрите настройки в разделе оригинального workflow.

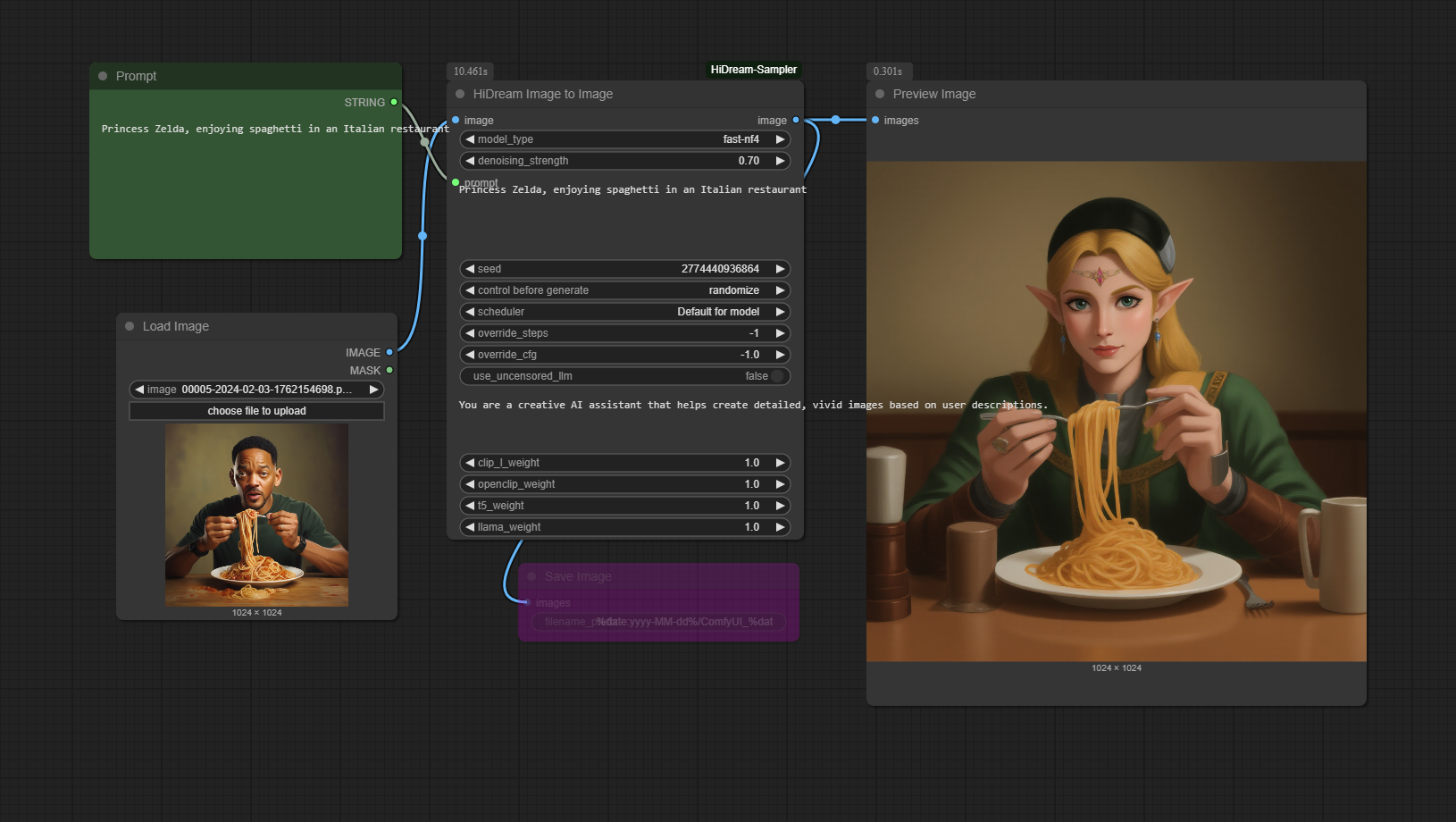

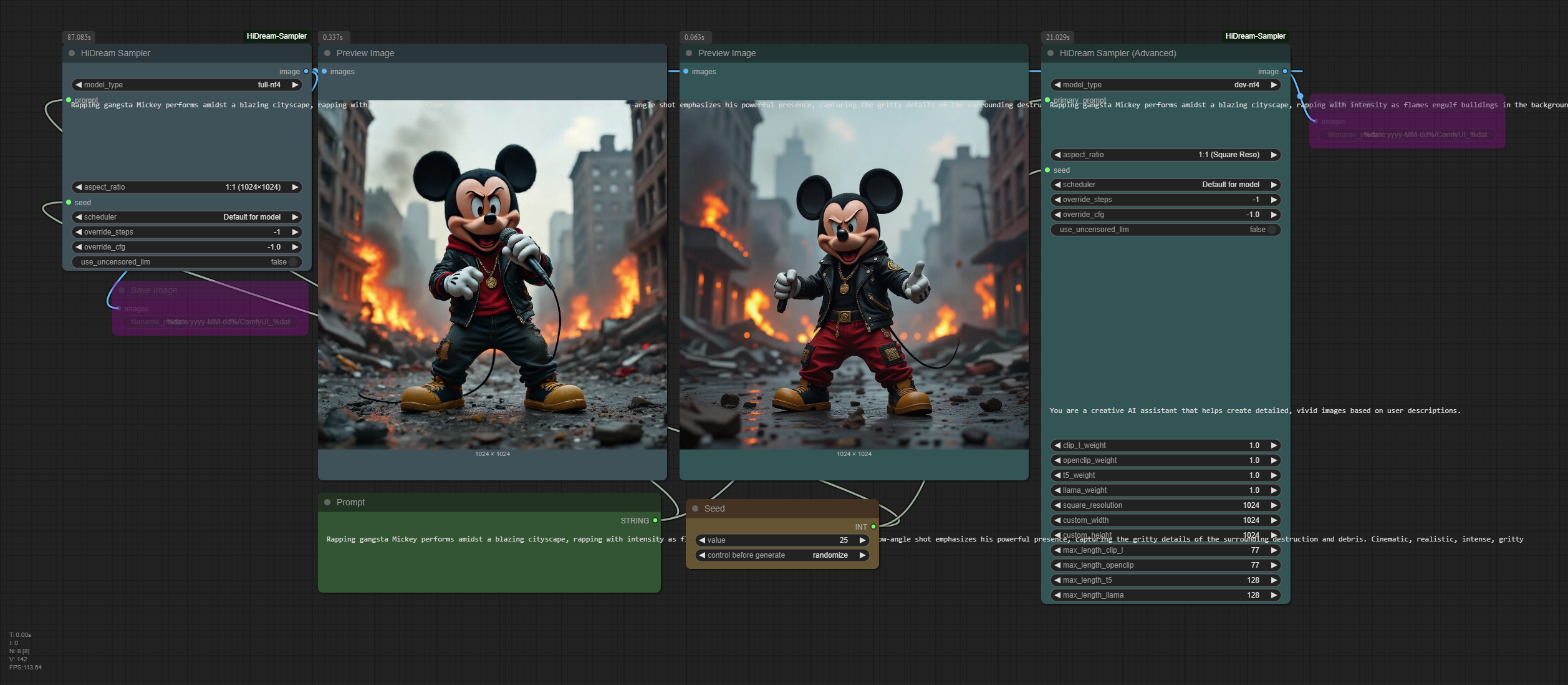

Workflow HiDream-I1 NF4 версии

Для этой версии требуется установка плагина ComfyUI-HiDream-Sampler, изначально созданного lum3on.

Узел должен автоматически скачать модель, но я заметил, что после установки не появляется лог загрузки, и нельзя вручную установить модель или выбрать её расположение, что немного неудобно. Тем не менее, в их примерах workflow уже реализована функция image-to-image. После установки вы должны найти папку sample-workflow в соответствующем каталоге или получить её по ссылке sample-workflow. Ниже приведены изображения с соответствующими workflow. Если у вас получилось протестировать, пожалуйста, напишите в комментариях, как это сделать. :)

Workflow текст-в-изображение

Workflow изображение-в-изображение