Wan2.1 Fun Control ComfyUI Workflows — Полное руководство

Wan2.1-Fun-Control — это последняя функция управления видео, представленная командой Alibaba. Она позволяет использовать различные методы управления видео, такие как глубина, openpose и canny. В настоящее время модель доступна в двух вариантах: 1.3B и 14B.

- Wan2.1-Fun-1.3B-Control

- Wan2.1-Fun-14B-Control

- Репозиторий с исходным кодом: VideoX-Fun

В этом руководстве рассматриваются два типа рабочих процессов (workflow):

-

Родной рабочий процесс ComfyUI

- Полностью нативный (не требует сторонних пользовательских узлов)

- Улучшенная версия нативного рабочего процесса (с использованием пользовательских узлов)

-

Рабочий процесс с использованием ComfyUI-WanVideoWrapper от Kijai

- Оба рабочих процесса используют одни и те же модели, но источники моделей могут отличаться для лучшей совместимости с оригинальными рабочими процессами и моделями.

- Для работы с видео можно использовать пакет пользовательских узлов ComfyUI-VideoHelperSuite, который позволяет загружать видео, сохранять в mp4, объединять и выполнять другие операции с видео.

- Для установки плагинов ознакомьтесь с руководством по установке пользовательских узлов.

Родной рабочий процесс Wan2.1 Fun Control в ComfyUI

В настоящее время ComfyUI официально поддерживает модель Wan Fun Control, однако на момент написания (2025-04-10) официального примера рабочего процесса ещё нет.

Перед началом убедитесь, что ваша версия ComfyUI не ниже этого коммита, чтобы вы могли найти соответствующий узел WanFunControlToVideo. Для обновления ComfyUI ознакомьтесь с инструкцией как обновить ComfyUI.

1.1 Загрузка файла рабочего процесса Wan2.1 Fun Control

1.1.1 Файл рабочего процесса

Скачайте изображение ниже и перетащите его в ComfyUI — это загрузит соответствующий рабочий процесс и предложит скачать модель.

Скачать в формате Json

1.1.2 Исходный кадр и управляющее видео

Скачайте изображения и видео ниже — они будут использоваться в качестве входных данных.

- Здесь предоставлено предварительно обработанное управляющее видео, чтобы можно было использовать только нативные узлы без сторонних пользовательских узлов.

- Для предварительной обработки видео можно использовать пользовательские узлы, такие как ComfyUI-comfyui_controlnet_aux.

1.2 Ручная установка моделей

Если модель не загрузилась автоматически, ниже приведены ссылки для скачивания.

Diffusion models Выберите между 1.3B или 14B. Модель 14B больше по размеру и требует более производительного оборудования, но обеспечивает более высокое качество.

- Wan2.1-Fun-1.3B-Control: После скачивания переименуйте файл в

Wan2.1-Fun-1.3B-Control.safetensors - Wan2.1-Fun-14B-Control: После скачивания переименуйте файл в

Wan2.1-Fun-14B-Control.safetensors

Text encoders Выберите одну из двух моделей ниже. Версия fp16 больше по размеру и требует более мощного оборудования.

VAE

CLIP Vision Используется для извлечения признаков изображения

Место для сохранения файлов

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └── Wan2.1-Fun-1.3B-Control.safetensors # или версия, которую вы выбрали

│ ├── 📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # или версия, которую вы выбрали

│ └── 📂 vae/

│ │ └── wan_2.1_vae.safetensors

│ └── 📂 clip_vision/

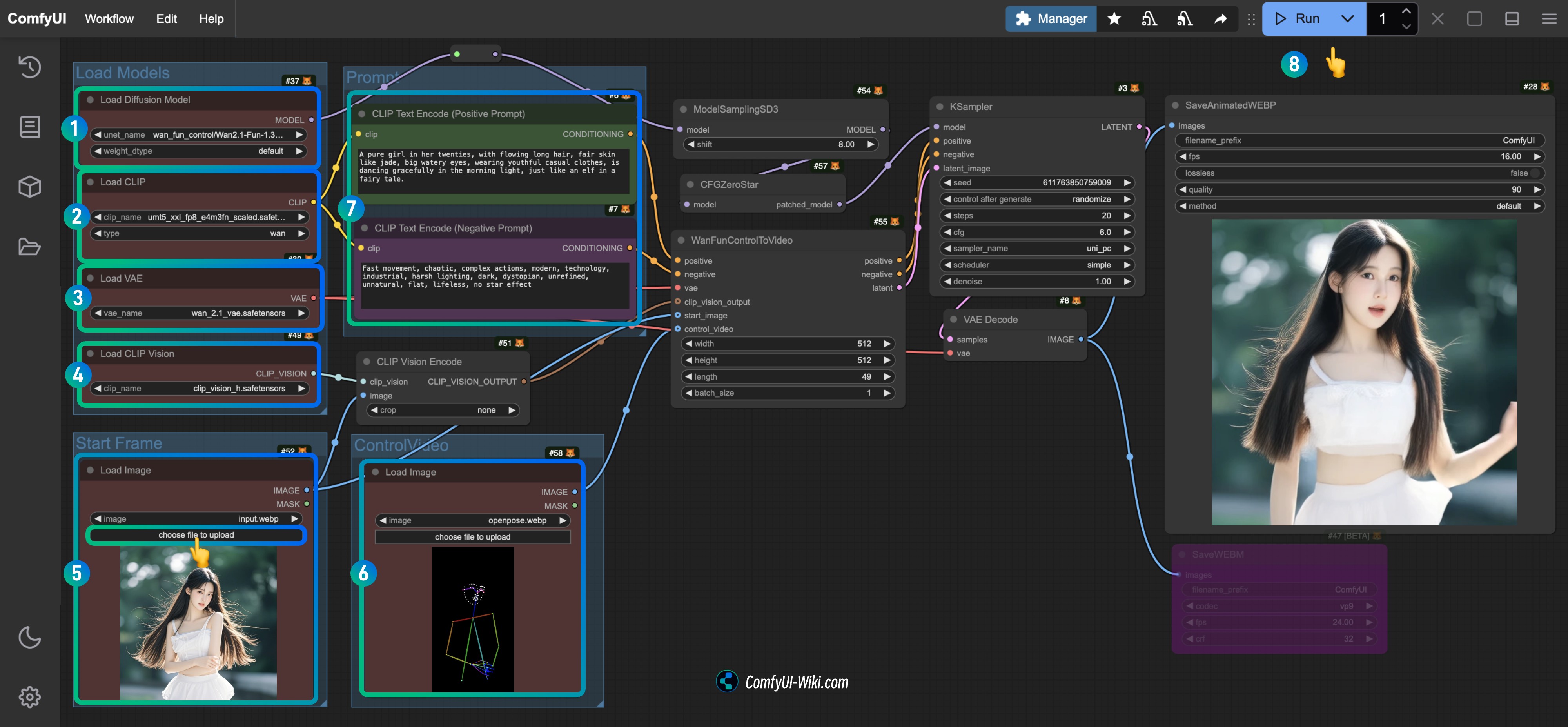

│ └── clip_vision_h.safetensors 1.3 Пошаговое выполнение рабочего процесса

- Убедитесь, что узел

Load Diffusion Modelзагрузил модельWan2.1-Fun-1.3B-Control.safetensors. - Убедитесь, что узел

Load CLIPзагрузил модельumt5_xxl_fp8_e4m3fn_scaled.safetensors. - Убедитесь, что узел

Load VAEзагрузил модельwan_2.1_vae.safetensors. - Убедитесь, что узел

Load CLIP Visionзагрузил модельclip_vision_h.safetensors. - Загрузите предоставленное входное изображение в узел

Load Imageв качестве стартового кадра. - Загрузите предоставленное видео в узел

Load Imageв качестве управляющего условия. - (Необязательно) Измените текстовый промпт для видео в узле

CLIP Text Encoder. - Нажмите кнопку

Runили используйте сочетание клавишCtrl(cmd) + Enterдля запуска генерации видео.

1.4 Анализ рабочего процесса

Нативный рабочий процесс в основном ориентирован на получение кадров видео. По умолчанию в узле WanFunControlToVideo длина выставлена 81 (это примерно 5 секунд видео при 15 кадрах в секунду), однако предоставленное управляющее видео содержит только 49 кадров, поэтому я внес корректировки. Также вы можете заметить, что после генерации видео персонаж внезапно увеличивается — это связано с тем, что стартовый кадр и управляющее видео имеют разные размеры, из-за чего при обработке происходит обрезка и масштабирование.

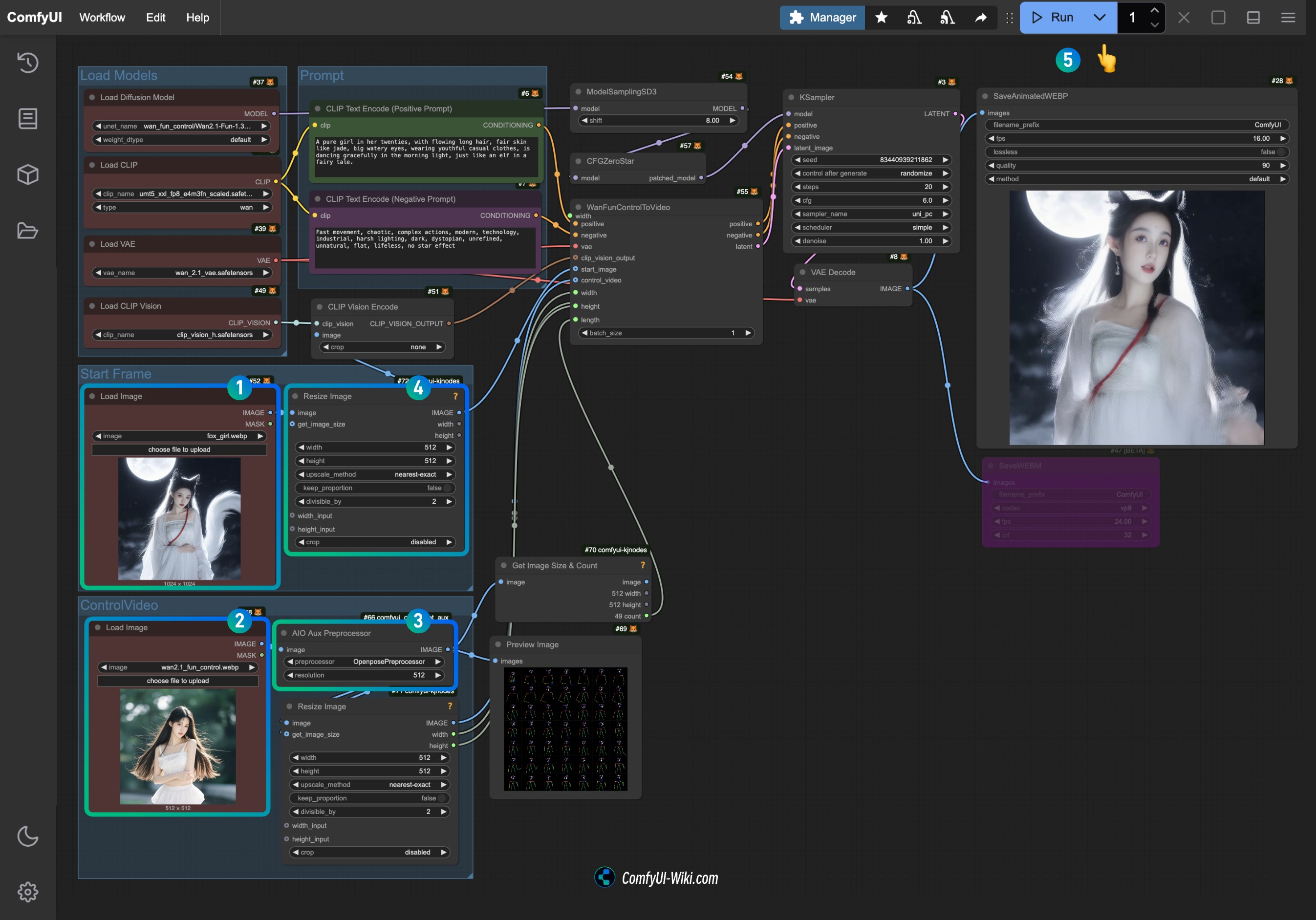

2. Улучшенная версия нативного рабочего процесса Wan2.1 Fun Control

Поскольку полностью нативный рабочий процесс не очень удобен для расчёта размера видео и количества кадров, в этой улучшенной версии я использовал некоторые узлы из следующих пользовательских пакетов:

- ComfyUI-KJNodes — для изменения размера видео и получения количества кадров.

- ComfyUI-comfyui_controlnet_aux — для предварительной обработки изображений видео.

Перед началом убедитесь, что вы установили эти два пользовательских пакета, либо воспользуйтесь ComfyUI-Manager для их установки после загрузки рабочего процесса.

2.1 Загрузка файла рабочего процесса

2.1.1 Загрузка файла рабочего процесса

Скачайте изображение ниже и перетащите его в ComfyUI для загрузки соответствующего рабочего процесса, после чего появится запрос на скачивание моделей.

2.1.2 Загрузка входного видео

Скачайте изображение и видео ниже для использования в качестве входных данных.

Из-за ограничения по времени в качестве входного видео по-прежнему используется вариант с эффектом внезапного увеличения.

2.2 Пошаговое выполнение рабочего процесса

- Загрузите предоставленное входное изображение в узел

Load Image(Start Frame). - Загрузите предоставленное видео в узел

Load Image(Control Video) в качестве управляющего условия. - В узле

AIO Aux Preprocessorвыберите нужный препроцессор (соответствующая модель будет скачана с Hugging Face при первом запуске). - Если требуется изменить размер, настройте параметры в узле

Resize Image, чтобы оба узла были согласованы по размеру. - Нажмите кнопку

Runили используйте сочетание клавишCtrl(cmd) + Enterдля запуска генерации видео.

Поскольку узел Load Image сейчас не поддерживает mp4-видео, если вы хотите использовать видео в качестве входных данных, воспользуйтесь узлом Load Video (Upload) из пакета ComfyUI-VideoHelperSuite для работы с разными видеоформатами.

3. Связанные расширения

Вы можете добавить к этим рабочим процессам соответствующие узлы генерации изображений, чтобы получить итоговое видео без необходимости использовать входные референсные изображения.

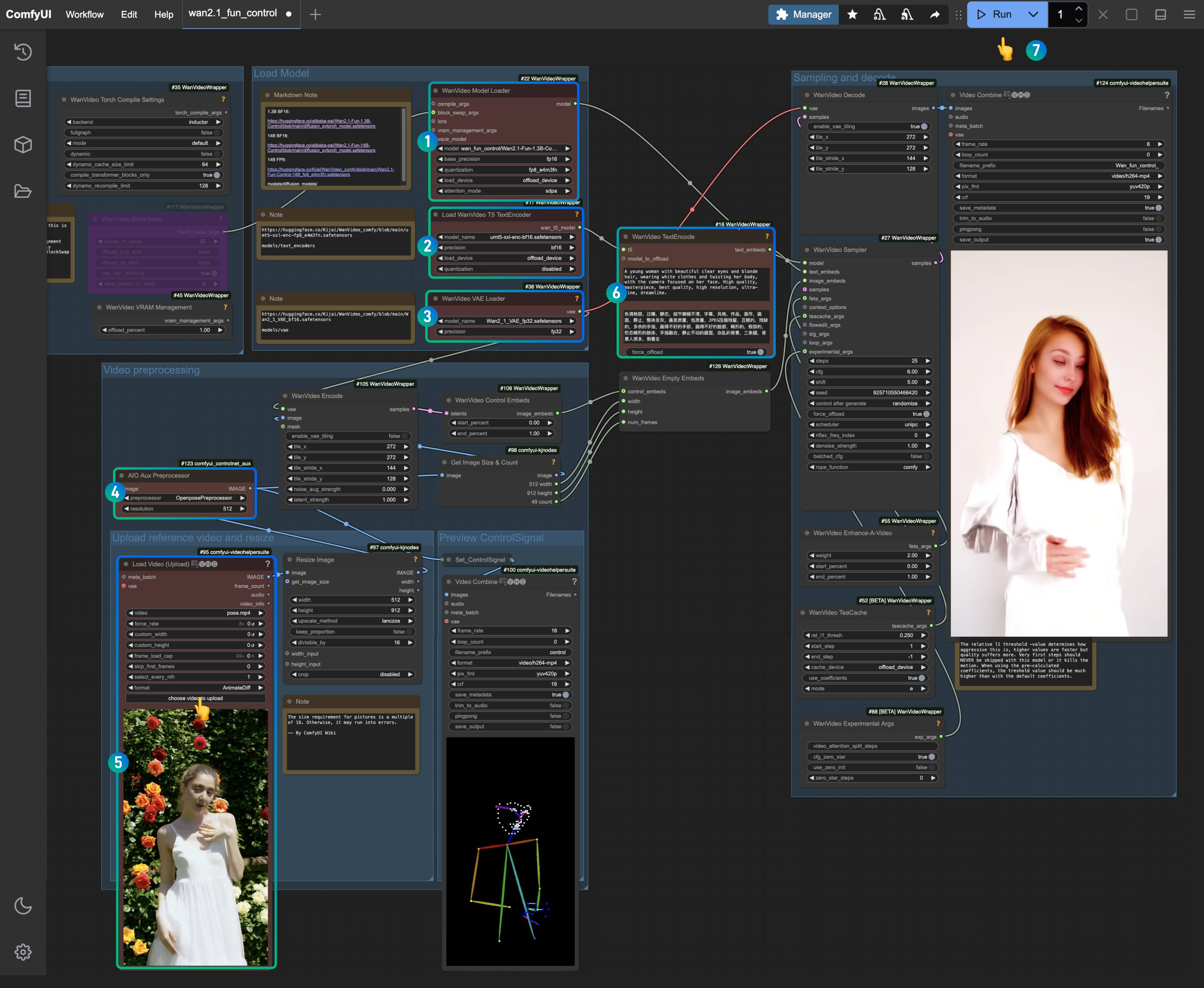

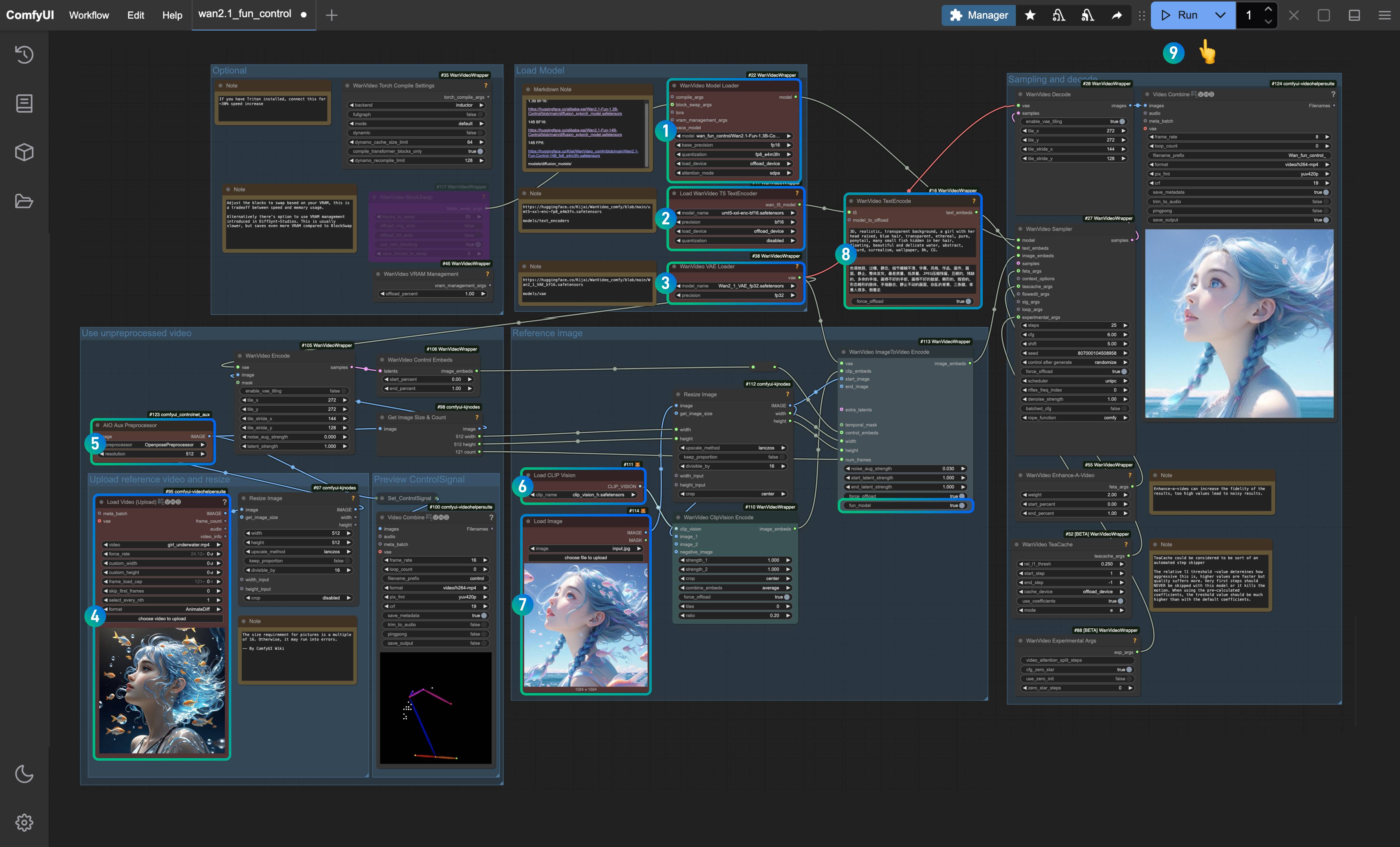

Рабочий процесс Kijai Wan Fun Control

Для выполнения примера Fun-Control мы будем использовать плагин ComfyUI-WanVideoWrapper от Kijai. Оригинальный рабочий процесс от Kijai можно найти здесь.

Рабочий процесс, описанный в этом руководстве, был переработан ComfyUI Wiki.

В этом разделе рабочий процесс будет разделён на две категории:

- Контрольный рабочий процесс для текст-видео только с использованием управляющего видео

- Контрольный рабочий процесс для генерации видео по референсному изображению, где с помощью Clip_vision анализируются и извлекаются признаки из референсного изображения, а затем добавляются условия по видео

Необходимая установка

Установка пользовательских узлов

Для корректной работы рабочего процесса необходимо установить следующие плагины:

- ComfyUI-WanVideoWrapper: обновите до последней версии

- ComfyUI-VideoHelperSuite

- ComfyUI-KJNodes

- ComfyUI-comfyui_controlnet_aux: для предварительной обработки видеоизображений, либо замените на ваши привычные узлы обработки изображений

Вы можете воспользоваться ComfyUI Manager для обновления или установки указанных выше пользовательских узлов, либо ознакомиться с инструкцией как установить пользовательские узлы.

ComfyUI-comfyui_controlnet_aux при первом запуске скачает нужную модель, убедитесь, что у вас есть доступ к huggingface.

Установка моделей

Wan2.1 Fun Control Доступны две модели: 1.3B и 14B. Выберите подходящую модель в зависимости от производительности вашего устройства.

- Wan2.1-Fun-1.3B-Control: после скачивания переименуйте в

Wan2.1-Fun-1.3B-Control.safetensors - Wan2.1-Fun-14B-Control: после скачивания переименуйте в

Wan2.1-Fun-14B-Control.safetensors - Kijai/Wan2.1-Fun-Control-14B_fp8_e4m3fn.safetensors

Скачайте одну из версий Text encoders:

VAE

CLIP Vision

Место для сохранения файлов

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └── Wan2.1-Fun-1.3B-Control.safetensors # или версия, которую вы выбрали

│ ├── 📂 text_encoders/

│ │ └─── umt5-xxl-enc-bf16.safetensors # или версия, которую вы выбрали

│ ├── 📂 vae/

│ │ └── Wan2_1_VAE_bf16.safetensors

│ └── 📂clip_vision/

│ └── clip_vision_h.safetensors 1. Контрольный рабочий процесс для текст-видео только с использованием управляющего видео

1.1 Загрузка файла рабочего процесса

Скачайте изображение ниже и перетащите его в ComfyUI, чтобы загрузить соответствующий рабочий процесс (workflow).

Скачайте рабочий процесс в формате JSON.

Скачайте видео ниже, оно будет использоваться как входное видео.

1.2 Выполнение шагов рабочего процесса

Скачайте изображение ниже и перетащите его в ComfyUI, чтобы загрузить соответствующий рабочий процесс.

Убедитесь, что соответствующие узлы загрузили нужные модели, используя скачанные вами версии.

- Проверьте, что узел

WanVideo Model Loaderзагрузил модельWan2.1-Fun-1.3B-Control.safetensors. - Проверьте, что узел

Load WanVideo T5 TextEncoderзагрузил модельumt5-xxl-enc-bf16.safetensors. - Проверьте, что узел

WanVideo Vae Loaderзагрузил модельWan2_1_VAE_bf16.safetensors. - В узле

AIO AuxAux Preprocessorвыберите вариантOpenposePreprocessor. - В узле

Load Video(Upload)загрузите входное видео, которое вы скачали ранее. - В узле

WanVideo TextEncodeвведите текстовый запрос для генерации видео (можно оставить по умолчанию). - Нажмите кнопку

Runили используйте сочетание клавишCtrl(cmd) + Enterдля запуска генерации видео.

1.3 Анализ рабочего процесса

В этой версии рабочего процесса основное внимание уделяется кодированию предварительно обработанных условий изображения, после чего происходит генерация видео. В узле предварительной обработки изображений OpenposePreprocessor вы можете выбрать различные методы обработки, такие как Openpose, Depth, Canny и другие. В данном примере выбран метод Openpose для создания и кодирования управления движением персонажа.

2. Рабочий процесс генерации видео с использованием референсного изображения

В этом рабочем процессе используется модель clip_vision_h.safetensors, которая позволяет эффективно анализировать содержимое референсного изображения. Однако видео генерируется не с полной сохранностью исходного образа, а на основе извлечённых признаков референсного изображения.

2.1 Скачивание файлов рабочего процесса

Скачайте изображение ниже и перетащите его в ComfyUI, чтобы загрузить соответствующий рабочий процесс.

Скачайте рабочий процесс в формате JSON.

Скачайте видео и изображения ниже, они будут использоваться в качестве входных данных.

2.2 Выполнение шагов рабочего процесса

- Проверьте, что узел

WanVideo Model Loaderзагрузил модельWan2.1-Fun-1.3B-Control.safetensors. - Проверьте, что узел

Load WanVideo T5 TextEncoderзагрузил модельumt5-xxl-enc-bf16.safetensors. - Проверьте, что узел

WanVideo Vae Loaderзагрузил модельWan2_1_VAE_bf16.safetensors. - В узле

Load Video(Upload)загрузите входное видео, которое вы скачали ранее. - В узле

AIO AuxAux Preprocessorвыберите вариантOpenposePreprocessor. - В узле

Load CLIP Visionубедитесь, что загружена модельclip_vision_h.safetensors, которая будет использоваться для извлечения признаков из референсного изображения. - В узле

Load Imageзагрузите референсное изображение, предоставленное выше. - В узле

WanVideo TextEncodeвведите текстовый запрос для генерации видео (можно оставить по умолчанию). - Нажмите кнопку

Runили используйте сочетание клавишCtrl(cmd) + Enterдля запуска генерации видео.

2.3 Анализ рабочего процесса

- Поскольку Kijai обновил соответствующие узлы, обратите внимание, что в узле

WanVideo ImageToVideo Encodeесть опцияfun_model, которую необходимо установить в значение true. - По сравнению с другими вариантами, использование признаков референсного изображения позволяет получить более подходящий результат, поэтому использование референсного изображения рекомендуется. Однако, поскольку извлекаются только признаки изображения, полная сохранность персонажа не гарантируется.

- В разделе предварительной обработки изображений вы можете попробовать комбинировать несколько узлов обработки для создания более разнообразных условий управления.