OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

ByteDance lanza USO: Modelo de generación de imágenes unificado de estilo y sujeto

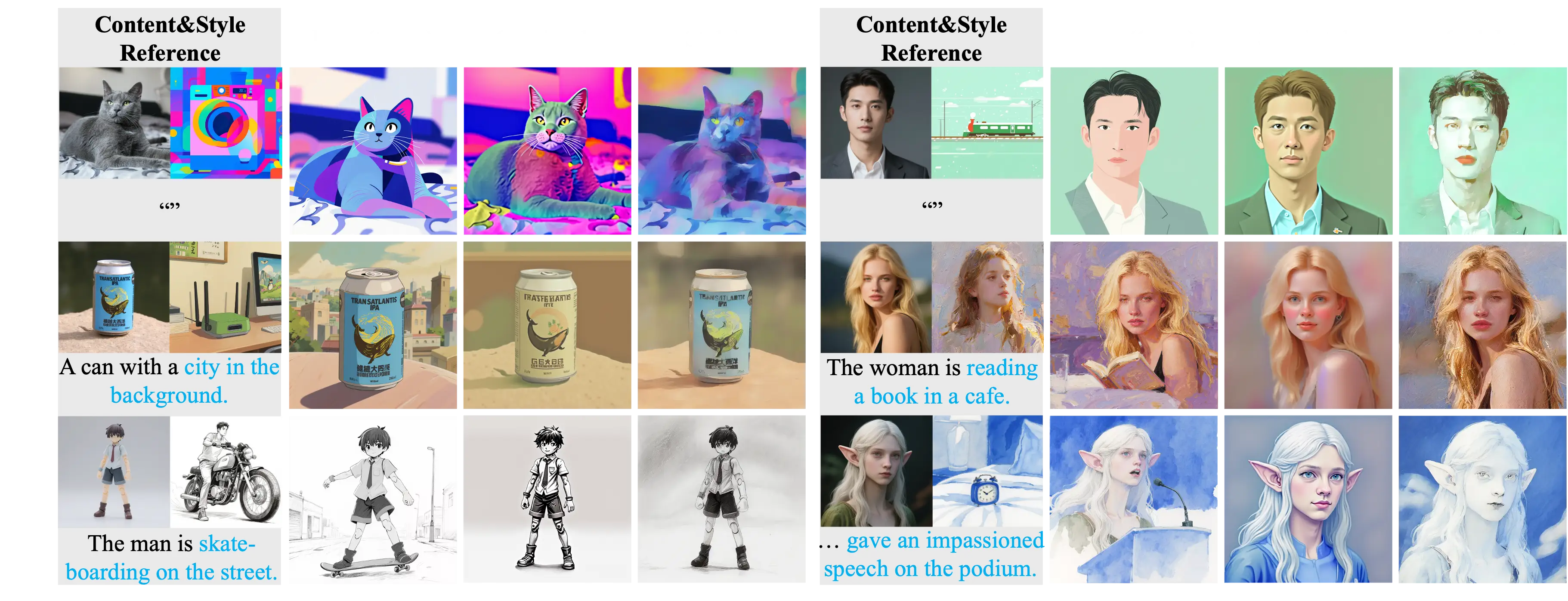

El equipo UXO del Laboratorio de Creación Inteligente de ByteDance ha lanzado USO (Generación unificada de estilo y sujeto), un modelo de generación personalizado que unifica la optimización de estilo y sujeto. USO puede combinar libremente cualquier sujeto con cualquier estilo, logrando efectos de transferencia de estilo de alta calidad mientras mantiene la consistencia del sujeto.

Características del modelo

El modelo USO aborda el problema en las tecnologías existentes donde las tareas de generación impulsadas por estilo y sujeto se oponen entre sí. Los métodos tradicionales normalmente tratan estas dos tareas como tareas independientes: la generación impulsada por estilo prioriza la similitud de estilo, mientras que la generación impulsada por sujeto enfatiza la consistencia del sujeto, lo que lleva a una relación antagonista obvia entre ambos.

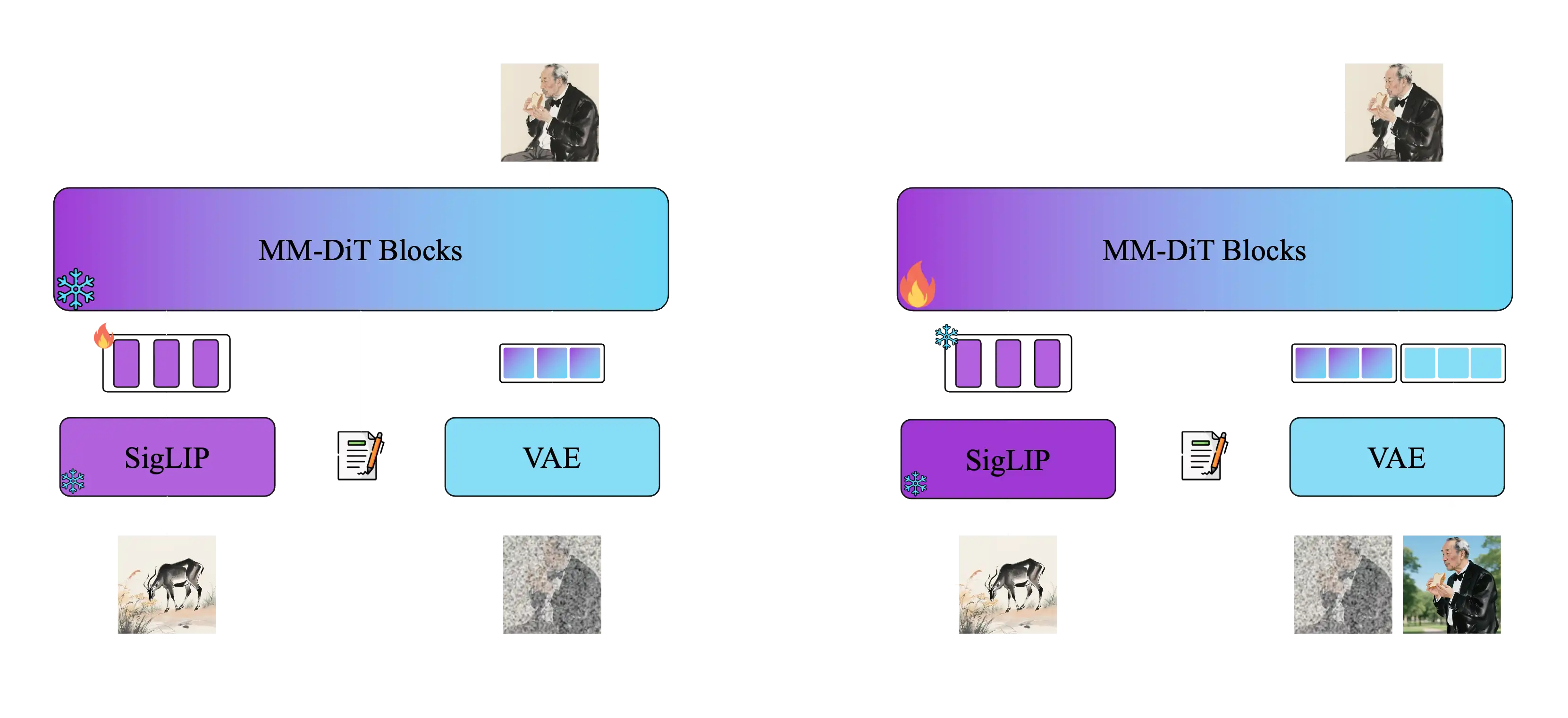

USO resuelve este problema mediante un marco unificado, con el desacoplamiento y recombinación del contenido y estilo como objetivo central. El modelo adopta un método de entrenamiento en dos etapas:

Primera etapa: Alinear las incrustaciones de SigLIP mediante entrenamiento de alineación de estilo para obtener un modelo con capacidades de estilo Segunda etapa: Desacoplar el codificador condicional y entrenar con datos tríos para lograr una generación condicional conjunta

Funciones principales

El modelo USO admite múltiples modos de generación, permitiendo la combinación libre de cualquier sujeto con cualquier estilo:

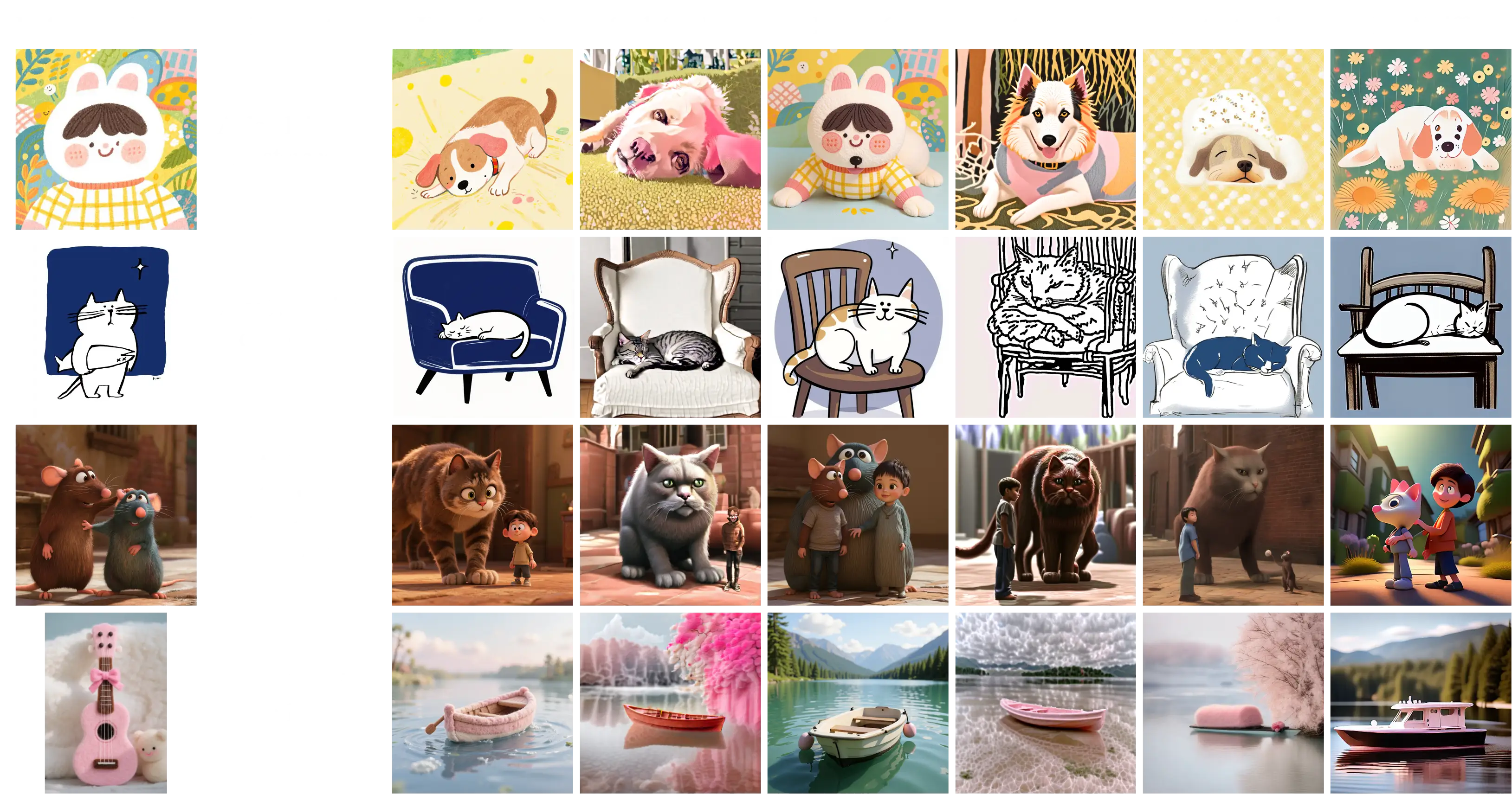

Generación impulsada por sujeto

Mantiene la consistencia de identidad del sujeto, adecuado para estilizar sujetos específicos como personas y objetos. Los usuarios pueden proporcionar una imagen de referencia que contenga un sujeto específico, y el modelo mantendrá las características de identidad del sujeto mientras aplica nuevos estilos o escenas.

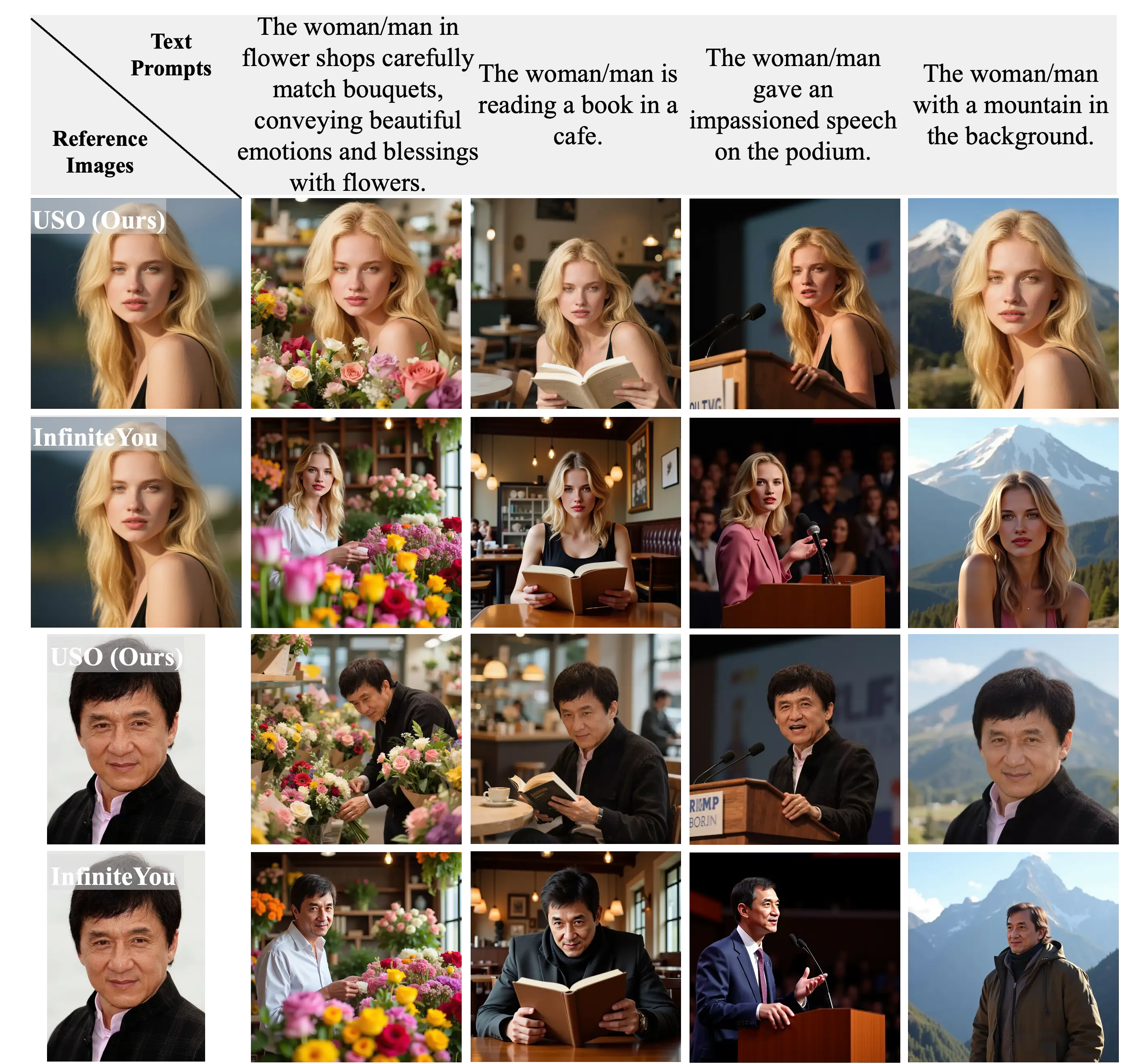

Generación impulsada por identidad

Realiza estilización manteniendo las características de identidad. Este modo es particularmente adecuado para la estilización de retratos, ya que puede mantener las características faciales, expresiones e información de identidad mientras cambia estilos artísticos, ropa o entornos de fondo.

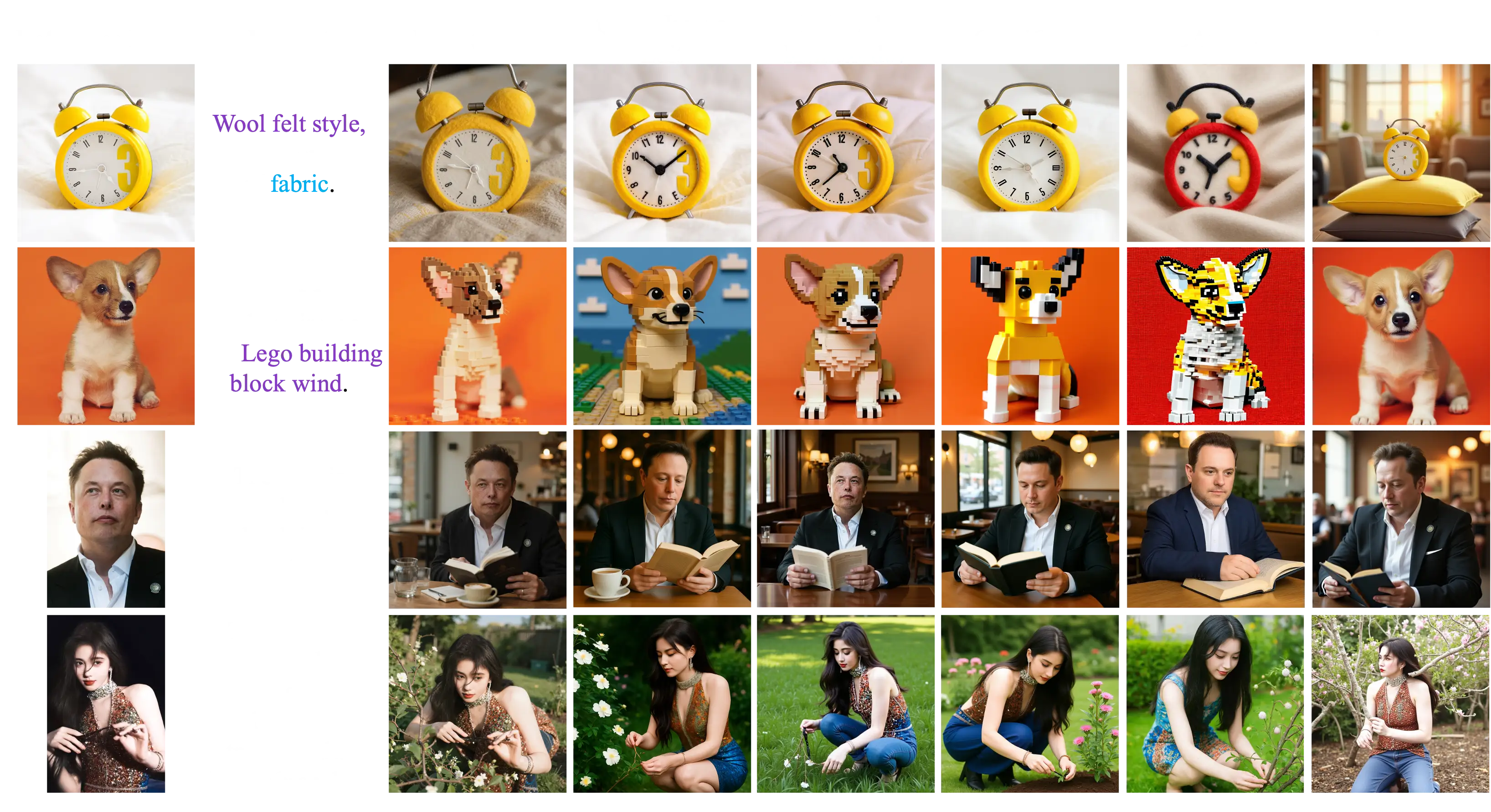

Generación impulsada por estilo

Logra transferencia de estilo de alta calidad aplicando el estilo de imágenes de referencia a nuevo contenido. Los usuarios pueden proporcionar una imagen de referencia de estilo, y el modelo aplicará este estilo artístico al contenido descrito por texto, creando nuevas imágenes con estilos específicos.

Generación mixta de múltiples estilos

Admite la aplicación de fusión de múltiples estilos. Los usuarios pueden proporcionar simultáneamente múltiples imágenes de referencia con diferentes estilos, y el modelo fusionará estos elementos de estilo juntos para crear efectos de estilo mixto únicos.

Generación conjunta de estilo y sujeto

Controla simultáneamente el sujeto y el estilo para lograr expresiones creativas complejas. Este modo combina las ventajas de la generación impulsada por sujeto y estilo, permitiendo a los usuarios especificar sujetos específicos y controlar estilos artísticos para un control creativo más preciso.

Principio de funcionamiento

USO adopta un método de entrenamiento en dos etapas: la primera etapa alinea las incrustaciones de SigLIP mediante entrenamiento de alineación de estilo para obtener un modelo con capacidades de estilo; la segunda etapa desacopla el codificador condicional y entrena con datos tríos para lograr una generación condicional conjunta. Finalmente, el paradigma de aprendizaje de recompensas de estilo supervisa ambas etapas para obtener un modelo unificado más fuerte.

Comparación con otros métodos

Comparación de generación impulsada por sujeto

Comparación de generación impulsada por estilo

Comparación de generación impulsada por identidad

Comparación de generación conjunta de estilo y sujeto

Conjunto de datos y entrenamiento

El equipo de investigación construyó un conjunto de datos tríos a gran escala que contiene imágenes de contenido, imágenes de estilo y sus correspondientes imágenes de contenido estilizado. Mediante un esquema de aprendizaje de desacoplamiento, el modelo puede manejar simultáneamente dos objetivos: alineación de estilo y desacoplamiento de contenido-estilo.

Rendimiento

Los resultados experimentales muestran que USO logra el mejor rendimiento en ambas dimensiones de consistencia de sujeto y similitud de estilo entre los modelos de código abierto. El modelo puede generar retratos naturales y no plásticos mientras mantiene una alta consistencia de sujeto y una fuerte fidelidad de estilo.

El equipo de investigación también lanzó la prueba de referencia USO-Bench, que es la primera prueba de referencia multi-métrica que evalúa simultáneamente la similitud de estilo y la fidelidad del sujeto, proporcionando una herramienta de evaluación estandarizada para la investigación relacionada.

Código abierto y uso

Enlaces del proyecto:

El lanzamiento de USO aporta nuevas soluciones al campo de la generación de imágenes por IA, particularmente en el equilibrio entre la transferencia de estilo y la preservación del sujeto. La apertura de este modelo impulsará la investigación relacionada y proporcionará potente soporte de herramientas para la comunidad de código abierto.