OpenMOSS 发布 MOVA - 开源音视频同步生成模型

2026/01/29

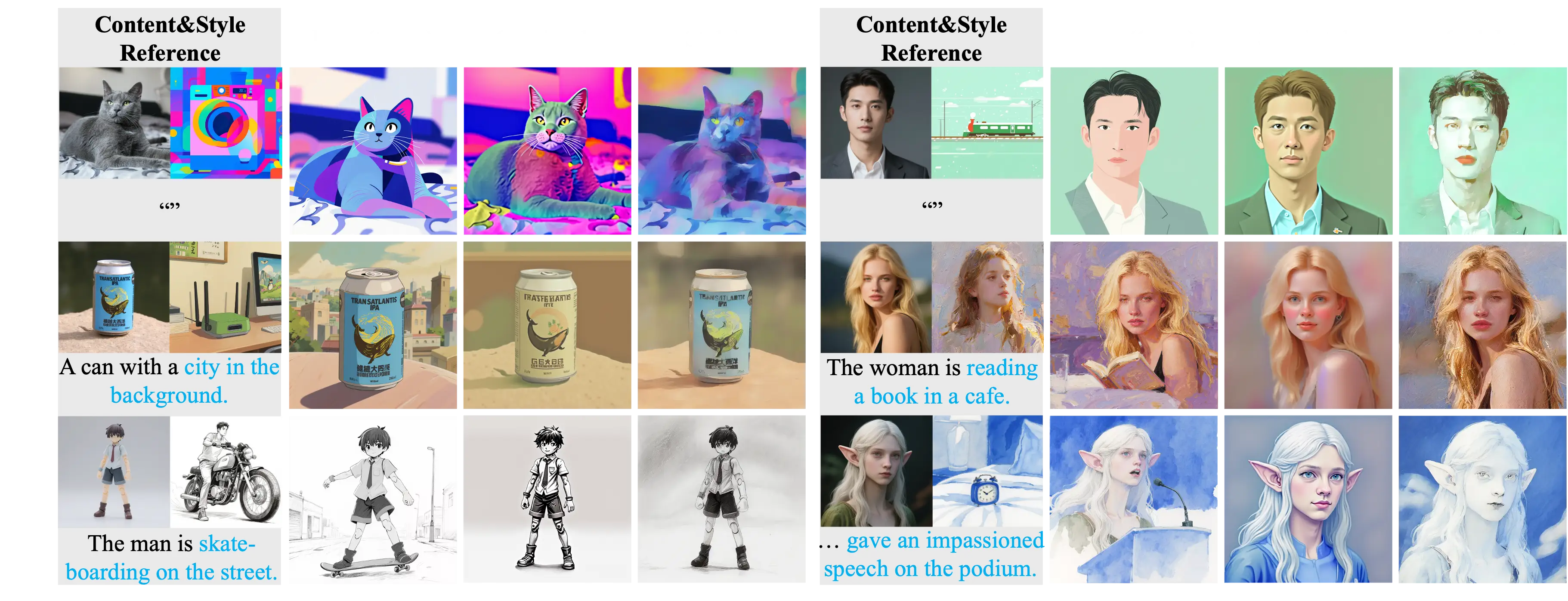

字节跳动发布USO:统一风格和主体驱动的图像生成模型

字节跳动智能创作实验室UXO团队发布了USO(Unified Style and Subject-Driven Generation)模型,这是一款统一风格和主体优化的定制化生成模型。USO能够自由组合任何主体与任何风格,在保持主体一致性的同时实现高质量的风格迁移效果。

模型特点

USO模型解决了现有技术中风格驱动和主体驱动生成任务相互对立的问题。传统方法通常将这两个任务视为独立任务:风格驱动生成优先考虑风格相似性,而主体驱动生成则强调主体一致性,导致两者之间存在明显的对抗关系。

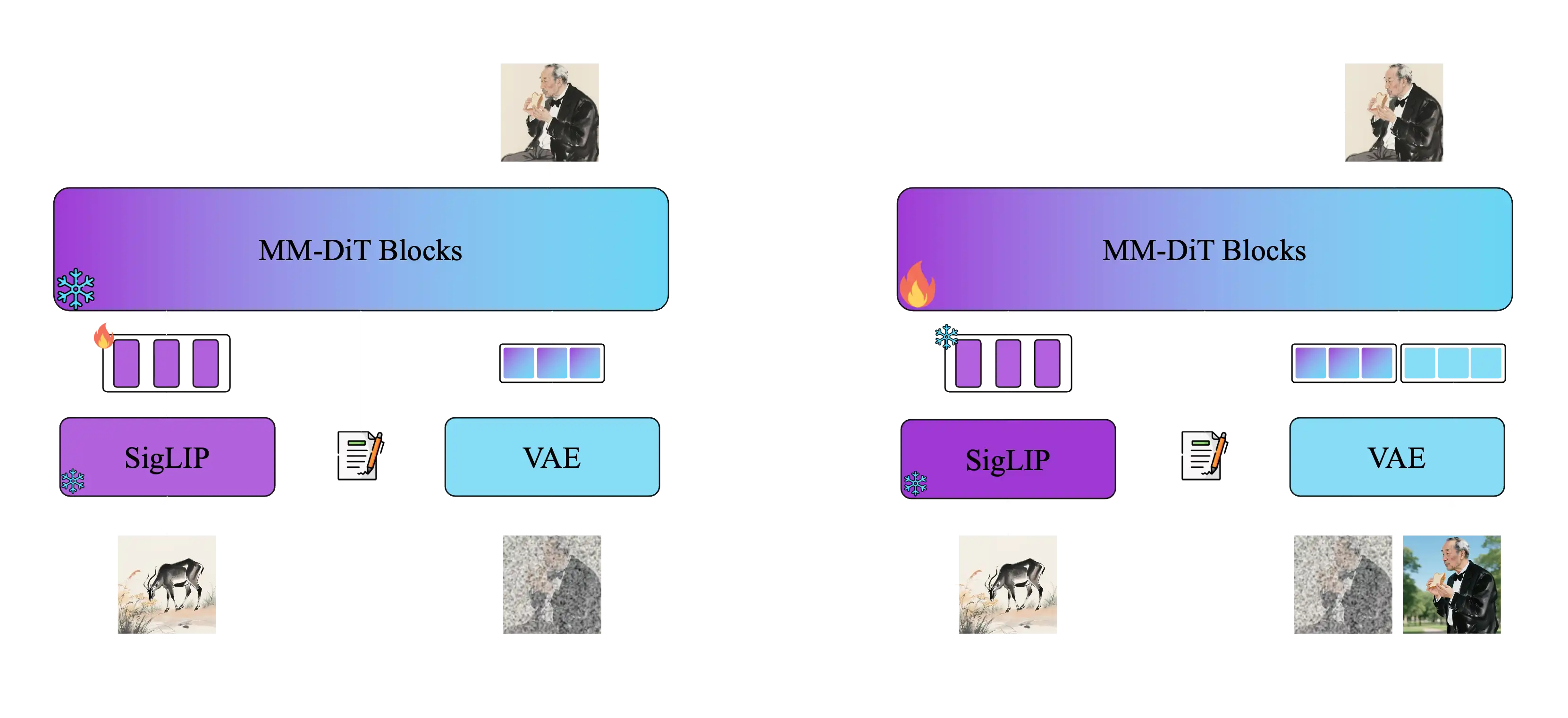

USO通过统一的框架解决了这一问题,将内容与风格的解耦和重组作为核心目标。该模型采用了两阶段训练方法:

第一阶段:通过风格对齐训练对齐SigLIP嵌入,获得具备风格能力的模型 第二阶段:解耦条件编码器并在三元组数据上训练,实现联合条件生成

核心功能

USO模型支持多种生成模式,能够自由组合任何主体与任何风格:

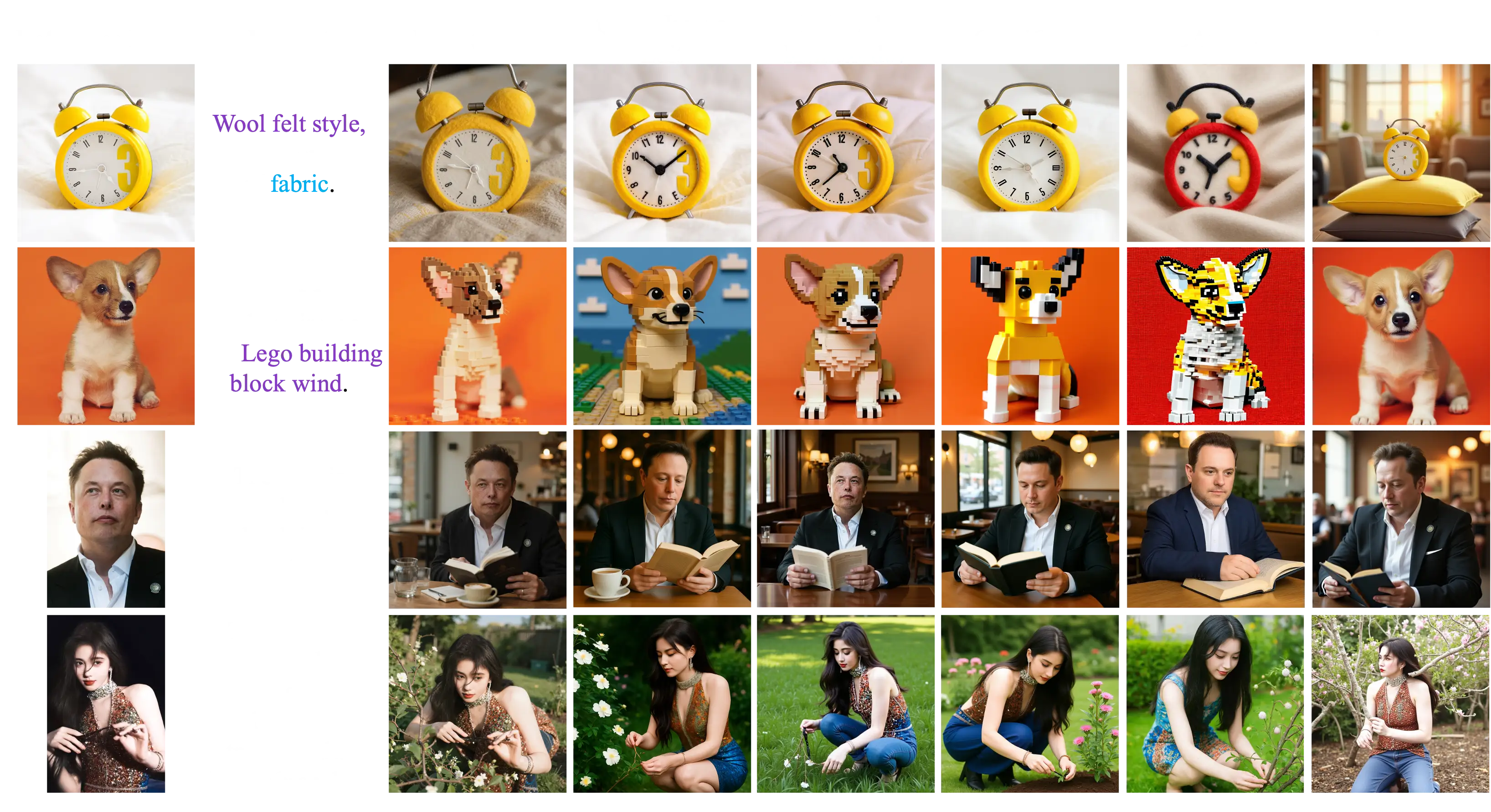

主体驱动生成

保持主体身份一致性,适用于人物、物体等特定主体的风格化。用户可以提供一张包含特定主体的参考图像,模型会保持该主体的身份特征,同时应用新的风格或场景。

身份驱动生成

在保持身份特征的同时进行风格化处理。这种模式特别适合人物肖像的风格化,能够保持面部特征、表情和身份信息,同时改变艺术风格、服装或背景环境。

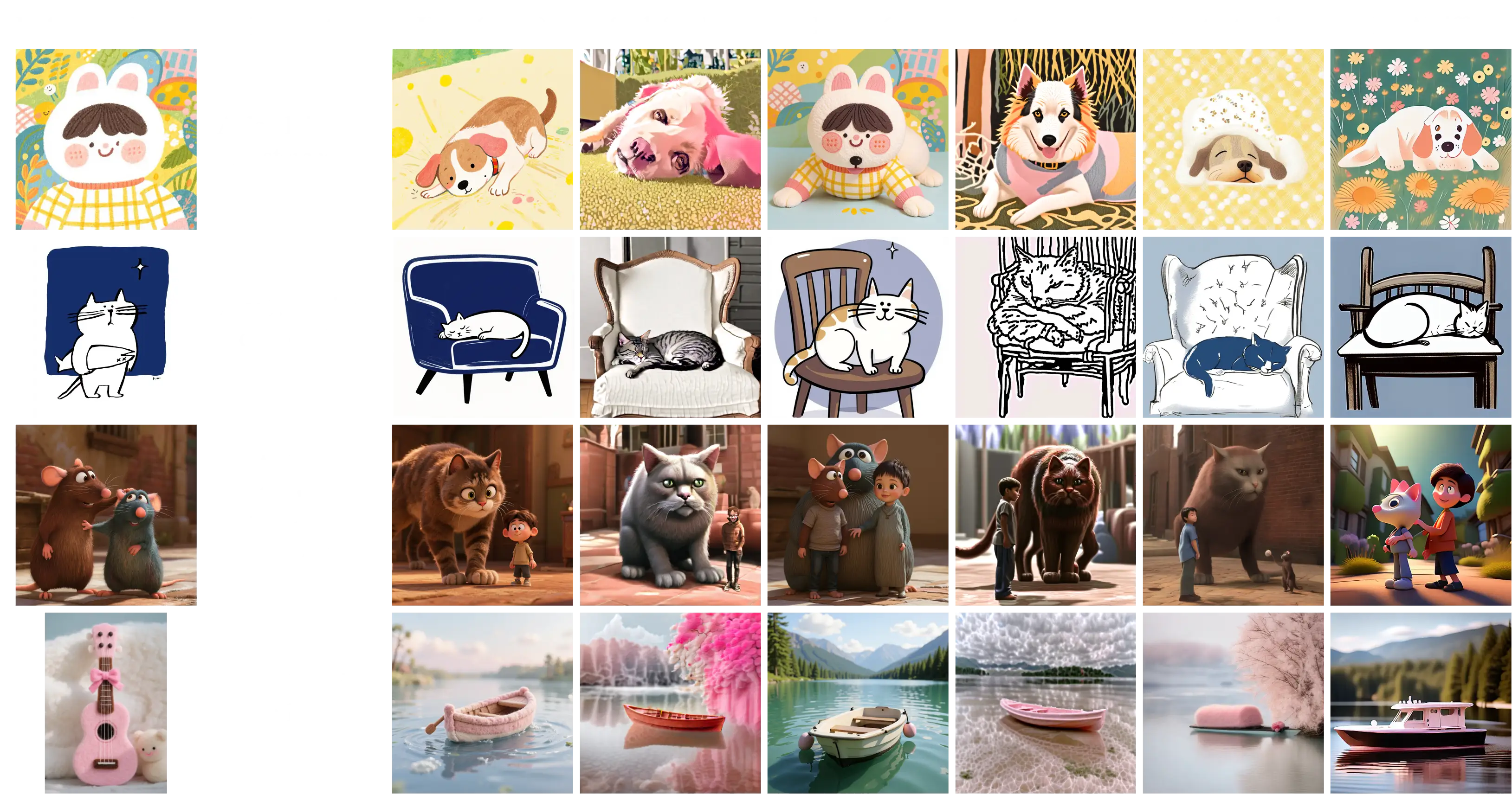

风格驱动生成

实现高质量的风格迁移,将参考图像的风格应用到新内容上。用户可以提供一张风格参考图像,模型会将这种艺术风格应用到文本描述的内容上,创造出具有特定风格的新图像。

多风格混合生成

支持多种风格的融合应用。用户可以同时提供多张不同风格的参考图像,模型会将这些风格元素融合在一起,创造出独特的混合风格效果。

风格主体联合生成

同时控制主体和风格,实现复杂的创意表达。这种模式结合了主体驱动和风格驱动的优势,用户既可以指定特定的主体,又可以控制艺术风格,实现更精确的创意控制。

工作原理

USO采用了两阶段训练方法:第一阶段通过风格对齐训练对齐SigLIP嵌入,获得具备风格能力的模型;第二阶段解耦条件编码器并在三元组数据上训练,实现联合条件生成。最后通过风格奖励学习范式监督两个阶段,得到更强的统一模型。

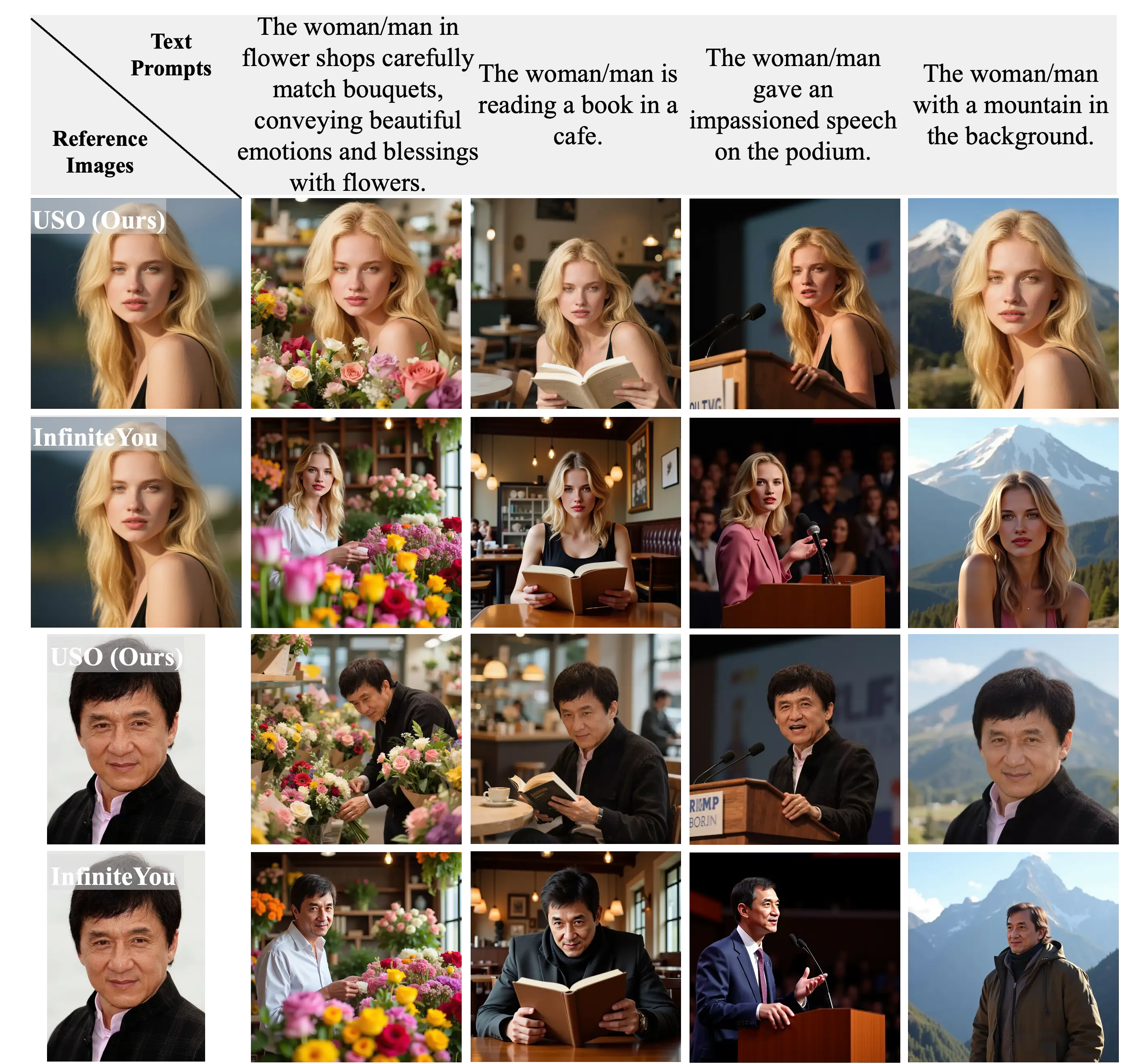

与其他方法的对比

主体驱动生成对比

风格驱动生成对比

身份驱动生成对比

风格主体联合生成对比

数据集与训练

研究团队构建了大规模三元组数据集,包含内容图像、风格图像及其对应的风格化内容图像。通过解耦学习方案,模型能够同时处理风格对齐和内容风格解耦两个目标。

性能表现

实验结果表明,USO在开源模型中实现了主体一致性和风格相似性两个维度上的最佳性能。模型能够生成自然、非塑料感的人像,同时保持高主体一致性和强风格保真度。

研究团队还发布了USO-Bench基准测试,这是首个同时评估风格相似性和主体保真度的多指标基准,为相关研究提供了标准化的评估工具。

开源与使用

项目地址:

USO的发布为AI图像生成领域带来了新的解决方案,特别是在风格迁移和主体保持的平衡方面。该模型的开源将推动相关研究的发展,为开源社区提供强大的工具支持。