OpenMOSS, MOVA 출시 - 오픈소스 동영상·오디오 동기화 생성 모델

2026. 01. 29.

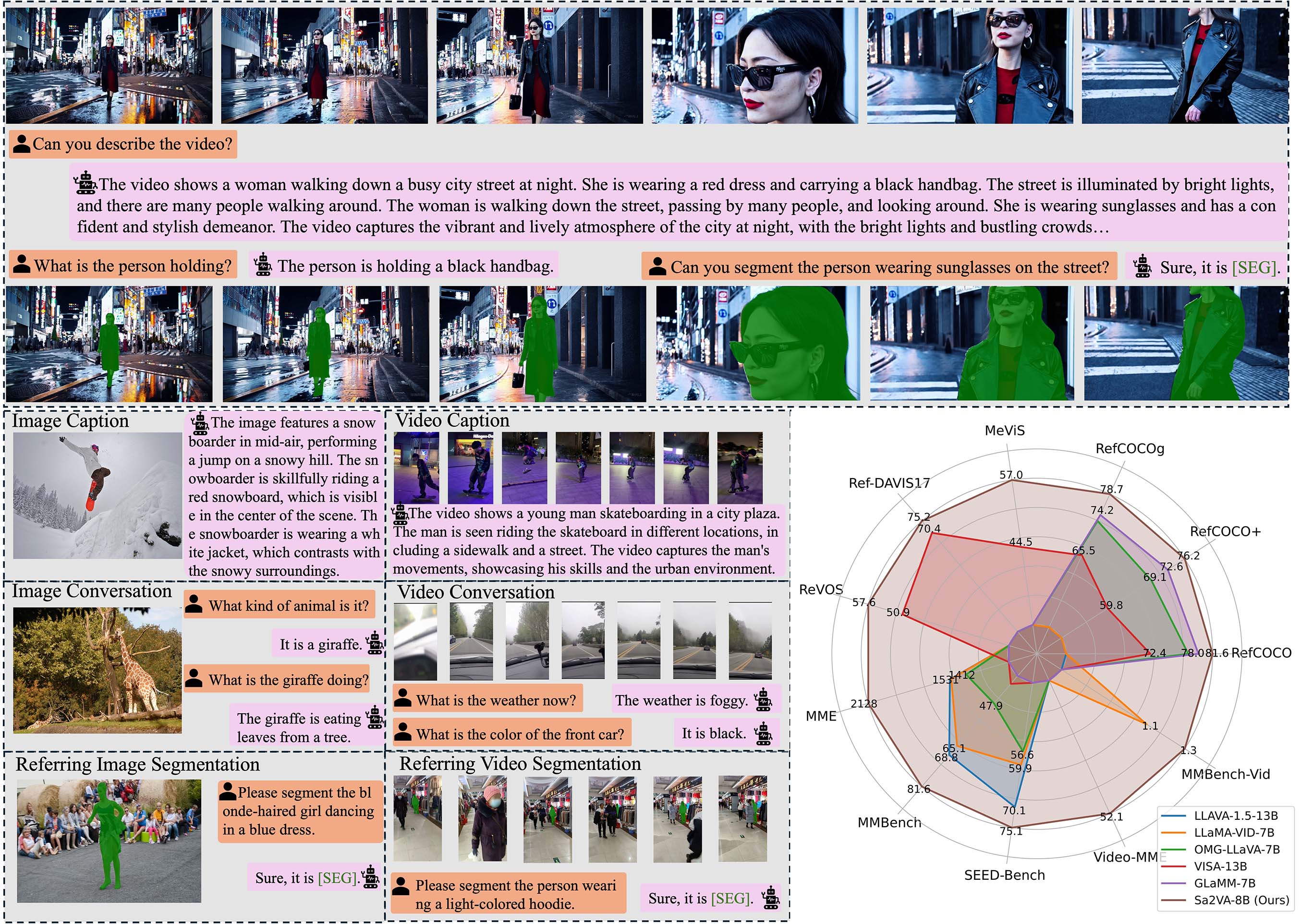

바이트댄스, Sa2VA 출시: 최초의 통합 영상-이미지 이해 모델

오늘 바이트댄스는 Hugging Face 플랫폼에 Sa2VA (SAM2 + LLaVA) 멀티모달 모델을 공개했습니다. 이는 이미지와 동영상을 동시에 처리할 수 있는 최초의 밀집 분할 이해 모델입니다. Sa2VA는 메타(Meta)의 SAM2 분할 기술과 LLaVA의 시각적 질문 응답 기능을 결합하여 최신 멀티모달 모델과 비교할 수 있는 질문 응답 성능을 유지하면서 시각적 프롬프트 이해 및 밀집 객체 분할 기능을 추가했습니다.

기술적 특징: 멀티모달 이해의 새로운 돌파구

Sa2VA의 핵심 혁신은 두 가지 첨단 기술을 유기적으로 통합하는 데 있습니다:

1. 시각 분할 기능

- 밀집 객체 분할: 이미지와 동영상에서 다수의 객체를 정확하게 식별하고 분할 가능

- 시각적 프롬프트 이해: 마스크와 같은 시각적 힌트를 통한 대화형 분할 지원

- 프레임 간 일관성: 동영상 처리 시 객체 분할의 시간적 연속성 유지

2. 멀티모달 질문 응답

- 이미지 이해: 상세한 이미지 설명과 분석 제공

- 영상 분석: 영상 콘텐츠의 시간적 동적 변화 이해

- 대화형 대화: 시각 콘텐츠 기반의 멀티턴 대화 지원

모델 시리즈: 다양한 요구에 맞춘 다수 사양

바이트댄스는 Qwen2.5-VL 및 InternVL 시리즈를 기반으로 완전한 Sa2VA 모델 패밀리를 구성했습니다:

| 모델명 | 베이스 모델 | 언어 모델 | 파라미터 규모 |

|---|---|---|---|

| Sa2VA-InternVL3-2B | InternVL3-2B | Qwen2.5-1.5B | 20억 |

| Sa2VA-InternVL3-8B | InternVL3-8B | Qwen2.5-7B | 80억 |

| Sa2VA-InternVL3-14B | InternVL3-14B | Qwen2.5-14B | 140억 |

| Sa2VA-Qwen2_5-VL-3B | Qwen2.5-VL-3B | Qwen2.5-3B | 30억 |

| Sa2VA-Qwen2_5-VL-7B | Qwen2.5-VL-7B | Qwen2.5-7B | 70억 |

성능: 여러 벤치마크에서 선도적 결과

Sa2VA는 여러 표준 테스트에서 우수한 성능을 발휘합니다:

시각적 질문 응답 기능

- MME 테스트: Sa2VA-InternVL3-14B는 1746/724점을 기록

- MMBench: 84.3점으로 전문 시각 이해 모델 수준에 근접

분할 작업 성능

- RefCOCO 시리즈: 지시 표현 분할 작업에서 우수한 성능

- 영상 분할: MeVIS 및 DAVIS 벤치마크 테스트에서 최고 성능 달성

응용 시나리오: 광범위한 실용적 가치

Sa2VA의 통합 아키텍처는 여러 분야에 새로운 가능성을 제공합니다:

1. 콘텐츠 제작

- 영상 편집: 동영상의 객체를 자동으로 식별하고 분할하여 포스트 프로덕션 프로세스 간소화

- 이미지 주석: 대규모 이미지 데이터셋에 정확한 객체 분할과 설명 제공

2. 교육 및 훈련

- 대화형 교육: 시각적 프롬프트와 질문 응답을 통해 학생들이 복잡한 개념을 이해할 수 있도록 지원

- 콘텐츠 분석: 교육용 동영상의 핵심 정보 포인트를 자동 분석

3. 보안 감시

- 지능형 분석: 감시 영상에서 사람과 물체의 행동을 실시간으로 분석

- 이상 감지: 시각 이해와 분할 기능을 결합하여 이상 상황 식별

4. 의료 영상

- 보조 진단: 의료 영상을 분석하고 상세한 영역 설명 제공

- 병변 위치 지정: 관심 영역을 정확하게 분할하고 주석 처리

오픈소스 리소스 및 접근 방법

Sa2VA는 오픈소스 릴리스 전략을 채택하여 연구자와 개발자에게 편의를 제공합니다:

공식 리소스 링크:

- 프로젝트 홈페이지: GitHub Sa2VA

- 논문: arXiv:2501.04001

- 모델 다운로드: Hugging Face Sa2VA 시리즈

Sa2VA의 출시는 멀티모달 AI가 보다 통합적이고 실용적인 방향으로 진화했음을 의미합니다. 시각 분할과 언어 이해를 깊이 통합하는 설계 개념은 향후 AI 응용에 새로운 가능성을 열어줍니다.