OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

title: “FlexiAct: Control Flexible de Acciones en Escenarios Heterogéneos” description: “FlexiAct, desarrollado conjuntamente por la Universidad de Tsinghua y el Laboratorio ARC de Tencent, puede transferir acciones de un video de referencia a cualquier imagen objetivo manteniendo la consistencia de identidad” tag: AI, video-generation, action-control, image-to-video date: 2025-05-08

FlexiAct: Control Flexible de Acciones en Escenarios Heterogéneos

Un equipo de investigación de la Universidad de Tsinghua y el Laboratorio ARC de Tencent ha lanzado recientemente FlexiAct, una nueva tecnología que puede transferir acciones de un video de referencia a cualquier imagen objetivo, manteniendo buenos resultados incluso cuando la distribución, el punto de vista y la estructura esquelética son diferentes. Esta tecnología ha sido aceptada por SIGGRAPH 2025.

Antecedentes Técnicos

La personalización de acciones se refiere a la generación de videos donde el sujeto realiza acciones dictadas por señales de control de entrada. Los métodos actuales utilizan principalmente personalización guiada por pose o movimiento global, pero están estrictamente limitados por la estructura espacial (como la distribución, el esqueleto y la consistencia del punto de vista), lo que dificulta la adaptación a diferentes sujetos y escenarios.

Innovación Técnica

FlexiAct supera las limitaciones de las tecnologías existentes para lograr:

- Control preciso de acciones

- Adaptación de estructura espacial

- Preservación de la consistencia de identidad

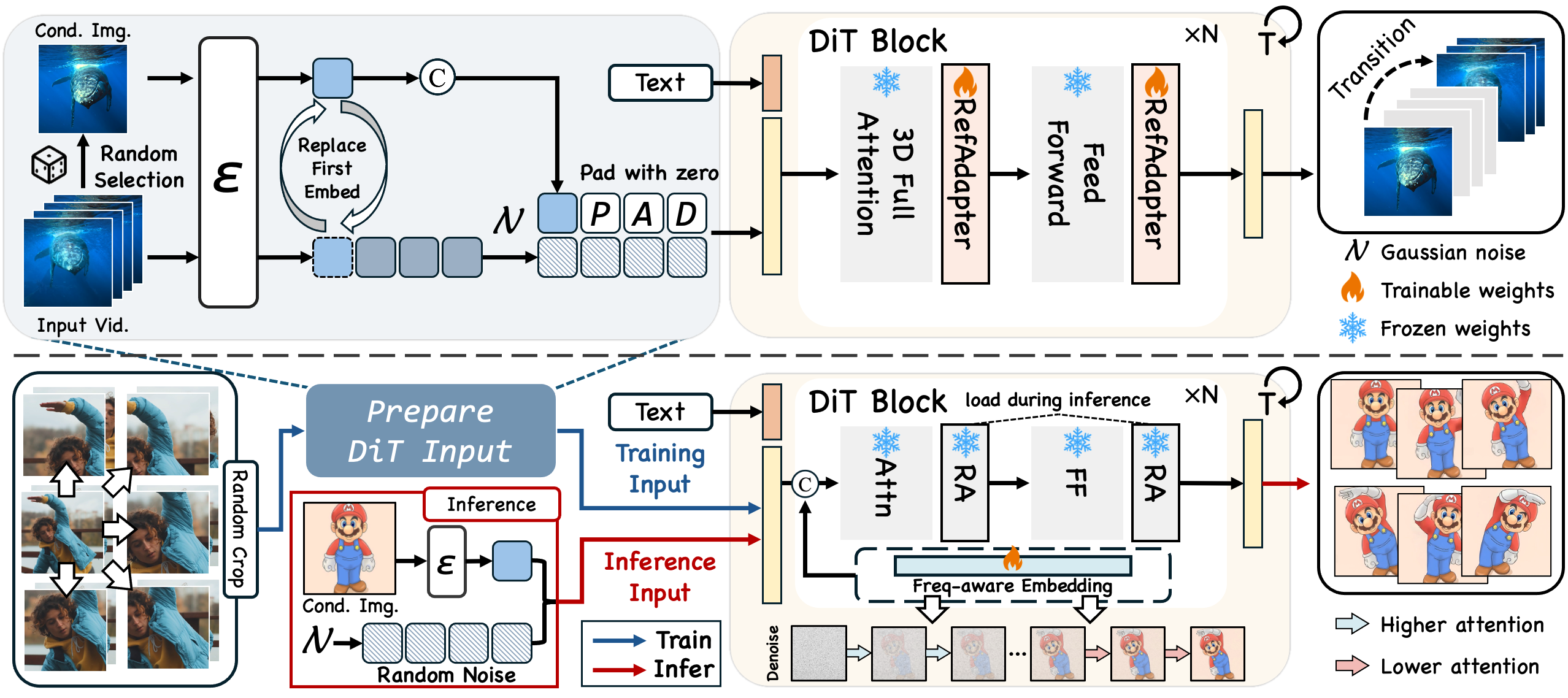

La tecnología se basa en dos componentes clave:

-

RefAdapter: Un adaptador ligero condicionado por imágenes que sobresale en adaptación espacial y preservación de consistencia, equilibrando la consistencia de apariencia y la flexibilidad estructural.

-

FAE (Extracción de Acciones Consciente de Frecuencia): Basado en las observaciones del equipo de investigación, el proceso de eliminación de ruido muestra diferentes niveles de atención al movimiento (baja frecuencia) y detalles de apariencia (alta frecuencia) en diferentes momentos. FAE logra la extracción de acciones directamente durante el proceso de eliminación de ruido, sin depender de arquitecturas espacio-temporales separadas.

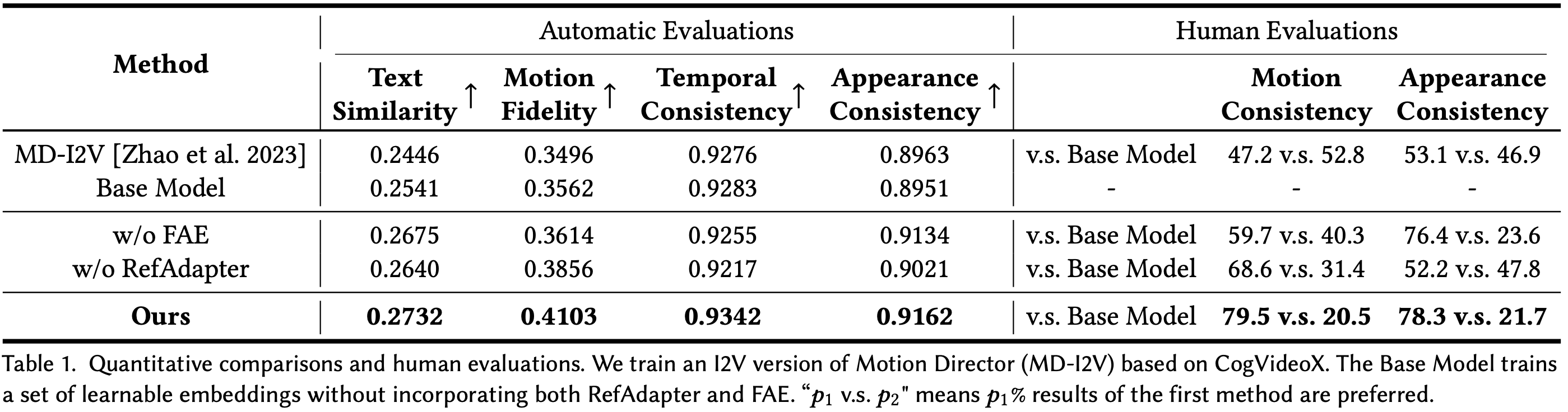

En comparación con los métodos existentes, FlexiAct demuestra ventajas significativas de rendimiento en escenarios heterogéneos:

Escenarios de Aplicación

FlexiAct puede aplicarse ampliamente en varios escenarios:

- Transferencia de Acciones Humanas: Transferir acciones humanas a personajes de juegos o figuras de dibujos animados

- Generación de Animación Animal: Añadir acciones dinámicas a imágenes de animales

- Efectos Dinámicos de Cámara: Crear efectos dinámicos bajo diferentes perspectivas de cámara

- Migración de Acciones Entre Dominios: Implementar la migración de acciones entre especies diferentes, como aplicar acciones humanas a animales

Datos y Modelos

El equipo de investigación construyó un conjunto de datos dedicado para este trabajo, incluyendo varios tipos de acciones:

- Acciones Humanas: Caminar, agacharse, saltar, etc.

- Acciones Animales: Correr, saltar, estar de pie, etc.

- Acciones de Cámara: Movimiento hacia adelante, rotación, zoom, etc.

FlexiAct se desarrolla basado en el modelo CogVideoX-5B, logrando efectos de transferencia de acciones de alta calidad.

Recursos de Código Abierto

El equipo de investigación ha puesto a disposición recursos relacionados, incluyendo:

- Modelos pre-entrenados de FlexiAct (basados en CogVideoX-5B)

- Conjuntos de datos para entrenamiento y pruebas

- Código para entrenamiento e inferencia

- Instrucciones detalladas y ejemplos

Planes Futuros

Según el registro de actualizaciones del proyecto, el equipo de investigación planea:

- Publicar código de entrenamiento e inferencia

- Publicar puntos de control de FlexiAct (basados en CogVideoX-5B)

- Publicar datos de entrenamiento

- Publicar demostración en Gradio