OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

ByteDance lanza UNO: Ampliando las capacidades de generación de menos a más

El equipo de Inteligencia Creativa de ByteDance ha lanzado recientemente un marco universal de generación de imágenes llamado UNO, que se basa en el concepto central de “Generalización de menos a más” (Less-to-More Generalization) y desbloquea mayor controlabilidad mediante la generación en contexto, logrando una generación de imágenes de alta calidad desde sujetos individuales hasta múltiples.

El marco UNO proporciona a los creadores de contenido herramientas más flexibles y potentes, permitiendo un control preciso en escenas complejas mientras mantiene las características de múltiples objetos, haciendo que las imágenes generadas por IA se alineen mejor con las intenciones de los creadores.

Desafíos clave abordados

Los modelos tradicionales de generación de imágenes por IA enfrentan dos grandes desafíos al manejar escenas con múltiples objetos específicos:

- Problema de escalabilidad de datos: La expansión desde conjuntos de datos de un solo sujeto a conjuntos de datos de múltiples sujetos es particularmente difícil, ya que los datos emparejados de alta calidad, con múltiples ángulos y consistencia de sujeto son difíciles de adquirir a gran escala

- Problema de extensibilidad de sujetos: Los métodos existentes se centran principalmente en la generación de un solo sujeto y luchan por adaptarse a los requisitos complejos de escenarios con múltiples sujetos

UNO resuelve estos problemas a través de enfoques únicos, logrando resultados de generación de imágenes más consistentes y controlables.

Principios técnicos explicados

El marco UNO introduce dos innovaciones técnicas clave:

-

Alineación progresiva entre modalidades: Una estrategia de entrenamiento en dos etapas

- Primera etapa: Ajuste fino de un modelo T2I preentrenado utilizando datos de un solo sujeto generados en contexto, transformándolo en un modelo S2I (Subject-to-Image)

- Segunda etapa: Entrenamiento adicional con pares de datos de múltiples sujetos generados para mejorar la capacidad del modelo para manejar escenas complejas

-

Incrustación de posición rotativa universal (UnoPE): Una técnica especial de codificación de posición que resuelve eficazmente los problemas de confusión de atributos al extender el control visual de sujetos, permitiendo al modelo distinguir y mantener con precisión las características de múltiples sujetos

Pipeline de síntesis de datos de alta consistencia

Una de las principales innovaciones de UNO es su pipeline de síntesis de datos de alta consistencia:

- Aprovechamiento de las capacidades inherentes de generación en contexto de los transformadores de difusión: Utilizando al máximo el potencial de los modelos de difusión actuales

- Generación de datos emparejados de múltiples sujetos de alta consistencia: Asegurando la calidad y consistencia de los datos de entrenamiento mediante estrategias específicas de generación de datos

- Proceso de entrenamiento iterativo: Evolucionando progresivamente desde modelos de texto a imagen hasta modelos complejos que manejan múltiples condiciones de imagen

Este enfoque no solo resuelve el desafío de la adquisición de datos, sino que también mejora la calidad y consistencia de los resultados de generación.

Escenarios de aplicación práctica

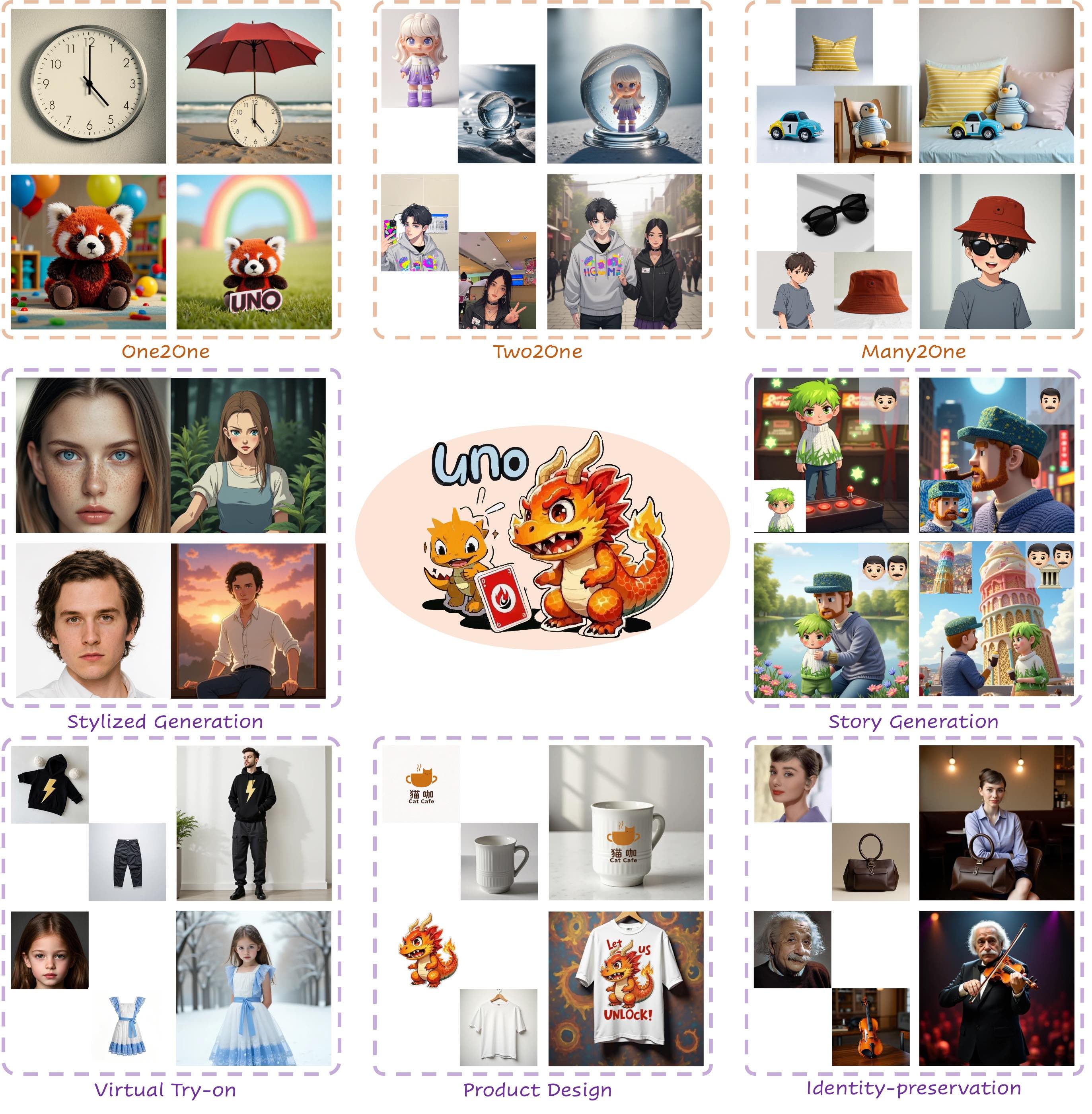

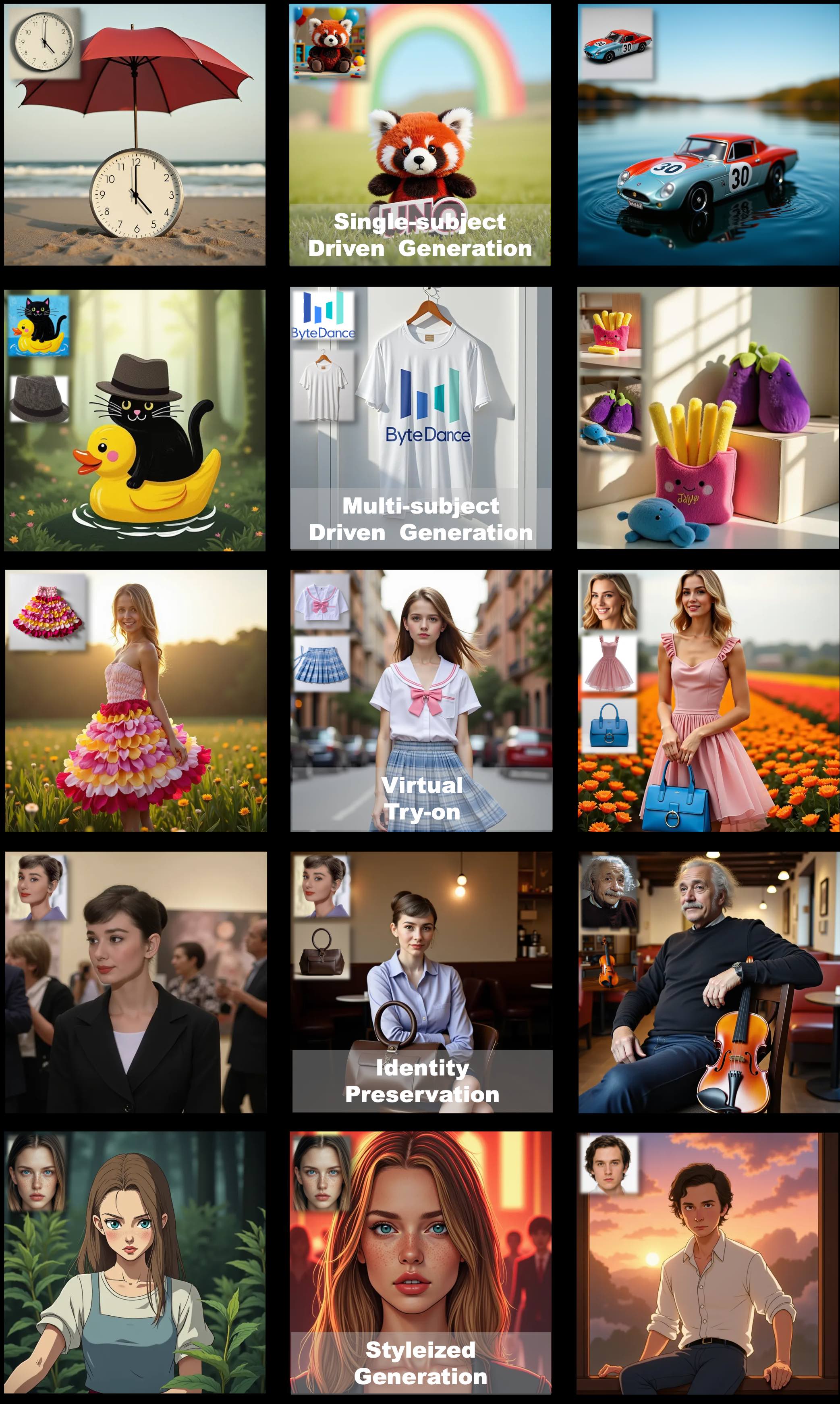

El modelo UNO demuestra diversas capacidades prácticas, aplicables a:

- Generación personalizada de múltiples sujetos: Colocación de múltiples objetos específicos en la misma escena manteniendo sus características individuales

- Prueba virtual y exhibición de productos: Mostrar productos o servicios específicos en diferentes entornos

- Contenido personalizado de marca: Integración de elementos de marca en varias escenas manteniendo la consistencia de la marca

- Diseño creativo y producción de contenido: Proporcionar a diseñadores y creadores de contenido posibilidades creativas más ricas

Capacidades de generalización

El modelo UNO demuestra potentes capacidades de generalización, unificando varias tareas:

- Transferencia de sujeto único a múltiples sujetos: Expansión desde escenas simples a escenarios complejos

- Adaptación a diferentes estilos: Adaptación a diferentes requisitos de estilo manteniendo las características del sujeto

- Integración de múltiples tareas creativas: Un modelo que maneja tareas que anteriormente requerían múltiples modelos especializados

Experiencia en línea

Puede experimentar personalmente las potentes capacidades de UNO a través de la siguiente interfaz:

Parámetros técnicos e información de código abierto

El modelo UNO está desarrollado basado en FLUX.1 y liberado como código abierto por el equipo de ByteDance, incluyendo código de entrenamiento, código de inferencia y pesos del modelo.

El proyecto está disponible en GitHub, permitiendo a investigadores y desarrolladores acceder y utilizar libremente la tecnología. El código del proyecto sigue la licencia Apache 2.0, mientras que los pesos del modelo se publican bajo la licencia CC BY-NC 4.0. Cabe destacar que cualquier modelo relacionado con el modelo base FLUX.1-dev debe cumplir con los términos de la licencia original.