OpenMOSS lanza MOVA - modelo de generación sincronizada de video y audio de código abierto

29/01/2026

Lanzamiento de Open-Sora 2.0: Generación de video de nivel comercial a bajo costo

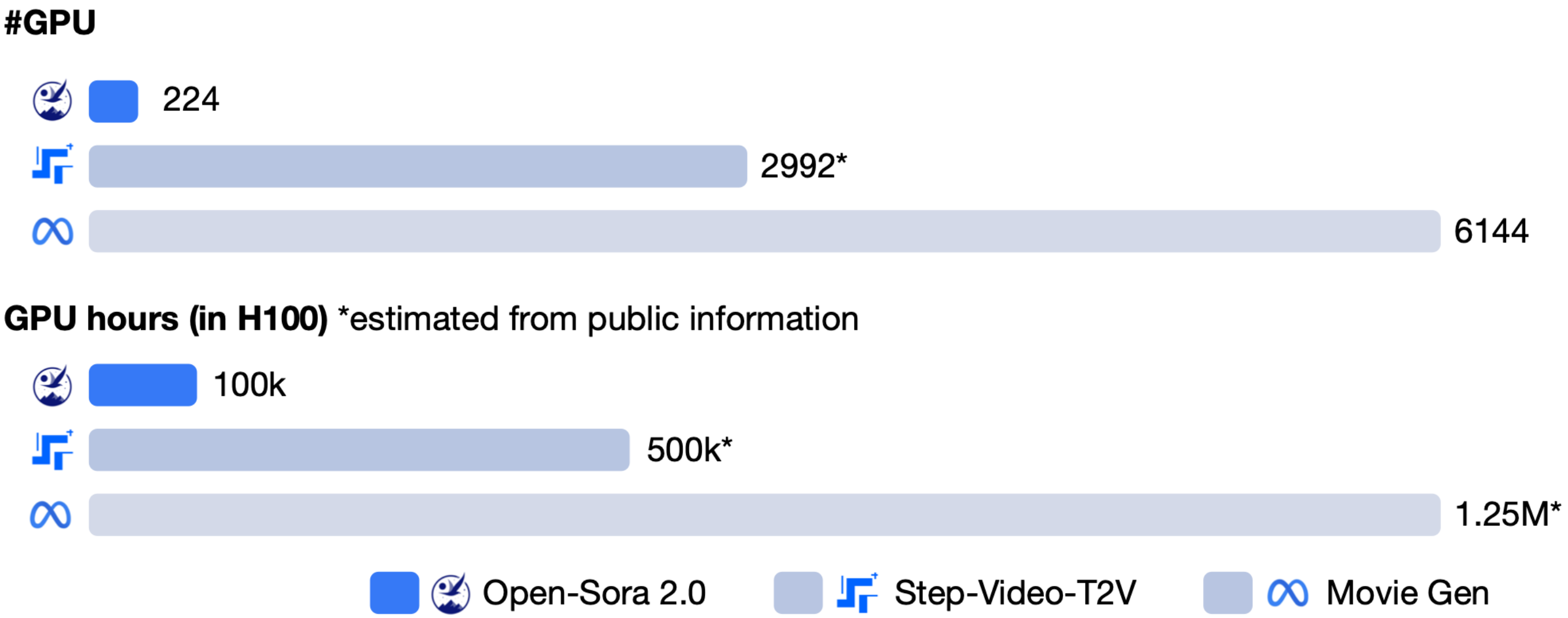

hpcaitech (equipo de ColossalAI) ha lanzado oficialmente Open-Sora 2.0, un modelo de generación de video de código abierto con 11 mil millones de parámetros que ha atraído una amplia atención por su equilibrio entre costo y rendimiento. Este modelo requiere aproximadamente 200,000 dólares (equivalente a 224 GPU) en costos de entrenamiento, pero ha demostrado un rendimiento cercano a los modelos comerciales de primer nivel en múltiples evaluaciones.

Demostraciones de video

Nota: Los GIF anteriores están en formato comprimido. Para ver los videos originales en alta calidad, visite la página de demostración oficial

Rendimiento

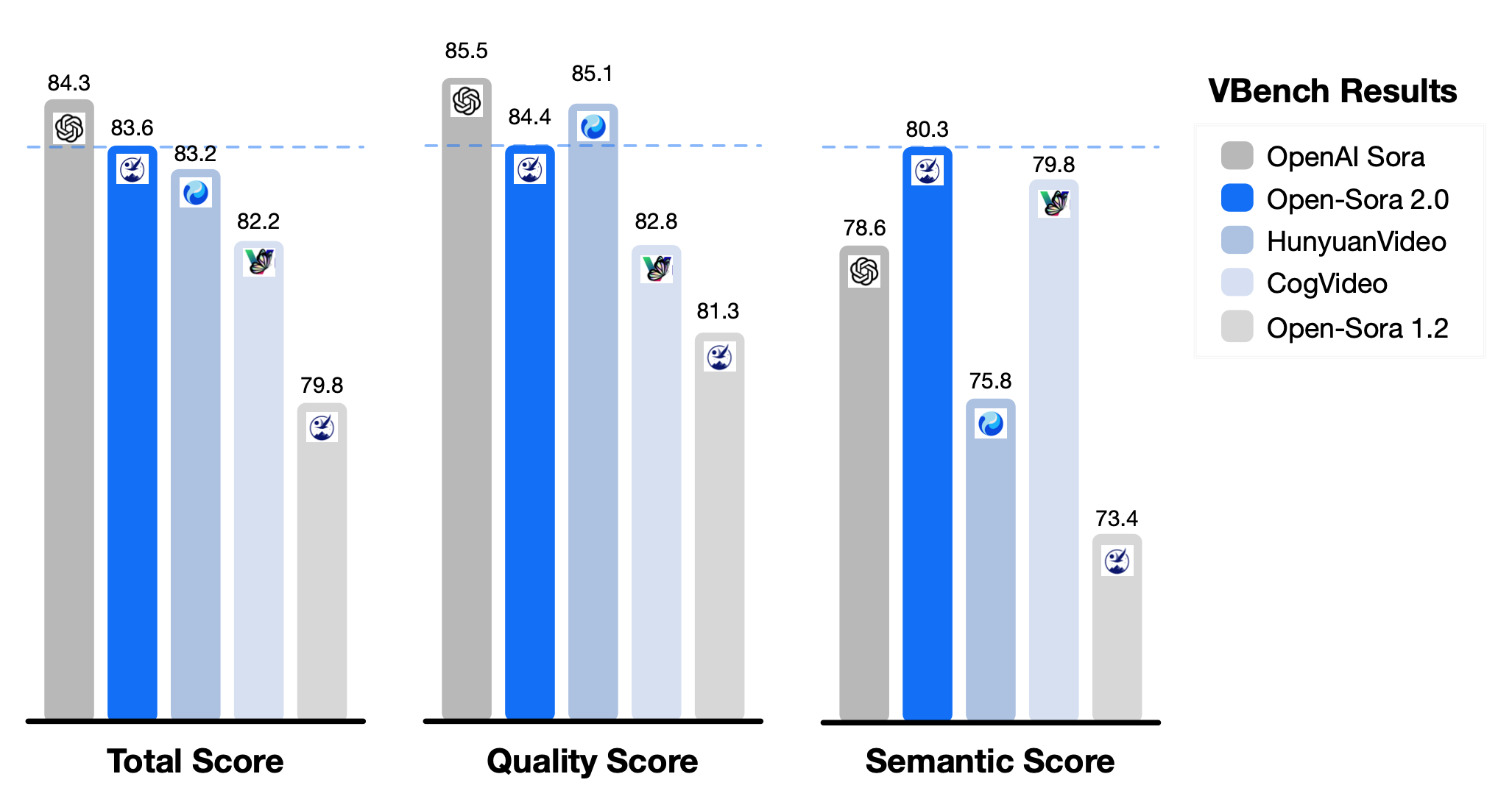

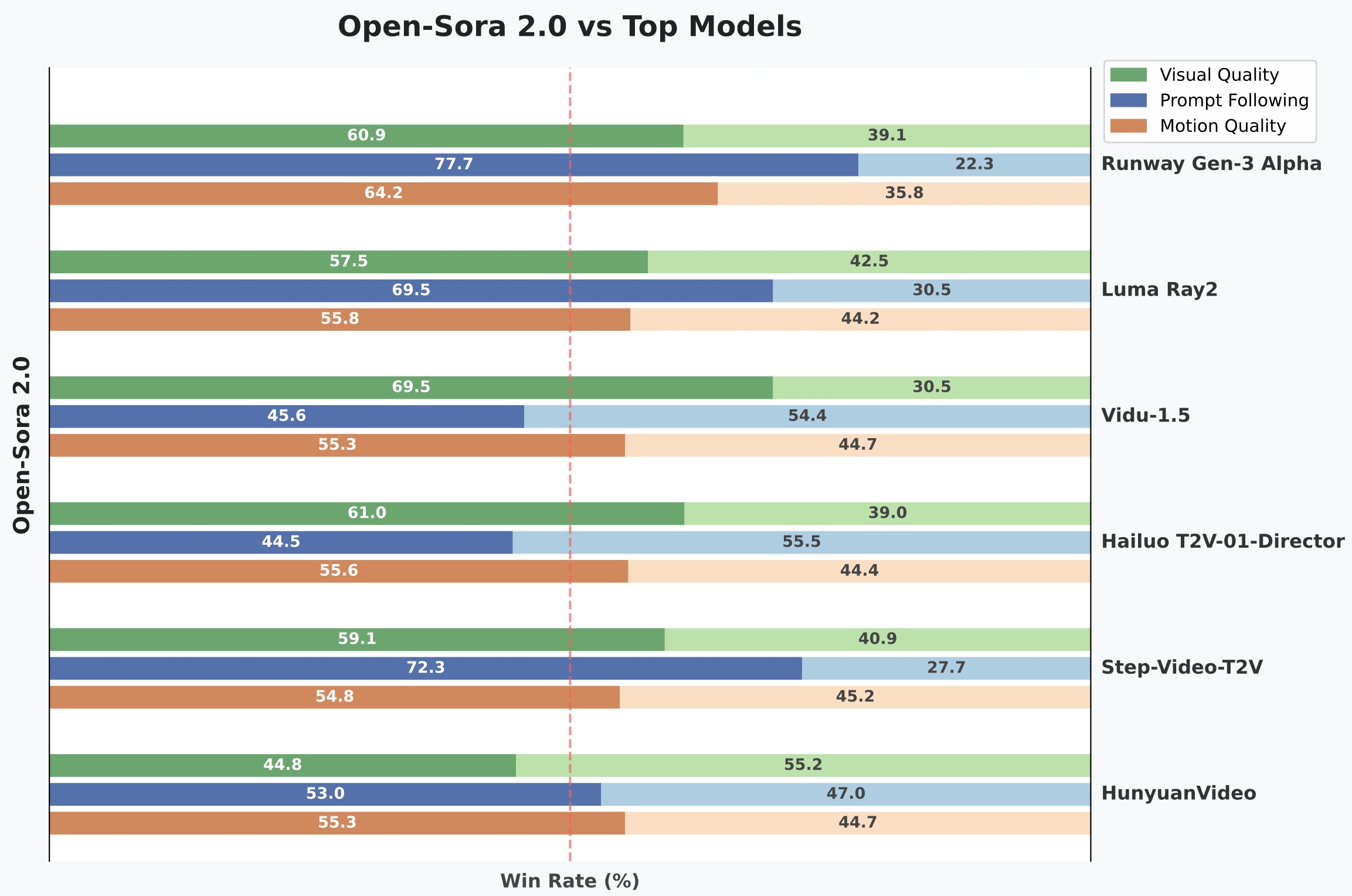

En la evaluación VBench, la diferencia de rendimiento entre Open-Sora 2.0 y el modelo Sora de OpenAI se ha reducido del 4.52% en la generación anterior a solo el 0.69%, casi alcanzando la paridad. Las pruebas de preferencia de los usuarios muestran que este modelo supera a varios competidores en calidad visual (tasa de victoria del 69.5%), consistencia textual (tasa de victoria del 55.6%) y otros indicadores, mostrando un rendimiento comparable a modelos comerciales como HunyuanVideo de Tencent (11B) y Step-Video (30B).

Comparación de rendimiento en la evaluación VBench

Comparación de tasas de victoria en pruebas de preferencia de usuarios

Comparación de costos de entrenamiento del modelo

Innovaciones tecnológicas

Detrás de la realización de un alto rendimiento a bajo costo con Open-Sora 2.0 se encuentran varias innovaciones tecnológicas:

- Arquitectura de modelo eficiente: adopción de un mecanismo de atención 3D completo y la arquitectura MMDiT (Masked Motion Diffusion Transformer) para mejorar la capacidad de modelado de características espacio-temporales.

- Estrategia de prioridad de baja resolución: primero se aprenden las características de movimiento, y luego se mejora la calidad de imagen a través de la generación de imágenes a partir de videos (T2I2V), ahorrando 40 veces los recursos de cálculo.

- Marco de entrenamiento paralelo: aprovechando el marco paralelo de ColossalAI, combinando tecnologías como ZeroDP y Gradient Checkpointing, con una utilización de GPU del 99%.

- Auto-codificador de alta compresión: reduce el tiempo de generación de video de 768px de 30 minutos a 3 minutos, aumentando la velocidad 10 veces.

Valor del ecosistema de código abierto

Como un proyecto de código abierto de pila completa, Open-Sora 2.0 ha publicado en GitHub los pesos del modelo, el código de entrenamiento (incluyendo preprocesamiento de datos y optimización distribuida) y el informe técnico. El modelo admite múltiples escenarios de aplicación:

- Preproducción cinematográfica: generación de guiones gráficos y prototipos de efectos especiales.

- Creatividad publicitaria: producción rápida de videos en múltiples escenarios.

- Educación y divulgación: demostraciones dinámicas de principios físicos.

- Desarrollo de videojuegos: generación automática de animaciones de comportamiento de NPC y efectos de transición de escenas.

Este proyecto ha superado las cien citas en artículos en seis meses, atrayendo la participación de varias empresas, incluida NVIDIA, en la construcción del ecosistema, proporcionando un impulso importante para la popularización de la tecnología de generación de video.

Funciones y características prácticas

Open-Sora 2.0 cuenta con una rica variedad de funciones prácticas:

Soporte para múltiples resoluciones y relaciones de aspecto

Admite resoluciones de 256px y 768px, y puede manejar la generación de videos en diferentes relaciones de aspecto como 16:9, 9:16, 1:1, 2.39:1.

Múltiples modos de generación

- Generación de video a partir de texto: genera videos que se ajustan al contenido según la descripción textual.

- Generación de video a partir de imágenes: convierte imágenes estáticas en videos con efectos dinámicos.

- Control de intensidad de movimiento: ajusta la amplitud del movimiento en el video mediante el parámetro Motion Score (1-7 puntos).

Las puntuaciones de movimiento de izquierda a derecha son 1, 4 y 7 puntos respectivamente.

Inferencia eficiente

El modelo puede ejecutarse de manera eficiente en GPU de alta gama (como H100/H800):

- Generación de video a 256×256 de resolución: solo necesita aproximadamente 60 segundos en una sola GPU.

- Generación de video a 768×768 de resolución: se puede completar en aproximadamente 4.5 minutos utilizando 8 GPU en paralelo.

Obtención y uso

El modelo ya está disponible para su descarga en las siguientes plataformas:

Desarrollo futuro

El equipo de hpcaitech ha declarado que Open-Sora continuará mejorando en el futuro:

- Soporte para generación de videos de más de 1 minuto a 4K de resolución.

- Exploración de capacidades multimodales (generación de audio sincronizado, edición cruzada de modalidades).

- Reducción adicional de los costos de entrenamiento e inferencia.

Se espera que este logro reduzca significativamente la barrera de entrada para la creación de contenido de video, promoviendo la aplicación de herramientas de video AI en una gama más amplia de campos.

Enlaces relacionados

- Repositorio de GitHub de Open-Sora

- Página de demostración oficial de Open-Sora

- Descarga del informe técnico