OpenMOSS 发布 MOVA - 开源音视频同步生成模型

2026/01/29

title: “FlexiAct:实现异构场景中的灵活动作控制” description: “清华大学与腾讯ARC实验室联合开发的FlexiAct技术能够将参考视频中的动作转移到任意目标图像,同时保持身份一致性” tag: AI, video-generation, action-control, image-to-video date: 2025-05-08

FlexiAct:实现异构场景中的灵活动作控制

清华大学与腾讯ARC实验室的研究团队近日发布了一项名为FlexiAct的新技术,该技术能够将参考视频中的动作转移到任意目标图像,即使在布局、视角和骨骼结构各不相同的情况下也能保持良好的效果。这一技术已被SIGGRAPH 2025接收。

技术背景

动作自定义是指根据输入控制信号生成主体执行特定动作的视频。当前的方法主要使用姿态引导或全局运动自定义,但这些方法受到空间结构(如布局、骨架和视角一致性)的严格限制,难以适应不同主体和场景的多样性。

技术创新

FlexiAct克服了现有技术的局限性,能够实现:

- 精确的动作控制

- 空间结构适应

- 保持身份一致性

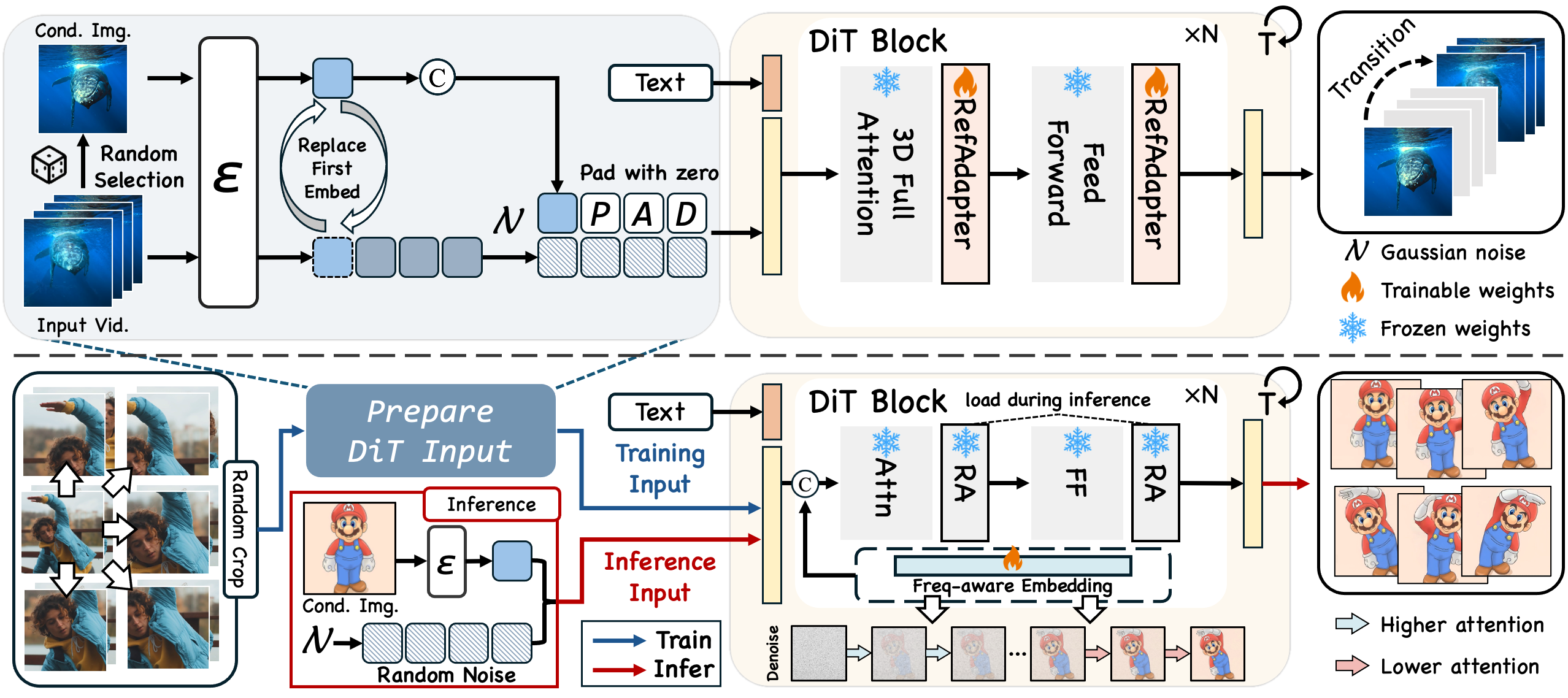

该技术的核心包含两个关键组件:

-

RefAdapter:一种轻量级的图像条件适配器,在空间适应和一致性保持方面表现出色,能够平衡外观一致性和结构灵活性。

-

FAE (频率感知动作提取):基于研究团队的观察,去噪过程在不同时间步长对运动(低频)和外观细节(高频)有不同程度的关注。FAE直接在去噪过程中实现动作提取,无需依赖单独的时空架构。

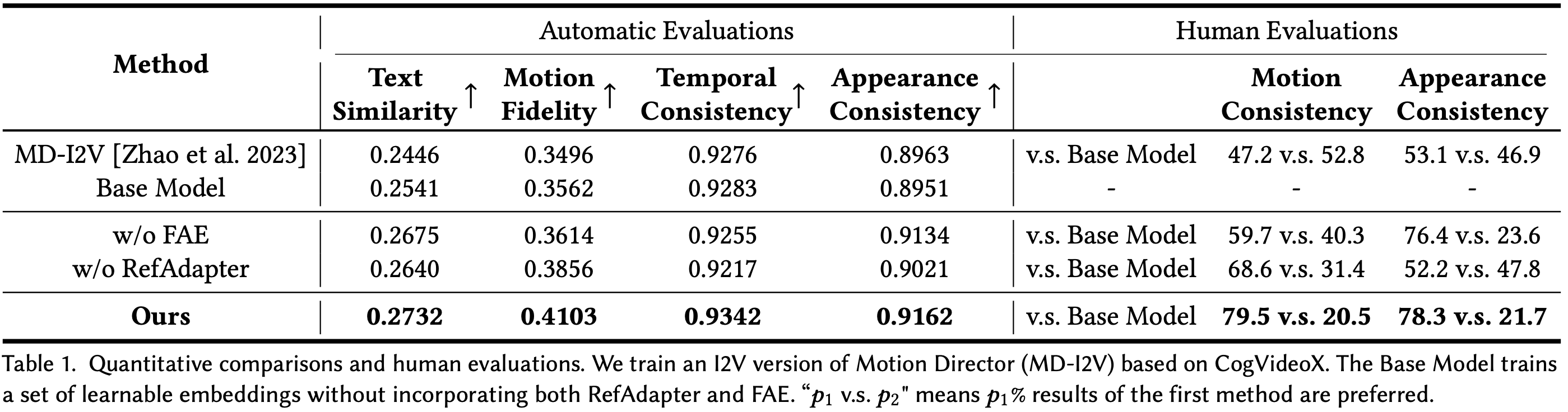

与现有方法相比,FlexiAct在异构场景中展现出显著的性能优势:

应用场景

FlexiAct可以广泛应用于多种场景:

- 人类动作转移:将人类动作转移到游戏角色或卡通形象

- 动物动画生成:为动物图像添加动态动作

- 相机动态效果:在不同相机视角下创建动态效果

- 跨域动作迁移:实现不同物种间的动作迁移,如将人的动作应用于动物

数据与模型

研究团队为这项工作专门构建了一个数据集,包含多种动作类型:

- 人类动作:行走、蹲下、跳跃等

- 动物动作:奔跑、跳跃、站立等

- 相机动作:前进、旋转、缩放等

FlexiAct基于CogVideoX-5B模型开发,实现了高质量的动作转移效果。

开源资源

研究团队已经开源了相关资源,包括:

- FlexiAct预训练模型(基于CogVideoX-5B)

- 用于训练和测试的数据集

- 用于训练和推理的代码

- 详细的使用说明和示例

未来计划

根据项目更新日志,研究团队计划:

- 发布训练和推理代码

- 发布FlexiAct检查点(基于CogVideoX-5B)

- 发布训练数据

- 发布Gradio演示