ByteDance publie Sa2VA : Premier modèle unifié de compréhension d’images et de vidéos

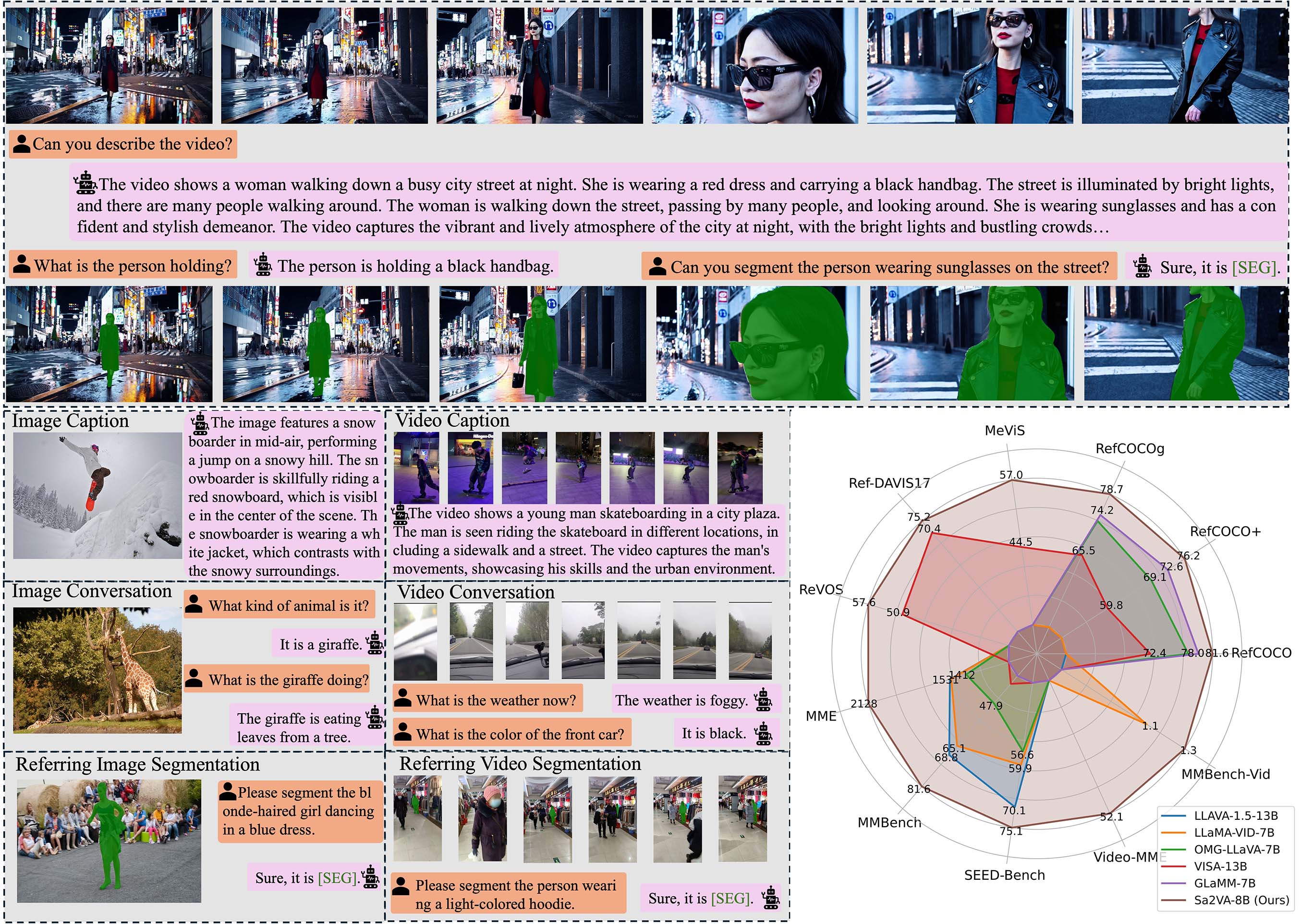

Aujourd’hui, ByteDance a publié le modèle multimodal Sa2VA (SAM2 + LLaVA) sur la plateforme Hugging Face. Il s’agit du premier modèle de compréhension par segmentation dense capable de traiter simultanément des images et des vidéos. Sa2VA combine la technologie de segmentation SAM2 de Meta avec les capacités de réponse aux questions visuelles de LLaVA, ajoutant des fonctionnalités de compréhension des invites visuelles et de segmentation dense d’objets tout en maintenant des performances de réponse aux questions comparables à celles des meilleurs modèles multimodaux.

Caractéristiques techniques : Une nouvelle percée dans la compréhension multimodale

L’innovation centrale de Sa2VA réside dans l’intégration organique de deux technologies avancées :

1. Capacités de segmentation visuelle

- Segmentation dense d’objets : Capable d’identifier et de segmenter précisément plusieurs objets dans des images et des vidéos

- Compréhension des invites visuelles : Prend en charge la segmentation interactive via des indices visuels tels que les masques

- Cohérence inter-images : Maintient la continuité temporelle de la segmentation des objets lors du traitement des vidéos

2. Réponse aux questions multimodales

- Compréhension des images : Fournit des descriptions et analyses détaillées des images

- Analyse vidéo : Comprend les changements dynamiques temporels dans le contenu vidéo

- Dialogue interactif : Prend en charge des conversations à plusieurs tours basées sur le contenu visuel

Série de modèles : Plusieurs spécifications pour répondre à différents besoins

ByteDance a construit une gamme complète de modèles Sa2VA basée sur les séries Qwen2.5-VL et InternVL :

| Nom du modèle | Modèle de base | Modèle de langage | Échelle des paramètres |

|---|---|---|---|

| Sa2VA-InternVL3-2B | InternVL3-2B | Qwen2.5-1.5B | 2 milliards |

| Sa2VA-InternVL3-8B | InternVL3-8B | Qwen2.5-7B | 8 milliards |

| Sa2VA-InternVL3-14B | InternVL3-14B | Qwen2.5-14B | 14 milliards |

| Sa2VA-Qwen2_5-VL-3B | Qwen2.5-VL-3B | Qwen2.5-3B | 3 milliards |

| Sa2VA-Qwen2_5-VL-7B | Qwen2.5-VL-7B | Qwen2.5-7B | 7 milliards |

Performances : Résultats de pointe sur plusieurs benchmarks

Sa2VA démontre d’excellentes performances sur plusieurs tests standard :

Capacités de réponse aux questions visuelles

- Test MME : Sa2VA-InternVL3-14B a atteint 1746/724 points

- MMBench : 84,3 points, proche du niveau des modèles professionnels de compréhension visuelle

Performances des tâches de segmentation

- Série RefCOCO : Excellentes performances dans les tâches de segmentation par expression référentielle

- Segmentation vidéo : A atteint les meilleures performances sur les tests de référence MeVIS et DAVIS

Scénarios d’application : Valeur pratique étendue

L’architecture unifiée de Sa2VA offre de nouvelles possibilités dans plusieurs domaines :

1. Création de contenu

- Montage vidéo : Identifie et segmente automatiquement les objets dans les vidéos, simplifiant les processus de post-production

- Annotation d’images : Fournit une segmentation précise des objets et des descriptions pour de grands ensembles de données d’images

2. Éducation et formation

- Enseignement interactif : Aide les élèves à comprendre des concepts complexes grâce à des invites visuelles et à la réponse aux questions

- Analyse de contenu : Analyse automatiquement les points d’information clés dans les vidéos pédagogiques

3. Sécurité et surveillance

- Analyse intelligente : Analyse en temps réel du comportement des personnes et des objets dans les vidéos de surveillance

- Détection d’anomalies : Identifie les situations anormales en combinant les capacités de compréhension et de segmentation visuelles

4. Imagerie médicale

- Diagnostic assisté : Analyse les images médicales et fournit des descriptions détaillées des régions

- Localisation des lésions : Segment et annote précisément les régions d’intérêt

Ressources open-source et accès

Sa2VA adopte une stratégie de publication open-source, offrant commodité aux chercheurs et développeurs :

Liens officiels vers les ressources :

- Page d’accueil du projet : GitHub Sa2VA

- Article : arXiv:2501.04001

- Téléchargement du modèle : Hugging Face Série Sa2VA

La publication de Sa2VA marque l’évolution de l’IA multimodale vers une direction plus unifiée et plus pratique. Son approche de conception qui intègre profondément la segmentation visuelle à la compréhension du langage ouvre de nouvelles possibilités pour les futures applications d’IA.