L’Équipe Hunyuan de Tencent Publie le Framework MixGRPO en Open Source pour Améliorer l’Efficacité d’Entraînement dans l’Alignement des Préférences Humaines

L’équipe Hunyuan de Tencent a officiellement publié le framework MixGRPO en open source ! Il s’agit du premier framework à intégrer l’échantillonnage mixte ODE-SDE à fenêtre glissante pour GRPO (Generalized Reward-based Policy Optimization), spécifiquement conçu pour améliorer l’efficacité de l’alignement des préférences humaines dans les modèles d’IA.

Le framework réduit significativement la surcharge d’entraînement tout en maintenant d’excellentes performances. La variante MixGRPO-Flash atteint jusqu’à 71% d’accélération d’entraînement, surpassant les méthodes précédentes comme DanceGRPO.

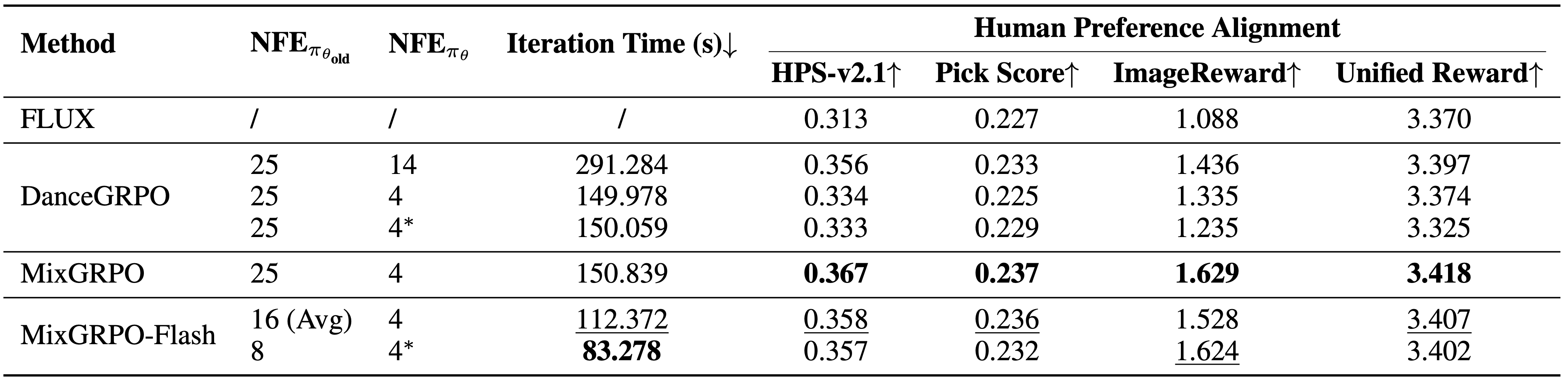

Comparaison de performance pour différents nombres d’étapes de débruitage optimisées. L’amélioration de performance de DanceGRPO dépend de plus d’étapes optimisées, tandis que MixGRPO atteint une performance optimale avec seulement 4 étapes

Comparaison de performance pour différents nombres d’étapes de débruitage optimisées. L’amélioration de performance de DanceGRPO dépend de plus d’étapes optimisées, tandis que MixGRPO atteint une performance optimale avec seulement 4 étapes

Le framework MixGRPO prend en charge les solveurs ODE d’ordre supérieur, permettant une accélération supplémentaire de l’entraînement sans sacrifier les performances. Les modèles basés sur la diffusion et les modèles basés sur le flux peuvent tous deux libérer leur potentiel avec seulement quelques étapes d’itération.

Caractéristiques du Framework MixGRPO

Innovations Techniques Principales

- Échantillonnage Mixte à Fenêtre Glissante : Premier framework à intégrer l’échantillonnage mixte ODE-SDE à fenêtre glissante pour GRPO

- Amélioration Significative de l’Efficacité : MixGRPO-Flash atteint jusqu’à 71% d’accélération d’entraînement

- Support des Solveurs d’Ordre Supérieur : Prend en charge les solveurs ODE d’ordre supérieur pour une accélération supplémentaire

- Compatibilité Universelle : Applicable aux modèles de diffusion et aux modèles de flux

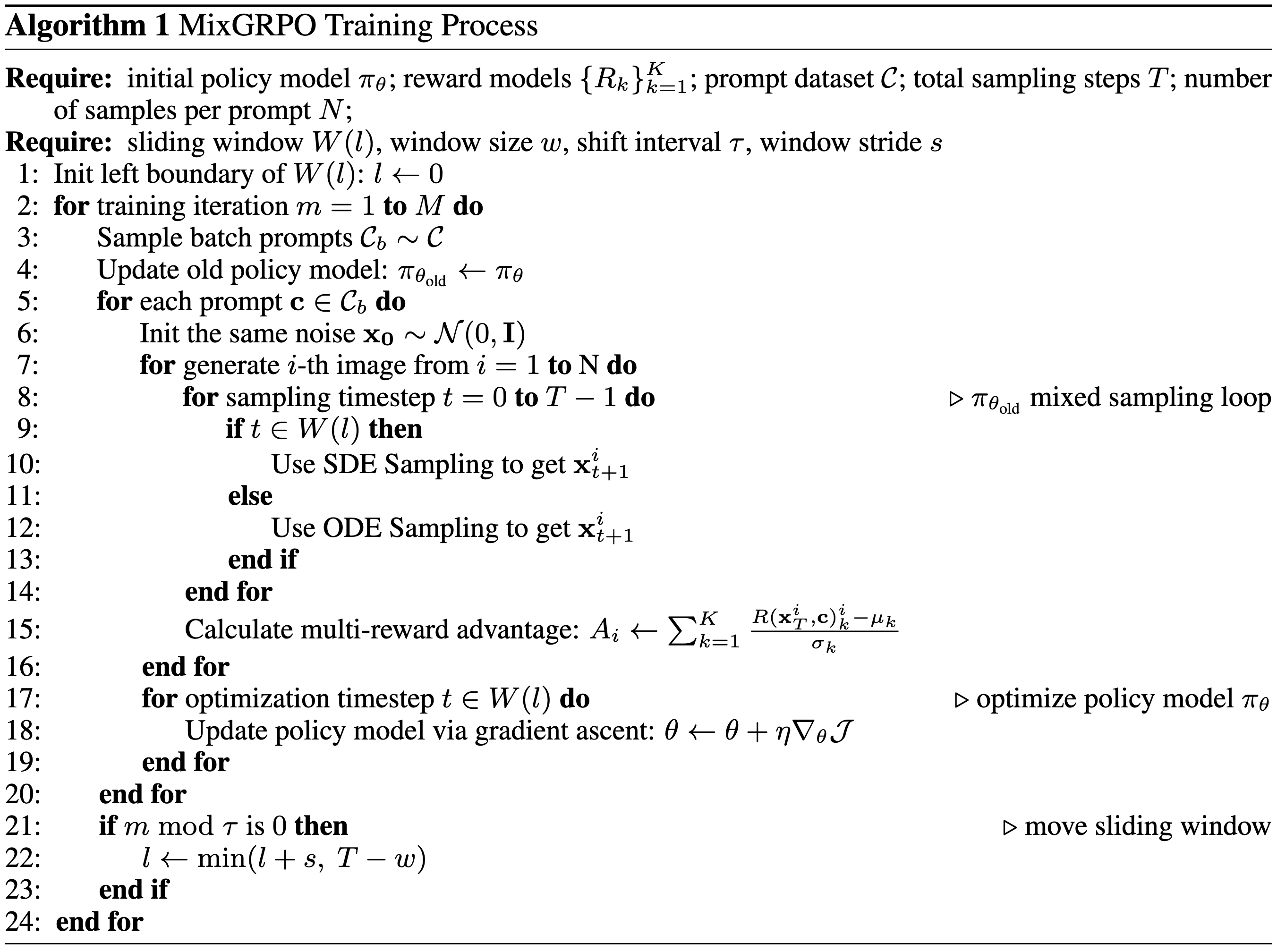

Diagramme d’architecture technique de MixGRPO, illustrant le principe de fonctionnement du mécanisme de fenêtre glissante

Diagramme d’architecture technique de MixGRPO, illustrant le principe de fonctionnement du mécanisme de fenêtre glissante

Avantages de Performance

- Réduction Drastique de la Surcharge d’Entraînement : Réduit significativement la consommation de ressources de calcul par rapport aux méthodes traditionnelles

- Supérieur aux Méthodes Précédentes : Surpasse DanceGRPO et d’autres méthodes précédentes en efficacité et en efficience

- Convergence Rapide : Atteint le potentiel du modèle avec seulement quelques étapes d’itération

Résultats de comparaison de surcharge et de performance. MixGRPO atteint les meilleures performances sur plusieurs métriques, tandis que MixGRPO-Flash réduit significativement le temps d’échantillonnage tout en surpassant DanceGRPO

Résultats de comparaison de surcharge et de performance. MixGRPO atteint les meilleures performances sur plusieurs métriques, tandis que MixGRPO-Flash réduit significativement le temps d’échantillonnage tout en surpassant DanceGRPO

Scénarios d’Application Technique

Le framework MixGRPO est principalement utilisé pour les tâches d’alignement des préférences humaines, une direction de recherche importante dans le domaine de l’IA. Grâce à ce framework, les chercheurs peuvent :

- Entraîner plus efficacement des modèles de génération d’images qui s’alignent mieux avec les préférences humaines

- Réduire les coûts de calcul pour l’entraînement de modèles à grande échelle

- Accélérer l’itération expérimentale tout en maintenant la qualité du modèle

Cette technologie est significative pour améliorer la qualité du contenu généré par l’IA et la satisfaction des utilisateurs, particulièrement dans les applications de génération d’images et de création de contenu.

Résultats Expérimentaux

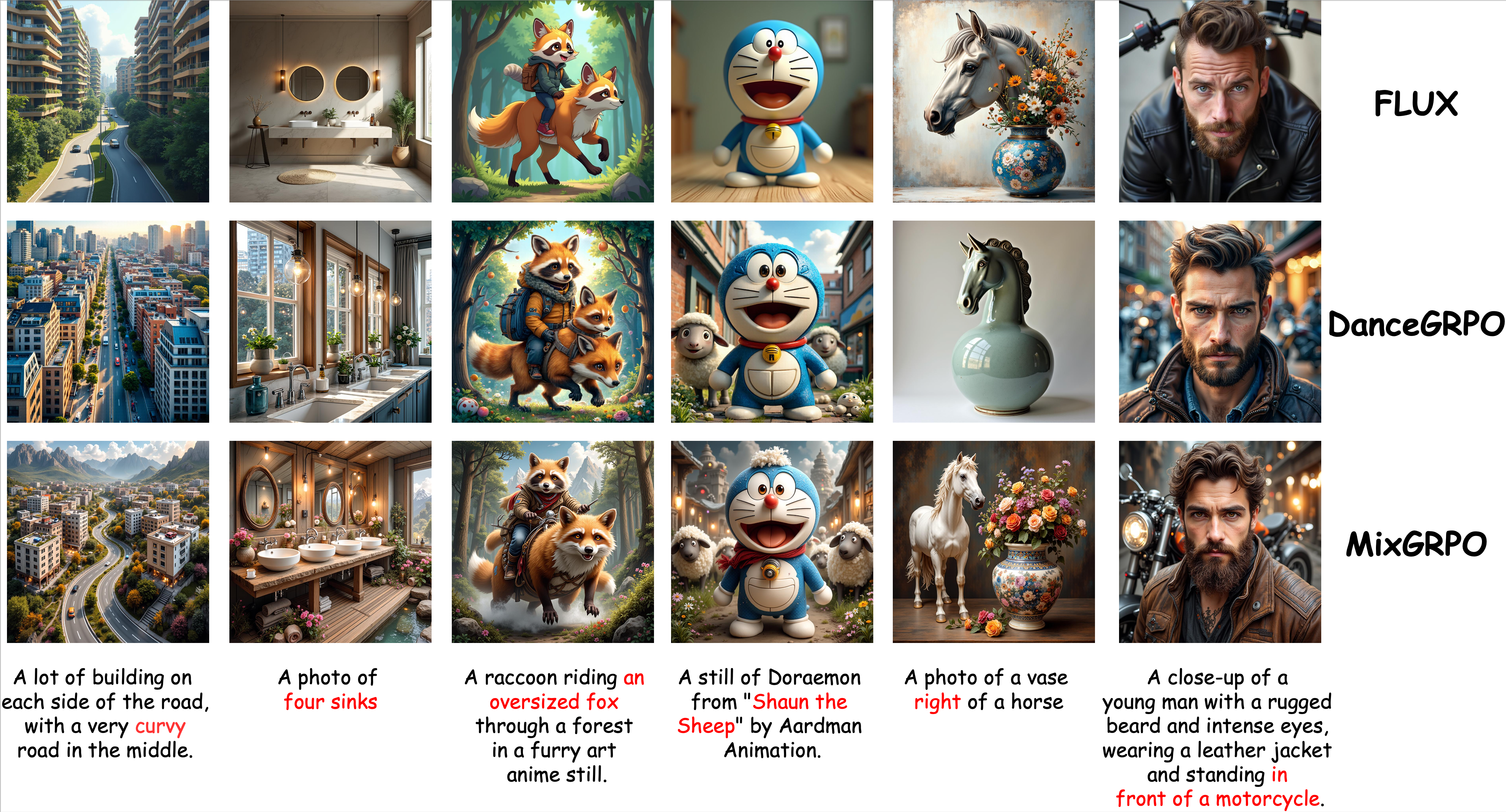

Résultats de comparaison qualitative. MixGRPO atteint une performance supérieure en sémantique et en esthétique

Résultats de comparaison qualitative. MixGRPO atteint une performance supérieure en sémantique et en esthétique

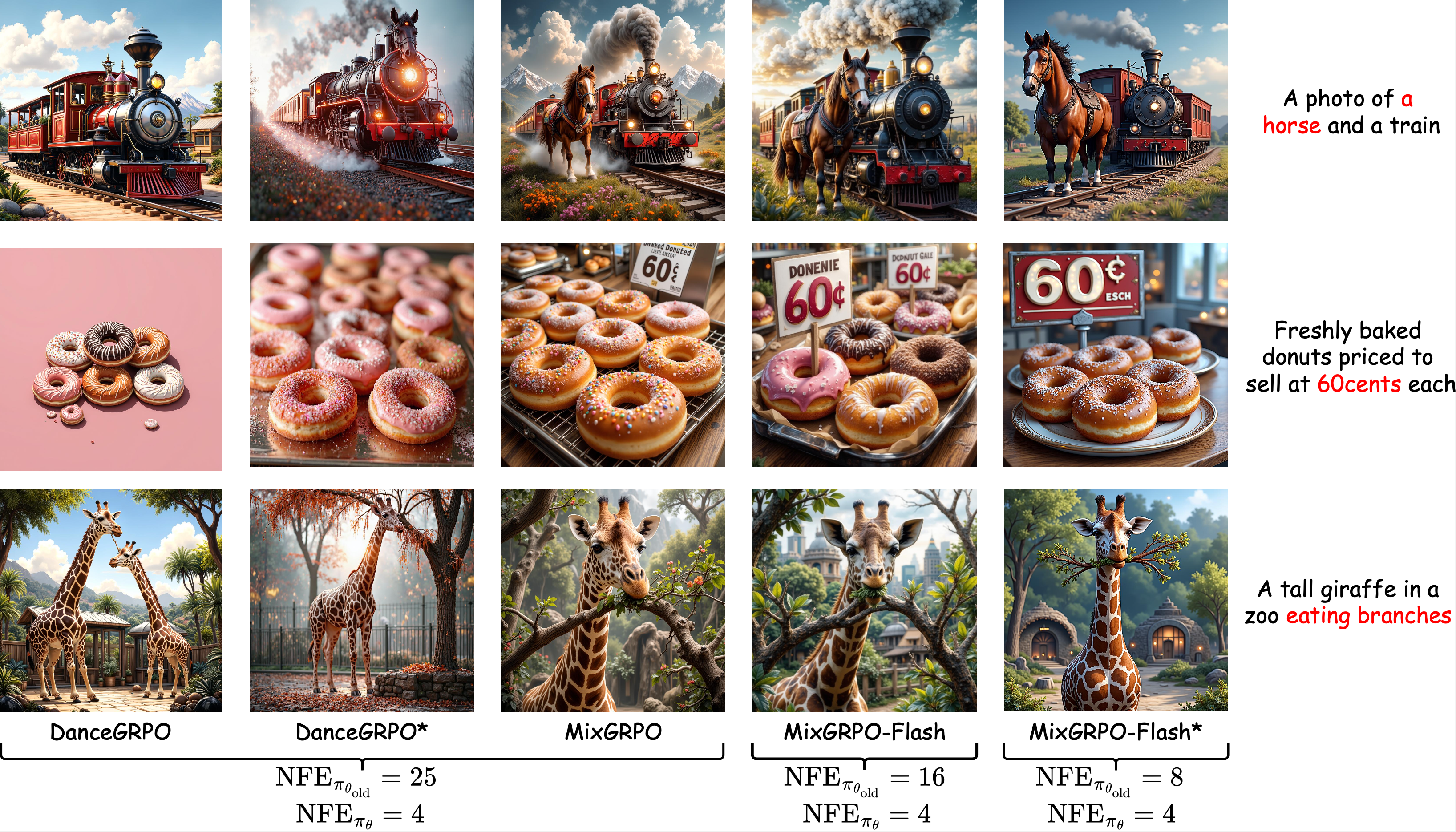

Comparaison qualitative avec différentes étapes d’échantillonnage au moment de l’entraînement. La performance de MixGRPO ne diminue pas significativement avec la réduction de la surcharge

Comparaison qualitative avec différentes étapes d’échantillonnage au moment de l’entraînement. La performance de MixGRPO ne diminue pas significativement avec la réduction de la surcharge

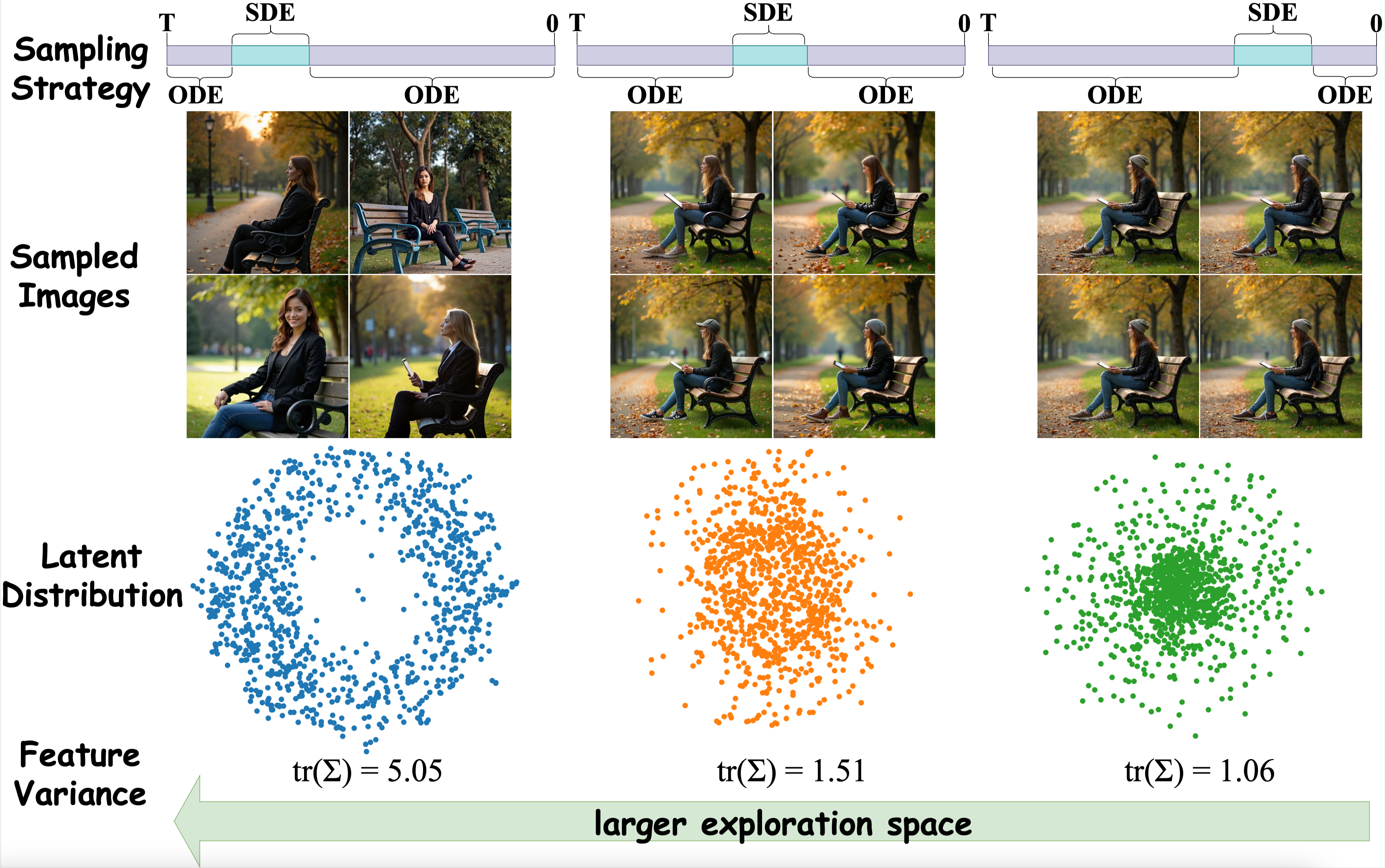

Visualisation t-SNE pour les images échantillonnées avec différentes stratégies. L’emploi de l’échantillonnage SDE dans les premières étapes du processus de débruitage résulte en une distribution de données plus discrète

Visualisation t-SNE pour les images échantillonnées avec différentes stratégies. L’emploi de l’échantillonnage SDE dans les premières étapes du processus de débruitage résulte en une distribution de données plus discrète

Ressources Open Source

Le framework MixGRPO est maintenant entièrement open source. Les chercheurs et développeurs peuvent accéder aux ressources connexes via les canaux suivants :

Liens Connexes

- Page du Projet : https://tulvgengenr.github.io/MixGRPO-Project-Page/

- Dépôt de Code : https://github.com/Tencent-Hunyuan/MixGRPO

- Article de Recherche : https://arxiv.org/abs/2507.21802

La publication en open source de MixGRPO fournira un support d’outils puissant pour la communauté de recherche en IA, faisant progresser le développement et l’application ultérieurs de la technologie d’alignement des préférences humaines.