Open-Sora 2.0 : une capacité de génération vidéo de niveau commercial à faible coût

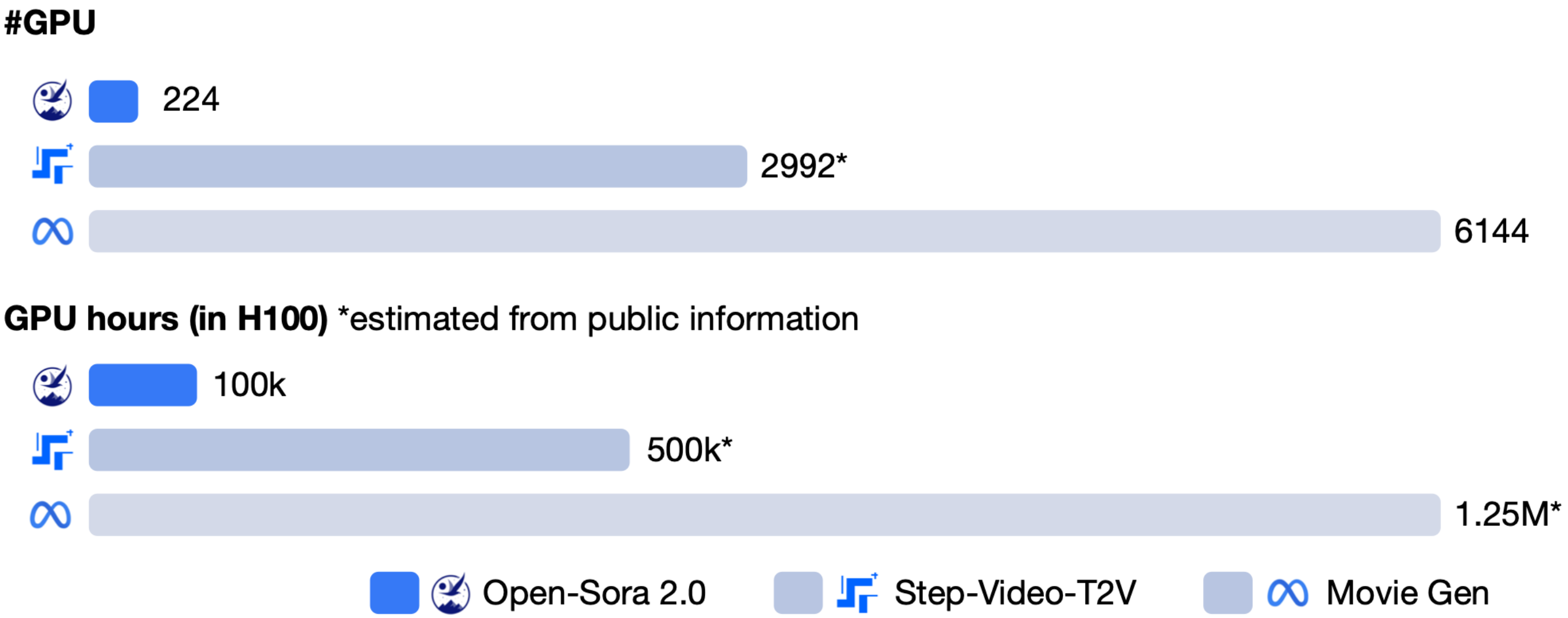

hpcaitech (équipe ColossalAI) a récemment lancé officiellement Open-Sora 2.0, un modèle de génération vidéo open source avec 11 milliards de paramètres, qui a suscité un grand intérêt dans l’industrie grâce à son équilibre entre coût et performance. Ce modèle a nécessité environ 200 000 dollars (équivalent à 224 GPU) pour son coût d’entraînement, tout en affichant des performances proches des modèles commerciaux de premier plan dans plusieurs évaluations.

Démonstration vidéo

Remarque : les GIF ci-dessus sont au format compressé. Pour voir la vidéo originale en haute qualité, veuillez visiter la page de démonstration officielle.

Performance

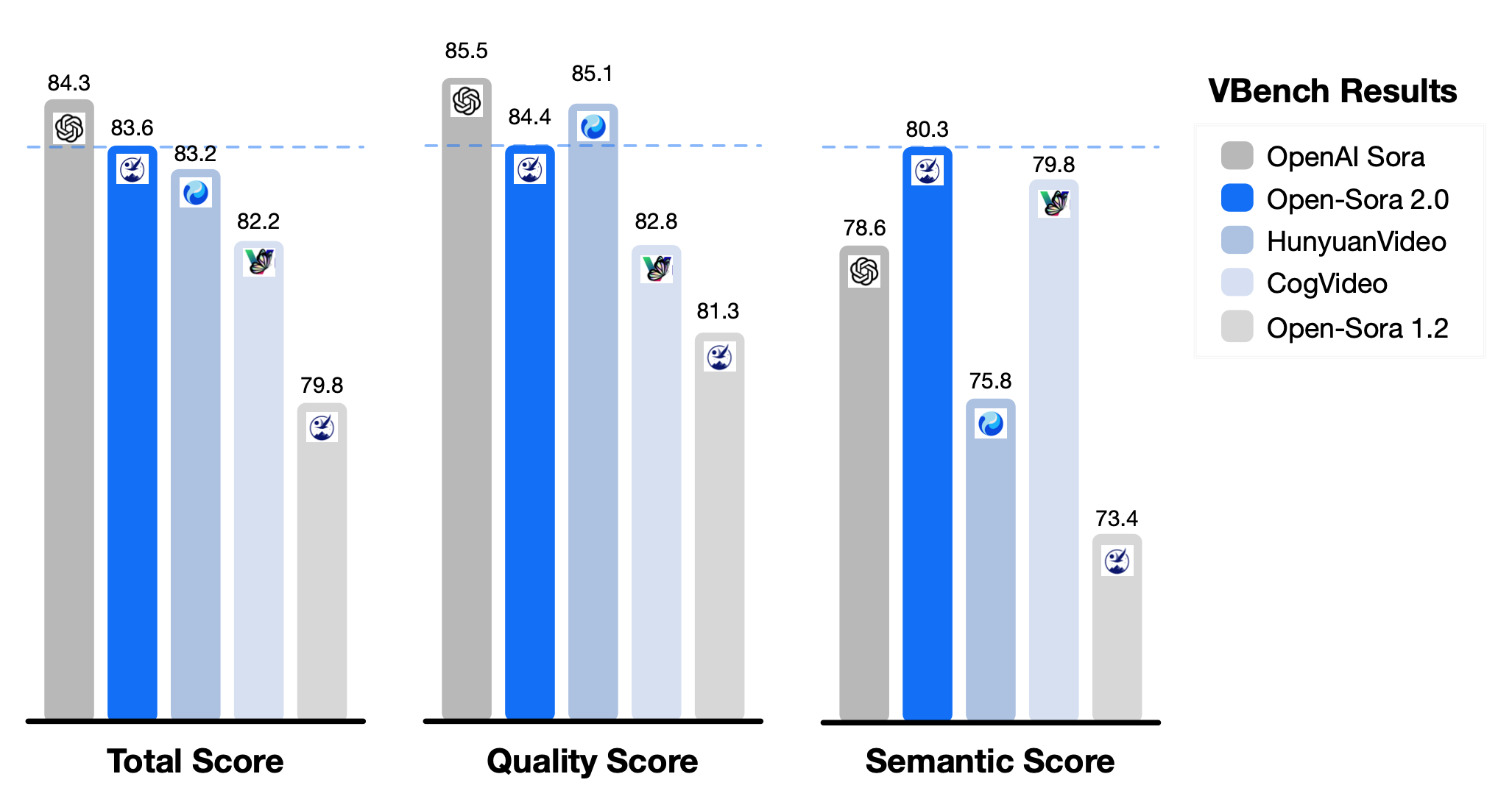

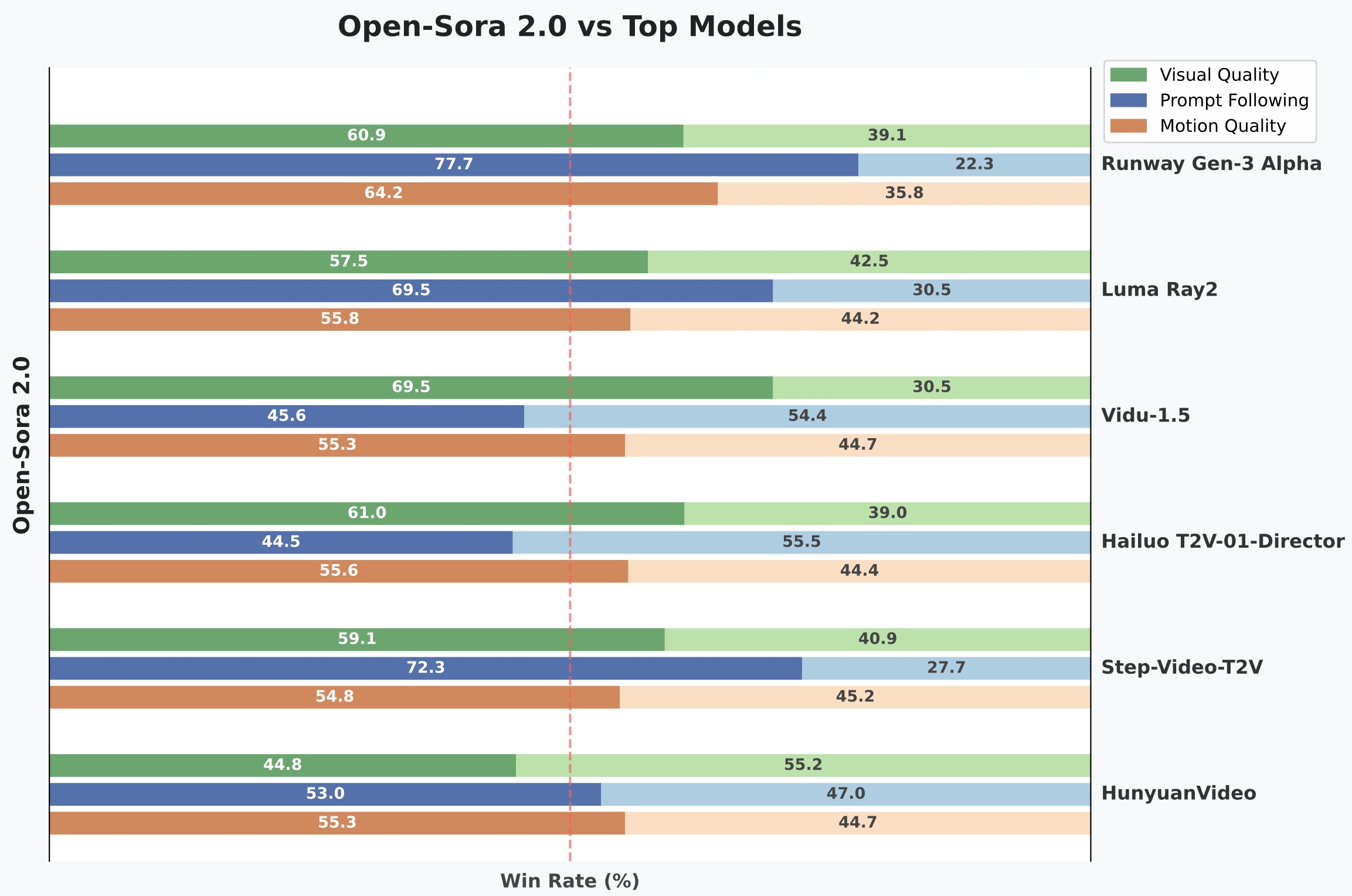

Dans l’évaluation VBench, Open-Sora 2.0 a réduit l’écart de performance avec le modèle OpenAI Sora de 4,52 % à seulement 0,69 %, atteignant presque l’égalité. Les tests de préférence des utilisateurs montrent que ce modèle surpasse plusieurs concurrents en termes de qualité visuelle (taux de victoire de 69,5 %) et de cohérence textuelle (taux de victoire de 55,6 %), affichant des performances comparables à celles de modèles commerciaux tels que Tencent HunyuanVideo (11B) et Step-Video (30B).

Comparaison des performances dans l’évaluation VBench

Comparaison des taux de victoire des tests de préférence des utilisateurs

Comparaison des coûts d’entraînement du modèle

Innovations technologiques

Derrière la réalisation d’un haut niveau de performance à faible coût avec Open-Sora 2.0 se trouvent plusieurs innovations technologiques :

- Architecture de modèle efficace : adoption d’un mécanisme d’attention 3D complet et de l’architecture MMDiT (Masked Motion Diffusion Transformer) pour renforcer la capacité de modélisation des caractéristiques spatio-temporelles.

- Stratégie de priorité basse résolution : apprentissage d’abord des caractéristiques de mouvement, puis amélioration de la qualité d’image via la génération d’images à partir de vidéos (T2I2V), économisant 40 fois les ressources de calcul.

- Cadre d’entraînement parallèle : utilisation du cadre parallèle ColossalAI, combiné à des technologies telles que ZeroDP et Gradient Checkpointing, atteignant un taux d’utilisation du GPU de 99 %.

- Autoencodeur à haute compression : réduction du temps de génération de vidéos 768px de 30 minutes à 3 minutes, améliorant la vitesse par un facteur de 10.

Valeur de l’écosystème open source

En tant que projet open source complet, Open-Sora 2.0 a publié sur GitHub les poids du modèle, le code d’entraînement (y compris le prétraitement des données et l’optimisation distribuée) et le rapport technique. Le modèle prend en charge divers scénarios d’application :

- Prévisualisation cinématographique : génération de scripts de storyboard et de prototypes d’effets spéciaux.

- Créativité publicitaire : production rapide de vidéos de plusieurs scènes.

- Éducation et vulgarisation scientifique : démonstration dynamique des lois physiques.

- Développement de jeux : génération automatique d’animations de comportement NPC et d’effets de transition de scène.

Ce projet a dépassé les 100 citations de publications en six mois, attirant la participation de plusieurs entreprises, y compris NVIDIA, à la construction de l’écosystème, contribuant ainsi de manière significative à la diffusion de la technologie de génération vidéo.

Fonctionnalités pratiques et caractéristiques

Open-Sora 2.0 dispose de nombreuses fonctionnalités pratiques :

Support de plusieurs résolutions et rapports d’aspect

Prend en charge les résolutions de 256px et 768px, capable de générer des vidéos avec différents rapports d’aspect tels que 16:9, 9:16, 1:1, 2.39:1.

Modes de génération variés

- Génération de vidéos à partir de texte : génération de vidéos correspondant au contenu selon la description textuelle.

- Génération de vidéos à partir d’images : transformation d’images statiques en vidéos avec des effets dynamiques.

- Contrôle de l’intensité du mouvement : ajustement de l’intensité du mouvement dans la vidéo via le paramètre Motion Score (1-7 points).

Les scores de mouvement vont de 1 point à 7 points de gauche à droite.

Inférence efficace

Le modèle fonctionne efficacement sur des GPU haut de gamme (comme H100/H800) :

- Génération de vidéos à 256×256 résolutions : environ 60 secondes sur un seul GPU.

- Génération de vidéos à 768×768 résolutions : environ 4,5 minutes sur 8 GPU en parallèle.

Obtention et utilisation

Le modèle est disponible en téléchargement sur les plateformes suivantes :

Développements futurs

L’équipe de hpcaitech a déclaré qu’Open-Sora continuera à évoluer :

- Support de la génération de vidéos en 4K et de vidéos de plus d’une minute.

- Exploration des capacités multimodales (génération synchronisée audio, édition intermodale).

- Réduction supplémentaire des coûts d’entraînement et d’inférence.

Cette réalisation devrait considérablement abaisser les barrières à la création de contenu vidéo et favoriser l’application des outils vidéo AI dans des domaines plus larges.

Liens connexes

- Dépôt GitHub d’Open-Sora

- Page de démonstration officielle d’Open-Sora

- Téléchargement du rapport technique